Encyclopédie de l'informatique. Grande encyclopédie soviétique - informatique. Approche alphabétique dans le cursus d'informatique à la fondation de l'école

Dans les pays anglophones, le terme informatique est utilisé - informatique.

La base théorique de l'informatique est un ensemble de sciences fondamentales telles que : la théorie de l'information, la théorie des algorithmes, la logique mathématique, la théorie langages formels et grammaire, analyse combinatoire, etc. En plus d'eux, l'informatique comprend des sections telles que l'architecture informatique, les systèmes d'exploitation, la théorie des bases de données, la technologie de programmation et bien d'autres. Il est important pour définir l'informatique en tant que science que, d'une part, elle traite de l'étude des dispositifs et des principes de fonctionnement de la technologie informatique et, d'autre part, de la systématisation des techniques et des méthodes de travail avec des programmes qui contrôler cette technologie.

La technologie de l'information est un ensemble d'outils matériels et logiciels spécifiques qui sont utilisés pour effectuer une variété d'opérations de traitement de l'information dans toutes les sphères de notre vie et de nos activités. La technologie de l'information est parfois appelée technologie informatique ou informatique appliquée.

Informations analogiques et numériques.

Le terme "informations" vient du latin informatio, – explication, exposition, prise de conscience.

Les informations peuvent être classifiées différentes façons, et différentes sciences le font de différentes manières. Par exemple, en philosophie, faites la distinction entre les informations objectives et subjectives. L'information objective reflète les phénomènes de la nature et de la société humaine. Les informations subjectives sont créées par des personnes et reflètent leur point de vue sur des phénomènes objectifs.

En informatique, les informations analogiques et les informations numériques sont considérées séparément. Ceci est important, car une personne, grâce à ses sens, est habituée à traiter des informations analogiques, alors que la technologie informatique, au contraire, travaille principalement avec des informations numériques.

Une personne perçoit les informations par les sens. La lumière, le son, la chaleur sont des signaux énergétiques, et le goût et l'odorat sont le résultat de l'exposition à des composés chimiques, eux aussi basés sur la nature énergétique. Une personne subit continuellement des impacts énergétiques et peut ne jamais rencontrer deux fois la même combinaison. Il n'y a pas deux feuilles vertes identiques sur un arbre et deux sons absolument identiques - il s'agit d'informations analogiques. Si vous attribuez des nombres à différentes couleurs et des notes à différents sons, les informations analogiques peuvent être transformées en informations numériques.

La musique, lorsqu'elle est écoutée, transporte des informations analogiques, mais lorsqu'elle est notée, elle devient numérique.

La différence entre l'information analogique et l'information numérique est, tout d'abord, que l'information analogique est continue, tandis que l'information numérique est discrète.

Les appareils numériques comprennent les ordinateurs personnels - ils fonctionnent avec des informations présentées dans forme numérique, les lecteurs de CD laser sont également numériques.

Encodage des informations.

Le codage de l'information est le processus de formation d'une certaine représentation de l'information. .

Dans un sens plus étroit, le terme « codage » est souvent compris comme le passage d'une forme de présentation de l'information à une autre, plus commode pour le stockage, la transmission ou le traitement.

Un ordinateur ne peut traiter que des informations présentées sous forme numérique. Toutes les autres informations (sons, images, relevés d'instruments, etc.) doivent être converties sous forme numérique pour être traitées sur ordinateur. Par exemple, pour quantifier un son musical, on peut mesurer l'intensité du son à de courts intervalles sur certaines fréquences, représentant les résultats de chaque mesure sous forme numérique. À l'aide de programmes informatiques, il est possible de transformer les informations reçues, par exemple en «superposant» des sons de différentes sources les uns sur les autres.

De même, les informations textuelles peuvent être traitées sur un ordinateur. Lorsqu'elle est entrée dans un ordinateur, chaque lettre est codée avec un certain nombre, et lors de la sortie vers des périphériques externes (écran ou impression), pour la perception humaine, des images de lettres sont construites à l'aide de ces chiffres. La correspondance entre un ensemble de lettres et de chiffres s'appelle un codage de caractères.

En règle générale, tous les nombres dans l'ordinateur sont représentés par des zéros et des uns (et non par dix chiffres, comme c'est la coutume pour les gens). En d'autres termes, les ordinateurs fonctionnent généralement en binaire système de numérotation, car dans ce cas, les dispositifs pour leur traitement sont beaucoup plus simples.

Unités de mesure de l'information. Bit. Octet.

Un bit est la plus petite unité de représentation de l'information. Octet - la plus petite unité de traitement et de transmission de l'information .

Résolvant divers problèmes, une personne utilise des informations sur le monde qui nous entoure. On entend souvent dire qu'un message véhicule peu d'informations ou au contraire contient des informations exhaustives, alors que différentes personnes recevant le même message (par exemple, après avoir lu un article dans un journal) estiment différemment la quantité d'informations qu'il contient. Cela signifie que la connaissance que les gens avaient de ces événements (phénomènes) avant de recevoir le message était différente. La quantité d'informations dans un message dépend donc de la nouveauté du message pour le destinataire. Si, à la suite de la réception d'un message, une clarté complète sur un problème donné est atteinte (c'est-à-dire que l'incertitude disparaît), ils disent que des informations exhaustives ont été reçues. Cela signifie qu'il n'y a pas besoin de Informations Complémentaires sur ce thème. Au contraire, si après réception du message l'incertitude restait la même (l'information rapportée était déjà connue ou non pertinente), alors aucune information n'a été reçue (zéro information).

Lancer une pièce et la regarder tomber fournit certaines informations. Les deux côtés de la médaille sont "égaux", donc les deux côtés sont également susceptibles de se présenter. Dans de tels cas, on dit que l'événement porte des informations sur 1 bit. Si nous mettons deux balles de couleurs différentes dans un sac, puis en tirant aveuglément une balle, nous obtiendrons également des informations sur la couleur de la balle en 1 bit.

L'unité de mesure de l'information s'appelle un bit (bit) - une abréviation des mots anglais chiffre binaire, que signifie un chiffre binaire.

En informatique, un bit correspond à l'état physique du support d'information : aimanté - non aimanté, il y a un trou - il n'y a pas de trou. Dans ce cas, un état est généralement désigné par le chiffre 0 et l'autre par le chiffre 1. Le choix de l'une des deux options possibles vous permet également de faire la distinction entre la vérité logique et le mensonge. Une séquence de bits peut encoder du texte, une image, un son ou toute autre information. Cette méthode de présentation des informations est appelée codage binaire. (encodage binaire) .

En informatique, une quantité appelée octet est souvent utilisée et est égale à 8 bits. Et si le bit vous permet de choisir une option sur deux possibles, alors l'octet, respectivement, est 1 sur 256 (2 8). Outre les octets, des unités plus grandes sont utilisées pour mesurer la quantité d'informations :

1 Ko (un kilo-octet) = 2\up1210 octets = 1024 octets ;

1 Mo (un mégaoctet) = 2\up1210 Ko = 1024 Ko ;

1 Go (un gigaoctet) = 2\up1210 Mo = 1024 Mo.

Par exemple, un livre contient 100 pages ; 35 lignes par page, 50 caractères par ligne. Le volume d'informations contenues dans le livre est calculé comme suit:

La page contient 35 × 50 = 1750 octets d'informations. Le volume de toutes les informations dans le livre (dans différentes unités):

1750 × 100 = 175 000 octets.

175 000 / 1024 = 170,8984 Ko.

170,8984 / 1024 = 0,166893 Mo.

Déposer. Formats de fichiers.

Un fichier est la plus petite unité de stockage d'informations contenant une séquence d'octets et portant un nom unique.

Le but principal des fichiers est de stocker des informations. Ils sont également conçus pour transférer des données d'un programme à l'autre et d'un système à l'autre. En d'autres termes, un fichier est un référentiel de données stables et mobiles. Mais un fichier est plus qu'un simple magasin de données. Le fichier contient généralement nom, attributs, heure de modification et heure de création.

Une structure de fichiers est un système de stockage de fichiers sur un périphérique de stockage, tel qu'un disque. Les fichiers sont organisés en répertoires (parfois appelés répertoires ou dossiers). Tout répertoire peut contenir un nombre arbitraire de sous-répertoires, chacun pouvant stocker des fichiers et d'autres répertoires.

La façon dont les données sont organisées en octets s'appelle le format de fichier. .

Pour lire un fichier, comme une feuille de calcul, vous devez savoir comment les octets représentent les nombres (formules, texte) dans chaque cellule ; lire le fichier éditeur de texte, vous devez savoir quels octets représentent des caractères et quelles polices ou champs, ainsi que d'autres informations.

Les programmes peuvent stocker des données dans un fichier d'une manière choisie par le programmeur. Cependant, on s'attend souvent à ce que les fichiers soient utilisés par différents programmes, de sorte que de nombreux programmes d'application prennent en charge certains des formats les plus courants afin que d'autres programmes puissent comprendre les données du fichier. Les éditeurs de logiciels (qui souhaitent que leurs logiciels deviennent des « standards ») publient souvent des informations sur les formats qu'ils créent afin qu'ils puissent être utilisés dans d'autres applications.

Tous les fichiers peuvent être conditionnellement divisés en deux parties - texte et binaire.

Les fichiers texte sont le type de données le plus courant dans le monde informatique. Un octet est le plus souvent alloué pour stocker chaque caractère, et les fichiers texte sont encodés à l'aide de tables spéciales dans lesquelles chaque caractère correspond à un certain nombre n'excédant pas 255. Un fichier qui n'utilise que 127 premiers nombres pour encoder est appelé ASCII- fichier (abréviation de American Standard Code for Information Intercange - code standard américain pour l'échange d'informations), mais un tel fichier ne peut pas contenir de lettres autres que latines (y compris le russe). La plupart des alphabets nationaux peuvent être codés à l'aide d'une table à huit bits. Pour la langue russe, trois encodages sont actuellement les plus populaires : Koi8-R, Windows-1251 et l'encodage dit alternatif (alt).

Des langues telles que le chinois contiennent beaucoup plus de 256 caractères, donc plusieurs octets sont utilisés pour encoder chaque caractère. Pour économiser de l'espace, l'astuce suivante est souvent utilisée : certains caractères sont codés sur un octet, tandis que d'autres utilisent deux octets ou plus. Une tentative de généralisation de cette approche est la norme Unicode, qui utilise une gamme de nombres de zéro à 65 536 pour coder les caractères. Une telle gamme permet de représenter numériquement les caractères d'une langue de n'importe quel coin de la planète.

Mais propre fichiers texte deviennent de moins en moins courants. Les documents contiennent souvent des images et des diagrammes, et diverses polices sont utilisées. En conséquence, des formats apparaissent qui sont diverses combinaisons de formes de données textuelles, graphiques et autres.

Les fichiers binaires, contrairement aux fichiers texte, ne sont pas aussi faciles à visualiser et ils ne contiennent généralement pas de mots familiers - seulement beaucoup de caractères obscurs. Ces fichiers ne sont pas destinés à être directement lisibles par des humains. Des exemples de fichiers binaires sont des programmes exécutables et des fichiers graphiques.

Exemples de codage binaire d'informations.

Parmi la variété d'informations traitées sur un ordinateur, une part importante est constituée d'informations numériques, textuelles, graphiques et audio. Familiarisons-nous avec certaines façons de coder ces types d'informations dans un ordinateur.

Encodage des nombres.

Il existe deux formats principaux pour représenter les nombres dans la mémoire de l'ordinateur. L'un d'eux est utilisé pour encoder des nombres entiers, le second (la représentation dite à virgule flottante d'un nombre) est utilisé pour spécifier un certain sous-ensemble de nombres réels.

L'ensemble des nombres entiers pouvant être représentés dans la mémoire de l'ordinateur est limité. La plage de valeurs dépend de la taille de la zone mémoire utilisée pour stocker les nombres. DANS k-la cellule bit peut stocker 2 k différentes valeurs d'entiers .

Pour obtenir la représentation interne d'un entier positif N stocké dans k-bit machine word, il vous faut :

1) traduire le nombre N dans le système de numération binaire ;

2) le résultat obtenu est complété à gauche par des zéros non significatifs jusqu'à k digits.

Par exemple, pour obtenir la représentation interne de l'entier 1607 dans une cellule de 2 octets, le nombre est converti en binaire : 1607 10 = 11001000111 2 . La représentation interne de ce numéro dans la cellule est : 0000 0110 0100 0111.

Pour écrire une représentation interne d'un entier nombre négatif(–N) il vous faut :

1) obtenir la représentation interne d'un nombre positif N;

2) récupérer le code retour de ce numéro en remplaçant 0 par 1 et 1 par 0 ;

3) ajouter 1 au numéro reçu.

La représentation interne d'un entier négatif est -1607. En utilisant le résultat de l'exemple précédent, la représentation interne du nombre positif 1607 s'écrit : 0000 0110 0100 0111. Le code inverse est obtenu en inversant : 1111 1001 1011 1000. On en ajoute un : 1111 1001 1011 1001 - c'est le code interne représentation binaire du nombre -1607.

Le format à virgule flottante utilise une représentation numérique réelle R comme produit de la mantisse m basé sur le système de numération n dans une certaine mesure p, qui s'appelle l'ordre : R=m * np.

La représentation d'un nombre sous forme de virgule flottante est ambiguë. Par exemple, les égalités suivantes sont vraies :

12,345 \u003d 0,0012345 × 10 4 \u003d 1234,5 × 10 -2 \u003d 0,12345 × 10 2

Le plus souvent, les ordinateurs utilisent une représentation normalisée d'un nombre sous forme de virgule flottante. La mantisse dans cette représentation doit satisfaire la condition :

0,1 pJ m p. En d'autres termes, la mantisse est inférieure à 1 et le premier chiffre significatif n'est pas zéro ( p est la base du système numérique).

Dans la mémoire de l'ordinateur, la mantisse est représentée sous la forme d'un entier contenant uniquement des chiffres significatifs (les entiers 0 et une virgule ne sont pas stockés), donc pour le nombre 12,345, le nombre 12,345 sera stocké dans la cellule mémoire allouée pour stocker la mantisse. restaurer uniquement le numéro d'origine, il ne reste plus qu'à le sauvegarder afin, dans cet exemple est 2.

Encodage de texte.

L'ensemble de caractères utilisé pour écrire un texte s'appelle un alphabet. Le nombre de caractères d'un alphabet s'appelle sa cardinalité.

Pour représenter des informations textuelles dans un ordinateur, on utilise le plus souvent un alphabet d'une capacité de 256 caractères. Un caractère d'un tel alphabet porte 8 bits d'information, puisque 2 8 \u003d 256. Mais 8 bits constituent un octet, par conséquent, le code binaire de chaque caractère occupe 1 octet de mémoire informatique.

Tous les caractères d'un tel alphabet sont numérotés de 0 à 255, et chaque numéro correspond à un code binaire de 8 bits de 00000000 à 11111111. Ce code est le nombre ordinal du caractère dans le système de numération binaire.

Pour différents types d'ordinateurs et de systèmes d'exploitation, différentes tables de codage sont utilisées, qui diffèrent dans l'ordre dans lequel les caractères alphabétiques sont placés dans la table de codage. La table de codage ASCII déjà mentionnée est la norme internationale sur les ordinateurs personnels.

Le principe du codage alphabétique séquentiel est que dans la table des codes ASCII, les lettres latines (majuscules et minuscules) sont classées par ordre alphabétique. La disposition des nombres est également ordonnée par ordre croissant de valeurs.

Seuls les 128 premiers caractères sont standard dans ce tableau, c'est-à-dire les caractères avec des nombres de zéro (code binaire 00000000) à 127 (01111111). Cela inclut les lettres de l'alphabet latin, les chiffres, les signes de ponctuation, les parenthèses et certains autres symboles. Les 128 codes restants, commençant par 128 (code binaire 10000000) et se terminant par 255 (11111111), sont utilisés pour coder les lettres des alphabets nationaux, les pseudographies et les symboles scientifiques.

Codage des informations graphiques.

La mémoire vidéo contient informations binaires sur l'image affichée à l'écran. Presque toutes les images créées, traitées ou visualisées à l'aide d'un ordinateur peuvent être divisées en deux grandes parties - les graphiques raster et vectoriels.

Les images raster sont une grille à une seule couche de points appelés pixels (pixel, de l'élément d'image anglais). Le code du pixel contient des informations sur sa couleur.

Pour une image en noir et blanc (sans demi-teintes), un pixel ne peut prendre que deux valeurs : blanc et noir (s'allume - ne s'allume pas), et un bit de mémoire suffit à l'encoder : 1 - blanc, 0 - noir.

Un pixel sur un écran couleur peut avoir différentes couleurs, donc un bit par pixel ne suffit pas. Deux bits par pixel sont nécessaires pour coder une image en 4 couleurs car deux bits peuvent prendre 4 états différents. Par exemple, cette option de codage couleur peut être utilisée : 00 - noir, 10 - vert, 01 - rouge, 11 - marron.

Sur les moniteurs RVB, toute la variété des couleurs est obtenue en combinant les couleurs de base - rouge (Rouge), vert (Vert), bleu (Bleu), à partir desquelles vous pouvez obtenir 8 combinaisons de base :

Bien sûr, si vous avez la possibilité de contrôler l'intensité (luminosité) de la lueur des couleurs de base, le nombre d'options différentes pour leurs combinaisons, générant diverses nuances, augmente. Nombre de couleurs différentes - POUR et le nombre de bits pour les coder - N sont interconnectés par une formule simple : 2 N = POUR.

Contrairement aux graphiques raster image vectorielle en couches. Chaque élément d'une image vectorielle - une ligne, un rectangle, un cercle ou un fragment de texte - est situé dans son propre calque, dont les pixels sont définis indépendamment des autres calques. Chaque élément d'une image vectorielle est un objet qui est décrit à l'aide d'un langage spécial (équations mathématiques de lignes, d'arcs, de cercles, etc.) Objets complexes(lignes brisées, formes géométriques diverses) se présentent comme un ensemble d'objets graphiques élémentaires.

Les objets d'image vectorielle, contrairement aux graphiques raster, peuvent changer de taille sans perte de qualité (le grain augmente lorsqu'une image raster est agrandie).

Codage sonore.

Nous savons par la physique que le son sont les vibrations de l'air. Si vous convertissez l'audio en signal électrique(par exemple, à l'aide d'un microphone), vous pouvez voir la tension évoluer en douceur avec le temps. Pour le traitement informatique, un tel signal analogique doit en quelque sorte être converti en une séquence de nombres binaires.

Cela se fait, par exemple, comme ceci - la tension est mesurée à intervalles réguliers et les valeurs résultantes sont enregistrées dans la mémoire de l'ordinateur. Ce processus est appelé échantillonnage (ou numérisation) et le dispositif qui l'exécute est appelé convertisseur analogique-numérique (ADC).

Pour reproduire le son ainsi encodé, il faut faire la conversion inverse (pour cela on utilise un convertisseur numérique-analogique). - DAC), puis lisser le signal de pas résultant.

Plus le taux d'échantillonnage est élevé et plus il y a de bits alloués pour chaque échantillon, plus le son sera représenté avec précision, mais la taille du fichier son augmentera également. Par conséquent, en fonction de la nature du son, des exigences de sa qualité et de la quantité de mémoire occupée, certaines valeurs de compromis sont choisies.

La méthode décrite d'encodage des informations sonores est assez universelle, elle vous permet de représenter n'importe quel son et de le transformer de différentes manières. Mais il y a des moments où il est plus avantageux d'agir différemment.

Une manière assez compacte de représenter la musique a longtemps été utilisée - la notation musicale. Il indique avec des symboles spéciaux quelle est la hauteur du son, sur quel instrument et comment jouer. En fait, cela peut être considéré comme un algorithme pour un musicien, écrit dans un langage formel spécial. En 1983, les principaux fabricants d'ordinateurs et de synthétiseurs musicaux ont développé une norme définissant un tel système de codes. C'est ce qu'on appelle le MIDI.

Bien sûr, un tel système de codage ne vous permet pas d'enregistrer tous les sons, il ne convient qu'à la musique instrumentale. Mais il a aussi des avantages indéniables : un enregistrement extrêmement compact, naturel pour un musicien (presque n'importe quel éditeur MIDI permet de travailler avec de la musique sous forme de notes ordinaires), facilité de changement d'instruments, changement de tempo et de tonalité de la mélodie.

Il existe d'autres formats d'enregistrement de musique purement informatiques. Parmi eux se trouve le format MP3, qui permet d'encoder de la musique avec une qualité et un taux de compression très élevés, tandis qu'au lieu de 18 à 20 compositions musicales, environ 200 sont placées sur un disque compact standard (CDROM).Une chanson occupe environ 3,5 Mo, ce qui permet aux internautes d'échanger facilement des compositions musicales.

L'ordinateur est une machine universelle d'information.

L'un des principaux objectifs d'un ordinateur est le traitement et le stockage d'informations. Avec l'avènement des ordinateurs, il est devenu possible de travailler avec des volumes d'informations auparavant impensables. Les bibliothèques contenant de la littérature scientifique et de fiction sont converties sous forme électronique. Les anciennes archives de photos et de films gagnent nouvelle vie sous forme numérique.

Anna Chugainova

M. : FIZMATLIT, 2006. - 768 p.

Le dictionnaire de référence encyclopédique contient plus de 18 000 termes russes et anglais, thématiquement systématisés dans les principales sections suivantes : I. Principes fondamentaux des technologies de l'information ; II. Automatisation des processus d'information et des systèmes automatisés (AC); III. Appui technique de l'UA ; IV. logiciel AS ; V. Multimédia, hypermédia, réalité virtuelle, vision artificielle ; VI. Technologies de réseau pour le traitement et la transmission de données; VII. Argot informatique et réseau ; VIII. Pictogrammes utilisés dans les e-mails ; IX. Abréviations de mots et d'expressions utilisés sur Internet.

Les entrées du dictionnaire sont de nature étendue et comprennent des données de référence sur les objets de description, ainsi que des liens vers des sources documentaires primaires pour une connaissance plus complète de celles-ci pour les utilisateurs intéressés.

La structure et le contenu du dictionnaire permettent de l'utiliser pour une étude systématique des matériaux sur les sections et sous-sections thématiques d'intérêt pour le lecteur, pour faire une étude préliminaire des décisions liées à la conception de systèmes automatisés d'information et de télécommunication hétérogènes, et aussi de préparer sur sa base une documentation pédagogique et méthodologique, de révision, de référence, etc.

Le dictionnaire s'adresse à un large éventail d'utilisateurs dont les activités professionnelles ou les intérêts sont liés aux technologies modernes de l'information.

Format: djvu

Taille: 7,1 Mo

Télécharger: yandex.disk

CONTENU

Préface à l'édition encyclopédique du dictionnaire ....................................... 7

Préface à la troisième édition du dictionnaire, sur le dictionnaire de référence et son auteur... 9

De l'auteur ....................................................... ... .... onze

À propos de l'utilisation du dictionnaire .................................................. 13

I. Fondamentaux des technologies de l'information ...................... 15

1.1. Données, informations, connaissances, logique............................................ 15

1.2. Ressources informationnelles, théorie de l'information, informatique 19

1.3. Supports de données, documents, documentation, publications.............. 22

1.4. Principes de représentation structurée des documents et des données....... 27

1.4.1. Éléments d'information et leurs types .............. 27

1.4.2. Enregistrement, Fichier, Tableau, Clé .................................. 30

1.4.3. Structures, modèles de données et termes associés 34

1.4.4. Format, champ de données et termes associés .................................. 45

1.5. Technologies de l'information.................................. 49

1.5.1. Concepts et termes généraux .................................. 49

1.5.2. Manipulation et traitement des documents et des données .................................. 52

1.5.3. Saisie de documents et de données dans un ordinateur ....................... 58

1.5.4. Recherche d'informations ^ concepts et termes généraux ...... 63

1.5.5. Indexation, recherche image de documents et requêtes 66

1.6. Sécurité des technologies de l'information .................................. 74

1.6.1. Concepts et termes généraux .................................. 74

1.6.2. Encodage et décodage de documents et de données.............. 83

1.6.3. Cryptologie et concepts associés ....................... 87

II. Automatisation des processus d'information et systèmes d'information automatisés 93

2.1. Concepts et termes généraux ....................................................... 93

2.2. Automatisation des processus d'information et de bibliothèque............ 95

2.2.1. Termes liés à l'automatisation.............................. 95

2.3. Systèmes automatisés.................................. 98

2.3.1. Concepts et termes généraux .................................. 98

2.3.2. Systèmes automatisés orientés vers la fonctionnalité..... 106

2.4. Support linguistique et informationnel des systèmes automatisés 117

2.4.1. Support linguistique ^ concepts et termes généraux ......... 117

2.4.2. Langages de recherche d'informations et dictionnaires AIS....... 119

2.4.3. Métadonnées et formats AIS 128

2.4.4. Prise en charge des informations de l'AIS ....................... 147

2.5. Personnel et utilisateurs des systèmes automatisés ....................... 153

2.5.1. Développeurs et personnel AIS .................................. 153

2.5.2. Utilisateurs AIS ....................................... 157

2.5.3. Certification des spécialistes en AIS .................................. 159

2.6. Processus de création et d'exploitation des systèmes automatisés ......... 162

2.6.1. Conception de systèmes automatisés................................. 162

2.6.2. Cycle de vie AIS et intégration du système.................................. 165

III. Support technique des systèmes automatisés ......... 169

3.1. Ordinateurs, leurs types et classification générale 169

3.2. Architecture, configuration, plate-forme informatique............ 175

3.3. Ordinateurs personnels (PC) .................................. 178

3.4. PC portables et appareils numériques autonomes à usages divers... 185

3.4.1. Types d'ordinateurs portables .................................................. 185

3.4.2. Appareils de lecture et d'enregistrement numériques 188

3.5. Unité système et éléments de sa conception ....................... 191

3.5.1. Processeurs, leurs types et termes associés.............. 192

3.5.2. Mémoire d'ordinateur ^ concepts et termes ....................... 202

3.5.3. Périphériques fonctionnels de la mémoire de l'ordinateur .................. 208

3.5.4. Adaptateurs, interfaces et termes associés.............. 216

3.5.5. Cartes, Ports, Bus, Slots................................................ 224

3.6. Périphériques informatiques (externes) .................................. 233

3.6.1. Mémoire d'ordinateur externe, lecteurs et termes associés ...... 233

3.6.2. CD et termes associés .................................. 251

3.6.3. Périphériques d'entrée de données, manipulateurs ................ 260

3.6.4. Périphériques de sortie.............................................. 271

3.6.5. Modems, encodeurs, alimentations.................. 286

3.7. Cartes PC ....................................................... ............... .. 289

3.8. Base informatique microélectronique .................................. 294

3.9. Dispositifs optoélectroniques.................................. 299

IV. Logiciels pour systèmes automatisés ......... 303

4.1. Algorithmes, programmes, programmation.................................. 303

4.1.1. Concepts et termes généraux 303

4.1.2. Langages de programmation.................................. 307

4.1.3. Termes liés à la programmation.............................. 319

4.2. Logiciel général.................................. 327

4.2.1. Systèmes d'exploitation................................. 328

4.2.2. Outils de service logiciel généraux 338

4.3. Logiciels d'application pour les systèmes automatisés ...... 339

4.3.1. Concepts et termes généraux .................................. 339

4.3.2. Programmes d'application.................................. 342

4.3.3. Virus informatiques et antivirus ....................... 346

4.4. Termes liés au fonctionnement des outils logiciels 350

4.4.1. Quelques concepts et termes généraux ....................... 350

4.4.2. Archivage, compression-restauration des fiches de données............. 352

4.4.3. Accès, adresse et termes associés.................................. 364

V. Multimédia, hypermédia, réalité virtuelle, vision artificielle. 372

5.1. Systèmes multimédias et termes associés. .................. 372

5.2. Moyens de fournir un accompagnement musical et vocal ...... 375

5.2.1. Concepts et termes généraux .................................. 375

5.2.2. Fichiers son, leurs normes et formats .................................. 380

5.3. Graphiques machine (ordinateur) .................. 389

5.3.1. Concepts et termes généraux .................................. 389

5.3.2. Fichiers graphiques et leurs formats.............................. 392

5.3.3. Technologie de l'infographie .................................. 400

5.4. Vidéo informatique, télévision numérique et animation .................. 408

5.4.1. Concepts et termes généraux .................................. 408

5.4.2. Technologie vidéo .................................................. 412

5.4.3. Technologie d'animation.............................. 416

5.4.4. Télévision numérique 420

5.5. Réalité virtuelle, mondes parallèles. ....................... 424

5.6. Vision par ordinateur.................................................. 427

VI. Technologies de réseau. Moyens de traitement et de transmission des informations 430

6.1. Concepts et termes généraux ....................................... 430

6.2. Réseaux locaux .................................................. 433

6.3. Réseaux informatiques distribués.................................. 441

6.3.1. Concepts et termes généraux .................................. 441

6.3.2. Intranet....................................... 450

6.3.3. ETHERNET ............................... 455

6.4. Réseaux informatiques mondiaux, Internet ....................... 471

6.4.1. Concepts et termes généraux .................................. 471

6.4.2. Technologie Web.................................................. 482

6.4.3. Technologies de transmission de données sur les canaux Internet............ 489

6.4.4. Services et outils de service sur Internet.............................. 499

6.4.5. Services de réseau numérique intégrés - RNIS .................................. 518

6.4.6. Communication cellulaire et téléphonie informatique .................... 520

6.4.7. Equipements de télécommunication des bâtiments .................................. 526

6.4.8. Développement de moyens et complexes techniques basés sur l'utilisation des technologies de télécommunication 532

6.4.9. Objets des relations juridiques sur Internet .................................. 533

6.5. Moyens et technologies de protection des réseaux informatiques .................................. 536

6.6. Normes de base pour les réseaux de données. ....................... 541

6.6.1. Normes ISO ....................................................... . 541

6.6.2. Normes IEEE .................................. 543

6.6.3. Normes UIT-T .................................................. 554

6.6.4. Autres normes et protocoles.............................. 560

VII. Argot informatique et réseau ............................... 565

VIII. Icônes et symboles smiley pour E-mail........... 592

IX. Abréviations de mots et d'expressions utilisés sur Internet ...... 594

Références ............................................... 597

Index alphabétique anglais.............................................................. 644

Index alphabétique russe.............................................................. ... 708

INFORMATION (informatique en anglais), science consistant à extraire des informations à partir de messages, à créer des ressources d'information, à programmer le comportement de machines et d'autres entités liées à la construction et à l'utilisation d'un environnement homme-machine pour résoudre des problèmes de modélisation, de conception, d'interaction, d'apprentissage, etc. Elle étudie les propriétés de l'information, les méthodes pour l'extraire des messages et la présenter sous une forme donnée ; propriétés, méthodes et moyens d'interaction de l'information ; propriétés des ressources d'information, méthodes et moyens de leur création, présentation, stockage, accumulation, recherche, transfert et protection ; propriétés, méthodes et moyens de construction et d'utilisation des machines programmables et de l'environnement homme-machine pour la résolution de problèmes.

Production scientifique de l'informatique

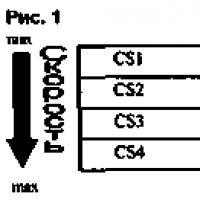

La production scientifique de l'informatique sert de base méthodologique à la construction d'un environnement homme-machine pour résoudre des problèmes (Fig. 1) liés à divers domaines d'activité.

Les résultats des études d'entités (généralement appelées objets en science) sont représentés par leurs modèles symboliques et/ou physiques. Les modèles symboliques sont des descriptions des connaissances acquises [voir. Modélisation symbolique(s-modélisation)], et physiques sont des prototypes des objets étudiés, reflétant leurs propriétés, leur comportement, etc. Le résultat scientifique est un modèle d'un système de connaissances (ou un composant d'un modèle préalablement défini et publié) qui décrit un ensemble d'objets, y compris l'objet à l'étude, et les relations entre eux . La description du modèle est présentée sous la forme d'un message destiné à être reconnu et interprété par la communauté scientifique. La valeur du résultat dépend du pouvoir prédictif, de la reproductibilité et de l'applicabilité du modèle, ainsi que des propriétés du message contenant sa description.

Des exemples de résultats qui ont joué un rôle remarquable dans le support méthodologique de la construction d'un environnement homme-machine pour la résolution de problèmes peuvent être : le modèle d'une machine électronique numérique inventée par J. von Neumann avec des instructions de programme et des données stockées dans une mémoire partagée [ connu sous le nom de modèle de von Neumann] et l'architecture de von Neumann] ; inventé par le créateur du Web (cf. Le World Wide Web) T Berner Lee Protocole HTTP (eng. Hypertext transfer protocol - hypertext transfer protocol), qui est un protocole au niveau de l'application qui définit les règles de transfert de messages dans les systèmes hypermédias (voir Multimédia), et un identifiant de ressource uniforme URI (eng. Uniform Resource Identifier), qui est devenu la norme pour enregistrer une adresse de ressource publiée sur Internet. Il est difficile de trouver aujourd'hui (2017) un domaine d'activité où les produits scientifiques de l'informatique ne soient pas appliqués. Sur cette base, le courrier électronique, le Web, les moteurs de recherche, la téléphonie IP, l'Internet des objets et d'autres services Internet ont été créés (voir Internet); enregistrement audio, photo et vidéo numérique; systèmes de conception assistée par ordinateur (CAO); simulateurs informatiques et robots (voir. Modélisation informatique), systèmes de communication numériques, systèmes de navigation, imprimantes 3D, etc.

Concepts de base

La formation continue de l'informatique s'accompagne du développement de son appareil conceptuel et de l'affinement de l'objet de recherche. En 2006, un nouveau domaine de recherche a été créé à l'Institut des problèmes informatiques de l'Académie russe des sciences (IPI RAS) - modélisation symbolique d'objets arbitraires dans un environnement homme-machine (en abrégé- Avec simulation symbolique ou s-simulation). L'un des premiers projets scientifiques dans ce domaine a été consacré à la méthodologie de construction d'un modèle symbolique du système de connaissance informatique dans un environnement homme-machine. . Dans la théorie de la modélisation symbolique (s-modélisation) créée en 2009, la prochaine version du modèle symbolique du noyau du système de concepts informatiques a été proposée, qui comprend les concepts suivants.

Message(message anglais) est considéré comme un ensemble ordonné fini de symboles (visuels, audio, etc.; voir Symbole en informatique) ou son code (voir Code en informatique) qui satisfait le protocole d'interaction entre la source et le destinataire. L'existence d'un message présuppose l'existence d'une source de message, d'un destinataire, d'un transporteur, d'un support de transmission, d'un moyen de livraison et d'un protocole d'interaction entre la source et le destinataire. Dans l'environnement homme-machine pour la résolution de problèmes (environnement s), les personnes à l'aide de machines programmables (machines s) forment des messages, les présentent dans des langages de requête, de programmation, etc. ; effectuer diverses conversions (par exemple, de l'analogique au numérique et vice versa; du non compressé au compressé et vice versa; d'une forme de représentation de document à une autre); reconnaître, utiliser des messages pour construire de nouveaux messages (programmes, documents, etc.) ; interpréter sur des modèles de systèmes conceptuels (qui sont stockés dans la mémoire de l'interprète également sous forme de messages); échanger des messages à l'aide de systèmes de règles implémentés par logiciel et matériel (protocoles réseau, voir ci-dessous). Réseau informatique); enregistrer et accumuler des messages (en créant des bibliothèques électroniques, des encyclopédies et d'autres ressources d'information), résoudre les problèmes de recherche et de protection des messages.

Interprète de messages est étudié en tant que constructeur du message de sortie en fonction de l'entrée conformément au système donné de règles d'interprétation. Une condition nécessaire à la construction d'un interpréteur de messages est l'existence de modèles des langages d'entrée et de sortie, ainsi que de modèles de systèmes de concepts sur lesquels les messages écrits dans les langages d'entrée et de sortie doivent être interprétés.

Données(Données anglaises) - un message nécessaire pour résoudre un certain problème ou ensemble de problèmes, présenté sous une forme conçue pour la reconnaissance, la transformation et l'interprétation par le résolveur (programme ou personne). Une personne perçoit des données (textes, images, etc.) sous forme symbolique, tandis qu'un programme informatique ou un appareil informatique (smartphone, appareil photo numérique, etc.) les perçoit sous forme de code.

Information(informations en anglais) est étudié à la suite de l'interprétation du message sur le modèle du système de concepts [voir. Modélisation symbolique(s-simulation)]. Pour extraire des informations d'un message, il est nécessaire que le message reçu soit présenté sous une forme conçue pour être reconnue et interprétée par le destinataire du message ; des modèles de systèmes conceptuels stockés dans la mémoire de l'interprète, parmi lesquels celui nécessaire à l'interprétation du message reçu ; mécanismes pour rechercher le modèle nécessaire, interpréter le message, présenter le résultat de l'interprétation sous une forme conçue pour le destinataire (Fig. 2).

Par exemple, le résultat de l'interprétation du message ma, présenté en langue a, reçu par le traducteur (humain ou robot) sous la forme d'un message mb en langue b, est l'information extraite du message ma.

Tâche programmable(s-problème) est considéré comme un ensemble (Formul , Rulsys , Alg , Prog ), où Formul est l'énoncé du problème ; Rulsys - un ensemble de systèmes de règles obligatoires et d'orientation pour résoudre un problème, alignés sur Formula; Alg est l'union d'ensembles d'algorithmes dont chacun correspond à un élément de Rulsys ; Prog est l'union d'ensembles de programmes, dont chacun est affecté à l'un des éléments de Alg . Chaque élément de Rulsys , Alg et Prog doit faire l'objet d'une description d'application. Les descriptions de l'utilisation des éléments Rulsys incluent la spécification du type de résolveur de problèmes (s-machine autonome, coopération réseau de s-machines, coopération homme-s-machine, etc.), les exigences de sécurité de l'information, etc. les modes de fonctionnement du résolveur de problèmes ( automatique local, automatique distribué, interactif local, etc.), les exigences relatives au résultat obtenu, etc. Les descriptions de l'application des programmes incluent des données sur les langages de mise en œuvre, les systèmes d'exploitation, etc.

Algorithme– une description formalisée d'un ensemble fini d'étapes de résolution du problème, correspondant à l'un des éléments de Rulsys et permettant une correspondance univoque entre un ensemble donné de données d'entrée et l'ensemble résultant de données de sortie.

Programme- un algorithme implémenté dans un langage de programmation haut niveau, un langage orienté machine et/ou un système d'instructions machine. Présenté sous la forme d'un message qui définit le comportement d'un solveur de problème s-machine avec des propriétés données. Existe en incarnations symboliques, de code et de signal, reliées par des relations de traduction (voir Compilateur en informatique).

Symbole(symbole anglais) - substitut d'un objet naturel ou inventé, désignant cet objet et étant un élément d'un certain système de construction de messages symboliques (textes, notations musicales, etc.), destiné à être perçu par une personne ou un robot. Par exemple, l'alphabet russe est un système de symboles textuels ; la lettre A dans ce système est un symbole qui remplace le son correspondant du système de symboles audio de la parole de la langue russe; La lettre A correspond à un symbole textural tactile (perçu par le toucher avec les doigts) dans un système de messagerie texte pour aveugles connu sous le nom de Braille (voir Fig. Braille). L'ensemble des symboles visuels, sonores et autres choisis pour construire des messages d'un certain type est considéré comme un ensemble d'objets constructifs élémentaires, dont chacun est doté d'un ensemble d'attributs et d'un ensemble d'opérations autorisées. La création de structures à partir des éléments de cet ensemble est déterminée par le système de règles de construction des modèles symboliques [pour plus de détails, voir l'article Symbole en informatique (s-symbole)].

Code(code anglais) - substitut d'un symbole ou d'un message symbolique utilisé pour les représenter dans les ordinateurs, les smartphones et autres machines programmables et conçu pour construire, enregistrer, transmettre et interpréter des messages symboliques [pour plus de détails, voir l'article Code en informatique ( code s)].

Signal(signal anglais) est un impact optique, sonore ou autre perçu par les sens humains ou les capteurs de la machine, ou la représentation du code sous la forme d'une fréquence de rayonnement électromagnétique, de compositions de valeurs de tension électrique, ou autre, conçu pour être perçu par le matériel de la machine (par exemple, unité centrale de traitement ordinateur, microprocesseur navigateur automobile). Symboles, codes et signaux sont interconnectés par des relations de transformation. Chaque symbole et construction symbolique, conçu pour être perçu par un humain ou un robot, peut être associé à une correspondance biunivoque avec des codes conçus pour les manipuler à l'aide de logiciels et de dispositifs informatiques.

Modèle de système conceptuel. Le modèle S Cons d'un système de concepts est considéré comme un couple (ConsSet , ConsRel ), où ConsSet est un ensemble de concepts ; ConsRel est une famille de relations définies sur ConsSet . Définition d'un système de concepts - une description de son modèle, accompagnée d'une indication de la portée. La description est présentée sous la forme d'un message destiné à être interprété par le destinataire, présenté, stocké, distribué, accumulé et recherché dans l'environnement homme-machine de l'activité intellectuelle. Un système de concepts considéré comme défini ne devrait pas inclure des concepts qui n'ont pas de définitions (et en même temps ne sont pas liés à des concepts-axiomes). Détermination de la portée du modèle - une description des types de correspondants (à qui la définition s'adresse), l'objectif en cours de réalisation auquel la définition a du sens (classes de tâches dans l'étude desquelles la définition peut être utile) , l'étape à laquelle il convient d'utiliser la définition (concept, méthodologie de résolution, etc.) d.).

Modèle de système de connaissances. Le concept de "savoir" dans la modélisation s [voir. Modélisation symbolique(s-simulation)] est défini comme l'état du récepteur du message lorsque le message de sortie résultant de l'interprétation du message d'entrée est reconnu comme déjà connu et ne nécessite pas de modifications des modèles de systèmes conceptuels stockés dans la mémoire du message destinataire. Le concept de "connaissance" est défini comme une capacité complexe à extraire des informations de messages contenant les conditions de tâches d'une certaine classe (il peut s'agir de tâches de reconnaissance de formes, de traduction d'une langue à une autre, ou d'autres classes de tâches). Le S-modèle du système de connaissances est considéré comme une triade (Cons , Lang , Interp ), où Cons est le s-modèle du système de concepts ; Lang est le s-modèle de l'ensemble des langages de messages interprétés sur Cons ; Interp est le s-model de la collection d'interprètes sur Cons de messages composés dans des langues de Lang.

L'interprétation du message sur le modèle Cons comprend :

1) construire un message de sortie (extraction d'informations) en fonction d'un message d'entrée donné (les messages sont présentés dans des langues de l'ensemble Lang) ;

2) analyse du message de sortie (si des changements sont nécessaires dans le modèle Cons);

3) si nécessaire, modifiez le modèle Cons ; sinon, fin.

Par exemple, le centre cérébral d'un système moderne de conception assistée par ordinateur (CAO) est le système de connaissances. La productivité de la conception dépend de la qualité de sa construction.

Machine programmable(s-machine) est une structure logicielle et matérielle permettant de résoudre des problèmes. Les superordinateurs, les ordinateurs centraux, les ordinateurs personnels, les ordinateurs portables, les smartphones, les navigateurs, les appareils photo numériques et les caméras vidéo sont tous des s-cars. Les claviers, souris, trackballs, pavés tactiles et autres périphériques d'entrée sont des composants des s-machines qui convertissent les caractères en codes acceptés par les pilotes (voir Pilote en informatique) des périphériques correspondants. Les moniteurs d'ordinateurs personnels, les écrans d'ordinateurs portables, les navigateurs, etc. convertissent les codes générés par les contrôleurs vidéo en compositions symboliques conçues pour le canal visuel humain.

(environnement s) - une association de réseaux informatiques et de machines programmables individuelles utilisées pour résoudre divers problèmes. Moyens d'informatisation de divers types d'activité. L'environnement S doit permettre la représentation de codes numériques de modèles symboliques et la manipulation de ces codes à l'aide de machines s. Au cœur des technologies modernes de communication numérique, conception assistée par ordinateur, etc., il y a une idée remarquable par les conséquences de sa mise en œuvre : réduire toute diversité symbolique à des codes numériques [et chacun d'eux à un seul code (ils ont toujours un code binaire)] et instruisent le travail avec des codes sur des machines programmables, combinées dans un environnement homme-machine pour résoudre des problèmes.

Interaction de l'information dans le milieu s(Fig. 3) est étudié comme un ensemble d'interfaces telles que "homme - homme", "homme - programme", "homme - matériel d'une machine programmable", "programme - programme", "programme - matériel" (voir Interface Port en informatique). Une personne perçoit des signaux analogiques d'entrée (lumière, son, etc.) à l'aide de dispositifs d'entrée visuels, auditifs et autres de la biointelligence (un système biologique qui assure le fonctionnement de l'intellect). Il convertit les signaux qui l'intéressent en constructions symboliques visuelles, sonores et autres utilisées dans les processus de la pensée. Les signaux de sortie de la biointelligence sont réalisés par des gestes (par exemple, utilisés lors de la saisie à partir du clavier et de la souris), de la parole, etc. . L'entrée et la sortie des programmes sont les données d'entrée et les codes de résultat (voir Fig. Code en informatique), et l'entrée et la sortie du matériel sont des signaux. Les signaux analogiques d'entrée sont convertis en signaux numériques à l'aide convertisseurs analogique-numérique(ADC), et la sortie numérique vers analogique en utilisant convertisseurs numérique-analogique(DAC).

Dans l'environnement s moderne (2017), les moyens naturels de perception, de traitement et de stockage des signaux humains sont complétés par des moyens inventés : caméras numériques photo et vidéo, smartphones, etc. Une partie bien connue des technologies d'interaction de l'information est représentée par le développement rapide Services Internet. Utilisé pour interagir avec les gens E-mail(e-mail en anglais), différents types de connexion Internet [ Téléphonie Internet(téléphonie IP); par exemple, mis en œuvre dans le service Internet Skype ; messagers (messager anglais - connecté); par exemple, le service Internet Telegram), les réseaux sociaux (réseaux sociaux anglais), etc. Internet des objets » sont utilisés (voir. Internet ).

Classes de tâches de base

Basé sur l'étude des propriétés et des modèles modélisation symbolique(s-simulation) les classes suivantes de problèmes informatiques de base sont définies.

Représentation de modèles d'objets arbitraires, conçu pour la perception humaine et les machines programmables, est associé à l'invention de langages de messages répondant à certaines exigences. Cette classe étudie les systèmes de symboles et de codes utilisés respectivement dans les langages orientés vers l'homme et vers la machine. Le premier comprend les langages de spécification, de programmation, de requêtes, le second - les systèmes d'instructions machine. Cette classe comprend également des tâches de présentation de données. Il comprend les tâches de représentation des modèles de systèmes de concepts sur lesquels les messages sont interprétés. Au niveau supérieur de la hiérarchie des tâches de cette classe se trouve la représentation des modèles de systèmes de connaissances.

Conversion des types et des formes de représentation des modèles symboliques permet d'établir une correspondance entre les modèles. Les tâches de conversion de types (par exemple, parole en texte et vice versa) et de formulaires (par exemple, analogique en numérique et vice versa ; non compressé en compressé et vice versa ; *.doc en *.pdf) sont un complément nécessaire à la tâches de représentation de modèles.

Reconnaissance des messages implique la nécessité de le présenter dans un format connu du destinataire. Lorsque cette condition est remplie, pour reconnaître le message, les tâches de mise en correspondance avec des modèles modèles, ou de mise en correspondance des propriétés du modèle reconnu avec les propriétés des modèles modèles, sont résolues. Par exemple, dans la tâche d'identification biométrique d'une personne, ses données biométriques (message d'entrée) sont comparées à un échantillon biométrique de la base de données du système biométrique.

Modélisme systèmes de concepts, systèmes de connaissances, interprètes de messages sur des modèles de systèmes de concepts ; modèles de tâches, technologies de programmation, interaction dans l'environnement s ; modèles d'architecture de s-machines, réseaux informatiques, architectures orientées services ; modèles de messages et moyens de leur construction, documents et flux de travail. Au niveau supérieur de la hiérarchie de cette classe se trouvent les tâches de construction de modèles d'environnement s et de technologies de modélisation symbolique.

Interprétation des messages(extraction d'information) présuppose l'existence du message reçu, le modèle du système de concepts sur lequel il doit être interprété et le mécanisme d'interprétation. La résolution de problèmes dans l'environnement homme-machine est l'interprétation des données initiales (message d'entrée) sur le modèle du système de concepts présenté dans l'algorithme. Le résultat de la solution est le message de sortie (information extraite du message d'entrée). Si l'interpréteur est un programme exécutable, alors les données initiales, le programme et le résultat de la résolution du problème sont représentés par les codes correspondants (voir Code en informatique). Pour le microprocesseur de la machine programmable, les messages à interpréter et les résultats de l'interprétation sont représentés par des signaux correspondant à des instructions machine et des codes de données. Par exemple, lors d'une prise de vue avec un appareil photo numérique, un message (sous la forme d'un signal lumineux) agit sur une matrice photosensible, est reconnu par celle-ci, puis converti en un code d'image numérique, qui est interprété par un programme qui améliore l'image qualité. Le résultat obtenu est converti et enregistré (sur le stockage intégré de l'appareil photo ou sur la carte mémoire) sous forme de fichier graphique.

Echange de messages : les tâches de construction d'interfaces de type "homme - homme", "homme - programme", "homme - matériel d'une machine programmable", "programme - programme", "programme - matériel" (voir Interface en informatique), " hardware - hardware » (voir Port en informatique) ; tâches de messagerie dans un environnement homme-machine pour résoudre des problèmes (avec typage des expéditeurs et des destinataires ; moyens d'envoyer, de transmettre et de recevoir des messages ; environnements de messagerie). Des systèmes de règles d'échange de messages (protocoles de réseau) sont inventés ; architectures réseau ; systèmes de gestion de documents. Par exemple, les messages sont échangés entre les processus systèmes d'exploitation(OS), programmes s-machine dans un réseau informatique, utilisateurs de messagerie, etc.

Enregistrement, accumulation et recherche de messages : les dispositifs de mémoire et de stockage, leurs mécanismes de contrôle sont étudiés et typifiés ; formes de conservation et d'accumulation ; médias, méthodes de conservation, d'accumulation et de recherche ; bases de données et bibliothèques de logiciels. Des modèles de sujet de recherche (par modèle, par caractéristiques, par description de biens) et des méthodes de recherche sont étudiés.

Protection des informations : les problématiques de prévention et de détection de vulnérabilités, de contrôle d'accès, de protection contre les intrusions, les malwares, l'interception de messages et les utilisations non autorisées sont étudiées.

Domaines de recherche

Les idées scientifiques les plus importantes qui influencent le développement de l'informatique sont incarnées dans le support méthodologique pour la construction d'outils pour soutenir les processus de cognition, d'interaction d'informations et de résolution automatisée de divers problèmes. Au stade actuel (2017) du développement de l'informatique, les complexes interconnectés suivants de domaines de recherche sont pertinents.

Automatisation des calculs(calcul à l'aide de machines programmables) : modèles, architectures et systèmes de commande de machines programmables sont étudiés ; algorithmisation de tâches programmables [algorithmes et structures de données, algorithmes distribués (Distributed Algorithms), algorithmes randomisés (Randomized Algorithms), etc.] ; informatique distribuée (Distributed Computing), informatique en nuage (Cloud Computing); la complexité et l'intensité des ressources des calculs.

La programmation: les systèmes de symboles textuels et de codes sont étudiés ; langages de programmation et spécifications de tâches ; traducteurs; bibliothèques de programmes ; Programmation du système ; système d'exploitation ; systèmes de programmation instrumentale; Systèmes de gestion de bases de données; technologies de programmation; services en ligne pour résoudre des problèmes, etc.

Environnement homme-machine pour la résolution de problèmes(s-environnement) : modèles, méthodes et outils de construction d'un s-environnement, réseaux informatiques, réseaux de communication numériques, Internet sont étudiés.

Perception et présentation des messages, interaction dans l'environnement s : des modèles, des méthodes et des moyens de perception et de présentation de messages visuels, sonores, tactiles et autres sont étudiés ; vision par ordinateur, audition et autres capteurs artificiels ; formation de messages audio, visuels, tactiles et autres (y compris combinés) conçus pour une personne et un robot partenaire ; reconnaissance de messages audio, visuels et autres (paroles, gestes, etc.); traitement d'images, infographie, visualisation, etc.; échange de messages (modèles de messages, méthodes et moyens de leur réception et transmission); interfaces de l'utilisateur, programmes, matériel, programmes avec matériel; les services d'interaction en ligne (messagers, réseaux sociaux, etc.).

Ressources et systèmes d'information pour résoudre les problèmes dans l'environnement s : les modèles, les méthodes et les moyens de construire, de représenter, de sauvegarder, d'accumuler, de rechercher, de transférer et de protéger les ressources informationnelles sont étudiés ; gestion électronique de documents; bibliothèques électroniques et autres systèmes d'information; internet (voir Le World Wide Web).

Sécurité des informations et cryptographie : les méthodes de prévention et de détection des vulnérabilités sont étudiées ; contrôle d'accès; protection des systèmes d'information contre les intrusions, les logiciels malveillants, l'interception de messages ; l'utilisation non autorisée des ressources d'information, des logiciels et du matériel.

Intelligence artificielle: des modèles, méthodes et outils de construction de robots intelligents utilisés comme partenaires humains (résolution de problèmes de sécurité, contrôle de situation, etc.) sont étudiés ; méthodes de décision expertes.

Modélisation symbolique : des systèmes de symboles visuels, sonores, tactiles et autres sont étudiés, considérés comme des objets constructifs pour la construction de modèles d'entités arbitraires conçues pour une personne (systèmes de concepts et systèmes de connaissances, objets environnement et des objets inventés par des personnes) ; des systèmes de codes, mis en conformité avec des systèmes de symboles, qui sont destinés à la construction d'équivalents en code de modèles symboliques destinés à être manipulés à l'aide de programmes ; les langages pour décrire des modèles symboliques ; typage des modèles symboliques et de leurs équivalents en code ; méthodes de construction de modèles symboliques de systèmes de concepts et de systèmes de connaissances (y compris les systèmes de connaissances sur les tâches programmables) [pour plus de détails, voir l'article Modélisation symbolique(s-simulation)].

La formation de l'informatique

Modélisation symbolique des objets étudiés a longtemps été le principal outil de présentation des connaissances acquises. L'invention de symboles (gestuels, graphiques, etc.) et les modèles de messages symboliques construits à partir d'eux, la représentation et l'accumulation de tels modèles dans l'environnement extérieur sont devenus des moyens clés pour la formation et le développement des capacités intellectuelles. Le rôle dominant des modèles symboliques dans l'activité intellectuelle est déterminé non seulement par leur compacité et leur expressivité, mais aussi par le fait qu'il n'y a pas de restrictions sur les types de supports utilisés pour les stocker. Le support peut être une mémoire humaine, une feuille de papier, une matrice d'appareil photo numérique, une mémoire d'enregistreur vocal numérique ou autre chose. Les coûts de construction, de copie, de transfert, de sauvegarde et d'accumulation de modèles symboliques sont incomparablement inférieurs aux coûts similaires associés à des modèles non symboliques (par exemple, des modèles de navires, de bâtiments, etc.). Sans outils de modélisation symbolique, il est difficile d'imaginer le développement de la science, de l'ingénierie et d'autres activités.

Aux premiers stades du développement de la modélisation, la variété des objets modélisés se limitait à ce qu'on appelle communément les objets environnementaux, et les modèles de ces objets étaient physiques. Le développement du son, du geste et d'autres moyens de modélisation symbolique des significations, provoqué par la nécessité de signaler un danger, le placement d'objets de chasse et d'autres objets d'observation, a contribué à l'amélioration des mécanismes de cognition, de compréhension mutuelle et d'apprentissage. Des langages de message ont commencé à se former, y compris des symboles sonores et gestuels. Le désir de modéliser le comportement (y compris le sien) a posé de nouveaux défis. On peut supposer qu'au départ, ce désir était associé à l'enseignement d'un comportement rationnel à la chasse, dans la vie quotidienne, lors de catastrophes naturelles. À un certain stade, ils ont pensé à créer de tels outils de modélisation qui permettraient de construire des modèles permettant leur stockage, leur copie et leur transfert.

La volonté d'accroître l'efficacité des explications accompagnant le spectacle a conduit à l'amélioration de l'appareil conceptuel et des moyens de son incarnation verbale. Le développement de modèles symboliques sous forme de schémas graphiques et l'amélioration de la parole ont conduit à un modèle graphique de la parole. L'écriture s'est créée. Il est devenu non seulement une étape importante dans le développement de la modélisation symbolique, mais aussi un outil puissant dans le développement de l'activité intellectuelle. Désormais, les descriptions des objets de modélisation et les relations entre eux pourraient être représentées par des compositions de textes, de diagrammes et de dessins. Une boîte à outils a été créée pour afficher les observations, les raisonnements et les plans sous forme de modèles symboliques pouvant être stockés et transmis. Les tâches d'invention de supports, d'outils pour écrire et créer des images, de colorants, etc.

Une étape importante de la modélisation graphique est associée aux modèles d'images schématiques (les ancêtres des dessins) - la base de la conception. La représentation d'un objet tridimensionnel en cours de conception dans trois projections bidimensionnelles, qui montrent les dimensions et les noms des pièces, a joué un rôle décisif dans le développement de l'ingénierie. Sur le chemin des textes manuscrits, des dessins et des schémas à la typographie et aux modèles graphiques dans le design, de l'enregistrement sonore, de la photographie et de la radio au cinéma et à la télévision, des ordinateurs et des réseaux locaux au réseau mondial, aux laboratoires virtuels et à l'enseignement à distance, le rôle de la symbolique modèles qu'une personne crée avec des machines.

La productivité des résolveurs de problèmes est un problème clé de la productivité de l'activité intellectuelle, qui est constamment au centre de l'attention des inventeurs. Le besoin d'évaluations quantitatives des objets matériels a longtemps stimulé l'invention de systèmes de symboles sonores, gestuels, puis graphiques. Pendant un temps, ils se sont débrouillés avec la règle : chaque valeur a son propre symbole. Le comptage à l'aide de cailloux, de bâtons et d'autres objets (comptage objectif) a précédé l'invention du comptage symbolique (basé sur une représentation graphique des quantités). Au fur et à mesure que le nombre d'objets à utiliser augmentait, la tâche de représentation symbolique des quantités devenait plus urgente. La formation du concept de "nombres" et l'idée de sauvegarder des symboles lors de la modélisation des nombres ont conduit à l'invention des systèmes de nombres. L'idée des systèmes de nombres positionnels mérite une mention spéciale, dont l'un (binaire) au XXe siècle. était destiné à jouer un rôle clé dans l'invention des machines programmables numériques et le codage numérique des modèles de caractères. Changer la signification d'un symbole avec un changement de sa position dans la séquence de symboles est une idée très productive qui a fait progresser l'invention des dispositifs informatiques (de l'abaque à l'ordinateur).

Outils pour augmenter la productivité des résolveurs de problèmes. En 1622-1633, le scientifique anglais William Otred proposa une variante règle à calcul, qui est devenu le prototype des règles à calcul que les ingénieurs et les chercheurs du monde entier utilisent depuis plus de 300 ans (avant que les ordinateurs personnels ne soient disponibles). En 1642, B. Pascal, essayant d'aider son père dans les calculs lors de la perception des impôts, crée un dispositif d'addition à cinq chiffres ("Pascaline" ), construit sur la base de roues dentées. Au cours des années suivantes, il a créé des appareils à six et huit chiffres conçus pour additionner et soustraire des nombres décimaux. En 1672, le scientifique allemand G.W. Leibniz crée une calculatrice mécanique numérique pour les opérations arithmétiques sur les nombres décimaux à douze chiffres. C'était la première calculatrice à effectuer toutes les opérations arithmétiques. Le mécanisme, appelé "roue de Leibniz", jusque dans les années 1970. reproduit dans diverses calculatrices de poche. En 1821, la production industrielle de machines à additionner débute. En 1836–48 C. Babbage a terminé le projet d'un ordinateur décimal mécanique (appelé par lui un moteur analytique), qui peut être considéré comme un prototype mécanique des futurs ordinateurs. Le programme de calcul, les données et le résultat ont été enregistrés sur des cartes perforées. L'exécution automatique du programme était assurée par le dispositif de contrôle. La voiture n'a pas été construite. En 1934 - 38 K. Zuse créé un ordinateur binaire mécanique (longueur de mot– 22 chiffres binaires ; mémoire– 64 mots; opérations en virgule flottante). Initialement, le programme et les données étaient entrés manuellement. Environ un an plus tard (après le début de la conception), un dispositif de saisie d'un programme et de données à partir d'un film perforé a été fabriqué, et une unité de calcul mécanique (AU) a été remplacée par une AU construite sur des relais téléphoniques. En 1941, Zuse, avec la participation de l'ingénieur autrichien H. Schreier, a créé le premier ordinateur binaire fonctionnant entièrement à relais au monde avec contrôle de programme (Z3). En 1942, Zuse a également créé le premier ordinateur numérique de contrôle au monde (S2), qui a été utilisé pour contrôler les avions à projectiles. En raison du secret des travaux effectués par Zuse, leurs résultats ne sont devenus connus qu'après la fin de la 2e guerre mondiale. Le premier langage de programmation de haut niveau au monde Plankalkül (Allemand Plankalkül - plan de calcul) a été créé par Zuse en 1943-45, publié en 1948. Les premiers ordinateurs électroniques numériques, à commencer par l'ordinateur américain ENIAC [(ENIAC - Electronic Numerical Integrator and Computer - intégrateur numérique électronique et calculateur); début du développement - 1943, présenté au public en 1946], ont été créés comme un moyen d'automatiser les calculs mathématiques.

Créer la science de l'informatique avec des machines programmables. Tout R 20ième siècle la production d'ordinateurs numériques a commencé, qui aux États-Unis et en Grande-Bretagne étaient appelés ordinateurs (ordinateurs) et en URSS - ordinateurs électroniques (ordinateurs). Depuis les années 1950 au Royaume-Uni et à partir des années 1960 aux États-Unis, la science de l'informatique à l'aide de machines programmables a commencé à se développer, appelée Computer Science (informatique). En 1953 Université de Cambridge un programme a été formé dans la spécialité informatique; aux États-Unis programme similaire introduit en 1962 à l'Université Purdue.

En Allemagne, l'informatique s'appelait Informatik (informatique). En URSS, le domaine de la recherche et de l'ingénierie consacré à la construction et à l'application des machines programmables s'appelait "informatique". En décembre 1948, I. S. Bruk et B. I. Rameev ont reçu le premier certificat de droit d'auteur en URSS pour l'invention d'une machine numérique automatique. Dans les années 1950 la première génération d'ordinateurs domestiques a été créée (élément de base - lampes électroniques): 1950 - MESM (le premier ordinateur électronique soviétique, développé sous la direction de S. A. Lebedev ); 1952 - M-1, BESM (jusqu'en 1953 l'ordinateur le plus rapide d'Europe); 1953 - "Flèche" (le premier ordinateur produit en série en URSS); 1955 - Oural-1 de la famille Ural d'ordinateurs numériques à usage général (concepteur en chef B. I. Rameev).

Améliorer les méthodes et les moyens d'automatisation. Avec la disponibilité croissante des ordinateurs pour les utilisateurs de divers domaines d'activité, qui a commencé dans les années 1970, on observe une diminution de la part des problèmes mathématiques résolus à l'aide d'ordinateurs (créés à l'origine comme un moyen d'automatiser les calculs mathématiques), et une augmentation de la part de problèmes non mathématiques (communication, recherche, etc.). Quand dans la seconde moitié des années 1960. des terminaux informatiques avec écrans ont commencé à être produits, le développement de programmes d'édition d'écran pour saisir, enregistrer et corriger du texte avec l'afficher sur plein écran[l'un des premiers éditeurs d'écran était le O26, créé en 1967 pour les opérateurs de console des ordinateurs de la série CDC 6000 ; en 1970, vi a été développé, l'éditeur d'écran standard pour les systèmes d'exploitation Unix et Linux]. L'utilisation d'éditeurs d'écran a non seulement augmenté la productivité des programmeurs, mais a également créé les conditions préalables à des changements importants dans les outils de construction automatisée de modèles symboliques d'objets arbitraires. Par exemple, utiliser des éditeurs d'écran pour générer des textes à des fins diverses(articles et livres scientifiques, manuels, etc.) déjà dans les années 1970. a permis d'augmenter considérablement la productivité de la création de ressources d'informations textuelles. En juin 1975, le chercheur américain Alan Kay [le créateur du langage de programmation orienté objet Smalltalk (Smalltalk) et l'un des auteurs de l'idée d'un ordinateur personnel] dans l'article "Personal Computing" (« Informatique personnelle» ) a écrit : "Imaginez-vous en tant que propriétaire d'une machine à connaissances autonome dans mallette portative, qui a la taille et la forme d'un bloc-notes ordinaire. Comment l'utiliseriez-vous si ses capteurs étaient supérieurs à votre vue et à votre ouïe, et si sa mémoire vous permettait de stocker et de récupérer, si nécessaire, des milliers de pages de documents de référence, des poèmes, des lettres, des recettes, ainsi que des dessins, des animations, des oeuvres, graphismes, modèles dynamiques et quelque chose d'autre que vous aimeriez créer, mémoriser et changer ? . Cette déclaration reflétait le tournant qui s'était opéré à cette époque dans l'approche de la construction et de l'application des machines programmables : des outils d'automatisation, principalement des calculs mathématiques, aux outils de résolution de problèmes de divers domaines d'activité. En 1984 Kurzweil Music Systems (KMS), créé par l'inventeur américain Raymond Kurzweil, a produit le premier synthétiseur de musique numérique au monde, le Kurzweil 250. C'était le premier ordinateur dédié au monde qui convertissait les caractères gestuels tapés sur le clavier en sons musicaux.

Amélioration des méthodes et des moyens d'interaction de l'information. En 1962, les chercheurs américains J. Licklider et W. Clark ont publié un rapport sur l'interaction homme-machine en ligne. Le rapport contenait une justification de l'opportunité de construire un réseau mondial en tant que plate-forme d'infrastructure qui donne accès à ressources d'information hébergés sur des ordinateurs connectés à ce réseau. Justification théorique de la commutation de paquets lors de la transmission de messages dans réseaux informatiques a été donnée dans un article publié en 1961 par le scientifique américain L. Kleinrock.En 1971, R. Tomlinson (USA) a inventé le courrier électronique, en 1972 ce service a été mis en place. L'événement clé de l'histoire de la création d'Internet a été l'invention en 1973 par les ingénieurs américains V. Cerf et R. Kahn du protocole de contrôle de transmission - TCP. En 1976, ils ont démontré la transmission d'un paquet réseau sur le protocole TCP. En 1983, la famille de protocoles TCP/IP a été normalisée. En 1984, le système de noms de domaine (DNS) a été créé (voir. Domaine en informatique). En 1988, le protocole de chat [Internet Real Time Text Messaging Service (IRC - Internet Relay Chat)] a été développé. En 1989, le projet Web a été mis en œuvre (voir. Le World Wide Web) développé par T. Berner Lee. 6.6.2012 - un jour important dans l'histoire d'Internet : grands fournisseurs d'accès Internet, fabricants d'équipements pour réseaux informatiques et les sociétés Web ont commencé à utiliser le protocole IPv6 (avec le protocole IPv4), résolvant pratiquement le problème de la rareté des adresses IP (voir Internet). Le taux de développement élevé d'Internet est facilité par le fait que depuis sa création, les professionnels impliqués dans les tâches scientifiques et techniques de construction d'Internet échangent sans tarder des idées et des solutions en utilisant ses capacités. Internet est devenu une plate-forme infrastructurelle pour un environnement homme-machine permettant de résoudre des problèmes. Il sert d'infrastructure de communication E-mail, Web, moteurs de recherche, Téléphonie Internet(téléphonie IP) et autres services Internet utilisés dans l'informatisation de l'éducation, de la science, de l'économie, de l'administration publique et d'autres activités. Les services électroniques créés sur la base d'Internet ont permis le bon fonctionnement de diverses entités Internet commerciales et non commerciales : boutiques en ligne, réseaux sociaux[Facebook (Facebook), VKontakte, Twitter (Twitter), etc.], moteurs de recherche [Google (Google), Yandex (Yandex), etc.], ressources Web encyclopédiques [Wikipedia (Wikipedia), Webopedia, etc.], électroniques bibliothèques [World Digital Library (World Digital Library), Scientific Electronic Library eLibrary, etc.], portails d'information d'entreprises et gouvernementaux, etc.

Depuis les années 2000, le nombre de solutions Internet n'a cessé de croître - "maison intelligente" (Smart House), "système d'alimentation intelligent" (Smart Grid), etc. Les solutions M2M (M2M - Machine-to-Machine) basées sur les technologies de l'information de l'interaction machine-machine et conçues pour surveiller les capteurs de température, les compteurs d'électricité, les compteurs d'eau, etc. se développent avec succès ; suivi de l'emplacement des objets en mouvement sur la base des systèmes GLONASS et GPS (voir. Système de positionnement par satellite); contrôle d'accès aux objets protégés, etc.