Limitation de la bande passante avec QoS. Comment utiliser la QoS pour garantir la qualité de l'accès Internet Où se trouve le planificateur de paquets qos

Dans la première partie de cette série, j'ai couvert ce que fait la QoS et à quoi elle sert. Dans cette partie, je vais continuer la conversation en expliquant comment fonctionne la QoS. En lisant cet article, gardez à l'esprit que les informations présentées ici sont basées sur l'application QoS de Windows Server 2003, qui est différente de l'application QoS de Windows 2000 Server.

API de gestion du trafic

L'un des principaux problèmes liés à la hiérarchisation du trafic réseau est que vous ne pouvez pas hiérarchiser le trafic en fonction de l'ordinateur qui le génère. Il est courant qu'un seul ordinateur utilise plusieurs applications et crée un flux de trafic distinct pour chaque application (et système d'exploitation). Lorsque cela se produit, chaque flux de trafic doit être priorisé individuellement. Après tout, une application peut avoir besoin de bande passante supplémentaire, tandis que la meilleure livraison est idéale pour une autre application.

C'est ici qu'intervient l'API Traffic Control (Traffic Control Programming Interface). L'API de contrôle du trafic est une interface de programmation d'applications qui vous permet d'appliquer des paramètres de QoS à des packages individuels. L'API Traffic Control fonctionne en définissant des flux de trafic individuels et en appliquant différentes méthodes de contrôle QoS à ces flux.

La première chose que fait l'API Traffic Control est de créer ce que l'on appelle filterspec. Filterspec est essentiellement un filtre qui définit ce que cela signifie pour un package d'appartenir à un flux particulier. Certains des attributs utilisés par filterspec incluent l'adresse IP source et de destination du paquet et le numéro de port.

Une fois le filterspec défini, l'API vous permet de créer le flowspec. Flowspec définit les paramètres de QoS qui seront appliqués à la séquence de paquets. Certains des paramètres définis par le flowspec incluent le taux de transfert (taux de transfert acceptable) et le type de service.

Le troisième concept défini par l'API Traffic Control est le concept de flux. Un flux est une simple séquence de paquets qui sont soumis à la même flowspec. En termes simples, le filterspec définit quels packages seront inclus dans le flowspec. Flowspec détermine si les paquets seront traités avec des priorités plus élevées, et le flux est le transfert réel des paquets qui sont traités par la flowspec. Tous les paquets du flux sont traités de manière égale.

Il convient de mentionner que l'un des avantages de l'API de contrôle du trafic par rapport à l'API QoS générique utilisée dans Windows 2000 est la possibilité d'utiliser l'agrégation (agrégation). Si un nœud a plusieurs applications transmettant plusieurs flux de données vers une destination commune, ces paquets peuvent être combinés en un flux commun. Cela est vrai même si les applications utilisent des numéros de port différents, à condition que les adresses IP source et de destination soient les mêmes.

Classificateur de paquets générique

Dans la section précédente, j'ai discuté de la relation entre flowspec, filterspec et flow. Cependant, il est important de se rappeler que l'API de contrôle du trafic est simplement une interface de programmation d'application. En tant que tel, son travail consiste à définir et à hiérarchiser les flux de trafic, pas à créer ces flux.

Le classificateur de paquets générique est responsable de la création de flux. Comme vous vous en souvenez dans la section précédente, l'un des attributs définis dans la flowspec était le type de service. Le type de service détermine essentiellement la priorité du thread. Le classificateur de paquets générique est chargé de déterminer le type de service qui a été attribué à la flowspec, après quoi il met en file d'attente les paquets associés en fonction du type de service. Chaque thread est placé dans une file d'attente distincte.

Planificateur de paquets QoS

Le troisième composant QoS que vous devez connaître est le planificateur de paquets QoS. En termes simples, la tâche principale d'un planificateur de paquets QoS est la mise en forme du trafic. Pour ce faire, le planificateur de paquets reçoit des paquets de différentes files d'attente, puis marque ces paquets avec des priorités et un débit.

Comme je l'ai expliqué dans la première partie de cette série d'articles, pour que la qualité de service fonctionne correctement, les divers composants situés entre la source des paquets et leur destination doivent prendre en charge (c'est-à-dire être conscients de) la qualité de service. Bien que ces appareils doivent savoir comment gérer la qualité de service, ils doivent également savoir comment gérer le trafic normal sans priorités. Pour rendre cela possible, QoS utilise une technologie appelée tagging.

En fait, il existe ici deux types de marquages. Le planificateur de paquets QoS utilise le balisage Diffserv, reconnu par les appareils de couche 3, et le balisage 802.1p, reconnu par les appareils de couche 2.

Configuration du planificateur de paquets QoS

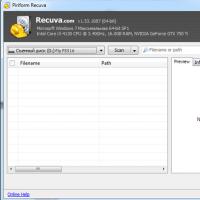

Avant de vous montrer comment fonctionne le balisage, il convient de noter que vous devrez configurer le planificateur de paquets QoS pour que cela fonctionne. Dans Windows Server 2003, le planificateur de paquets QoS est un composant réseau facultatif, tout comme le client pour les réseaux Microsoft ou le protocole TCP/IP. Pour activer le planificateur de paquets QoS, ouvrez la page de propriétés de la connexion réseau de votre serveur et cochez la case en regard du planificateur de paquets QoS, comme illustré à la Figure A. Si le planificateur de paquets QoS n'est pas répertorié, cliquez sur le bouton Installer et suivez les instructions.

Figure A : Le planificateur de paquets QoS doit être activé avant de pouvoir utiliser QoS

Une autre chose que vous devez savoir sur le planificateur de paquets QoS est que votre adaptateur réseau doit prendre en charge le balisage 802.1p pour qu'il fonctionne correctement. Pour tester votre adaptateur, cliquez sur le bouton Configurer, Figure A, et Windows affichera les propriétés de votre adaptateur réseau. Si vous regardez l'onglet Avancé sur la page de propriétés, vous verrez les différentes propriétés prises en charge par votre carte réseau.

Si vous regardez la figure B, vous pouvez voir que le balisage VLAN 802.1Q / 1P est l'une des propriétés répertoriées. Vous pouvez également voir que cette propriété est désactivée par défaut. Pour activer le balisage 802.1p, activez simplement cette propriété et cliquez sur OK.

Figure B : vous devez activer le balisage VLAN 802.1Q/1P

Vous avez peut-être remarqué dans la figure B que la fonctionnalité que vous avez activée est le balisage VLAN, et non le balisage des paquets. En effet, les marqueurs de priorité sont inclus dans les balises VLAN. La norme 802.1Q définit les VLAN et les balises VLAN. Cette norme réserve en fait trois bits dans le paquet VLAN, qui sont utilisés pour écrire le code de priorité. Malheureusement, la norme 802.1Q ne précise jamais quels devraient être ces codes de priorité.

La norme 802.1P a été créée pour compléter 802.1Q. 802.1P définit le marquage de priorité qui peut être inclus dans une balise VLAN. Je vais vous expliquer comment ces deux normes fonctionnent dans la troisième partie.

Conclusion

Dans cet article, nous avons abordé certains des concepts de base de l'architecture QoS de Windows Server 2003. Dans la partie 3, j'expliquerai plus en détail comment le planificateur de paquets QoS marque les paquets. Je discuterai également du fonctionnement de la QoS dans un environnement réseau à faible bande passante.

Dans cet article, nous verrons comment configurer la bande passante réservée dans Windows 10. Par défaut, Windows réserve 20 % de la bande passante Internet totale.

Oui, oui, le système d'exploitation Windows 10 réserve un certain pourcentage de la bande passante de votre connexion Internet pour la qualité de service (QoS).

Selon Microsoft :

La qualité de service peut inclure des opérations système critiques telles que la mise à jour du système Windows, la gestion de l'état des licences, etc. Le concept de bande passante réservée s'applique à tous les programmes exécutés sur le système. Généralement, le planificateur de paquets limitera le système à 80 % de la bande passante de connectivité. Cela signifie que Windows réserve 20% de votre bande passante Internet exclusivement pour la QoS.

Si vous souhaitez obtenir ce pourcentage de bande passante réservée, cet article est pour vous. Vous trouverez ci-dessous deux manières de configurer la bande passante réservée dans le système d'exploitation Windows 10.

REMARQUE: Si vous désactivez toute la bande passante réservée pour votre système, c'est-à-dire que vous la définissez sur 0%, cela affectera les actions du système d'exploitation, en particulier les mises à jour automatiques.

Déni de responsabilité : d'autres étapes incluront la modification du registre. Des erreurs lors de la modification du registre peuvent nuire à votre système. Par conséquent, soyez prudent lorsque vous modifiez des entrées de registre et créez d'abord un point de restauration système.

Étape 1: Ouvrir l'éditeur de registre(si vous n'êtes pas familier avec l'éditeur de registre, cliquez sur).

Étape 2: Dans le volet gauche de la fenêtre de l'Éditeur du Registre, accédez à la section suivante :

HKEY_LOCAL_MACHINE\SOFTWARE\Politiques\Microsoft\Windows\Psched

Noter: Si la section et le paramètre " NonBestEffortLimit"N'existez pas, créez-les simplement.

Étape 3: Maintenant dans le volet droit de la clé de registre "Psched" trouvez le paramètre DWORD (32 bits) nommé NonBestEffortLimit... Double-cliquez dessus pour modifier ses valeurs :

Par défaut, le paramètre est défini sur 50 en hexadécimal ou 80 en notation décimale.

Étape 4: Sélectionnez le système décimal et définissez la valeur égale au pourcentage de la bande passante réservée requise.

Par example si vous définissez la valeur sur 0 , la bande passante réservée à votre système d'exploitation Windows sera complètement désactivée, c'est-à-dire égale à 0%. Cliquez sur le bouton "D'ACCORD" et fermez l'Éditeur du Registre.

Étape 5 : Redémarrez votre PC pour que les modifications prennent effet.

Si vous souhaitez configurer ou limiter la bande passante réservée sur plusieurs ordinateurs de votre organisation/lieu de travail, vous pouvez déployer le paramètre approprié dans le GPO.

Étape 1: Ouvrez l'éditeur de stratégie de groupe local

Étape 2: Allez dans la rubrique : Configuration ordinateur → Modèles d'administration → Réseau → Planificateur de packages Qos

Étape 3: Dans la fenêtre de droite, double-cliquez sur la stratégie.

Par défaut, cette politique n'est pas définie et le système réserve 20% bande passante de la connexion Internet. Vous devez l'activer, définir le paramètre "Limiter la bande passante réservée" sens "Inclus".

Il n'y a pas une seule personne qui n'a lu au moins une fois une FAQ sur Windows XP. Et si c'est le cas, alors tout le monde sait qu'il existe une qualité de service si nuisible - pour faire court, la qualité de service. Lors de la configuration du système, il est fortement recommandé de le désactiver, car il limite la bande passante du réseau à 20 % par défaut, et comme si ce problème existait également sous Windows 2000.

Ce sont les lignes :

Q : Comment désactiver complètement le service QoS (Quality of Service) ? Comment puis-je le configurer? Est-il vrai que cela limite la vitesse du réseau ?

R : En effet, par défaut Quality of Service réserve 20% de la bande passante du canal pour ses besoins (n'importe quel - même un modem pour 14400, même un gigabit Ethernet). De plus, même si vous supprimez le service QoS Packet Scheduler de la connexion Propriétés, ce canal n'est pas libéré. Vous pouvez libérer le canal ou simplement configurer QoS ici. Lancez l'applet de stratégie de groupe (gpedit.msc). Dans Stratégie de groupe, recherchez Stratégie d'ordinateur local et cliquez sur Modèles d'administration. Sélectionnez l'élément Réseau - QoS Packet Sheduler. Activez Limiter la bande passante réservable. Maintenant, nous réduisons la limite de bande passante de 20% à 0% ou la désactivons simplement. Si vous le souhaitez, vous pouvez également configurer d'autres paramètres QoS ici. Pour activer les modifications apportées, il ne reste plus qu'à redémarrer.

20 %, c'est bien sûr beaucoup. Vraiment Microsoft est Mazdai. Des déclarations de ce genre errent de FAQ en FAQ, de forum en forum, de média en média, sont utilisées dans toutes sortes de "tweaks" - programmes pour "réglage" Windows XP (au fait, ouvrez "Group Policies" et "Local Politiques de sécurité", et aucun "tweak" ne peut les égaler dans la richesse des options de personnalisation). Il faut veiller à exposer des allégations infondées de ce genre, ce que nous allons maintenant faire par une approche systématique. C'est-à-dire que nous étudierons en profondeur la question problématique, en nous appuyant sur des sources primaires officielles.

Qu'est-ce qu'un réseau de services de qualité ?

Adoptons la définition simplifiée suivante d'un système en réseau. Les applications s'exécutent et s'exécutent sur des hôtes et communiquent entre elles. Les applications envoient des données au système d'exploitation pour transmission sur le réseau. Une fois que les données sont transférées vers le système d'exploitation, elles deviennent du trafic réseau.

La qualité de service du réseau repose sur la capacité du réseau à traiter ce trafic pour garantir que les demandes de certaines applications sont satisfaites. Cela nécessite un mécanisme fondamental de traitement du trafic réseau capable d'identifier le trafic éligible et de contrôler un traitement spécifique.

La fonctionnalité QoS est conçue pour satisfaire deux acteurs du réseau : les applications réseau et les administrateurs réseau. Ils ont souvent des désaccords. L'administrateur réseau limite les ressources utilisées par une application spécifique, tandis que l'application essaie de récupérer autant de ressources réseau que possible. Leurs intérêts peuvent être conciliés, compte tenu du fait que l'administrateur du réseau joue un rôle de premier plan vis-à-vis de toutes les applications et utilisateurs.

Paramètres QoS de base

Différentes applications ont des exigences différentes pour gérer leur trafic réseau. Les applications tolèrent plus ou moins la latence et la perte de trafic. Ces exigences ont trouvé une application dans les paramètres suivants liés à la qualité de service :

- Bande passante - Le débit auquel le trafic généré par l'application doit être envoyé sur le réseau.

- Latence (latence) - le délai que l'application peut tolérer dans la livraison du paquet de données ;

- Jitter - modifiez le temps de retard ;

- Perte - Le pourcentage de données perdues.

Si des ressources réseau infinies étaient disponibles, tout le trafic d'application pourrait être transmis au débit requis, avec une latence nulle, une variation de latence nulle et une perte nulle. Cependant, les ressources du réseau ne sont pas illimitées.

Le mécanisme QoS contrôle l'allocation des ressources réseau pour le trafic applicatif afin de répondre à ses exigences de transmission.

Ressources QoS fondamentales et mécanismes de gestion du trafic

Les réseaux qui connectent les hôtes utilisent une variété de périphériques réseau, notamment des adaptateurs réseau hôte, des routeurs, des commutateurs et des concentrateurs. Chacun d'eux dispose d'interfaces réseau. Chaque interface réseau peut recevoir et transmettre du trafic à un débit fini. Si le débit auquel le trafic est dirigé vers une interface est supérieur au débit auquel l'interface transfère le trafic, un encombrement se produit.

Les périphériques réseau peuvent gérer la condition de congestion en mettant le trafic en file d'attente dans la mémoire du périphérique (dans une mémoire tampon) jusqu'à ce que la congestion soit terminée. Dans d'autres cas, l'équipement réseau peut réduire le trafic pour réduire la congestion. De ce fait, les applications sont confrontées à un changement de latence (car le trafic est stocké dans des files d'attente sur les interfaces) ou à une perte de trafic.

La capacité des interfaces réseau à transférer le trafic et la disponibilité de la mémoire pour stocker le trafic sur les périphériques réseau (jusqu'à ce que le trafic puisse être envoyé plus loin) constituent les ressources fondamentales requises pour fournir la qualité de service pour les flux de trafic d'application.

Allocation de ressources QoS aux périphériques réseau

Les appareils qui prennent en charge la qualité de service utilisent intelligemment les ressources réseau pour acheminer le trafic. C'est-à-dire que le trafic des applications plus tolérantes aux latences est mis en file d'attente (stocké dans un tampon en mémoire) et que le trafic des applications critiques pour la latence est transféré.

Pour accomplir cette tâche, un périphérique réseau doit identifier le trafic en classant les paquets et doit disposer de files d'attente et de mécanismes pour les servir.

Moteur de traitement du trafic

Le mécanisme de traitement du trafic comprend :

- 802.1p ;

- Comportements différenciés par saut (diffserv PHB) ;

- Services intégrés (intserv);

- guichet automatique, etc.

La plupart des réseaux locaux sont basés sur la technologie IEEE 802, y compris Ethernet, Token Ring, etc. 802.1p est un mécanisme de traitement du trafic pour prendre en charge la QoS dans de tels réseaux.

802.1p définit un champ (couche 2 dans le modèle de réseau OSI) dans un en-tête de paquet 802 qui peut transporter l'une des huit valeurs de priorité. En règle générale, les hôtes ou les routeurs, lors de l'envoi de trafic vers le réseau local, marquent chaque paquet envoyé en lui attribuant une certaine valeur de priorité. Les périphériques réseau tels que les commutateurs, les ponts et les concentrateurs sont censés gérer les paquets de manière appropriée à l'aide de mécanismes de mise en file d'attente. 802.1p est limité à un réseau local (LAN). Dès que le paquet traverse le LAN (via OSI Layer 3), la priorité 802.1p est supprimée.

Diffserv est un mécanisme de couche 3. Il définit un champ dans la couche 3 de l'en-tête des paquets IP appelé diffserv codepoint (DSCP).

Intserv c'est toute une gamme de services qui définissent un service garanti et un service qui gère les téléchargements. Le service garanti promet de transporter une certaine quantité de trafic avec une latence mesurable et limitée. Le service qui gère la charge s'engage à acheminer une certaine quantité de trafic avec un « léger encombrement du réseau ». Ce sont des services mesurables dans le sens où ils sont définis pour fournir une qualité de service mesurable à une quantité spécifique de trafic.

Étant donné que la technologie ATM fragmente les paquets en cellules relativement petites, elle peut offrir une latence très faible. Si vous devez envoyer un paquet de manière urgente, l'interface ATM peut toujours être libre pour la transmission pendant le temps nécessaire pour transmettre une cellule.

La qualité de service comporte de nombreux mécanismes plus complexes qui font fonctionner cette technologie. Notons juste un point important : pour que la QoS fonctionne, il est nécessaire de supporter cette technologie et une configuration appropriée tout au long de la transmission du point de départ au point d'arrivée.

L'un des domaines les plus populaires dans le réseautage d'aujourd'hui est le mélange de la voix et de la vidéo sur les réseaux de données traditionnels. L'un des problèmes avec ce type d'informations est que pour qu'elles fonctionnent correctement, les paquets de données vidéo et audio doivent être transmis au destinataire de manière rapide et fiable, sans interruption ni délais trop longs. Cependant, dans le même temps, ce type de trafic ne doit pas entraver la transmission de paquets de données plus classiques.

Une solution possible à ce problème est la QoS. QoS, ou qualité de service, est une technologie permettant de hiérarchiser les paquets de données. QoS vous permet de transmettre des paquets sensibles au temps avec une priorité plus élevée que les autres paquets.

QoS est une norme de l'industrie, pas une norme Microsoft. Cependant, Microsoft a introduit cette norme de QoS pour la première fois dans Windows 2000. La version de QoS de Microsoft a beaucoup évolué depuis, mais répond toujours aux normes de l'industrie.

Dans Windows XP Professionnel, QoS agit principalement comme un mécanisme de réservation de bande passante. Lorsque QoS est activé, l'application est autorisée à réserver jusqu'à 20 % de la bande passante totale du réseau fournie par la carte réseau de chaque machine. Cependant, la quantité de bande passante réseau que l'application réserve est configurable. Je vais vous montrer comment modifier la quantité de bande passante réservée dans la partie 3.

Pour voir comment la bande passante disponible est utilisée, supposons que vous ayez une application de visioconférence qui nécessite une bande passante prioritaire pour fonctionner correctement. En supposant que la QoS soit activée pour cette application, on peut dire qu'elle réserve 20% de la bande passante totale de la machine, laissant 80% de la bande passante pour le reste du trafic réseau.

Toutes les applications, à l'exception des applications de vidéoconférence, utilisent une technologie appelée livraison au mieux. Cela signifie que les paquets sont envoyés avec la même priorité premier livré-premier servi. D'un autre côté, le trafic des applications de visioconférence sera toujours prioritaire par rapport aux autres trafics, mais l'application ne sera jamais autorisée à consommer plus de 20 % de toute la bande passante.

Cependant, ce n'est pas parce que Windows XP réserve une partie de la bande passante pour le trafic prioritaire que les applications avec une priorité normale ne pourront pas utiliser la bande passante disponible. Bien que les applications de vidéoconférence tirent parti de la bande passante réservée de priorité plus élevée, les chances que de telles applications soient constamment utilisées sont très faibles. Dans ce cas, Windows permet à d'autres applications d'utiliser la bande passante disponible et non disponible pour la meilleure livraison possible, tant que les applications pour lesquelles une partie de la bande passante réseau est réservée ne sont pas utilisées.

Dès que l'application de visioconférence démarre, Windows commence à appliquer la réservation. Même ainsi, la réservation n'est pas absolue. Supposons que Windows ait réservé 20 % de la bande passante du réseau pour une application de vidéoconférence, mais que cette application n'ait pas besoin des 20 %. Dans ces cas, Windows permet à d'autres applications d'utiliser la bande passante restante, mais surveillera en permanence les besoins de l'application la plus prioritaire. Dans le cas où l'application a besoin de plus de bande passante, la bande passante lui sera allouée jusqu'à une valeur maximale de 20%.

Comme je l'ai dit, la QoS est une norme de l'industrie, pas une technologie Microsoft. En tant que tel, QoS est utilisé par Windows, mais Windows ne peut pas faire le travail seul. Pour que la QoS fonctionne, chaque équipement entre l'expéditeur et le destinataire doit prendre en charge la QoS. Cela signifie que les adaptateurs réseau, les commutateurs, les routeurs et tous les autres appareils utilisés doivent connaître la qualité de service, ainsi que les systèmes d'exploitation du destinataire et de l'expéditeur.

Si vous êtes curieux, vous n'avez pas besoin d'installer une infrastructure réseau exotique folle pour utiliser QoS. Le mode de transfert asynchrone (ATM) est une excellente technologie de mise en réseau pour utiliser la QoS car il s'agit d'une technologie orientée connexion, mais vous pouvez utiliser la QoS avec d'autres technologies telles que Frame Relay, Ethernet et même Wi-FI (802.11 x).

La raison pour laquelle ATM est un choix idéal pour la QoS est qu'il est capable de mettre en œuvre la réservation de bande passante et l'allocation de ressources au niveau matériel. Ce type de distribution va au-delà des capacités d'Ethernet et des technologies de mise en réseau similaires. Cela ne signifie pas que QoS ne peut pas être utilisé. Cela signifie simplement que la qualité de service doit être appliquée différemment que dans un environnement ATM.

Dans un environnement ATM, les ressources sont allouées immédiatement, au niveau du périphérique physique. Étant donné qu'Ethernet et d'autres technologies similaires ne peuvent pas allouer de ressources de cette manière, les technologies de ce type sont basées sur la hiérarchisation plutôt que sur une véritable allocation de ressources. Cela signifie que les réservations de bande passante se produisent au niveau de la couche supérieure du modèle OSI. Une fois la bande passante réservée, les paquets les plus prioritaires sont envoyés en premier.

Un point à considérer si vous allez appliquer la QoS sur Ethernet, Wi-Fi ou d'autres technologies similaires est que ces technologies ne sont pas connectées. Cela signifie qu'il n'y a aucun moyen pour l'expéditeur de vérifier l'état du récepteur ou l'état du réseau entre l'expéditeur et le destinataire. Ceci, à son tour, signifie que l'expéditeur peut garantir que les paquets avec des priorités plus élevées seront envoyés en premier, mais ne peut garantir que ces paquets seront livrés dans un certain laps de temps. D'autre part, QoS est capable de fournir ce type d'assurance sur les réseaux ATM, car ATM est une technologie orientée connexion.

Windows 2000 contre Serveur Windows 2003

Plus tôt, j'ai expliqué comment Microsoft a introduit pour la première fois la QoS dans Windows 2000, et que cette application de QoS a considérablement évolué depuis lors. Par conséquent, je veux parler un peu des différences entre QoS dans Windows 2000 et dans Windows XP et Windows Server 2003 (dans lequel cette norme est utilisée à peu près de la même manière).

Dans Windows 2000, la QoS était basée sur l'architecture Intserv, qui n'est pas prise en charge dans Windows XP ou Windows Server 2003. La raison pour laquelle Microsoft a choisi de ne pas utiliser une telle architecture était que l'API sous-jacente était difficile à utiliser et que l'architecture posait des problèmes. échelle.

Certaines organisations utilisent encore Windows 2000, j'ai donc décidé de vous donner quelques informations sur le fonctionnement de l'architecture QoS de Windows 2000. Windows 2000 utilise un protocole appelé RSVP pour réserver des ressources de bande passante. Lorsque la bande passante est demandée, Windows doit déterminer quand les paquets peuvent être envoyés. Pour ce faire, Windows 2000 utilise un protocole de signalisation appelé SBM (Sunbelt Bandwidth manager) pour indiquer à l'expéditeur qu'il est prêt à recevoir des paquets. Le service de contrôle d'admission (ACS) vérifie que la bande passante effective est disponible, puis accorde ou refuse la demande de bande passante.

API de gestion du trafic

L'un des principaux problèmes liés à la hiérarchisation du trafic réseau est que vous ne pouvez pas hiérarchiser le trafic en fonction de l'ordinateur qui le génère. Il est courant qu'un seul ordinateur utilise plusieurs applications et crée un flux de trafic distinct pour chaque application (et système d'exploitation). Lorsque cela se produit, chaque flux de trafic doit être priorisé individuellement. Après tout, une application peut avoir besoin de bande passante supplémentaire, tandis que la meilleure livraison est idéale pour une autre application.

C'est ici qu'intervient l'API Traffic Control (Traffic Control Programming Interface). L'API de contrôle du trafic est une interface de programmation d'applications qui vous permet d'appliquer des paramètres de QoS à des packages individuels. L'API Traffic Control fonctionne en définissant des flux de trafic individuels et en appliquant différentes méthodes de contrôle QoS à ces flux.

La première chose que fait l'API Traffic Control est de créer ce que l'on appelle filterspec. Filterspec est essentiellement un filtre qui définit ce que cela signifie pour un package d'appartenir à un flux particulier. Certains des attributs utilisés par filterspec incluent l'adresse IP source et de destination du paquet et le numéro de port.

Une fois le filterspec défini, l'API vous permet de créer le flowspec. Flowspec définit les paramètres de QoS qui seront appliqués à la séquence de paquets. Certains des paramètres définis par le flowspec incluent le taux de transfert (taux de transfert acceptable) et le type de service.

Le troisième concept défini par l'API Traffic Control est le concept de flux. Un flux est une simple séquence de paquets qui sont soumis à la même flowspec. En termes simples, le filterspec définit quels packages seront inclus dans le flowspec. Flowspec détermine si les paquets seront traités avec des priorités plus élevées, et le flux est le transfert réel des paquets qui sont traités par la flowspec. Tous les paquets du flux sont traités de manière égale.

Il convient de mentionner que l'un des avantages de l'API de contrôle du trafic par rapport à l'API QoS générique utilisée dans Windows 2000 est la possibilité d'utiliser l'agrégation (agrégation). Si un nœud a plusieurs applications transmettant plusieurs flux de données vers une destination commune, ces paquets peuvent être combinés en un flux commun. Cela est vrai même si les applications utilisent des numéros de port différents, à condition que les adresses IP source et de destination soient les mêmes.

Classificateur de paquets générique

Dans la section précédente, j'ai discuté de la relation entre flowspec, filterspec et flow. Cependant, il est important de se rappeler que l'API de contrôle du trafic est simplement une interface de programmation d'application. En tant que tel, son travail consiste à définir et à hiérarchiser les flux de trafic, pas à créer ces flux.

Le classificateur de paquets générique est responsable de la création de flux. Comme vous vous en souvenez dans la section précédente, l'un des attributs définis dans la flowspec était le type de service. Le type de service détermine essentiellement la priorité du thread. Le classificateur de paquets générique est chargé de déterminer le type de service qui a été attribué à la flowspec, après quoi il met en file d'attente les paquets associés en fonction du type de service. Chaque thread est placé dans une file d'attente distincte.

Planificateur de paquets QoS

Le troisième composant QoS que vous devez connaître est le planificateur de paquets QoS. En termes simples, la tâche principale d'un planificateur de paquets QoS est la mise en forme du trafic. Pour ce faire, le planificateur de paquets reçoit des paquets de différentes files d'attente, puis marque ces paquets avec des priorités et un débit.

Comme je l'ai expliqué dans la première partie de cette série d'articles, pour que la qualité de service fonctionne correctement, les divers composants situés entre la source des paquets et leur destination doivent prendre en charge (c'est-à-dire être conscients de) la qualité de service. Bien que ces appareils doivent savoir comment gérer la qualité de service, ils doivent également savoir comment gérer le trafic normal sans priorités. Pour rendre cela possible, QoS utilise une technologie appelée tagging.

En fait, il existe ici deux types de marquages. Le planificateur de paquets QoS utilise le balisage Diffserv, reconnu par les appareils de couche 3, et le balisage 802.1p, reconnu par les appareils de couche 2.

Configuration du planificateur de paquets QoS

Avant de vous montrer comment fonctionne le balisage, il convient de noter que vous devrez configurer le planificateur de paquets QoS pour que cela fonctionne. Dans Windows Server 2003, le planificateur de paquets QoS est un composant réseau facultatif, tout comme le client pour les réseaux Microsoft ou le protocole TCP/IP. Pour activer le planificateur de paquets QoS, ouvrez la page de propriétés de la connexion réseau de votre serveur et cochez la case en regard du planificateur de paquets QoS, comme illustré à la Figure A. Si le planificateur de paquets QoS n'est pas répertorié, cliquez sur le bouton Installer et suivez les instructions.

Figure A : Le planificateur de paquets QoS doit être activé avant de pouvoir utiliser QoS

Une autre chose que vous devez savoir sur le planificateur de paquets QoS est que votre adaptateur réseau doit prendre en charge le balisage 802.1p pour qu'il fonctionne correctement. Pour tester votre adaptateur, cliquez sur le bouton Configurer, Figure A, et Windows affichera les propriétés de votre adaptateur réseau. Si vous regardez l'onglet Avancé sur la page de propriétés, vous verrez les différentes propriétés prises en charge par votre carte réseau.

Si vous regardez la figure B, vous pouvez voir que le balisage VLAN 802.1Q / 1P est l'une des propriétés répertoriées. Vous pouvez également voir que cette propriété est désactivée par défaut. Pour activer le balisage 802.1p, activez simplement cette propriété et cliquez sur OK.

Figure B : vous devez activer le balisage VLAN 802.1Q/1P

Vous avez peut-être remarqué dans la figure B que la fonctionnalité que vous avez activée est le balisage VLAN, et non le balisage des paquets. En effet, les marqueurs de priorité sont inclus dans les balises VLAN. La norme 802.1Q définit les VLAN et les balises VLAN. Cette norme réserve en fait trois bits dans le paquet VLAN, qui sont utilisés pour écrire le code de priorité. Malheureusement, la norme 802.1Q ne précise jamais quels devraient être ces codes de priorité.

La norme 802.1P a été créée pour compléter 802.1Q. 802.1P définit le marquage de priorité qui peut être inclus dans une balise VLAN.

Signal 802.1P

Comme je l'ai dit dans la partie précédente, la signalisation 802.1p est effectuée au niveau de la deuxième couche du modèle OSI. Cette couche est utilisée par des périphériques physiques tels que des commutateurs. Les périphériques de couche 2 qui prennent en charge 802.1p peuvent afficher les marquages de priorité attribués aux paquets, puis regrouper ces paquets dans des classes de trafic distinctes.

Sur les réseaux Ethernet, le marquage prioritaire est inclus dans les balises VLAN. Les VLAN et les balises VLAN sont définis par la norme 802.1Q, qui définit un champ prioritaire à trois bits, mais ne définit pas vraiment comment ce champ prioritaire doit être utilisé. C'est là qu'intervient la norme 802.1P.

802.1P définit diverses classes de priorité qui peuvent être utilisées en conjonction avec la norme 802.1Q. En fin de compte, le 802.1Q laisse à l'administrateur le choix du marquage de priorité, donc techniquement, vous n'avez pas à suivre les directives du 802.1P, mais le 802.1P semble être celui que tout le monde choisit.

Bien que l'idée d'utiliser les normes 802.1P pour fournir le marquage de couche 2 ressemble probablement à de la théorie pure, elle peut en réalité être définie à l'aide des paramètres de stratégie de groupe. La norme 802.1P fournit huit classes de priorité différentes (allant de 0 à 7). Les paquets de priorité plus élevée sont traités par QoS avec une priorité de livraison plus élevée.

Par défaut, Microsoft attribue les marquages prioritaires suivants :

Mais comme je l'ai mentionné précédemment, vous pouvez modifier ces priorités en modifiant divers paramètres de stratégie de groupe. Pour ce faire, ouvrez l'éditeur de stratégie de groupe et accédez dans l'arborescence de la console à Configuration ordinateur \ Modèles d'administration \ Réseaux \ Planificateur de packages QoS \ Valeur de priorité de deuxième niveau. Comme vous pouvez le voir dans la figure A, il existe des paramètres de stratégie de groupe correspondant à chacune des étiquettes de priorité que j'ai répertoriées ci-dessus. Vous pouvez attribuer vos propres niveaux de marquage de priorité à l'un de ces types de services. Gardez toutefois à l'esprit que ces paramètres de stratégie de groupe ne s'appliquent qu'aux hôtes exécutant Windows XP, 2003 ou Vista.

Figure A : vous pouvez utiliser l'éditeur de stratégie de groupe pour personnaliser le marquage de priorité de deuxième niveau.

Services différenciés

Comme je l'ai expliqué dans l'article précédent, QoS effectue un marquage prioritaire aux deuxième et troisième couches du modèle OSI. Cela garantit que les priorités sont prises en compte tout au long du processus de livraison du colis. Par exemple, les commutateurs fonctionnent au niveau de la deuxième couche du modèle OSI, mais les routeurs fonctionnent généralement au niveau de la troisième couche. Ainsi, si les paquets n'utilisaient que le marquage de priorité 802.1p, le commutateur donnerait la priorité à ces paquets, mais ces priorités seraient ignorées par les routeurs du réseau. Pour contrer cela, QoS utilise le protocole Differentiated Services (Diffserv) pour prioriser le trafic sur la troisième couche du modèle OSI. Le marquage Diffserv est inclus dans les en-têtes IP des paquets utilisant TCP/IP.

L'architecture utilisée par Diffserv a été définie à l'origine par la RFC 2475. Cependant, de nombreuses spécifications d'architecture ont été réécrites dans la RFC 2474. La RFC 2474 définit l'architecture Diffserv pour IPv4 et IPv6.

Un point intéressant à propos d'IPv4 dans la RFC 2474 est que même si Diffserv a été complètement redéfini, il est toujours rétrocompatible avec la spécification RFC 2475 d'origine. Cela signifie que les routeurs plus anciens qui ne prennent pas en charge les nouvelles spécifications peuvent reconnaître les priorités attribuées.

L'application Diffserv actuelle utilise les octets de type de paquet Type of Service (TOS) pour stocker la valeur Diffserv (appelée valeur DSCP). Dans cet octet, les six premiers bits contiennent la valeur DSCP et les deux derniers bits sont inutilisés. La raison pour laquelle ces marquages sont rétrocompatibles avec la spécification RFC 2475 est que la RFC 2475 exigeait que les trois premiers bits du même octet soient utilisés dans les informations de séquence IP. Bien que les valeurs DSCP aient une longueur de six bits, les trois premiers bits reflètent toujours la séquence IP.

Comme pour le balisage 802.1p que j'ai démontré précédemment, vous pouvez configurer les priorités Diffserv via divers paramètres de stratégie de groupe. Avant de vous montrer comment, je vais vous présenter les priorités Diffserv standard utilisées dans Windows :

Vous avez peut-être remarqué que les marquages de priorité Diffserv utilisent une plage complètement différente de 802.1P. Au lieu de prendre en charge une plage de 0 à 7, Diffserv prend en charge une plage de marquage de priorité de 0 à 63, les plus grands nombres ayant des priorités plus élevées.

Comme je l'ai dit plus tôt, Windows vous permet de définir le marquage de priorité Diffserv à l'aide des paramètres de stratégie de groupe. Gardez à l'esprit, cependant, que certains routeurs plus avancés attribueront leurs propres valeurs Diffserv aux paquets, indépendamment de ce que Windows attribue.

Dans cet esprit, vous pouvez configurer le marquage de priorité Diffserv en ouvrant l'éditeur de stratégie de groupe et en accédant à Configuration ordinateur \ Modèles d'administration \ Réseau \ Planificateur de packages QoS dans l'arborescence de la console.

Si vous regardez la figure B, vous remarquerez qu'il y a deux onglets liés au DSCP sous l'onglet QoS Packet Scheduler. L'un de ces onglets vous permet d'attribuer un marquage de priorité DSCP pour les paquets qui correspondent à la flowspec, et l'autre vous permet de définir un marquage de priorité DSCP pour les paquets non conformes. Les paramètres réels eux-mêmes sont similaires pour les deux onglets, comme le montre la figure C.

Figure B : Windows gère les marquages de priorité DSCP séparément pour les paquets qui correspondent à la flowspec et ceux qui ne le font pas.

Figure C : Vous pouvez attribuer manuellement un marquage prioritaire DSCP pour différents types de services.

Paramètres de stratégie de groupe divers

Si vous regardez la figure B, vous remarquerez qu'il existe trois paramètres de stratégie de groupe que je n'ai pas mentionnés. Je voulais mentionner brièvement ce que sont ces paramètres et ce qu'ils font, pour ceux d'entre vous qui pourraient être intéressés.

Le paramètre Limit Outstanding Packets est essentiellement une valeur de seuil de service. Si le nombre de paquets dépassés atteint une certaine valeur, alors QoS refusera toute allocation de bande passante supplémentaire pour la carte réseau jusqu'à ce que la valeur tombe en dessous du seuil maximum autorisé.

Le paramètre Limit Reservable Bandwidth contrôle le pourcentage de bande passante totale que les applications QoS peuvent réserver. Par défaut, les applications compatibles QoS peuvent réserver jusqu'à 80 % de la bande passante du réseau. Bien entendu, toute partie de la bande passante réservée qui n'est pas actuellement utilisée par les applications QoS peut être utilisée par d'autres applications.

Le paramètre Set Timer Resolution contrôle les unités de temps minimum (en microsecondes) que le planificateur de paquets QoS utilisera pour planifier les paquets. Essentiellement, ce paramètre contrôle le débit maximal auquel les paquets peuvent être mis en file d'attente pour la livraison.

QoS et modems

À l'ère de la disponibilité quasi universelle des technologies à large bande, il semble étrange de parler de modems. Cependant, il existe encore de nombreuses petites entreprises et utilisateurs à domicile qui utilisent des modems comme mécanisme pour se connecter à Internet. Récemment, j'ai même vu une grande entreprise utiliser des modems pour communiquer avec des bureaux satellites situés dans des endroits éloignés où la technologie à large bande n'est pas disponible.

Bien sûr, le plus gros problème avec l'utilisation des modems est la bande passante limitée dont ils disposent. Un problème moins évident mais tout aussi important est que les utilisateurs ne modifient généralement pas leur comportement en ligne lorsqu'ils utilisent des connexions commutées. Bien sûr, les utilisateurs peuvent ne pas avoir envie de télécharger de gros fichiers lorsqu'ils sont connectés à Internet via un modem, mais le reste du comportement de l'utilisateur reste le même que s'il était connecté via une connexion haut débit.

En règle générale, les utilisateurs ne se soucient pas trop de garder Microsoft Outlook ouvert tout le temps ou de naviguer pendant le téléchargement des fichiers en arrière-plan. Certains utilisateurs gardent également leur système de messagerie instantanée ouvert en permanence. Le problème avec ce type de comportement est que chacune de ces applications ou tâches consomme une certaine quantité de bande passante sur votre connexion internet.

Pour voir comment QoS peut aider, examinons ce qui se passe dans des circonstances normales lorsque QoS n'est pas utilisé. Habituellement, la première application qui essaie d'accéder à Internet a le plus de droits pour utiliser la connexion. Cela ne signifie pas que d'autres applications ne peuvent pas utiliser la connexion, mais plutôt que Windows pense que d'autres applications n'utiliseront pas la connexion.

Une fois la connexion établie, Windows commence à ajuster dynamiquement la taille de la fenêtre de réception TCP. La taille de la fenêtre de réception TCP est la quantité de données pouvant être envoyées avant d'attendre un accusé de réception des données. Plus la fenêtre de réception TCP est grande, plus le nombre de paquets que l'expéditeur peut transmettre est important avant d'attendre une confirmation de livraison réussie.

La taille de la fenêtre de réception TCP doit être réglée avec soin. Si la fenêtre de réception de TCP est trop petite, l'efficacité en souffrira, car TCP nécessite des accusés de réception très fréquents. Cependant, si la fenêtre de réception TCP est trop grande, la machine peut transmettre trop de données avant de savoir qu'il y a eu un problème pendant le transfert. En conséquence, une grande quantité de données doit être retransmise, ce qui affecte également l'efficacité.

Lorsqu'une application commence à utiliser une connexion Internet à distance, Windows ajuste dynamiquement la taille de la fenêtre de réception TCP au fur et à mesure qu'il envoie des paquets. L'objectif de Windows ici est d'atteindre un état stable dans lequel la taille de la fenêtre de réception TCP est réglée de manière optimale.

Maintenant, supposons que l'utilisateur ouvre une deuxième application qui nécessite également une connexion Internet. Après cela, Windows lance l'algorithme de démarrage lent TCP, qui est l'algorithme chargé d'ajuster la taille de la fenêtre de réception TCP à la valeur optimale. Le problème est que TCP est déjà utilisé par une application qui a été démarrée plus tôt. Cela affecte la deuxième application de deux manières. Premièrement, la deuxième application prend beaucoup plus de temps pour atteindre la taille optimale de la fenêtre de réception TCP. Deuxièmement, le débit en bauds de la deuxième application sera toujours plus lent que le débit en bauds de l'application en cours d'exécution.

La bonne nouvelle est que vous pouvez éviter ces problèmes sur Windows XP et Windows Server 2003 en exécutant simplement le planificateur de packages QOS. Après cela, le planificateur de paquets QOS utilisera automatiquement une technologie appelée Deficit Round Robin chaque fois que Windows détectera une vitesse de connexion lente.

Deficit Round Robin fonctionne en créant dynamiquement des files d'attente distinctes pour chaque application nécessitant un accès Internet. Windows gère ces files d'attente de manière circulaire, ce qui améliore considérablement l'efficacité de toutes les applications qui doivent accéder à Internet. Si vous êtes curieux, Deficit Round Robin est également disponible dans Windows 2000 Server, mais il ne s'active pas automatiquement.

Partage de connexion Internet

Dans Windows XP et Windows Server 2003, QoS facilite également le partage de connexion Internet. Comme vous le savez probablement, le partage de connexion Internet est un moyen simplifié de créer un routeur basé sur NAT. L'ordinateur auquel la connexion Internet est physiquement connectée agit comme un routeur et un serveur DHCP pour les autres ordinateurs du réseau, leur fournissant ainsi un accès à Internet via cet hôte. Le partage de connexion Internet n'est généralement utilisé que sur de petits réseaux peer-to-peer dépourvus d'infrastructure de domaine. Les grands réseaux utilisent généralement des routeurs physiques ou des services de routage et d'accès à distance.

Dans la section ci-dessus, j'ai déjà expliqué comment Windows ajuste dynamiquement la taille de la fenêtre de réception TCP. Cependant, ce paramètre dynamique peut poser des problèmes lors du partage d'une connexion Internet. La raison en est que les connexions entre ordinateurs sur un réseau local sont généralement relativement rapides. En règle générale, une telle connexion consiste en une connexion Ethernet 100 Mb ou sans fil 802.11G. Bien que ces types de connexions soient loin d'être les plus rapides, ils sont beaucoup plus rapides que la plupart des connexions Internet disponibles aux États-Unis. Là est le problème.

L'ordinateur client doit communiquer via Internet, mais il ne peut pas le faire directement. Au lieu de cela, il utilise l'hôte de partage de connexion Internet comme module d'accès. Lorsque Windows calcule la taille optimale de la fenêtre de réception TCP, il le fait en fonction de la vitesse de la connexion entre la machine locale et la machine de partage de connexion Internet. La différence entre la quantité de données que la machine locale peut réellement recevoir d'Internet et la quantité qu'elle pense pouvoir recevoir, en fonction de la vitesse de l'hôte de partage de connexion Internet, peut causer des problèmes. Plus précisément, la différence de vitesse de connexion peut potentiellement provoquer des situations dans lesquelles les données sont sauvegardées dans une file d'attente connectée à une connexion lente.

C'est là que la QoS entre en jeu. Si vous installez le planificateur de paquets QOS sur un site de partage de connexion Internet, l'hôte de partage de connexion Internet invalidera la taille de la fenêtre de réception TCP. Cela signifie que l'hôte de partage de connexion Internet définira la taille de la fenêtre de réception TCP pour les hôtes locaux sur la même taille que s'ils étaient directement connectés à Internet. Cela résout les problèmes causés par des vitesses de connexion réseau incompatibles.

Conclusion

Dans cette série d'articles, j'ai couvert la QoS et comment elle peut être utilisée pour façonner le flux de trafic sur divers types de connexions réseau. Comme vous pouvez le voir, la qualité de service peut rendre le réseau beaucoup plus efficace en façonnant le trafic de manière à tirer parti de la congestion du réseau la plus légère et à assurer une livraison plus rapide du trafic de priorité plus élevée.

Brien Posey

Le mythe de la QoS

Il n'y a pas une seule personne qui n'a lu au moins une fois une FAQ sur Windows XP. Et si c'est le cas, alors tout le monde sait qu'il existe une qualité de service si nuisible - pour faire court, la qualité de service. Lors de la configuration du système, il est fortement recommandé de le désactiver, car il limite la bande passante du réseau à 20 % par défaut, et comme si ce problème existait également sous Windows 2000.

Ce sont les lignes :

« Q : Comment désactiver complètement le service QoS (Quality of Service) ? Comment le configurer ? Est-il vrai que cela limite la vitesse du réseau ?"

R : En effet, par défaut Quality of Service réserve 20% de la bande passante du canal pour ses besoins (n'importe quel - même un modem pour 14400, même un gigabit Ethernet). De plus, même si vous supprimez le service QoS Packet Scheduler de la connexion Propriétés, ce canal n'est pas libéré. Vous pouvez libérer le canal ou simplement configurer QoS ici. Lancez l'applet de stratégie de groupe (gpedit.msc). Dans Stratégie de groupe, recherchez Stratégie d'ordinateur local et cliquez sur Modèles d'administration. Sélectionnez l'élément Réseau - QoS Packet Sheduler. Activez Limiter la bande passante réservable. Maintenant, nous réduisons la limite de bande passante de 20% à 0% ou la désactivons simplement. Si vous le souhaitez, vous pouvez également configurer d'autres paramètres QoS ici. Pour activer les modifications, il vous suffit de redémarrer."

20 %, c'est bien sûr beaucoup. Vraiment Microsoft est Mazdai. Des déclarations de ce genre errent de FAQ en FAQ, de forum en forum, de média en média, sont utilisées dans toutes sortes de "tweaks" - programmes pour "réglage" Windows XP (au fait, ouvrez "Group Policies" et "Local Politiques de sécurité", et aucun "tweak" ne peut les égaler dans la richesse des options de personnalisation). Il faut veiller à exposer des allégations infondées de ce genre, ce que nous allons maintenant faire par une approche systématique. C'est-à-dire que nous étudierons en profondeur la question problématique, en nous appuyant sur des sources primaires officielles.

Qu'est-ce qu'un réseau de services de qualité ?

Adoptons la définition simplifiée suivante d'un système en réseau. Les applications s'exécutent et s'exécutent sur des hôtes et communiquent entre elles. Les applications envoient des données au système d'exploitation pour transmission sur le réseau. Une fois que les données sont transférées vers le système d'exploitation, elles deviennent du trafic réseau.

La qualité de service du réseau repose sur la capacité du réseau à traiter ce trafic pour garantir que les demandes de certaines applications sont satisfaites. Cela nécessite un mécanisme fondamental de traitement du trafic réseau capable d'identifier le trafic éligible et de contrôler un traitement spécifique.

La fonctionnalité QoS est conçue pour satisfaire deux acteurs du réseau : les applications réseau et les administrateurs réseau. Ils ont souvent des désaccords. L'administrateur réseau limite les ressources utilisées par une application spécifique, tandis que l'application essaie de récupérer autant de ressources réseau que possible. Leurs intérêts peuvent être conciliés, compte tenu du fait que l'administrateur du réseau joue un rôle de premier plan vis-à-vis de toutes les applications et utilisateurs.

Paramètres QoS de base

Différentes applications ont des exigences différentes pour gérer leur trafic réseau. Les applications tolèrent plus ou moins la latence et la perte de trafic. Ces exigences ont trouvé une application dans les paramètres suivants liés à la qualité de service :

Bande passante - Le débit auquel le trafic généré par l'application doit être envoyé sur le réseau.

Latence - La latence qu'une application peut tolérer lors de la livraison d'un paquet de données.

Jitter - modifiez le temps de retard.

Perte - Le pourcentage de données perdues.

Si des ressources réseau infinies étaient disponibles, tout le trafic d'application pourrait être transmis au débit requis, avec une latence nulle, une variation de latence nulle et une perte nulle. Cependant, les ressources du réseau ne sont pas illimitées.

Le mécanisme QoS contrôle l'allocation des ressources réseau pour le trafic applicatif afin de répondre à ses exigences de transmission.

Ressources QoS fondamentales et mécanismes de gestion du trafic

Les réseaux qui connectent les hôtes utilisent une variété de périphériques réseau, notamment des adaptateurs réseau hôte, des routeurs, des commutateurs et des concentrateurs. Chacun d'eux dispose d'interfaces réseau. Chaque interface réseau peut recevoir et transmettre du trafic à un débit fini. Si le débit auquel le trafic est dirigé vers une interface est supérieur au débit auquel l'interface transfère le trafic, un encombrement se produit.

Les périphériques réseau peuvent gérer la condition de congestion en mettant le trafic en file d'attente dans la mémoire du périphérique (dans une mémoire tampon) jusqu'à ce que la congestion soit terminée. Dans d'autres cas, l'équipement réseau peut réduire le trafic pour réduire la congestion. De ce fait, les applications sont confrontées à un changement de latence (car le trafic est stocké dans des files d'attente sur les interfaces) ou à une perte de trafic.

La capacité des interfaces réseau à transférer le trafic et la disponibilité de la mémoire pour stocker le trafic sur les périphériques réseau (jusqu'à ce que le trafic puisse être envoyé plus loin) constituent les ressources fondamentales requises pour fournir la qualité de service pour les flux de trafic d'application.

Allocation de ressources QoS aux périphériques réseau

Les appareils qui prennent en charge la qualité de service utilisent intelligemment les ressources réseau pour acheminer le trafic. C'est-à-dire que le trafic des applications plus tolérantes aux latences est mis en file d'attente (stocké dans un tampon en mémoire) et que le trafic des applications critiques pour la latence est transféré.

Pour accomplir cette tâche, un périphérique réseau doit identifier le trafic en classant les paquets et doit disposer de files d'attente et de mécanismes pour les servir.

Moteur de traitement du trafic

Le mécanisme de traitement du trafic comprend :

802.1p

Comportements différenciés par saut (diffserv PHB).

Services intégrés (intserv).

guichet automatique, etc.

La plupart des réseaux locaux sont basés sur la technologie IEEE 802, y compris Ethernet, Token Ring, etc. 802.1p est un mécanisme de traitement du trafic pour prendre en charge la QoS dans de tels réseaux.

802.1p définit un champ (couche 2 dans le modèle de réseau OSI) dans un en-tête de paquet 802 qui peut transporter l'une des huit valeurs de priorité. En règle générale, les hôtes ou les routeurs, lors de l'envoi de trafic vers le réseau local, marquent chaque paquet envoyé en lui attribuant une certaine valeur de priorité. Les périphériques réseau tels que les commutateurs, les ponts et les concentrateurs sont censés gérer les paquets de manière appropriée à l'aide de mécanismes de mise en file d'attente. 802.1p est limité à un réseau local (LAN). Dès que le paquet traverse le LAN (via OSI Layer 3), la priorité 802.1p est supprimée.

Diffserv est un mécanisme de couche 3. Il définit un champ dans la couche 3 de l'en-tête des paquets IP appelé diffserv codepoint (DSCP).

Intserv c'est toute une gamme de services qui définissent un service garanti et un service qui gère les téléchargements. Le service garanti promet de transporter une certaine quantité de trafic avec une latence mesurable et limitée. Le service qui gère la charge s'engage à acheminer une certaine quantité de trafic avec un « léger encombrement du réseau ». Ce sont des services mesurables dans le sens où ils sont définis pour fournir une qualité de service mesurable à une quantité spécifique de trafic.

Étant donné que la technologie ATM fragmente les paquets en cellules relativement petites, elle peut offrir une latence très faible. Si vous devez envoyer un paquet de manière urgente, l'interface ATM peut toujours être libre pour la transmission pendant le temps nécessaire pour transmettre une cellule.

La qualité de service comporte de nombreux mécanismes plus complexes qui font fonctionner cette technologie. Notons juste un point important : pour que la QoS fonctionne, il est nécessaire de supporter cette technologie et une configuration appropriée tout au long de la transmission du point de départ au point d'arrivée.

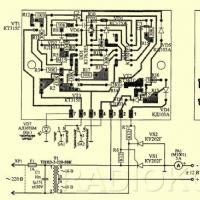

Pour plus de clarté, considérons la Fig. un.

Nous acceptons ce qui suit :

Tous les routeurs participent à la transmission des protocoles requis.

Une session QoS, nécessitant 64 Kbps, est provisionnée entre l'hôte A et l'hôte B.

Une autre session, nécessitant 64 Kbps, est initialisée entre l'hôte A et l'hôte D.

Pour simplifier le schéma, nous supposons que les routeurs sont configurés de manière à pouvoir réserver toutes les ressources du réseau.

Dans notre cas, une demande de réservation de 64 Kbps atteindrait trois routeurs sur le chemin de données entre l'hôte A et l'hôte B. Une autre demande de 64 Kbps atteindrait trois routeurs entre l'hôte A et l'hôte D. Les routeurs répondraient à ces demandes de réservation de ressources car ils pas dépasser le maximum. Si, à la place, les hôtes B et C initiaient chacun simultanément une session QoS de 64 Kbps avec l'hôte A, alors le routeur desservant ces hôtes (B et C) refuserait l'une des connexions.

Supposons maintenant que l'administrateur réseau désactive le traitement QoS sur les trois derniers routeurs desservant les hôtes B, C, D, E. Dans ce cas, les demandes de ressources jusqu'à 128 Kbps seraient satisfaites quel que soit l'emplacement de l'hôte participant. Cependant, l'assurance qualité serait faible car le trafic d'un hôte compromettrait le trafic d'un autre. La qualité de service pourrait être maintenue si le routeur supérieur limitait toutes les demandes à 64 Kbit/s, mais cela entraînerait une utilisation inefficace des ressources du réseau.

D'autre part, la bande passante de toutes les connexions réseau pourrait être augmentée à 128 Kbps. Mais la bande passante accrue ne sera utilisée que lorsque les hôtes B et C (ou D et E) demandent simultanément des ressources. Si ce n'est pas le cas, les ressources du réseau seront à nouveau utilisées de manière inefficace.

Composants Microsoft QoS

Windows 98 contient uniquement des composants QoS de niveau utilisateur, notamment :

Composants d'application.

API GQoS (partie de Winsock 2).

Fournisseur de services QoS.

Le système d'exploitation Windows 2000 / XP / 2003 contient tous les éléments ci-dessus et les composants suivants :

Fournisseur de services de protocole de réservation de ressources (Rsvpsp.dll) et services RSVP (Rsvp.exe) et QoS ACS. Non utilisé sous Windows XP, 2003.

Contrôle du trafic (Traffic.dll).

Classificateur de paquets générique (Msgpc.sys). Le classificateur de package identifie la classe de service à laquelle appartient le package. Dans ce cas, le colis sera livré dans la file d'attente appropriée. Les files d'attente sont gérées par le QoS Packet Scheduler.

Planificateur de packages QoS (Psched.sys). Définit les paramètres QoS pour un flux de données spécifique. Le trafic est balisé avec une valeur de priorité spécifique. Le planificateur de paquets QoS détermine le calendrier de mise en file d'attente pour chaque paquet et gère les demandes concurrentes entre les paquets mis en file d'attente qui nécessitent un accès réseau simultané.

Le diagramme de la figure 2 illustre la pile de protocoles, les composants Windows et leur interaction sur un hôte. Les éléments utilisés dans Windows 2000 mais non utilisés dans Windows XP / 2003 ne sont pas représentés dans le schéma.

Les applications sont au sommet de la pile. Ils peuvent ou non connaître la QoS. Pour exploiter toute la puissance de la QoS, Microsoft recommande d'utiliser les appels API QoS génériques dans les applications. Ceci est particulièrement important pour les applications nécessitant des garanties de service de haute qualité. Plusieurs utilitaires peuvent être utilisés pour invoquer la QoS au nom d'applications qui ne sont pas conscientes de la QoS. Ils fonctionnent via l'API de gestion du trafic. Par exemple, NetMeeting utilise l'API GQoS. Mais pour de telles applications, la qualité n'est pas garantie.

Le dernier clou

Les points théoriques ci-dessus ne donnent pas de réponse sans ambiguïté à la question de savoir où vont les notoires 20% (que, je note, personne n'a encore mesuré exactement). Sur la base de ce qui précède, cela ne devrait pas être le cas. Mais les opposants avancent un nouvel argument : le système QoS est bon, mais la mise en œuvre est tordue. Par conséquent, 20 % sont « gorgés » après tout. Apparemment, le problème a également épuisé le géant du logiciel, car il a déjà nié séparément de telles fabrications depuis assez longtemps.

Cependant, laissons la parole aux développeurs et présentons des moments choisis de l'article "316666 - Améliorations et comportement de la qualité de service (QoS) de Windows XP" en russe littéraire :

« 100 % de la bande passante du réseau est disponible pour être partagée entre tous les programmes, à moins qu'un programme ne demande explicitement la bande passante prioritaire. Cette bande passante « réservée » est disponible pour d'autres programmes si le programme qui l'a demandé n'envoie pas de données.

Par défaut, les programmes peuvent réserver jusqu'à 20% de la vitesse de connexion principale sur chaque interface informatique. Si le programme qui a réservé la bande passante n'envoie pas suffisamment de données pour l'utiliser, la partie inutilisée de la bande passante réservée est disponible pour d'autres flux de données.

Il y a eu des déclarations dans divers articles techniques et groupes de discussion selon lesquels Windows XP réserve toujours 20 % de la bande passante disponible pour la QoS. Ces déclarations sont fausses."

Si maintenant quelqu'un consomme encore 20% de la bande passante, eh bien, je peux vous conseiller de continuer à utiliser davantage toutes sortes de "tweaks" et de pilotes réseau déséquilibrés. Et pas tellement sera "engraissé".

Tout le monde, le mythe de la QoS, meurs !

Youri Trofimov,

X360ce - connectez n'importe quel joystick (instructions pour l'ancienne version) Installez le joystick sur le PC à partir de xbox 360

X360ce - connectez n'importe quel joystick (instructions pour l'ancienne version) Installez le joystick sur le PC à partir de xbox 360 Récupérer des contacts sur Android

Récupérer des contacts sur Android Pizza empire code promo octobre

Pizza empire code promo octobre Pourquoi le volant ne se connecte pas à l'ordinateur

Pourquoi le volant ne se connecte pas à l'ordinateur Comment connecter une roue de jeu à un ordinateur

Comment connecter une roue de jeu à un ordinateur Comment tenir un journal intime et à quoi sert-il

Comment tenir un journal intime et à quoi sert-il Chargeur "Cèdre": description, mode d'emploi

Chargeur "Cèdre": description, mode d'emploi