Сравнение чипсетов nvidia. Чипсеты семейства NVIDIA nForce. Напряжение питания процессора, В

Встроенная графика нового поколения пришла первой на платформу AMD. Почему так? Никакого секрета тут нет.

Во-первых, системная логика для платформы AMD устроена значительно проще, чем для платформы Intel. По той причине, что самые сложные компоненты уже встроены в центральный процессор, а на долю чипсета материнской платы приходится только поддержка периферии. Следовательно, встроить более сложное графическое ядро в кристалл северного моста чипсета для платформы AMD намного проще технически.

Во-вторых, корпорация Intel, основной поставщик чипсетов для своей платформы, пока не смогла представить достойное графическое ядро, которого следует опасаться NVIDIA. Неудивительно, что руководство последней потребовало приложить все усилия для своевременного выпуска новых интегрированных чипсетов для платформы AMD. Ведь сама AMD, заполучив отдел разработки чипсетов компании ATI, стала активно развивать именно направление интегрированных решений. И чипсет с новым графическим ядром, получивший название AMD 780G, выпустила первой именно она.

Впрочем, NVIDIA подтянулась довольно быстро. И, судя по косвенным признакам, ее чипсет получился более надежным и доведенным до ума, хотя и более дорогим. Собственно, чипсет не один – их целая линейка, от самых простых и дешевых до полнофункциональных с поддержкой Tri-SLI. Из них на рынок домашних медиа-центров нацелены чипсеты GeForce 8000, которые предназначены для установки на материнские платы с максимальным количеством мультимедиа-функций.

Итак, что нам может предложить чипсет GeForce 8200, базовый в упомянутой линейке? Он оснащен урезанным графическим ядром G86, успешно примененным в свое время в видеокартах серии GeForce 8400. Заявленная поддержка DirectX 10 и шейдеров версии 4.0 вряд ли пригодится владельцу интегрированной материнской платы, так как ввиду некоторых "врожденных" особенностей (в частности, нет локальной памяти – только системная, доступная через общий контроллер) производительность в 3D будет весьма низкой. Но с другой стороны, чип G86 способен аппаратно обрабатывать видеопоток, сжатый новыми кодеками, ускоряя тем самым воспроизведение. При этом новый чипсет в полной мере поддерживает интерфейс HDMI для подключения цифровых телевизоров, позволяет передавать цифровой многоканальный звук и видео по одному и тому же интерфейсу.

Важной может показаться и новая функция "гибридной" графики, позволяющая добавлять дискретную видеокарту для совместного со встроенной обсчета 3D-графики (технология GeForce Boost). Правда, работать это будет только для младшей модели вроде той же 8400, покупка которой, между нами говоря, не имеет никакого смысла. Если же оснастить новую плату мощной видеокартой класса 9800 GT, то гибридная технология может быть применена для другого – для отключения этой видеокарты при работе в 2D, что дает снижение температуры и шума компьютера.

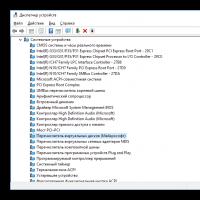

С точки зрения поддержки периферии у чипсетов NVIDIA давно все в порядке – гигабитный Ethernet, RAID вплоть до уровня 5, 12 портов USB. В новой линейке реализована поддержка PCI Express 2.0. Неясной остается ситуация лишь с External SATA: на платах с чипсетами NVIDIA соответствующий разъем если и встречается, то обслуживается дополнительным контроллером, а не чипсетом. Но модели внешних винчестеров с External SATA уже не редкость.

Gigabyte M78SM-S2H. Дизайн, функциональность

Несмотря на то, что чипсеты серии GeForce 8000 практически не уступают чипсету AMD 780G, да и другие модели нового поколения весьма неплохи, компания Gigabyte отдает предпочтение именно чипсетам AMD 700-ой серии. Связано это, возможно, с высокой стоимостью микросхем NVIDIA. В частности, на базе чипсета GeForce 8200 у Gigabyte имеется (на момент подготовки статьи) только одна модель – M78SM-S2H.

А модель эта интересная. Начнем с того, что она оснащается сразу тремя видеовыходами – аналоговым VGA (с разъемом D-Sub) и цифровыми DVI и HDMI. При этом нужно учесть, что цифровые порты делят на двоих один CRTC-контроллер, то есть выводят одинаковое изображение, в то время как порт VGA работает независимо от них. Этот недостаток может проявляться, например, невозможностью реализовать режим "Театр", когда на телевизор выводится полноэкранное видео, которое на мониторе в то же время воспроизводится в окне.

С другой стороны, отсутствует поддержка FireWire (1394), хотя большинство видеокамер подключаются именно через него. На панели портов имеется урезанный до трех набор аналоговых "джеков", зато выведен электрический S/PDIF.

Получается, что производитель рекомендует подключать и телевизор, и звук "по цифре". Аудиокодек Realtek ALC888 – обычный 8-канальный кодек с поддержкой основных функций. Сетевой кодек тоже Realtek, с поддержкой гигабитных сетей. Остальная функциональность, в том числе по поддержке жестких дисков, обеспечивается чипсетом NVIDIA.

Подробнее рассмотрим дизайн.

Плата выполнена в форм-факторе microATX, но по ширине она урезана почти на 3 см. К сожалению, поместились только два слота DIMM, что было бы не критично для платы начального уровня, но модель Gigabyte отнюдь не дешевая. Набор остальных слотов типичен для этого форм-фактора – по одному PCI Express, x16 и x1, плюс два PCI. Все шесть портов Serial ATA разведены, как и все 12 портов USB (в том числе 8 через внутренние штырьковые разъемы).

Модуль питания процессора выполнен по 4-фазной схеме, динамическое управление количеством фаз не реализовано.

В цепях использованы твердотельные конденсаторы, но только для VRM процессора. Оба разъема питания расположены в удобных местах.

Для охлаждения чипсета, а точнее, одного чипа MCP78S, из которого и состоит GeForce 8200, применен крупный алюминиевый радиатор, окрашенный "под золото".

Чтобы не мешать установке карты расширения в слот PCIe x1, который у платы только один, радиатор в соответствующем месте спилен.

Все разъемы расположены в удобных местах, за исключением Front Audio, который вынесен поближе к аудиокодеку. Особенность последних моделей Gigabyte, и M78SM-S2H в частности, состоит в том, что все разъемы не только подробно раскрашены, но и снабжены подписями прямо на колодках (крупными и читабельными), а также рамками для надежной фиксации.

Будем надеяться, что и другие производители начнут ставить такие колодки.

Панель портов у платы нестандартная. Про три видеовыхода и S/PDIF мы уже упоминали, как и про 4 порта USB. Тут имеется также архаичный порт LPT (трудно предположить, зачем он может понадобиться в домашнем компьютере), зато PS/2 порт для мышки отсутствует – на его месте расположены два USB.

BIOS, настройки

По традиции плата M78SM-S2H снабжена BIOS фирмы Award, в который внесены некоторые фирменные изменения. Например, самые "опасные" опции доступны после нажатия Ctrl-F1 в главном меню BIOS Setup.

Для повышения производительности и разгона следует заглянуть в раздел MB Intelligent Tweaker, поскольку в остальных разделах ничего интересного обнаружено не было.

Объем настроек для разгона весьма невелик и включает:

- выбор опорной частоты шины HT, от которой зависит тактовая частота процессора (по умолчанию 200 МГц);

- выбор множителя (для процессоров серии Black Edition);

- выбор множителя (в виде частоты) и ширины канала HT между процессором и чипсетом;

- настройка частоты шины PCI Express;

- изменение напряжения на процессоре и модулях памяти; для процессора отображается номинальное напряжение (так сказать, для справки).

В подразделе управления работой памяти можно указать желаемую ее частоту (400, 533, 667, 800 или 1066 МГц), которая не всегда будет совпадать с реальной (ввиду особенностей тактирования памяти у процессоров AMD).

Набор таймингов скрыт от пользователя, можно изменить лишь CAS Latency.

В разделе PC Health Status можно опять же по традиции указать порог температуры, по достижении которого включается "сирена", и активировать предупреждение об остановке кулера процессора и вентилятора в корпусе.

Управление вращением процессорного кулера имеется, но оно не настраивается; вентилятор в корпусе не управляем.

В целом набор настроек платы M78SM-S2H весьма скромен для платы домашнего назначения и скорее характерен для платы офисной.

Комплектация

В коробке с платой Gigabyte M78SM-S2H обнаружен компакт-диск (драйверы и утилиты для плат на чипсетах NVIDIA), заглушка для панели портов, два кабеля Serial ATA, один IDE и один FDD.

Руководство пользователя очень подробное, имеется небольшая инструкция на французском и турецком (видимо, в этих странах запрещено продавать товары без инструкции). Никаких других аксессуаров, которые могут пригодиться пользователю, в комплекте нет.

Тестирование

Мы провели тестирование платы Gigabyte в составе компьютера следующей конфигурации:

- процессор Athlon 64 X2 5000+ Black Edition (2.6 ГГц);

- память DDR2 GoodRAM PRO DDR2-900 2 x 1 Гб;

- жесткий диск WD Caviar SE 250 Гб.

Для сравнения приведем результаты тестирования конкурирующего продукта – платы Micro-Star на чипсете AMD 780G. Данная плата в чем-то уступает M78SM-S2H (нет поддержки RAID и разъема DVI), а в чем-то превосходит, в том числе по стоимости.

Производительность . В тесте SYSMark 2007 задействован целый ряд современных приложений, которые отрабатывают тот или иной сценарий – последовательность действий пользователя. Мы запускали этот пакет и в Windows XP, и в Windows Vista.

И, судя по всему, у платы Gigabyte производительность на 5-10% выше. Обратный результат наблюдался только в Vista, в сценарии видеомонтажа, в чем виноват скорее сам тест SYSMark 2007.

А вот с производительностью встроенной графики в 3D-играх у данной платы (и у всех аналогов) проблемы.

Рассчитывать на играбельность можно лишь в играх типа Quake 4 или Call за Duty 2, да и то при минимальных настройках и разрешении ниже 1024х768. У встроенной графики чипсета AMD 780G показатели лучше, но тоже далеки от желаемого.

Разгон . Плата M78SM-S2H способна работать при опорной частоте шины HT, равной 405 МГц (если процессор позволит, конечно). Значение выше этого BIOS просто не позволяет ввести. Что касается конкретных результатов разгона тестового процессора Athlon 64 X2 5000+, то у нас получился результат всего 2.75 ГГц, или 6% прироста. А все оттого, что BIOS не дает повысить напряжение Vcore выше 1.55 В.

Плата Gigabyte M78SM-S2H интересна прежде всего наличием сразу трех выходов на монитор, включая HDMI. Ее встроенная графика способна поддерживать 3D-игры (пусть и в минимальном качестве), а также аппаратно декодировать HD-видео на дисках Blu-ray. В плюсы запишем также поддержку RAID и наличие шести разъемов Serial ATA. Вместе с тем данная плата не пригодна для разгона (по крайней мере, при активированной встроенной графике) и не имеет никаких дополнительных функций, которые положены хорошей модели для домашнего ПК.

Плюсы:

- три видеовыхода;

- практичная компоновка, уменьшенная ширина;

- 6 портов Serial ATA и 12 USB;

- твердотельные конденсаторы в цепях VRM процессора.

Минусы:

- всего два слота DIMM;

- нет FireWire;

- не поддерживается аналоговое подключение акустики 7.1;

- бедный настройками BIOS.

Благодарим компанию "ДжетСервис" за предоставленную материнскую плату Gigabyte

| Оценка автора: |

|

Компания NVIDIA хорошо известна пользователям ПК как признанный лидер рынка игровых видеокарт. Благодаря своим 3D-ускорителям GeForce компании удалось занять практически монопольное положение, поскольку она испытывает конкуренцию только со стороны одной графической компании, ATI Technologies. Не останавливаясь на достигнутом, NVIDIA сделала попытку вторгнуться на другой рынок, рынок чипсетов для материнских плат.

Однако успешной эту попытку назвать никак нельзя. На мой взгляд, повторилась ситуация с запуском графического бизнеса NVIDIA. Как известно, компания дебютировала на рынке с чипом NV1 - интегрированным контроллером, совмещающим в себе и видео-, и звуковую часть. Однако в итоге пришлось отказаться от звука и выпустить NV2 (он же Riva128) - классический графический 3D-ускоритель.

Конечно, сегодня все обстоит не так, как это было в начале. NVIDIA - далеко не новичок в области разработки высокотехнологических продуктов. Однако у чипсетов для материнских плат есть своя специфика: это не просто подсистема, как в случае с графическим контроллером, это - важнейший узел системы, выступающий в роли связующего звена между всеми остальными компонентами. От чипсета во многом зависят практически все параметры системы - производительность, совместимость, расширяемость, функциональность, стабильность и т.д. С первого раза выпустить продукт, не уступающий по всем параметрам аналогам фирм, которые не одну собаку съели на разработках чипсетов, кажется просто нереальным.

Однако надо отдать должное смелости NVIDIA. Фирма не просто предложила свой аналог, она использовала самые передовые и многообещающие технологии, сделав заявку на лидерство как в сегменте производительных ПК, так и в сегментах базовых (mainstream) и бюджетных (value) систем. К сожалению, все идет к тому, что попытка в целом не удалась. Однако об этом - чуть позже, а сейчас - краткий обзор чипсетов серии nForce с сопоставлением того, что хотела NVIDIA, и что получилось на самом деле.

Чипсеты nForce: 420D, 415D, 220D, 220

Семейство чипсетов NVIDIA включает в себя на данный момент четыре базовых модификации: nForce 420D, 415D, 220D и 220 (по убыванию стоимости). Также в ближайшее время будут добавлены еще два чипсета - nForce 620D и 615D, которые являются ничем иным, как доработанными модификациями 420D и 415D соответственно (по крайней мере, такие сведения имеются на момент написания статьи).

Структура чипсета - классическая двухчиповая: сопряжением процессора, памяти и AGP-видеокарты занимается северный мост, а за работу с периферийными устройствами отвечает южный мост. Северных мостов nForce существует три: IGP-128, IGP-64 и SPP.

"IGP" - это "Integrated Graphics Processor" (интегрированный графический процессор), северный мост со встроенным графическим ядром, который NVIDIA называет процессором. Идеологически это неверно, так как обработкой данных он не занимается, а только коммутирует потоки данных и команд. Вот его часть, графическое ядро, действительно является процессором. Варианты чипа с индексами -128 и -64 отличаются суммарной шириной шины памяти (об том ниже). Чип IGP-128 является основой nForce 420D, а IGP-64 - nForce 220D и 220.

"SPP" расшифровывается как "System Platform Processor". Фактически это все тот же IGP-128, но с отключенным графическим ядром. NVIDIA пришлось отказаться от встроенной графики, достаточно медленной по нынешним меркам, поскольку современным требованиям она уже не удовлетворяет. Рынок производительных компьютеров не принял nForce 420D, однако в случае с nForce 415D (именно этот чипсет использует северный мост SPP) ситуация может измениться коренным образом. Нечто подобное в свое время произошло с Intel и чипсетом i815. Мне, например, непонятно, почему NVIDIA наступила на те же грабли.

В качестве южного моста NVIDIA предлагает чип MCP-D или его упрощенный вариант MCP. "MCP" расшифровывается как "Media and Communication Processor". В его состав входит звуковой контроллер NVIDIA "APU" (Audio Processing Unit), контроллеры USB и ATA, PCI и LPC интерфейс, сетевой контроллер MAC-уровня, SMBus-контроллер, другие контроллеры и кое-что необычное - тактовый генератор. Связь с северным мостом осуществляется посредством шины HyperTransport - фактически это первый массовый продукт, имеющий поддержку этой новейшей разработки AMD.

Давайте подробно рассмотрим особенности архитектуры и функционирования чипов.

Северные мосты IGP и SPP: TwinBank, DASP, NV11

Северный мост чипсета nForce 420D - это чип, обеспечивающий взаимодействие процессора, памяти, AGP-видеокарты и моста MCP. Он состоит из следующих блоков:

- шинный интерфейс (поддержка шины EV6 с эффективной частотой 200 и 266 МГц, используемой процессорами AMD K7);

- хост-контроллер AGP (режимы 4x, FastWrites, SBA, частота 66 МГц);

- контроллер шины HyperTransport (для связи с MCP, пропускная способность - 800 Мб/с);

- два независимых контроллера памяти, поддержка SDRAM и DDR SDRAM, частота - до 133 МГц, объем - до 1.5 Гб;

- встроенное графическое ядро GPU (NV11 GeForce2 MX);

- интеллектуальный арбитр-коммутатор.

Чипсет nForce поддерживает только процессоры AMD Athlon и Duron. Однако у NVIDIA нет каких-либо технических проблем с реализацией поддержки других процессоров, в частности, Intel Pentium-4. По ряду причин - маркетинговых, юридических и т.д. - на данный момент существует только вариант чипсета для платформы AMD.

Встроенное графическое ядро полностью эквивалентно чипу NV11 (GeForce2 MX). Отличия только в тактовых частотах и интерфейсе памяти. Встроенное ядро пользуется системными контроллерами, которые предоставляют доступ к памяти другим компонентам системы (в первую очередь процессору). Графическое ядро может быть отключено, если в слот AGP установлена внешняя видеокарта. Для большинства пользователей, использующих игры или графические приложения, возможностей и быстродействия GeForce2 MX будет недостаточно.

Для реализации вывода на телевизор и цифровой монитор чипсет поддерживает специальные платы расширения, устанавливаемые в слот AGP. Впрочем, они мало распространены, так что воспользоваться этой возможностью вряд ли удастся.

Чип SPP отличается от IGP только отключенным встроенным видео.

TwinBank - ключевая особенность архитектуры nForce, из-за которой, собственно, производительность чипсета должна была оказаться достаточно высокой. Ее суть в том, что у чипсета имеется не один, а два полноценных независимых 64-разрядных контроллера памяти, к которым могут обращаться все блоки чипсета. Каждый из контроллеров работает со своим набором банков (первый - с DIMM0, второй - с DIMM1 и DIMM2). Данные располагаются во всех банках с чередованием. При последовательном обращении к памяти устройство будет получать данные из обоих банков поочередно в режиме конвейера, что позволит сократить задержки, связанные с открытием/закрытием страниц, задержками на регенерацию и т.д. Если к памяти будут обращаться сразу несколько устройств, им не придется простаивать в ожидании, пока контроллер закончит работу с другим устройством. Тем самым гарантируется прирост скорости работы с памятью и увеличение ее пиковой пропускной способности до 4.2 Гб/с.

Использование такой архитектуры не должно привести к существенному увеличению быстродействия всей системы по той простой причине, что пропускная способность процессорной шины EV6 составляет всего 2.1 Гб/с - дополнительные 2.1 Гб/с ей практически ничего не дадут. Архитектура TwinBank оптимизирована прежде всего для нужд встроенного графического ядра. Благодаря ей интегрированный GeForce2 MX будет в меньшей степени подвержен проблемам совместного разделения шины памяти с другими компонентами системы, прежде всего с процессором. Если же будет использоваться отдельная видеокарта, прирост быстродействия будет мало заметен, так как прокачка текстур по AGP-каналу обычно не так интенсивна, чтобы загружать системную память.

NVIDIA утверждает, что если установить только один DIMM-модуль, будет использоваться только один контроллер памяти. Поэтому желательно ставить два модуля - один в первый, другой - во второй слот. Так как контроллеры независимы, можно ставить разные модули и конфигурировать их отдельно. По некоторым данным, если модули памяти не будут распознаны как официально поддерживаемые (см. список совместимых модулей на сайте NVIDIA), будет активирован режим "Super Stability Mode", при котором тайминги памяти снижены. Таким образом NVIDIA борется с проблемой низкой стабильности своего чипсета, выявленной сразу же после появления первых материнских плат на его базе.

Чип IGP-64 не позволяет использовать TwinBank (второй контроллер памяти отключен), поэтому его встроенное видео может теоретически достигнуть лишь уровня GeForce2 MX200. Однако до последнего времени nForce 220D, базирующийся на чипе IGP-64, не был востребован по причине слишком высокой цены, несоразмерной с его функциональностью и производительностью.

Еще одна ключевая особенность чипа IGP (точнее, его арбитра) - анализатор обращений к памяти DASP (Dynamic Adaptive Speculative Pre-Processor). Он отслеживает запросы на чтение, анализирует их характер и строит шаблоны, с помощью которых можно будет предсказать последующие запросы. После того, как шаблон определен, DASP-блок начинает генерировать запросы самостоятельно, предсказывая их и кэшируя полученные данные. Тем самым полоса пропускания памяти используется более эффективно, а часть данных, правильно предсказанная и полученная из памяти заблаговременно, поступает в процессор без обращения к памяти. Существующие чипсеты-аналоги способны только ставить запросы в очередь, но не предсказывать их. Тем самым технология DASP должна повысить эффективность TwinBank и обеспечить выдачу данных из памяти с меньшими задержками.

Южный мост MCP: APU

Южный мост NVIDIA MCP подключен к IGP/SPP с помощью новой универсальной шины HyperTransport, основное преимущество которой в данном случае - высокая пропускная способность (800 Мб/с). Только чипсеты SIS имеют более быстродействующую шину собственной разработки - MuTIOL (1 Гб/с), да и та вне чипов работает вдвое медленнее.

MCP - типичный современный южный мост, имеющий в своем составе контроллеры PCI (до пяти слотов), LPC (подключение флеш-микросхемы с ПЗУ и чипа ввода-вывода), USB (до шести портов), ATA/ATAPI (режим UltraATA/100), сетевой контроллер MAC-уровня и два AC-интерфейса для звуковых и модемных кодеков. Но есть у этого моста и уникальная особенность - встроенный звуковой контроллер APU (Audio Processing Unit). Он построен на базе нескольких DSP и способен аппаратно обрабатывать до 256 потоков 2D-звука, до 64 потоков 3D-звука, накладывать различные спецэффекты, в том числе применять HRTF-фильтры (для имитации объемного звучания). APU поддерживает DirectSound3D и новые возможности DirectX8, а также API и алгоритмы фирмы Sensaura. Кроме того, и это реализовано впервые, звуковой контроллер NVIDIA имеет встроенный блок кодирования звука в цифровой формат Dolby Digital (AC-3), благодаря чему позволяет эффективно использовать имеющуюся у пользователя цифровую акустику или систему "домашний кинотеатр". Впрочем, работает этот блок только у чипа MCP-D (nForce420D), а у MCP он отключен.

А в чем проблема?

Хорошо, скажете вы, чипсет замечательный - два контроллера памяти, шина HyperTransport, более чем передовой встроенный звук, да и графическое ядро - лучшее на сегодняшний день. Почему же тогда мы не завалены платами на чипсетах nForce?

Причин тому несколько. Во-первых, чипсет очень дорогостоящий. NVIDIA попросила за него нереальные деньги, поэтому производители материнских плат, ориентирующиеся на небогатого пользователя, сразу отказались от nForce - их потенциальные клиенты просто не смогут покупать дорогие платы. Сегодня с NVIDIA сотрудничают только избранные компании с положительной репутацией, выпускающие платы верхнего ценового диапазона - ASUS, ABIT, MSI, Leadtek и т.д.

Во-вторых, чипсет оказался не слишком удачным. Вот только короткий перечень его проблем:

- не доведенный до готовности BIOS, из-за чего возникают проблемы с совместимостью, быстродействием и стабильностью;

- встроенный тактовый генератор не имеет широких возможностей по настройке, что ограничивает пригодность платы к разгону;

- не предусмотрено достаточных средств для настройки чипсета;

- поддержка на уровне драйверов оставляет желать лучшего: WinNT, Linux и некоторые другие ОС практически не поддерживаются, Win98/ME - только частично (например, с горем пополам работает аппаратный звук).

В-третьих, чипсет совсем не вписался в ту нишу, на которую был нацелен. Встроенное игровое видео оказалось неуместным при высокой цене - куда важнее оно для бюджетной машины, но не для дорогостоящей игровой или рабочей станции. На мой взгляд, вместо nForce420D следовало сразу выпускать пару nForce 415D + nForce 220D.

Тем не менее, платы на базе nForce 420D после почти года доводки наконец-то появились в продаже в достаточных количествах. Обзору одной из них будет посвящена одна из следующих статей.

Комплектация.

В красочной коробке, внушительных размеров, кроме материнской платы имелось:

1. SLI мостики для 3-Way и обычной 2-Way SLI режима.

2. HDMI-to-DVI переходник.

3. Дополнительный вентилятор для материнской платы.

4. Переходник для подключения вентиляторов.

5. Шлейфы UltraDMA 133/100/66, SATA cables.

6. Кабели питания SATA.

7. Дополнительная плата с 2 портами USB 2.0 и IEEE 1394a

8. Руководство к эксплуатации.

9. Диск с драйверами и программами от Asus, 3Dmark06 и, что меня особенно удивило, с Антивирусом Касперского!

10. Диск с игрой Company of Heroes - лицензионная полная версия.

Технические спецификации.

Для новой материнской платы от Asus заявлены следующие возможности:

1. AMD® Socket AM2+ для процессоров AMD Phenom™ FX / Phenom / Athlon™ / Sempron™

2. AMD Socket AM2 для процессоров AMD Athlon 64 X2 / Athlon 64 FX / Athlon 64 / Sempron

3. AMD Cool"n"Quiet™ Technology

4. Chipset NVIDIA® nForce 780a SLI

5. System Bus Up to 5200 MT/s; HyperTransport™ 3.0 interface for AM2+ CPU. 2000 / 1600 MT/s for AM2 CPU. Как видим, тут используется новая шина, это первое отличие от материнчских плат предыдущей серии.

6. Memory 4 x DIMM, max. 8GB, DDR2 1066 / 800 / 667, ECC and non-ECC, un-buffered memory. Тут второе отличие. Правда это не заслуга нового чипсета, а заслуга новых процессоров AMD. Благодаря тому, что у новых процессоров контролёр памяти поддерживает память с частотой 1066Mhz и материнская плата при установке новых процессоров будет её поддерживать.

7. Dual channel memory architecture

8. VGA Integrated graphics. А тут мы видим новую тактику Nvidia, когда это было такое: Топовая материнская плата с интегрированным видео? А делается это всё для поддержки новых технологий Hybrid SLI и Hybrid Power.

9. 512MB Maximum shared memory of MB

Supports HDMI™ Technology with HDCP compliant with max. resolution 1920 x 1200

10. Supports D-Sub with max. resolution 1920 ? 1440 @ 75 Hz

Multi VGA output support: DVI & D-Sub

11. Hybrid SLI Support

12. Слоты расширения 3 x PCIe2.0 x16 support NVIDIA SLI Tech @ dual x16 or 3-way@x8, x8, x8. Это ещё одно отличие 3-слота Pci-Exp.

13. 2 x PCIe x1, PCIex1_1 (black) is compatible with audio slot

2 x PCI 2.2

14. Storage 6 x SATA 3Gb/s ports with RAID 0, 1, 0+1, 5 and JBOD support

15.1 x Ultra DMA 133 / 100 / 66 / 33

16. LAN Dual Gigabit LAN controllers, both featuring AI NET2

16A. High Definition Audio SupremeFX II Audio Card

- ADI 1988B 8-channel High Definition Audio CODEC

- Noise Filter

-Coaxial, Optical S/PDIF out at back I/O

17. IEEE 1394 2 x 1394a ports(1 port at back I/O, 1 port onboard)

18. USB max. 12 USB2.0/1.1 ports(6 портов на материнской плате, 6 портов на корпус)

19. ASUS ROG Overclocking Features Extreme Tweaker

20. Новая 8+2 фазное система питания.

21. Утилиты для разгона:

- CPU Level Up

- AI Overclocking (intelligent CPU frequency tuner)

- ASUS AI Booster Utility

- O.C Profile

22. Система защиты при разгоне:

- COP EX (Component Overheat Protection EX)

- Voltiminder LED

- ASUS C.P.R.(CPU Parameter Recall)

23. ASUS ROG Special Features LCD Poster

24. ROG BIOS Wallpaper

25. Onboard Switches: Power / Reset / Clr CMOS(at rear)

26. Q-Connector

27. ASUS EZ Flash2

28. ASUS CrashFree BIOS2

29. Stack Cool 2

30. ASUS Q-Shield

31. ASUS MyLogo3

32. Используются только твёрдотельные конденсаторы.

33. Порты вводавывода на задней панели:

1 x HDMI

1 x D-SUB

1 x PS/2 Keyboard port(purple)

1 x Optical + 1 x Coaxial S/PDIF Output

2 x LAN (RJ45) port

6 x USB 2.0/1.1 ports

1 x IEEE1394a port

1 x Clr CMOS switch

34. Внутренние порты:

3 x USB 2.0 connectors supports additional 6 USB 2.0 ports

1 x Floppy disk drive connector

1 x IDE connector for two devices

6 x SATA connectors

8 x Fan connectors: 1 x CPU / 1 x PWR / 3 x Chassis / 3 x Optional

3 x thermal sensor connectors

1 x IEEE1394a connector

1 x S/PDIF output connector

1 x Chassis Intrusion connector

24-pin ATX Power connector

8-pin ATX 12V Power connector

1 x En/Dis-able Clr CMOS

1 x LCD Poster

1 x ROG light connector

System panel connector

35. BIOS 8Mb Award BIOS, PnP, DMI2.0, WfM2.0, SM BIOS 2.4, ACPI2.0a Multi-Language BIOS

36. Manageability WOL by PME, WOR by PME, Chasis Intrusion, PXE

37. Form Factor ATX Form Factor, 12"x 9.6" (30.5cm x 24.4cm)

Разгон.

На новой материнской плате, процессору Phenom 9850, без труда удалось покорить свои заветные 2, 94 Ггц на номинальном напряжении 1,25 в..

При повышении напряжения кулер не справлялся со своей функцией, поэтому было решено отказаться от данной манипуляции.

Тестовая конфигурация и результаты тестирования.

Тестовая конфигурация:

1. Asus Crosshair II Formula

2. AMD Phenom 9850 BOX

3. Gainward 8800 GTS 512Mb Blitz

4. 2x1GbSamsung PC6400 DDR800

5. 2xHD WD 250AAJS в Raid 0 массиве.

6. Корпус Colors-it

7. БП FSP 450W

8. Монитор ASUS 222U

Тестирование проводилось в следующих тестах:

2. PC mark 2005.

3. 3Dmark 06.

1. Crysis (всё на максимум, разрешение 1280x1024)

Как видим, новая шина HyperTransport 3.0 даёт свои результаты. Новый чипсет показывает достойные результаты.

В синтетическом тесте новый чипсет также демонстрирует опережающие результаты.

В данном тесте мы также видим преимущество нового чипсета. Сразу должен оговорится, - преимущество идёт за счёт процессорного теста.

4. Тест жёсткого диска из пакета Everest Ultimate.

Линейная скорость чтения с Raid 0 массива также выше, чем у предыдущего чипсета.

Время доступа к данным на винчестерах, также быстрее на новом чипсете. Выводы:

1. Новый чипсет показывает отличные результаты по производительности. Во всех тестах он оказывается быстрее предшественника.

2. Особенно порадовало повышение быстродействия работы с жёсткими дисками. Этому я в последнее время уделяю всё большее внимание, так как считаю, что в современном компьютере самое слабое место - это Жёсткие диски.

3. Жаль, но система охлаждения процессора не позволила оценить все разгонные качества материнской платы и процессора. Но я уверен, разгонные характеристики процессора не были бы такими же потрясающими, как триумф нового чипсета.

4. Всё выше сказанное омрачают только новые процессоры от AMD. Да, если вы не планируете разгон - новую материнскую плату можно покупать с процессором от AMD. Но с другой стороны стоит ли платить 600$ за связку из материнской платы и процессора. Да, конечно, можно взять процессор по дешевле. Но не логично будет покупать материнскую плату за 330$,а процессор Phenom X3 за 170$ или Athlon X2 за 100$.

5. Отсюда вывод - данная материнская плата отлично подходит для Фанатов AMD и не более.

6. Мы, рассудительные пользователи, подождём материнские платы на чипсетах nForce 750a SLI, благо материнские платы на новых чипсетах nForce 750i SLI уже доступны в продаже.

Статья подготовлена FireAiD специально для Mega Obzor .

Смотрите в этой статье:

Видеокарты на базе NVIDIA GeForce RTX 2070, которым посвящен данный материал, являются младшими моделями из уже представленных на данных момент графических адаптеров нового поколения с архитектурой NVIDIA Turing.

Если не брать во внимание очень специфическую NVIDIA Titan RTX стоимостью $2500, то пользовательские видеокарты с архитектурой NVIDIA Turing представлены семейством NVIDIA GeForce RTX 2080 Ti, RTX 2080 и RTX 2070. Это видеокарты высокого класса, а через некоторое время планируется появление и более простых устройств типа RTX 2060.

Смотрим на характеристики

Графические процессоры для новых видеокарт Turing выполняются по более «тонкому» 12-нанометровому техпроцессу. Но, по слухам, этот техпроцесс не является чем-то принципиально новым, а представляет собой лишь чуть доработанную версию 16-нанометрового техпроцесса, который используется в предшественниках.

Для удобства сравнения характеристики новых GeForce RTX 2080 Ti, RTX 2080 и RTX 2070 и предшественников GeForce GTX 1080 Ti, GTX 1080 и GTX 1070 мы свели их в одну таблицу.

От поколения к поколению видеокарт NVIDIA можно наблюдать рост стоимости видеокарт. Но если ранее он был довольно плавным, то в данном случае адаптеры NVIDIA Turing значительно превзошли предшественников по цене.

За что платим?

Отчасти такое повышение можно объяснить увеличившейся сложностью новых GPU. Обратите внимание, что они имеют сильно возросшее количество транзисторов и значительно более высокую площадь кристалла. Соответственно, можно предположить, что себестоимость таких кристаллов оказывается выше.

Есть некоторые девиации по значениям частот GPU. Память теперь новая. Вместо GDDR5X и GDDR5 видеокарты RTX получили GDDR6.

Но примечательно, что объем памяти в новом поколение видеокарт остался на том же уровне, что и у предшественников.

Очень важно, что появились совершенно новые ядра RT и тензорные ядра. Именно этим обусловлен такой рост числа транзисторов и площади кристалла GPU.

Трассировка лучей

Поколение видеокарт RTX 2080 Ti, RTX 2080, RTX 2070 на базе архитектуры Turing сама NVIDIA называет революционной и связывает это с аппаратной поддержкой трассировки лучей в реальном времени.

Для этого внедрены упоминаемые выше RT-ядра. NVIDIA считает это настолько важным, что привычную приставку GTX в новых видеокартах даже заменили на RTX, где RT - Ray Tracing (трассировка лучей).

Данной технологии на презентации видеокарт нового поколения было уделено чуть ли не главное внимание.

Если упрощенно, то с Ray Tracing связаны новые эффекты отражений на объектах (в том числе взаимных), отражений света и прохождения лучей сквозь объекты. При этом лучи могут иметь реалистичное преломление, наложение и т. д. Ray Tracing также позволяет использовать более реалистичные смягченные тени и формировать правдоподобное освещение.

Это действительно очень важное нововведение для индустрии, но, как ни парадоксально, именно с технологией Ray Tracing и связывают довольно холодный прием новых видеокарт пользователями.

Новые RT-ядра сделали кристалл более крупным и дорогим, а что пользователи получают взамен?

На момент выхода видеокарт RTX не было ни единой игры, которая бы обладала поддержкой Ray Tracing. Сейчас ситуация меняется, но очень медленно.

К примеру, попробовать Ray Tracing вообще в какой-либо игре стало возможно совсем недавно с выходом Battlefield V.

Как оказалось, картинка в Battlefield V с эффектами меняется не так и кардинально. Улучшения есть, но совсем не скажешь, что получаешь принципиально новый уровень восприятия.

А вот вычислительные ресурсы Ray Tracing «подъедает» существенно. При активации трассировки лучей производительность может падаем более чем вдвое.

В результате, даже с дорогущей топовой NVIDIA GeForce RTX 2080 Ti, уровень FPS при Full HD-разрешении, максимальных настройках качества с использованием Ray Tracing не всегда сможет удовлетворить требовательного геймера.

А что тогда говорить о более простых RTX 2080, RTX 2070 и более высоких разрешениях?

Получается, что на данный момент игр с Ray Tracing практически нет, визуально разница в изображении с эффектами RT не такая кардинальная, а активация трассировки приводит к большому падению уровня FPS.

Для пользователей Ray Tracing в реальном времени пока является лишь потенциально перспективной технологией. Посмотрим, как будет развиваться ситуация.

DLSS-сглаживание, тензорные ядра и искусственный интеллект

Вдобавок к совершенно новым RT-ядрам в видеокартах RTX появились и тензорные ядра, предназначенные для рассчетов ИИ и нейросетей. Они работают в связке c RT-ядрами, но тензорные ядра могут использоваться и для других функций.

На базе их работы реализован новый метод сглаживания - DLSS (Deep Learning Super Sampling). Используется сниженное разрешение рендеринга, но за счет ИИ и тензорных ядер видеокарта преобразовывает изображение в более качественное, «додумывая» новые детали.

В зависимости от особенностей реализации за счет этого можно добиться увеличения производительности, повышения качества изображения или того и другого одновременно.

Опять-таки, как и в случае с Ray Tracing, для работы DLSS необходима поддержка со стороны игр. Указывается, что несколько десятков готовящихся к выходу игр будут поддерживать DLSS-сглаживание.

Одним из немногих тестов, где уже сейчас можно проверить DLSS, стал бенчмарк Final Fantasy XV Benchmark. Если в системе установлена видеокарта GeForce RTX, в настройках появляется соответствующий пункт, позволяющий активировать DLSS.

По нашим тестам, активация DLSS привела к существенному увеличению производительности.

Качество изображения с использованием DLSS и с обычным TAA-сглаживанием в данном приложении сопоставимо. Вы можете самостоятельно сравнить кадры с DLSS и с TAA.

DLSS

DLSS

TAA

TAA

Что еще нового?

Продолжает совершенствоваться технология автоматического повышения частоты GPU. В видеокартах NVIDIA RTX используется уже четвертое поколение GPU Boost.

Добавлена возможность ручной корректировки алгоритма работы разгона. Но куда более интересно, что впервые появилась функция автоматического разгона.

Если ранее для определения предельной частоты GPU требовалось экспериментировать, запускать различные игры, приложения, то сейчас процесс может быть сильно упрощен.

В приложениях типа MSI AfterBurner доступен новый пункт Nvidia Scanner. Нажав всего одну кнопку, через минут 15 автоматических тестов вы получите измененную кривую частот/напряжений GPU, соответственно, с более высокими значениями частот.

В наших тестах для всех видеокарт RTX 2070 мы проверяли такой автоматический разгон. Конечно, для получения еще более высоких результатов оверклокинга придется все же проводить более сложный разгон «вручную».

К видеокартам RTX можно подключить сразу два монитора с разрешением 8K. Максимальная кадровая частота будет составлять 60 Гц у обоих устройств вывода изображения.

Порты DisplayPort теперь соответствуют версии DisplayPort 1.4a, а HDMI - HDMI 2.0b. Обратите также внимание на наличие разъема USB Type-C прямо на видеокарте. Он предназначен для новых VR-шлемов.

Впрочем, этот порт может использоваться для любых устройств с поддержкой USB Type-C.

Вполне ожидаемо, что была проведена работа с различными видеокодеками. Например, добавлена поддержка компрессии данных в формате H.265 (HEVC) в режиме разрешении , а также повышено качество кодирования. Учитывая, что сегодня видеокарты активно используются при видеомонтаже, это весьма актуально.

Возможность объединения нескольких видеокарт в одной системе теперь доступна только в видеокартах самого высокого класса. NVIDIA GeForce RTX 2070 такой функции лишены.

Участники теста

В одном тесте нам удалось собрать сразу четыре видеокарты на базе NVIDIA GeForce RTX 2070 от разных производителей.

Это модели ASUS ROG Strix GeForce RTX 2070 OC edition, Gigabyte AORUS GeForce RTX 2070 XTREME 8G, Inno3D GeForce RTX 2070 Gaming OC X2 и MSI GeForce RTX 2070 GAMING Z 8G.

Все они имеют значительные отличия от референсных RTX 2070, получили повышенные частоты и используют фирменные системы охлаждения.

Сравнительная таблица характеристик

| Кодовый идентификатор модели | ROG-STRIX-RTX2070-O8G-GAMING | GV-N2070AORUS X-8GC | N20702-08D6X-2511683 | - |

| Поставщик | Представ-во ASUS | Представ-во Gigabyte | Представ-во Inno3D | Представ-во MSI |

| Цена, $ | 796 | 742 | 675 | 725 |

| Результаты измерений | ||||

| Производительность | 87,49 | 87,73 | 86,21 | 87,93 |

| 100 | 96,91 | 98,54 | 98,79 | |

| Производитетльнось/Цена | 86,7 | 93,26 | 100 | 95,66 |

| Технические характеристики | ||||

| Чипсет | NVIDIA GeForce RTX 2070 | NVIDIA GeForce RTX 2070 | NVIDIA GeForce RTX 2070 | NVIDIA GeForce RTX 2070 |

| Техпроцесс чипсета, нм | 12 | 12 | 12 | 12 |

| Тип и объем памяти, ГБ | GDDR6, 8 | GDDR6, 8 | GDDR6, 8 | GDDR6, 8 |

| Конструкция системы охлаждения | фирменная | фирменная | фирменная | фирменная |

| Количество вентиляторов системы охлаждения | 3 | 3 | 2 | 2 |

| Количество занимаемых слотов | 3 | 3 | 2 | 3 |

| Субъективная оценка шумности охлаждения | Отлично | Отлично | Хорошо | Отлично |

| Номинальная частота GPU | 1410 | 1410 | 1410 | 1410 |

| Boost-частота GPU | 1815 | 1815 | 1755 | 1830 |

| Результирующая частота памяти, МГц | 14000 | 14142 | 14000 | 14000 |

| Шина памяти, бит | 256 | 256 | 256 | 256 |

| Требует дополнительного питания? | да | да | да | да |

| Тип разъема доп. питания | 6pin+8pin | 6pin+8pin | 6pin+8pin | 6pin+8pin |

| Количество выходов HDMI/DisplayPort/USB Type-C | 2/2/1 | 3/3/1 | 1/3/1 | 2/2/1 |

ASUS ROG Strix GeForce RTX 2070 OC edition (ROG-STRIX-RTX2070-O8G-GAMING)

Представленная в тесте ASUS ROG Strix GeForce RTX 2070 OC edition на данный момент является самой мощной, в плане частоты GPU, и продвинутой среди всех видеокарт ASUS на базе RTX 2070 .

Она имеет традиционный для ASUS ROG Strix дизайн, который практически не изменился со времен прошлого поколения.

Устройство получилось довольно крупным и в системе займет три слота расширения.

Тут используется модифицированная плата с конфигурацией фаз питания 10+2 и фирменная система охлаждения с тремя вентиляторами.

Как заявляется, вентиляторы имеют специальную конструкцию, а внутренности защищены от пыли. Кстати, направление вращения всех вентиляторов одинаковое.

Массивный радиатор СО пронизан шестью тепловыми трубками. Подошва теплоприемника имеет особую обработку, которую ASUS называет технологией MaxContact.

При осмотре ASUS ROG Strix GeForce RTX 2070 OC edition (ROG-STRIX-RTX2070-O8G-GAMING) со всех сторон обнаруживаются любопытные детали.

На плате установлены сразу две микросхемы BIOS с немного измененными режимами работы платы. Один из них (Performance) предусматривает повышенную эффективность охлаждения, что достигается более высокими скоростями работы вентиляторов, а второй (Quiet) рассчитан на более тихую эксплуатацию. Выбор BIOS осуществляется специальным переключателем.

Кстати, полная остановка вентиляторов при малой нагрузке становится доступна только при использовании варианта BIOS с режимом Quiet.

На торце выведена специальная кнопка для быстрого отключения/включения подсветки. Это неплохое решение, когда надо погасить свечение без использования фирменного ПО.

Также на плате предусмотрена площадка для ручного измерения напряжения RAM, GPU, PLL и набор контактов для подключения светодиодной ленты и корпусных вентиляторов. Скорость вращения этих вентиляторов можно связать с температурой GPU. Это классная функция.

На одной из сторон ASUS ROG Strix GeForce RTX 2070 OC edition можно заметить контакты для подключения светодиодной ленты и корпусных вентиляторов

Частота памяти в данной модели соответствует референсной, а вот Boost-частота GPU повышена очень значительно - с 1620 до 1815 МГц.

В результате ASUS ROG Strix GeForce RTX 2070 OC edition находится среди лидеров теста по производительности. Превзойти Gigabyte AORUS GeForce RTX 2070 XTREME 8G и MSI GeForce RTX 2070 GAMING Z 8G по скорости не удалось, так как все три модели, включая ASUS, имеют похожие рабочие частоты. Уж очень сильные видеокарты участвуют в тесте.

Мониторинг работы ASUS ROG Strix GeForce RTX 2070 OC edition в приложении MSI Afterburner

При работе под нагрузкой в наших условиях температура GPU составила всего 57 ° C . Для всех тестов производительности и замера температуры использовался BIOS с режимом Performance.

Учитывая довольно высокое энергопотребление видеокарты, это просто великолепный результат. К слову, это самое низкое значение температуры среди всех тестируемых видеокарт на базе RTX 2070 в этом тесте.

Скорость вращения вентиляторов составила около 1600 об/мин. При работе видеокарта не будет создавать шумовой дискомфорт.

При использовании автоматического разгона с изначальными настройками максимальная частота GPU почти достигла отметки 2100 МГц.

ASUS ROG Strix GeForce RTX 2070 OC edition позволяет увеличить предел энергопотребления до 125%. Это самое высокое значение в тесте.

Система подсветки состоит из нескольких элементов с RGB-подсветкой на передней панели, светящимся логотипом ASUS ROG по боку и еще одним крупным логотипом, выведенным на заднюю пластину.

Работой подсветки, разумеется, можно управлять. Доступны ряд эффектов, а также возможность смены цвета в зависимости от температуры GPU.

Особенность: цвет свечения может меняться, но одновременно все элементы подсветки имеют один и тот же цвет.

Весьма неплохо, но сегодня уже есть и более продвинутые решения, в том числе и среди участников теста. Подсветка видеокарт Gigabyte AORUS и MSI оказалась еще более крутой.

Фирменное ПО ASUS по возможностям примерно представляет собой объединение MSI Afterburner и GPU-Z

ASUS ROG Strix GeForce RTX 2070 OC edition - это очень мощная видеокарта на базе RTX 2070 с просто-таки отличной по эффективности системой охлаждения.

Она находится среди лидеров по производительности, имеет ряд любопытных дополнительных функций в виде двух микросхем BIOS, контактов для вентиляторов корпуса и светодиодной ленты.

Но при всех своих достоинствах, ASUS ROG Strix GeForce RTX 2070 OC edition обладает и самой высокой стоимости среди других участников теста на базе RTX 2070.

Оценка ASUS ROG Strix GeForce RTX 2070 OC edition (ROG-STRIX-RTX2070-O8G-GAMING):

Отличная система охлаждения

Предел энергопотребления выше чем у других участников

Двойной BIOS

Контакты для подключения RGB светодиодных лент и вентиляторов корпуса

— самая высокая стоимость

— большие габариты

— сравнительно скромная комплектация

Если видеокарты ASUS ROG Strix в новом поколении выглядят почти также, как и в предыдущем, то MSI свою серию GAMING видоизменила существенно .

Узнаваемый дизайн с преобладанием красного цвета и вставками, напоминающими когти дракона, решили больше не использовать.

Модель хоть и не такая длинная, но широкая и в системе займет место трех слотов расширения.

MSI GeForce RTX 2070 GAMING Z 8 G (внимание на приставку Z в названии) выделяется более высокими частотами по сравнению с близнецами MSI GeForce RTX 2070 GAMING X 8 G и MSI GeForce RTX 2070 GAMING 8 G и является самой быстрой RTX 2070 у компании MSI на данный момент.

Плата типично для серии GAMING переработанная. Распаяна конфигурация фаз питания 8+2. СО состоит из двух вентиляторов и мощного радиатора с шестью тепловыми трубками.

Если присмотреться, то в каждом вентиляторе чередуются лопасти двух видов. Технология носит название TORX FAN 3.0. В сочетании с новым дизайном рассеивающих пластин радиатора это, по информации производителя, будет способствовать лучшей эффективности.

Система охлаждения и вправду оказалась очень эффективной.

Зафиксированная температура под нагрузкой - 66 °C. Но удивило другое. Данная температура держится при скорости вращения вентилятора всего 1100 об./мин.

В результате видеокарта работает очень тихо . По эффективности охлаждения MSI превзошла других участников кроме, пожалуй, ASUS ROG Strix GeForce RTX 2070 OC edition. Но с СО ASUS сравнивать сложно. С одной стороны, у конкурента более низкая температура, а с другой - это достигается при заметно более высоких оборотах вентиляторов.

Boost-частоте GPU видеокарты MSI GeForce RTX 2070 GAMING Z 8G составляет 1830 МГц. Это самое высокое значение среди всех участников теста. Но превосходство над ASUS ROG Strix GeForce RTX 2070 OC edition и Gigabyte AORUS GeForce RTX 2070 XTREME 8G совсем мизерное. У этих видеокарт данное значение составляет 1815 МГц.

Частота памяти, при этом, стандартная. Логично, что RTX 2070 GAMING Z 8G оказалась среди лидеров по производительности. При автоматическом разгоне максимальная частота доходит до отметки 2100 МГц.

Кривые зависимости частоты и напряжения графического процессора Характеристики MSI GeForce RTX 2070 GAMING Z 8G (данные приложения GPU-Z) со стандартными настройками (сверху) и после автоматического разгона

Доступный лимит энергопотребления - 111%.

Очень порадовала новая система подсветки данной видеокарты . Светящимися участками по периметру окружили вентиляторы. Подсвечивается и логотип на боку.

Все дело в том, как тут реализованы динамические эффекты. В некоторых режимах это, своего рода, цветовое шоу. Хотя тут и нет светящегося элемента на задней пластине данная подсветка MSI понравилась больше, чем решение у ASUS.

В комплекте с видеокартой поставляется дополнительная планка для более надежного крепежа видеокарты в корпусе. Видеокарта действительно увесистая, но, на наш взгляд, большой необходимости в такой планке нет. Вероятно, она не помешает, при транспортировке корпуса.

Планка прикручивается в корпусе компьютера ниже видеокарты после чего устройство опирается на эту планку через мягкие прокрадки

MSI GeForce RTX 2070 GAMING Z 8G отличается и высоким заводским разгоном, и отличной по эффективности системой охлаждения, и интересной новой подсветкой. Хорошая получилась модель.

Оценка MSI GeForce RTX 2070 GAMING Z 8G:

Отличная система охлаждения

Отключение вентиляторов при низкой нагрузке

Значительно повышенные частоты GPU

Продвинутая система RGB-подсветки

Дополнительная планка крепления в комплекте

— большие габариты

Gigabyte AORUS GeForce RTX 2070 XTREME 8G (GV-N2070AORUS X-8GC)

Даже по сравнению с другими крупными видеокартами в тесте Gigabyte AORUS GeForce RTX 2070 XTREME 8G оказывается еще массивнее.

Gigabyte AORUS GeForce RTX 2070 XTREME 8G слева

Но основной вклад в толщину устройства вносит не радиатор СО, а довольно любопытное размещение вентиляторов.

Они расположены немного внахлест. За счет этого, при умеренной длине, удалось разместить сразу три 100-миллиметровых вентилятора .

Gigabyte AORUS GeForce RTX 2070 XTREME 8 G является самой быстрой RTX 2070 у Gigabyte .

Boost частота составляет 1815 МГц, что, впрочем, сравнимо с тестируемыми ASUS ROG Strix GeForce RTX 2070 OC edition и MSI GeForce RTX 2070 GAMING Z 8G.

Любопытно, что заводской разгон получила и память. Во всех остальных видеокартах RTX 2070 данного теста частоты памяти соотвествуют референсным.

Но прибавка по памяти в случае с AORUS GeForce RTX 2070 XTREME 8G чисто номинальная и мало влияет на итоговую производительность. Частоту подняли со стандартной 14 000 до 14 140.

Производительность Gigabyte AORUS GeForce RTX 2070 XTREME 8G оказалась на уровне видеокарт MSI и ASUS.

Используя автоматический разгон максимальное значение частоты GPU составило около 2100. Что примерно повторяет результаты MSI и ASUS.

Кривые зависимости частоты и напряжения графического процессора Gigabyte AORUS GeForce RTX 2070 XTREME 8G со стандартными настройками (сверху) и после автоматического разгона

Доступный для изменения максимальный лимит энергопотребления - 109%.

Конфигурация фаз системы питания - 10+2.

В отличие от других участников, в конструкции системы охлаждения вместо полированной пластины или испарительной камеры используется вариант, когда сами тепловые трубки касаются GPU.

Всего тепловых трубок пять.

Производитель обращает отдельное внимание, что центральный вентилятор имеет другое направление вращения по сравнению с крайними. Указано, что это позволяет избежать турбулентности и увеличивает эффективность СО.

Умеет модель и останавливать вентиляторы при низкой нагрузке. На боковой панели, традиционно для Gigabyte, даже выведена подсвечиваемая надпись “Fan Stop”, которая загорается, когда вентиляторы бездействуют.

Как такая СО показала себя в деле?

Зафиксированные значения температуры и оборотов вентиляторов под нагрузкой составили 67 °C при 1700 об./мин. Очень неплохо, но, получается, что эффективность СО участвующих в тесте ASUS ROG Strix GeForce RTX 2070 OC edition и MSI GeForce RTX 2070 GAMING Z 8G немного выше.

Система подсветки в Gigabyte AORUS GeForce RTX 2070 XTREME 8G устроена очень необычно.

На краю одной из лопастей каждого вентилятора размещен RGB-диод. Этот диод может менять цвет в зависимости от того, в каком секторе круга он находится при вращении вентилятора . Получаемые эффекты впечатляют.

Видеокарта действительно способна привлечь немало внимания.

Дополнительно подсвечиваются логотипы, размещенные на лицевой, обратной сторонах и на боку видеокарты.

Из-за того, что подсветка AORUS GeForce RTX 2070 XTREME 8G связана с вращением вентиляторов обнаружились и не очень приятные особенности. Во-первых, эффекты с кольцами работают только при работающих вентиляторах. Во-вторых, заметно небольшое мерцание. Второй недостаток, впрочем, выражен не так существенно. Если видеокарта не находится постоянно в вашем поле зрения, неудобств не будет.

У видеокарты Gigabyte AORUS GeForce RTX 2070 XTREME 8G оказалось самое большое количество видеовыходов вреди других видеокарт на базе RTX 2070 в этом обзоре

В комплекте обнаружилась ножка для надежной фиксации видеокарты в корпусе. Да, видеокарта увесистая, но острой необходимости в такой дополнительной поддержке, на наш взгляд, нет.

К слову, уровень материалов и обработки у этой ножки просто изумительные.

Неужели такого рода аксессуары становится трендом для видеокарт высокого класса?

Резюмируя, можно сказать, что Gigabyte AORUS GeForce RTX 2070 XTREME 8G выделяется не только значительным заводским разгоном, но и довольно смелым дизайном в сочетании с любопытной системой подсветки.

Это очень достойный соперник для других мощнейших участников данного теста.

Оценка Gigabyte AORUS GeForce RTX 2070 XTREME 8G (GV-N2070AORUS X-8GC):

Эффективная система охлаждения

Отключение вентиляторов при низкой нагрузке

Значительно повышенные частоты GPU

Эффектная система RGB-подсветки

Дополнительная ножка крепления в комплекте

— большие габариты

— Эффекты системы подсветки зависят от того, вращаются вентиляторы или нет

Inno3D GeForce RTX 2070 Gaming OC X2 (N20702-08D6X-2511683)

Inno3D GeForce RTX 2070 Gaming OC X2 - это далеко не рядовая модель. Тут и заводской разгон GPU, и фирменная система охлаждения, и подсветка с RGB-элементами.

Но на фоне других видеокарт GeForce RTX 2070 из данного теста, а это оказались очень продвинутые модели, она выглядит скромнее.

Видеокарта от Inno3 D единственная в тесте занимает не три, а два слота расширения.

Радиатор содержит четыре тепловые трубки и обдувается парой вентиляторов.

Учитывая более скромный класс устройства, по эффективности охлаждения Inno3D GeForce RTX 2070 Gaming OC X2 ожидаемо уступила другим участникам теста.

Мониторинг работы Inno3D GeForce RTX 2070 Gaming OC X2 в приложении MSI Afterburner

Под нагрузкой температура составила 66 °C. Это более чем комфортный уровень, но обороты вентиляторов при этом оказались на уровне 2050 об/мин, что заметно выше, чем у представленных видеокарт ASUS, Gigabyte, MSI.

Соответственно, Inno3D GeForce RTX 2070 Gaming OC X2 работает не так тихо, но уровень ее шума большого дискомфорта создавать не должен.

Видеокарта умеет останавливать вентиляторы при низкой нагрузке, но делает это несколько своеобразно. Перед окончательной остановкой вентиляторы еще пару десятков раз раскручиваются от 0 до, примерно, 600 об./мин. Вполне возможно, что этот «баг» может быть решен в новой версии прошивки, хотя и сейчас существенной проблемой это не является.

На гистограмме видно, как вентиляторы перед полной остановкой некоторое время «пульсирует» со скоростью от 0 до 600 об/мин.

Boost-частота GPU повышена со стандартных 1620 до 1755 МГц. Это неплохой заводской разгон, но, опять-таки, конкуренты оказались уж слишком мощными и у них этот параметр еще выше.

Как результат, Inno3D GeForce RTX 2070 Gaming OC X2 немного уступила соперникам по производительности.

Если проанализировать полученную кривую частоты GPU/напряжения при автоматическом разгоне, то можно увидеть, что максимальная частота GPU примерно на 50 МГц ниже чем у других видеокарт RTX 2070 в тесте при заданных значениях напряжений.

Кривые зависимости частоты и напряжения графического процессора Inno3D GeForce RTX 2070 Gaming OC X2 со стандартными настройками (сверху) и после автоматического разгона

Подсветкой в Inno3D GeForce RTX 2070 Gaming OC X2 оснащены несколько элементов. На лицевой панели логотип Inno3D подсвечивается белым цветом. Зажигаются также и желтые вставки рядом с этим логотипом. А вот логотип Inno3D на боку может светиться уже любым цветом (RGB-подсветка).

Доступно управление подсветкой при помощи приложения.

Да, Inno3D GeForce RTX 2070 Gaming OC X2 несколько уступила соперникам в скорости и в эффективности системы охлаждения. Но для многих это все может быть запросто нивелировано тем, что Inno3 D GeForce RTX 2070 Gaming OC X2 отличается заметно более доступной стоимостью и по соотношению производительности и цены она переигрывает всех других участников данного теста .

А еще у Inno3D GeForce RTX 2070 Gaming OC X2 весьма продвинутая комплектация. Модель поставляется с игровым ковриком и ключами для тестов VRMark, 3DMark.

Оценка Inno3D GeForce RTX 2070 Gaming OC X2 (N20702-08D6X-2511683):

Наилучший баланс стоимости и производительности среди всех видеокарт на базе RTX 2070 в тесте

Отключение вентиляторов при низкой нагрузке

Заводской разгон GPU

Интересная комплектация

— сравнительно скромная подсветка

— странное поведение вентиляторов при переходе в режим остановки

Как мы тестировали видеокарты

Видеокарты работали с использованием изначальных настроек драйверов, оптимизированные игровые профили не применялись.

Видеокарты тестировались без разгона и без использования фирменных профилей (OC, Gaming, Silence и т. д.), которые иногда доступны при установке фирменного программного обеспечения.

Тестируемые видеокарты на базе RTX 20170 мы сравнивали с видеоадаптерами прошлого поколения на базе GTX 1080 и GTX 1080 Ti, в роли которых выступили MSI GeForce GTX 1080 GAMING X 8G и Gigabyte GeForce GTX 1080 Ti Gaming OC 11G.

В качестве тестовых приложений для определения производительности видеокарт мы использовали современные игры с поддержкой DirectX 11 и DirectX 12, которые имеют встроенные бенчмарки. Также в программу вошли популярные синтетические тесты 3DMark.

В каждой игре применялись максимальные или близкие к максимальным настройки графики. В играх мы использовали разрешение 2560×1440 и 3840×2160 пикс. (4K-разрешение). В 3DMark 11 видеокарты тестировались с предустановкой Extreme, а в 3DMark (2013) использовались тесты Fire Strike Extreme, Fire Strike Ultra и DirectX 12-тест Time Spy.

Отслеживание максимальной температуры GPU и энергопотребления системы (без монитора) производилось в игре Metro: Last Light. Именно в этой игре видеокарты, по наблюдениям, нагревались наиболее интенсивно и происходило максимальное энергопотребление.

Сама система эксплуатировалась вне корпуса ПК (открытый стенд) при температуре в помещении около 21 °C. Уровень шума, создаваемый работой систем охлаждения видеокарт, оценивался субъективно.

Итоговая оценка в категории «Производительность» определялась на базе всех тестов с равнозначным вкладом каждого теста. При этом, если говорить об играх, для уменьшения влияния зависимости от процессора, при подсчете общей производительности (категория «Производительность») учитывались только результаты с разрешением 3840×2160 пикс. (4 K ) .

Результаты с разрешением 2560×1440 пикс. приведены для ознакомления.

Гистограммы нормированы в процентах с сортировкой моделей по результатам тестов. Конкретные результаты в виде баллов и FPS также указаны.

Стоимость видеокарт указана на базе данных крупных интернет-магазинов (на момент публикации) с сайта Hotline.

В отдельном тесте Final Fantasy XV benchmark проводились эксперименты с технологией DLSS (см. гистограмму выше).

Конфигурация тестовой платформы:

Процессор: Intel Core i7-3770K, разогнанный до 4,4 МГц

Материнская плата: Biostar Hi-Fi Z77X

Объем оперативной памяти: 4×4 ГБ DDR3 1600

Накопители: SSD (система), HDD

Операционная система: Windows 10 Pro 64 бит

Монитор: Philips 272P7VPTKEB с разрешением 4K

Используемый драйвер NVIDIA для всех видеокарт: GeForce 416.94

Результаты тестов

Выводы

Как видно по результатам тестов, если сравнивать с решениями прошлого поколения, производительность новых видеокарт на базе RTX 2070 находится между NVIDIA GeForce GTX 1080 и GTX 1080 Ti ближе к GTX 1080.

Тройка ASUS ROG Strix GeForce RTX 2070 OC edition, Gigabyte AORUS GeForce RTX 2070 XTREME 8G и MSI GeForce RTX 2070 GAMING Z 8G - это очень «навороченные» видеокарты. Они имеют продвинутые системы подсветки, значительно повышенные частоты GPU.

Разницу в скорости между ними без специальных тестов вы точно не заметите. По эффективности систем охлаждения в этой тройке лидируют модели от ASUS и MSI.

ASUS позволяет сильнее других увеличить лимит энергопотребления. Эта же модель, кстати, выделяется и самой высокой стоимостью среди всех участников теста.

По впечатлениям от работы подсветки Gigabyte AORUS и MSI можно поставить несколько выше, чем ASUS. Inno3D тут в аутсайдерах.

Представленная в тесте Inno3D GeForce RTX 2070 Gaming OC X2 скромнее на фоне тройки ASUS, Gigabyte AORUS и MSI, хотя тоже далеко не рядовая модель. Она имеет более низкие частоты GPU, не такую продвинутую систему охлаждения и уступит по возможностям подсветки и разгона.

Но, зато, данная модель от Inno3D и самая доступная по цене. По соотношению производительности и стоимости она превосходит других участников теста.

Разница в скорости между Inno3D и тройкой ASUS, Gigabyte AORUS, MSI есть, но она не такая и существенная. Если есть желание сэкономить - это очень достойный вариант.

С самими участниками теста полный порядок. Любая видеокарта из теста - это качественное устройство с высокой производительностью, эффективным охлаждением без каких-то существенных недостатков.

Но новое поколение видеокарт RTX в целом оставляет целый ряд поводов для раздумий, хотя именно переход к RTX производитель называет революционным.

Если не «копать» сильно далеко в прошлое и взять во внимание переходы от поколения GTX 700 к GTX 900 (серия 800 в десктопных видеокартах была пропущена) и от GTX 900 к GTX 1000, то всегда новое поколение видеокарт отличалось сильно возросшей производительностью с одновременным значительным улучшением энергопотребления. При этом большого скачка стоимости равнозначных моделей не происходило.

А что же мы видим сейчас с выходом поколения NVIDIA GeForce RTX?

Да, рост производительности есть, но он не такой заметный, как это было ранее с новым поколением видеокарт.

По энергоэффективности новинки лучше моделей GTX 1000, но совсем незначительно.

А еще вы заметили, что в поколении RTX не произошло роста объема видеопамяти?

Но главное, что новые видеокарты оказались намного дороже своих предшественников .

Причем, ожидать значительного снижения стоимости видеокарт NVIDIA RTX довольно сложно. Они получили намного более сложные и дорогие в производстве графические процессоры.

Проблема в том, что значительная часть усложнений в новых GPU пошла на используемые впервые RT -ядра (аппаратная поддержка трассировки лучей), которые пока мало где можно задействовать . Кстати, на момент выхода видеокарт RTX игр с аппаратной поддержкой трассировки не было вовсе!

И тут еще большой вопрос, стоят ли те изменения в изображении, которые привносит трассировка лучей, очень серьезного падения производительности, происходящего при активации этой функции.

Получается, что на данный момент по соотношению производительности и стоимости новинки RTX 2000 уступают видеокартам-предшественникам серии GTX 1000 (прошлое поколение на архитектуре Pascal).

Да, потенциально RTX 2000 могут наращивать свою привлекательность со временем, с появлением большего количества игр, поддерживающих трассировку лучей и DLSS-сглаживание, но пока об этом говорить рано.

Благодарим компанию Philips за предоставленный 4K-монитор Philips 272P7VPTKEB

Активность производителей наборов логики в последнее время просто удивляет. Чипсеты выходят одним за другим и, честно говоря, мы с трудом успеваем доводить до наших читателей все подробности об архитектуре и производительности этих новинок. Действительно, если еще в недалеком прошлом вся конкурентная борьба на рынке чипсетов происходила по большей части только между VIA и Intel, то за последнее время к ним присоединились AMD, SiS и ALi, которые начали выпуск вполне конкурентоспособных продуктов. Однако, похоже, это еще далеко не все. На рынок системных чипсетов теперь пытаются выйти совсем новые игроки. Например, весной этого года о выпуске своего первого чипсета для материнских плат объявила компания NVIDIA, до сих пор производившая исключительно графические чипсеты.

По заявлению представителей NVIDIA, настроенных крайне оптимистично, для компании разрабатывающей 3D ускорители, в состав которых входит подчас несколько десятков миллионов транзисторов, проектирование системной логики – задача крайне простоя. Тем более, что NVIDIA была разработчиком базового набора микросхем для игровой приставки от Microsoft, X-BOX, являющейся почти что полноценным PC. Однако, как оказалось, не все так просто. Несмотря на то, что NVIDIA обещала начало поставок материнских плат и систем на базе набора логики собственного изготовления еще в августе, только сейчас эти платы стали появляться в продаже. Ну а раз так, пришла пора провести всестороннее тестирование этого нового чипсета.

Первый чипсет от NVIDIA, названный nForce и поддерживающий Socket A процессоры от AMD, представляет собой интегрированный набор логики со встроенным графическим ядром GeForce2 MX. Однако и как дискретный набор логики nForce представляет значительный интерес, так как в нем реализовано несколько интересных технологий, в первую очередь относящихся к контроллеру памяти, поддерживающему DDR SDRAM. Поэтому, мы построим рассмотрение nForce следующим образом: сначала поговорим об особенностях nForce, как обычного чипсета, а затем отдельно исследуем его графическое ядро, звуковой контроллер и другие подобные возможности.

Основы

Семейство новых чипсетов от NVIDIA, nForce включает в себя два продукта, отличающихся реализацией шины памяти. Одной из ключевых особенностей nForce является так называемая TwinBank архитектура: nForce в общем случае имеет два независимых контроллера памяти, работающих с DDR SDRAM. Соответственно, в зависимости от числа задействованных контроллеров памяти, nForce позволяет организовать либо 64-битный доступ к памяти, либо двухканальный 128-битный.Набор логики NVIDIA nForce состоит из двух микросхем, называемых в терминологии производителя «процессорами». Северный мост, Integrated Graphics Processor (IGP), объединяет в себе контроллер памяти, интегрированное графическое ядро GeForce2 MX, поддерживающий процессоры семейства Athlon/Duron интерфейс и AGP 4x интерфейс для подключения внешних видеокарт. Для того, чтобы отличать северные мосты с 64-битной шиной памяти и двухканальной 128-битной шиной, NVIDIA использует для них различную маркировку, IGP-128 и IGP-64 соответственно.

Южный мост, Media and Communication Processor (MCP) содержит аппаратный звуковой контроллер Audio Processor Unit (APU) с аппаратной поддержкой Dolby Digital, встроенный сетевой контроллер, PCI-контроллер, а также поддерживает типичные для современных южных мостов возможности: USB 1.1 порты, ATA-100 интерфейс, AC’97 интерфейс и т.п. Аналогично северным мостам, NVIDIA прелагает также и две версии южного моста: MCP-D с Dolby Digital 5.1 кодером и MCP – без него.

Северный и южный мосты в nForce соединяются последовательной шиной HyperTransport с топологией точка-точка.

Для лучшего понимания сравним возможности nForce с возможностями других современных DDR - наборов логики (возможности встроенной графики в рассмотрение пока не берутся).

* Версия южного моста, поддерживающего ATA-133 поставляется производителям материнских плат опционально.

Итак, глядя на представленную таблицу, можно отметить, что основными инновациями, реализованными в nForce являются:

Контроллер памяти, реализующий технологию TwinBank, позволяющую организацию двухканального 128-битного доступа к памяти. Отдельно следует отметить еще одну уникальную особенность этого контроллера, наличие Dynamic Adaptive Speculative Pre-Processor (DASP).

Использование шины HyperTransport для связи северного и южного моста.

Высокопроизводительное интегрированное графическое ядро GeForce2 MX.

Встроенный Audio Processing Unit (APU), аппаратный звуковой процессор совместимый с DirectX 8.0 и имеющий встроенный Dolby Digital 5.1 кодер.

В зависимости от того, в какой комбинации используются северные и южные мосты nForce, версия чипсета может иметь различные наименования:

Теоретически, как уже говорилось, nForce во многом повторяет набор системной логики, который NVIDIA спроектировала по заказу Microsoft для игровой приставки XBOX. Однако, необходимо понимать, что чипсет, используемый в игровой приставке поддерживает процессоры с архитектурой P3 и, соответственно, имеет отличную от nForce процессорную шину. Intel не предоставил NVIDIA лицензии на использование своих процессорных шин в наборах системной логики, поэтому, NVIDIA свой первый чипсет ориентировала под Socket A процессоры от AMD. Однако, не исключено что данная ситуация может измениться, и компания будет предлагать также и чипсеты под платформу Pentium 4: тут все в конечном итоге зависит от желания Intel.

Подробности: контролер памяти

Одной из главных особенностей nForce, выделяющей его по сравнению с другими наборами логики, является инновационный контроллер DDR памяти, позволяющий организацию двух независимых каналов передачи данных с суммарной шириной шины 128 бит. С учетом того, что набор микросхем nForce поддерживает память типа PC2100/PC1600 DDR SDRAM, пиковая пропускная способность подсистемы памяти у этого чипсета может достигать 4.2 Гбайт в секунду. То есть, среди всех сегодняшних наборов логики, ориентированных на применение в настольных PC, nForce обеспечивает наибольшую пропускную способность памяти, так как все остальные чипсеты имеют 64-битную шину памяти.Посмотрим на то, как все это работает. nForce реализует так называемую TwinBank архитектуру. Это означает, что контроллер памяти, примененный в этом наборе логики, по сути напоминает Croosbar контроллер видеочипсета GeForce3 и попросту является расщепленным на два независимых контроллера MC0 и MC1.

То есть, для получения высокой пропускной способности подсистемы памяти NVIDIA не стала изобретать для своего набора логики новые типы памяти, а просто добавила в свой чипсет еще один контроллер DDR SDRAM. Следует отметить, что контроллеры MC0 и MC1 являются равноправными и полностью независимыми, поэтому они способны обрабатывать запросы одновременно. В результате, суммарная ширина шины памяти достигла 128 бит, однако в целом подсистема памяти nForce, благодаря наличию двух контроллеров памяти, осталась оптимизирована для работы с 64-битными пакетами данных. Это немаловажный факт, поскольку процессорная шина, используемая в Socket A системах, также имеет ширину 64 бита.

Благодаря равноправности и полной независимости MC0 и MC1, nForce позволяет работу с ассиметричными конфигурациями памяти, устанавливаемой на разные каналы. Например, модули DIMM, работающие с MC0 и MC1 могут иметь разную скорость, разную конфигурацию и разный объем. Более того, можно вообще не задействовать один из каналов, оставив второй контроллер памяти неиспользуемым. Как раз именно благодаря этому, NVIDIA с легкостью предлагает производителям материнских плат два варианта своего северного моста: IGP-128 с двумя контроллерами памяти и IGP-64 с одним незадействованным контроллером.

Преимущество TwinBank архитектуры nForce кажется очевидным. Значительный рост пропускной способности, казалось бы, должен обеспечить значительное превосходство в производительности этого набора логики над конкурентами. Однако, не все тут так просто, как кажется. Пиковая пропускная способность подсистемы памяти nForce составляет 4.2 Гбайт/с и в два раза превосходит пропускную способность процессорной шины 2.1 Гбайт/с. А это значит, что процессор сам по себе оказывается не в состоянии задействовать весь потенциал шины памяти nForce. Как мы видели на примере набора логики VIA Apollo Pro266, подобный перекос в пропускных способностях шин ни к чему хорошему не приводит: производительность по сравнению с системами, где пропускные способности шин памяти и процессора уравновешены, практически не возрастает.

Но инженеры NVIDIA оснастили nForce двумя контроллерами памяти все-таки неспроста. Не следует забывать о том, что nForce – это все же в первую очередь интегрированный чипсет, и высокие требования к пропускной способности памяти в системах на его основе будет предъявлять не только CPU, но и встроенное графическое ядро. Благодаря TwinBank архитектуре, подразумевающей наличие двух независимых 64-битных контроллеров памяти, графическое ядро и процессор могут работать с памятью независимо. А учитывая то, что графическое ядро, основанное на архитектуре GeForce2 MX, обладает сравнительно высоким быстродействием, необходимость производительной шины памяти становится очевидной.

Тем не менее, говорить о том, что 128-битная шина памяти nForce может быть задействована только лишь при использовании интегрированной графики не совсем верно. Теоретически, напрямую к памяти, минуя процессор, могут обращаться и некоторые другие устройства. Например, AGP-видеокарты или контроллеры, встроенные в южный мост чипсета. Для этих устройств, хотя они и не столь требовательны к пропускной способности памяти, архитектура TwinBank также может принести определенные дивиденды. Таким образом, если рассматривать nForce, как обычный неинтегрированный набор логики, наличие двух контроллеров памяти может позволить получить выигрыш в производительности в некоторых приложениях, интенсивно работающих с AGP графикой или использующих потоковые операции ввода-вывода с данными большого объема. В остальных случаях TwinBank архитектура, рассматриваемая отдельно от встроенного графического ядра, ряд ли может оказаться полезной.

Более того, если наличие двух независимых каналов памяти теоретически позволяет увеличить скорость записи данных в память, благодаря использованию техники чередования каналов, то операции чтения из памяти ускорятся далеко не всегда. Наоборот, из-за необходимости при каждом обращении «искать» данные в обоих банках, латентность подсистемы памяти, по сравнению с одноканальными системами, возрастает. О том, какое значение имеет латентность подсистемы памяти, говорилось уже не раз. Нередко более низкая латентность имеет для производительности в реальных приложениях даже большее значение, чем высокая пропускная способность памяти. А это значит, что nForce 220, в котором используется северный мост IGP-64 с одним каналом памяти, теоретически даже может превзойти по быстродействию nForce 420 с IGP-128 и двумя каналами.

Понятно, что подобные принципы распространяются не только на наборы логики от NVIDIA. И, если бы не некоторые дополнительные технологии, о которых пойдет речь ниже, двухканальный nForce вполне мог бы отставать не только от своего одноканального собрата, но и от DDR-чипсетов других производителей. Естественно, NVIDIA, привыкшую быть лидером во всем, такой расклад совершенно не устраивал. Поэтому, перед инженерами компании была поставлена задача найти путь к уменьшению латентности подсистемы памяти при операциях чтения.

И это решение было найдено. В NVIDIA nForce был добавлен дополнительный блок, имеющий название DASP – Dynamic Adaptive Speculative Pre-Processor. Задача DASP состоит в мониторинге обращений процессора к памяти и предсказанию, какие данные могут потребоваться CPU впоследствии. Используя возможности 128-битной шины памяти с двумя независимыми контроллерами, DASP параллельно с работой процессора извлекает эти данные из памяти и размещает их в специальном буфере, находящемся в северном мосту чипсета. В результате, в случае правильного предсказания, процессору при обращении к этим данным не приходится осуществлять доступ к памяти с относительно большой латентностью: необходимые данные уже находятся в чипсете. Поэтому, DASP существенно снижает латентность подсистемы памяти.

Как можно заметить, DASP представляет собой некий аналог технологии Data Prefetch, реализованной в современных процессорах. Однако DASP по сравнению с Data Prefetch имеет важное преимущество – его работа не сопряжена с дополнительной загрузкой процессорной шины. А поскольку шина памяти, которую загружает DASP, у nForce узким местом не является, работа этого блока не вызывает никаких коллизий, связанных с чрезмерной загрузкой каких-либо каналов передачи данных в чипсете.

Важно понимать, что DASP в nForce обрабатывает исключительно обращения процессора, а данные, которые могут требоваться, например, графическому ядру или внешней AGP-видеокарте в буфер не попадают. Этим устройствам, поскольку они гораздо менее критичны к высокой латентности памяти, нежели CPU, приходится работать с памятью напрямую.

Именно DASP, а не TwinBank архитектура является главной технологией, влияющей на производительность nForce. При использовании с nForce внешней графической карты высокая пропускная способность шины памяти оказывается практически бесполезной, потому что процессор задействовать ее в полную силу не может из-за ограничений, накладываемых пропускной способностью процессорной шины. Современные же AGP-видеокарты используют для хранения текстур локальную видеопамять, поэтому с системной памятью они взаимодействуют не активно. DASP же позволяет уменьшить латентность подсистемы памяти независимо ни от чего. И единственное, о чем приходится жалеть – это о небольшом размере буфера, используемого DASP. В современной версии nForce его объем составляет всего 64 Кбайта, но и этого оказывается вполне достаточно для того, чтобы nForce показывал великолепную производительность.

Подробности: Hypertransport