A cuda processzorok számának összehasonlítása. CUDA Rollunk: NVIDIA CUDA technológia. A CUDA fejlesztési története

Arra tervezték, hogy a gazdakódot (fő, vezérlőkód) és az eszközkódot (hardverkódot) (.cu kiterjesztésű fájlok) objektumfájlokká fordítsa, amelyek alkalmasak a végső program vagy könyvtár felépítésére bármilyen programozási környezetben, például NetBeans.

A CUDA architektúra a grid memóriamodellt, a fürtszálakat és a SIMD utasításokat használja. Nemcsak a nagy teljesítményű grafikus számítástechnikára alkalmazható, hanem az nVidia grafikus kártyákat használó különféle tudományos számítástechnikákra is. A tudósok és kutatók széles körben használják a CUDA-t számos területen, beleértve az asztrofizikát, a számítógépes biológiát és a kémiát, a folyadékdinamikai szimulációkat, az elektromágneses kölcsönhatásokat, a számítógépes tomográfiát, a szeizmikus elemzést stb. A CUDA képes OpenGL és Direct3D használatával alkalmazásokhoz csatlakozni. A CUDA egy többplatformos szoftver olyan operációs rendszerekhez, mint a Linux, Mac OS X és Windows.

2010. március 22-én az nVidia kiadta a CUDA Toolkit 3.0-t, amely OpenCL támogatást is tartalmazott.

Felszerelés

A CUDA Platform először a nyolcadik generációs NVIDIA G80 chip kiadásával jelent meg a piacon, és jelen lett a GeForce, Quadro és NVidia Tesla gyorsítócsaládokban használt összes későbbi grafikus chip-sorozatban.

A CUDA SDK-t támogató hardverek első sorozata, a G8x egy 32 bites egyprecíziós vektorprocesszort tartalmazott, amely API-ként a CUDA SDK-t használta (a CUDA támogatja a C double típust, de most a pontosságát 32 bites lebegőre csökkentették pont). A későbbi GT200 processzorok támogatják a 64 bites pontosságot (csak SFU-hoz), de a teljesítmény lényegesen rosszabb, mint a 32 bitesé (annak oka, hogy minden stream multiprocesszorhoz csak két SFU, és nyolc skalár processzor van) . A GPU megszervezi a hardveres többszálú működést, amely lehetővé teszi az összes GPU erőforrás használatát. Így megnyílik a lehetőség egy fizikai gyorsító funkcióinak grafikus gyorsítóra való áthelyezésére (a megvalósításra példa az nVidia PhysX). Szintén széles lehetőségek kínálkoznak a számítógép grafikus berendezéseinek alkalmazására összetett, nem grafikus számítások elvégzésére: például a számítási biológiában és más tudományágakban.

Előnyök

Az általános célú számítástechnika grafikus API-k képességein keresztül történő megszervezésének hagyományos megközelítéséhez képest a CUDA architektúra a következő előnyökkel rendelkezik ezen a területen:

Korlátozások

- Az eszközön végrehajtott összes funkció nem támogatja a rekurziót (a CUDA Toolkit 3.1-ben támogatja a mutatókat és a rekurziót), és van néhány egyéb korlátozás is.

Támogatott GPU-k és grafikus gyorsítók

Az Nvidia berendezésgyártó termékeinek listája, amelyek teljes mértékben támogatják a CUDA technológiát, az Nvidia hivatalos webhelyén található: CUDA-Enabled GPU Products.

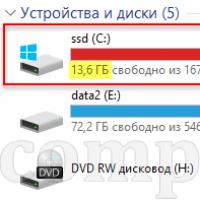

Valójában a PC-hardver piacon ma a következő perifériák támogatják a CUDA technológiát:

| Specifikációs verzió | GPU | Videokártyák |

|---|---|---|

| 1.0 | G80, G92, G92b, G94, G94b | GeForce 8800GTX / Ultra, 9400GT, 9600GT, 9800GT, Tesla C / D / S870, FX4 / 5600, 360M, GT 420 |

| 1.1 | G86, G84, G98, G96, G96b, G94, G94b, G92, G92b | GeForce 8400GS / GT, 8600GT / GTS, 8800GT / GTS, 9600 GSO, 9800GTX / GX2, GTS 250, GT 120/30/40, FX 4/570, 3/580, 17/18,2x,3700x,3700 / 370M, 3/5 / 770M, 16/17/27/28/36/37 / 3800M, NVS420 / 50 |

| 1.2 | GT218, GT216, GT215 | GeForce 210, GT 220/40, FX380 LP, 1800M, 370 / 380M, NVS 2 / 3100M |

| 1.3 | GT200, GT200b | GeForce GTX 260, GTX 275, GTX 280, GTX 285, GTX 295, Tesla C / M1060, S1070, Quadro CX, FX 3/4/5800 |

| 2.0 | GF100, GF110 | GeForce (GF100) GTX 465, GTX 470, GTX 480, Tesla C2050, C2070, S / M2050 / 70, Quadro Plex 7000, Quadro 4000, 5000, 6000, GTX 470, GTX 560, GTX 560, GTX 510, 80 |

| 2.1 | GF104, GF114, GF116, GF108, GF106 | GeForce 610M, GT 430, GT 440, GTS 450, GTX 460, GTX 550 Ti, GTX 560, GTX 560 Ti, 500M, Quadro 600, 2000 |

| 3.0 | GK104, GK106, GK107 | GeForce GTX 690, GTX 680, GTX 670, GTX 660 Ti, GTX 660, GTX 650 Ti, GTX 650, GT 640, GeForce GTX 680MX, GeForce GTX 680M, GeForce GTX 675MX, GeForce GTX 675MX, GeForce GTX 675MX, GeForce GTX 675MX, GeFor7 660 675MX0 GeForce GT 645M, GeForce GT 640M |

| 3.5 | GK110 |

|

|

|

|

|

- A Tesla C1060, Tesla S1070, Tesla C2050 / C2070, Tesla M2050 / M2070, Tesla S2050 modellek segítségével dupla pontossággal végezhet számításokat GPU-n.

Különböző változatok jellemzői és specifikációi

| Funkciótámogatás (a listán nem szereplő funkciók minden számítási képességhez támogatott) |

Számítási képesség (verzió) | ||||

|---|---|---|---|---|---|

| 1.0 | 1.1 | 1.2 | 1.3 | 2.x | |

32 bites szavak a globális memóriában |

Nem | Igen | |||

lebegőpontos értékek a globális memóriában |

|||||

| Egész számú atomi függvények működése 32 bites szavak megosztott memóriában |

Nem | Igen | |||

| atomicExch () 32 biten működik lebegőpontos értékek a megosztott memóriában |

|||||

| Egész számú atomi függvények működése 64 bites szavak a globális memóriában |

|||||

| Warp szavazási funkciók | |||||

| Dupla pontosságú lebegőpontos műveletek | Nem | Igen | |||

| 64 biten működő atomi függvények egész értékek a megosztott memóriában |

Nem | Igen | |||

| Lebegőpontos atomi összeadás működik 32 bites szavak a globális és megosztott memóriában |

|||||

| _ballot () | |||||

| _threadfence_system () | |||||

| _syncthreads_count (), _syncthreads_and (), _syncthreads_or () |

|||||

| Felületi funkciók | |||||

| Menetblokk 3D rácsja | |||||

| Műszaki adatok | Számítási képesség (verzió) | ||||

|---|---|---|---|---|---|

| 1.0 | 1.1 | 1.2 | 1.3 | 2.x | |

| A menetblokkok rácsának maximális mérete | 2 | 3 | |||

| A menetblokkok rácsának maximális x-, y- vagy z-dimenziója | 65535 | ||||

| A menetblokk maximális mérete | 3 | ||||

| Egy blokk maximális x- vagy y-dimenziója | 512 | 1024 | |||

| Egy blokk maximális z-mérete | 64 | ||||

| A szálak maximális száma blokkonként | 512 | 1024 | |||

| Warm mérete | 32 | ||||

| A rezidens blokkok maximális száma többprocesszoronként | 8 | ||||

| A rezidens vetemítések maximális száma többprocesszoronként | 24 | 32 | 48 | ||

| A rezidens szálak maximális száma többprocesszoronként | 768 | 1024 | 1536 | ||

| 32 bites regiszterek száma többprocesszoronként | 8 K | 16 K | 32 K | ||

| A megosztott memória maximális mennyisége többprocesszoronként | 16 KB | 48 KB | |||

| Megosztott memóriabankok száma | 16 | 32 | |||

| A helyi memória mennyisége szálanként | 16 KB | 512 KB | |||

| Állandó memóriaméret | 64 KB | ||||

| Gyorsítótár munkakészlet többprocesszoronként az állandó memória érdekében | 8 KB | ||||

| Gyorsítótár munkakészlet többprocesszoronként textúra memóriához | Eszközfüggő, 6 KB és 8 KB között | ||||

| Maximális szélesség 1D textúrához |

8192 | 32768 | |||

| Maximális szélesség 1D textúrához lineáris memóriához kötött referencia |

2 27 | ||||

| Maximális szélesség és rétegek száma 1D réteges textúra referenciához |

8192 x 512 | 16384 x 2048 | |||

| Maximális szélesség és magasság 2D-hez textúra referencia kötve lineáris memória vagy CUDA tömb |

65536 x 32768 | 65536 x 65535 | |||

| Maximális szélesség, magasság és szám rétegek 2D réteges textúra referenciához |

8192 x 8192 x 512 | 16384 x 16384 x 2048 | |||

| Maximális szélesség, magasság és mélység lineárishoz kötött 3D textúra referenciához memória vagy CUDA tömb |

2048 x 2048 x 2048 | ||||

| A textúrák maximális száma, amely kernelhez köthető |

128 | ||||

| Maximális szélesség 1D felülethez hivatkozás CUDA tömbhöz van kötve |

Nem támogatott |

8192 | |||

| Maximális szélesség és magasság 2D-hez CUDA tömbhöz kötött felületi hivatkozás |

8192 x 8192 | ||||

| A felületek maximális száma kernelhez köthető |

8 | ||||

| Az utasítások maximális száma per kernel |

2 millió | ||||

Példa

CudaArray * cu_array; struktúra< float , 2 >tex; // Tömb lefoglalása cudaMalloc (& cu_array, cudaCreateChannelDesc< float>(), szélesség magasság); // Képadatok másolása a cudaMemcpy tömbbe (cu_array, kép, szélesség * magasság, cudaMemcpyHostToDevice); // Kösd a tömböt a textúrához cudaBindTexture (text, cu_array); // Kernel dim3 futtatása blockDim (16, 16, 1); dim3 gridDim (szélesség / blockDim.x, magasság / blockDim.y, 1); kernel<<< gridDim, blockDim, 0 >>> (d_adat, szélesség, magasság); cudaUnbindTexture (text); __global__ void kernel (float * odata, int magasság, int szélesség) (előjel nélküli int x = blockIdx.x * blockDim.x + threadIdx.x; unsigned int y = blockIdx.y * blockDim.y + threadIdx.y; float c = texfetch (tex, x, y); odata [y * szélesség + x] = c;)

A pycuda.driver importálása drv-ként import numpy drv.init () dev = drv.Device (0) ctx = dev.make_context () mod = drv.SourceModule ( "" "__global__ void multiply_them (float * dest, float * a, float * b) (const int i = threadIdx.x; dest [i] = a [i] * b [i];)" "") multiply_them = mod.get_function ("multiply_them") a = numpy.random .randn (400) .astype (numpy.float32) b = numpy.random .randn (400) .astype (numpy.float32) dest_like = numpy. (a) multiply_them (drv.Out (dest), drv.In (a), drv.In (b), blokk = (400, 1, 1)) print dest-a * b

A CUDA mint tantárgy az egyetemeken

2009 decembere óta a CUDA programozási modellt 269 egyetemen oktatják szerte a világon. Oroszországban a CUDA képzési kurzusokat a Szentpétervári Politechnikai Egyetemen, a V.I.-ről elnevezett Jaroszlavli Állami Egyetemen oktatják. PG Demidov, Moszkva, Nyizsnyij Novgorod, Szentpétervár, Tver, Kazan, Novoszibirszk, Novoszibirszki Állami Műszaki Egyetem Omszki és Permi Állami Egyetemek, Nemzetközi Társadalom és Man „Dubna” Természettudományi Egyetem, Ivanovo Állami Energiamérnöki Egyetem, Belgorodi Állami Egyetem, MSTU őket. Bauman, RKhTU őket. Mengyelejev, Interregional Supercomputer Center RAS,. Ezenkívül 2009 decemberében bejelentették, hogy elindult az első orosz tudományos és oktatási központ, a "Parallel Computing", amely Dubna városában található, és amelynek feladatai közé tartozik a GPU-n történő összetett számítási problémák megoldására vonatkozó képzés és tanácsadás.

Ukrajnában a CUDA kurzusokat a Kijevi Rendszerelemző Intézetben oktatják.

Linkek

Hivatalos források

- CUDA Zone (orosz) - a CUDA hivatalos oldala

- CUDA GPU Computing – A CUDA számítástechnikával foglalkozó hivatalos webfórumok

Nem hivatalos források

Tom hardvere- Dmitrij Csekanov. nVidia CUDA: GPU számítástechnika vagy CPU halál? ... Tom "s Hardware (2008. június 22.). Archivált

- Dmitrij Csekanov. nVidia CUDA: GPU-benchmarkok a mainstream piac számára. Tom "s Hardware (2009. május 19.). Archiválva: 2012. március 4. Letöltve: 2009. május 19.

- Alekszej Berillo. NVIDIA CUDA – Nem grafikus számítástechnika GPU-kon. 1. rész . iXBT.com (2008. szeptember 23.). Az eredetiből archiválva: 2012. március 4. Letöltve: 2009. január 20.

- Alekszej Berillo. NVIDIA CUDA – Nem grafikus számítástechnika GPU-kon. 2. rész . iXBT.com (2008. október 22.). - Példák az NVIDIA CUDA megvalósítására. Az eredetiből archiválva: 2012. március 4. Letöltve: 2009. január 20.

- Boreskov Alekszej Viktorovics. CUDA Fundamentals (2009. január 20.). Az eredetiből archiválva: 2012. március 4. Letöltve: 2009. január 20.

- Vlagyimir Frolov. Bevezetés a CUDA technológiába. "Számítógépes grafika és multimédia" hálózati magazin (2008. december 19.). Az eredetiből archiválva: 2012. március 4. Letöltve: 2009. október 28..

- Igor Oszkolkov. Az NVIDIA CUDA a megfizethető jegy a nagy számítástechnika világába. Computerra (2009. április 30.). Letöltve: 2009. május 3.

- Vlagyimir Frolov. Bevezetés a CUDA technológiába (2009. augusztus 1.). Az eredetiből archiválva: 2012. március 4. Letöltve: 2010. április 3.

- GPGPU.ru. Grafikus kártyák használata számítástechnikához

- ... Párhuzamos számítástechnikai központ

Jegyzetek (szerkesztés)

Lásd még

| Nvidia | ||||||||

|---|---|---|---|---|---|---|---|---|

| Grafikus processzorok |

| |||||||

A személyi számítógépeket kis szuperszámítógépekké alakító eszközök már régóta léteznek. Még a múlt század 80-as éveiben kínáltak a piacon úgynevezett transzputereket, amelyeket az akkoriban elterjedt ISA bővítőhelyekbe helyeztek be. Eleinte lenyűgöző volt a teljesítményük a megfelelő feladatokban, de aztán felgyorsult az univerzális processzorok sebességének növekedése, megerősítették pozícióikat a párhuzamos számítástechnikában, és nem volt értelme a transzputereknek. Bár ma is léteznek ilyen eszközök, ezek különféle speciális gyorsítók. De gyakran alkalmazási körük szűk, és az ilyen gyorsítókat nem sok elterjedtségben részesítették.

A közelmúltban azonban a párhuzamos számítástechnika fáklyája a tömegpiacra tolódott el, így vagy úgy, hogy a háromdimenziós játékokkal kapcsolatos. A 3D grafikában használt, általános célú többmagos párhuzamos vektoros számítástechnikai eszközök olyan csúcsteljesítményt érnek el, amelyet az általános célú processzorok nem tudnak. Természetesen a maximális sebességet csak számos kényelmes feladatnál érik el, és vannak korlátai, de az ilyen eszközöket már széles körben használják olyan területeken, amelyekre eredetileg nem készültek. Az ilyen párhuzamos processzorok kiváló példája a Sony-Toshiba-IBM szövetség által kifejlesztett és a Sony PlayStation 3-ban használt Cell processzor, valamint a piacvezetők - az Nvidia és az AMD - összes modern videokártyája.

A Cell-hez ma nem nyúlunk, bár korábban megjelent, és egy univerzális processzor, további vektoros képességekkel, ma nem beszélünk róla. A 3D-s videógyorsítók számára néhány éve megjelent a nem grafikus általános célú számítások első technológiája, a GPGPU (General-Purpose compution on GPUs). Hiszen a modern videochipek több száz matematikai végrehajtási egységet tartalmaznak, és ezzel az erővel számos számításigényes alkalmazást jelentősen fel lehet gyorsítani. A GPU-k jelenlegi generációi pedig kellően rugalmas architektúrával rendelkeznek, amely a magas szintű programozási nyelvekkel, valamint az ebben a cikkben tárgyalt hardver- és szoftverarchitektúrákkal együtt feltárja ezeket a lehetőségeket, és sokkal elérhetőbbé teszi őket.

A GPCPU fejlesztését a kellően gyors és rugalmas shader programok megjelenése ösztönözte, amelyek képesek modern videochipek végrehajtására. A fejlesztők úgy döntöttek, hogy a GPU-val nem csak a 3D-s alkalmazásokban található képet számítják ki, hanem más párhuzamos számításokhoz is felhasználják. A GPGPU-ban ehhez grafikus API-kat használtak: OpenGL-t és Direct3D-t, amikor az adatok textúrák formájában kerültek a videochipbe, a számítási programokat pedig shaderek formájában töltötték be. Ennek a módszernek a hátránya a viszonylag nagy programozási bonyolultság, a CPU és a GPU közötti adatcsere alacsony sebessége és egyéb korlátok, amelyeket az alábbiakban tárgyalunk.

A GPU számítástechnika fejlődött, és nagyon gyorsan fejlődik. A jövőben pedig a videochipek két fő gyártója, az Nvidia és az AMD kifejlesztette és bejelentette a megfelelő platformokat CUDA (Compute Unified Device Architecture) és CTM (Close To Metal vagy AMD Stream Computing) néven. A korábbi GPU-programozási modellektől eltérően ezeket a videokártyák hardveres képességeihez való közvetlen hozzáféréssel hajtották végre. A platformok nem kompatibilisek egymással, a CUDA a C programozási nyelv kiterjesztése, a CTM pedig egy összeállítási kódot végrehajtó virtuális gép. Ehelyett mindkét platform megszüntette a korábbi GPGPU-modellek néhány fontos korlátját a hagyományos grafikus folyamat és a megfelelő Direct3D vagy OpenGL interfészek használatával.

Természetesen az OpenGL-t használó nyílt szabványok tűnnek a leginkább hordozhatónak és univerzálisnak, lehetővé teszik ugyanazon kód használatát a különböző gyártók videochipjeihez. De az ilyen módszereknek sok hátránya van, sokkal kevésbé rugalmasak és nem olyan kényelmesek a használatuk. Ezenkívül nem teszik lehetővé bizonyos videokártyák speciális képességeinek használatát, például a modern számítástechnikai processzorokban található gyors megosztott (megosztott) memóriát.

Ezért az Nvidia kiadta a CUDA platformot – egy C-szerű programozási nyelvet, saját fordítóval és könyvtárakkal a GPU-számításhoz. Természetesen a videochipek optimális kódjának megírása korántsem olyan egyszerű, és ez a feladat sok kézi munkát igényel, de a CUDA csak felfedi az összes lehetőséget, és a programozónak nagyobb irányítást ad a GPU hardveres képességei felett. Fontos, hogy a Geforce 8-as, 9-es és 200-as sorozatú grafikus kártyákban használt G8x, G9x és GT2xx lapkák Nvidia CUDA támogatással rendelkezzenek, amelyek igen elterjedtek. Jelenleg a CUDA 2.0 végleges verziója jelent meg, amely néhány újdonságot tartalmaz, például a dupla pontosságú számítások támogatását. A CUDA 32 bites és 64 bites Linux, Windows és MacOS X operációs rendszereken érhető el.

A CPU és a GPU közötti különbség párhuzamos számításokban

Az univerzális processzorok frekvenciájának növekedése a fizikai korlátokba és a nagy fogyasztásba ütközött, teljesítményük pedig egyre inkább nő a több mag egyetlen chipben való elhelyezése miatt. A jelenleg értékesített processzorok legfeljebb négy magot tartalmaznak (a további növekedés nem lesz gyors), és hétköznapi alkalmazásokhoz készültek, használjon MIMD-t - több utasítás- és adatfolyamot. Mindegyik mag külön működik a többitől, és különböző utasításokat hajt végre a különböző folyamatokhoz.

A négykomponensű (egypontos lebegőpontos) és kétkomponensű (dupla pontosságú) vektorokhoz speciális vektorképességek (SSE2 és SSE3) jelentek meg az általános célú processzorokban, elsősorban a grafikus alkalmazások megnövekedett követelményei miatt. Éppen ezért bizonyos feladatoknál kifizetődőbb a GPU-k használata, mert eredetileg ezekre készültek.

Például az Nvidia videochipekben a fő egység egy többprocesszor, nyolc-tíz maggal és összesen több száz ALU-val, több ezer regiszterrel és kis mennyiségű megosztott memóriával. Ezenkívül a videokártya tartalmaz gyors globális memóriát, amelyhez minden többprocesszor hozzáfér, helyi memóriát minden multiprocesszorban, és speciális memóriát az állandók számára.

A legfontosabb, hogy ezek a többprocesszoros magok a GPU-ban SIMD (egy utasításfolyam, több adatfolyam) magok. És ezek a magok ugyanazokat az utasításokat hajtják végre egyszerre, ez a programozási stílus gyakori a grafikus algoritmusoknál és számos tudományos problémánál, de speciális programozást igényel. Ez a megközelítés azonban lehetővé teszi a végrehajtási egységek számának növelését az egyszerűsítésük miatt.

Tehát soroljuk fel a fő különbségeket a CPU és a GPU architektúrák között. A CPU magokat úgy tervezték, hogy egyetlen szekvenciális utasításfolyamot hajtsanak végre maximális teljesítménnyel, míg a GPU-kat úgy tervezték, hogy gyorsan végrehajtsanak nagyszámú egyidejű utasításfolyamot. Az általános célú processzorokat a nagy teljesítményre optimalizálták egyetlen utasításfolyamból, amely egész számokat és lebegőpontos számokat is kezel. Ebben az esetben a memóriához való hozzáférés véletlenszerű.

A CPU-tervezők a teljesítmény javítása érdekében igyekeznek minél több utasítást párhuzamosan futtatni. Erre a célra az Intel Pentium processzoroktól kezdve megjelent a szuperskaláris végrehajtás, amely óránként két utasítás végrehajtását biztosítja, a Pentium Pro pedig az utasítások rendellenes végrehajtásával tűnt ki. De a szekvenciális utasításfolyam párhuzamos végrehajtásának vannak bizonyos alapvető korlátai, és a végrehajtási egységek számának növelésével a sebesség többszörös növelése nem érhető el.

A videochipek esetében a munka egyszerű és kezdetben párhuzamos. A videochip bemenetként egy sokszögcsoportot vesz fel, elvégzi az összes szükséges műveletet, és a kimeneten pixeleket ad ki. A sokszögek és pixelek feldolgozása független, párhuzamosan, egymástól elkülönítve dolgozhatók fel. Ezért a GPU-ban a munka kezdetben párhuzamos megszervezése miatt nagyszámú végrehajtási egységet használnak, amelyek könnyen betölthetők, ellentétben a CPU szekvenciális utasításaival. Ezenkívül a modern GPU-k egynél több utasítást is végrehajthatnak órajelenként (kettős probléma). Így a Tesla architektúra bizonyos feltételek mellett egyszerre indítja el a MAD + MUL vagy a MAD + SFU műveleteket.

A GPU a memóriaelérésben is különbözik a CPU-tól. A GPU-ban beköthető és könnyen kiszámítható - ha a textúra texelét memóriából olvassuk ki, akkor egy idő után eljön a szomszédos texelek ideje is. Igen, és ugyanaz a dolog felvétel közben - egy pixel kerül a framebufferbe, és néhány óraciklus után rögzítésre kerül a mellette lévő. Ezért a memória felépítése eltér a CPU-ban használttól. A videochipnek pedig az univerzális processzorokkal ellentétben egyszerűen nincs szüksége nagy cache-memóriára, a textúrákhoz pedig csak néhány (akár 128-256 a jelenlegi GPU-ban) kilobyte.

És önmagában a GPU és a CPU memóriájával való munka némileg különbözik. Tehát nem minden központi processzor rendelkezik beépített memóriavezérlővel, és minden GPU-nak általában több vezérlője van, legfeljebb nyolc 64 bites csatorna az Nvidia GT200 chipben. A videokártyákon ráadásul gyorsabb memóriát használnak, és ennek köszönhetően a videochipeknek sokszorosa nagyobb memóriasávszélesség áll rendelkezésre, ami szintén nagyon fontos a hatalmas adatfolyamokkal operáló párhuzamos számításoknál.

Az általános célú processzorokban nagy mennyiségű tranzisztor és chipterület jut utasításpufferekhez, hardverágak előrejelzéséhez és hatalmas mennyiségű chip-gyorsítótárhoz. Mindezekre a hardverblokkokra szükség van néhány utasításfolyam végrehajtásának felgyorsításához. A videochipek tranzisztorokat költenek végrehajtó egységek tömbjeire, áramlásvezérlő egységekre, kis megosztott memóriára és memóriavezérlőkre több csatornára. A fentiek nem gyorsítják fel az egyes szálak végrehajtását, lehetővé teszik, hogy a chip egyidejűleg több ezer szálat dolgozzon fel, amelyek a chipen futnak és nagy memória sávszélességet igényelnek.

A gyorsítótárazás különbségeiről. Az általános célú CPU-k gyorsítótárat használnak a teljesítmény növelésére a memóriaelérési késleltetés csökkentésével, míg a GPU-k gyorsítótárat vagy megosztott memóriát használnak a sávszélesség növelésére. A CPU-k nagy gyorsítótárak és elágazási előrejelzések használatával csökkentik a memóriaelérési késleltetést. Ezek a hardver részek foglalják el a chip területének nagy részét, és sok energiát fogyasztanak. A videochipek megkerülik a memóriaelérési késleltetés problémáját azáltal, hogy egyidejűleg több ezer szálat hajtanak végre – miközben az egyik szál adatra vár a memóriából, a videochip várakozás vagy késleltetés nélkül tud számításokat végezni egy másik szálon.

A többszálú támogatásban is sok különbség van. A CPU processzormagonként 1-2 számítási szálat hajt végre, a videochipek pedig akár 1024 szálat is támogathatnak multiprocesszoronként, amiből több is van a chipben. És ha a CPU egyik száláról a másikra való váltás több száz ciklusba kerül, akkor a GPU több szálat vált át egy ciklus alatt.

Ezenkívül a CPU-k SIMD (egy utasítás végrehajtása több adaton) blokkokat használnak a vektorszámításhoz, a videochipek pedig SIMT-et (egy utasítás és több szál) használnak az adatfolyamok skaláris feldolgozásához. A SIMT nem követeli meg a fejlesztőtől, hogy az adatokat vektorokká alakítsa, és lehetővé teszi az önkényes elágazásokat a folyamokban.

Röviden azt mondhatjuk, hogy a modern általános célú CPU-kkal ellentétben a videochipeket párhuzamos számításokhoz tervezték nagyszámú aritmetikai művelettel. És sokkal nagyobb számú GPU-tranzisztor működik a rendeltetésének megfelelően - adattömböket dolgoz fel, és nem irányítja néhány szekvenciális számítási szál végrehajtását (folyamatvezérlését). Ez a diagram azt mutatja, hogy mennyi helyet foglalnak el a különböző logikák a CPU-ban és a GPU-ban:

Ennek eredményeként a GPU teljesítményének tudományos és egyéb nem grafikus számításokban való hatékony felhasználásának alapja az algoritmusok párhuzamosítása a videochipekben elérhető több száz végrehajtási egységre. Például sok molekuláris modellező alkalmazás tökéletesen alkalmas videochipeken történő számításra, nagy számítási teljesítményt igényel, ezért kényelmes a párhuzamos számításokhoz. A több GPU használata pedig még nagyobb számítási teljesítményt biztosít az ilyen problémák megoldásához.

A GPU-n végzett számítások kiváló eredményeket mutatnak a párhuzamos adatfeldolgozást használó algoritmusok esetében. Vagyis amikor ugyanazt a matematikai műveletsort alkalmazzuk nagy mennyiségű adatra. Ebben az esetben a legjobb eredmény akkor érhető el, ha az aritmetikai utasítások számának aránya a memóriaelérések számához képest elég nagy. Ez kisebb igényt támaszt az áramlásszabályozásra, és a matematika nagy sűrűsége és a nagy mennyiségű adat szükségtelenné teszi a CPU-hoz hasonló nagy gyorsítótárak szükségességét.

A fent leírt különbségek eredményeként a videochipek elméleti teljesítménye jelentősen meghaladja a CPU-ét. Az Nvidia a következő grafikont mutatja be a CPU és a GPU teljesítményének növekedéséről az elmúlt néhány évben:

Természetesen ezek az adatok nem mentesek egy adag ravaszságtól. Valójában CPU-n sokkal könnyebb elméleti számadatokat elérni a gyakorlatban, és a számok GPU esetén egyszeri, CPU esetében pedig dupla pontosságra vannak megadva. Mindenesetre néhány párhuzamos feladatnál elég az egyszeri pontosság, az általános célú és a grafikus processzorok között igen nagy a sebességkülönbség, ezért a játék megéri a fáradságot.

Az első próbálkozások a GPU számítástechnika használatára

Hosszú ideig próbálták párhuzamos matematikai számításokban videochipeket használni. Az ilyen alkalmazásokkal kapcsolatos legkorábbi próbálkozások rendkívül primitívek voltak, és néhány hardverfunkció használatára korlátozódtak, mint például a raszterezés és a Z-pufferelés. De ebben a században, a shaderek megjelenésével, elkezdték felgyorsítani a mátrixszámításokat. 2003-ban a SIGGRAPH-nál külön szakaszt jelöltek ki a GPU-számításra, és ezt GPGPU-nak (General-Purpose computing on GPU) nevezték el.

A leghíresebb BrookGPU a Brook streaming programozási nyelv fordítója, amelyet nem grafikus számítások elvégzésére terveztek a GPU-n. Megjelenése előtt a videochipek számítástechnikai képességeit használó fejlesztők a két gyakori API egyikét választották: a Direct3D-t vagy az OpenGL-t. Ez komolyan korlátozta a GPU-k használatát, mert a 3D grafikában shadereket és textúrákat használnak, amiről a párhuzamos programozási szakembereknek nem kötelező tudniuk, szálakat és magokat használnak. Brook segíteni tudott a feladatuk megkönnyítésében. A Stanford Egyetemen kifejlesztett C nyelv streaming-kiterjesztései elrejtették a háromdimenziós API-t a programozók elől, és a videochipet párhuzamos koprocesszorként mutatták be. A fordító elemezte a .br fájlt C ++ kóddal és kiterjesztéssel, így egy DirectX, OpenGL vagy x86 könyvtárhoz kapcsolt kódot hozott létre.

Természetesen Brook-nak sok hibája volt, amelyeknél megálltunk, és amelyekről az alábbiakban részletesebben fogunk beszélni. De már a megjelenése is jelentős mértékben felkeltette ugyanazon Nvidia és ATI figyelmét a GPU-kon történő számítástechnikai kezdeményezésre, mivel ezeknek a képességeknek a fejlesztése a jövőben komolyan megváltoztatta a piacot, és egy teljesen új szektort nyitott meg - párhuzamos számítógépeken. videó chipeken.

Ezt követően a Brook projekt néhány kutatója csatlakozott az Nvidia fejlesztőcsapatához, hogy bevezessenek egy hardver-szoftver párhuzamos számítási stratégiát, új piaci részesedést nyitva ezzel. Ennek az Nvidia kezdeményezésnek pedig az a fő előnye, hogy a fejlesztők a legapróbb részletekig tisztában vannak GPU-ik minden képességével, és nincs szükség a grafikus API használatára, a hardverrel pedig közvetlenül az illesztőprogram segítségével lehet dolgozni. A csapat erőfeszítéseinek eredménye az Nvidia CUDA (Compute Unified Device Architecture), egy új hardver- és szoftverarchitektúra az Nvidia GPU-n történő párhuzamos számításokhoz, amelyről ez a cikk szól.

A párhuzamos GPU számítástechnika alkalmazásai

A számítások videochipekre való átvitelének előnyeinek megértéséhez itt találja a kutatók által a világ minden tájáról származó átlagos adatokat. Átlagosan a számítástechnika GPU-ra történő átvitelekor sok feladatban a gyorsulás 5-30-szoros a gyors, általános célú processzorokhoz képest. A legnagyobb számokat (nagyságrendileg 100-szoros gyorsulás és még több!) olyan kódban érik el, amely nem túl jól alkalmas SSE blokkokkal történő számításokhoz, de a GPU számára meglehetősen kényelmes.

Ez csak néhány példa a szintetikus kód gyorsítására GPU-n, szemben a CPU-n lévő SSE-vektorizált kóddal (az Nvidia szerint):

- Fluoreszcens mikroszkóp: 12x;

- Molekuladinamika (nem kötött erő számítás): 8-16x;

- Elektrosztatika (közvetlen és többszintű Coulomb halmozás): 40-120x és 7x.

És ez egy olyan lemez, amelyet az Nvidia nagyon szeret, és minden bemutatón megmutatja, amelyen a cikk második részében részletesebben foglalkozunk, a CUDA számítástechnika gyakorlati alkalmazásainak konkrét példáival:

Amint látható, a számok nagyon vonzóak, a 100-150-szeres nyereség különösen lenyűgöző. A következő cikkben a CUDA-ról részletesen le fogunk bontani néhány ilyen számot. Most pedig soroljuk fel azokat a fő alkalmazásokat, amelyekben a GPU számítástechnikát jelenleg használják: kép- és jelelemzés és -feldolgozás, fizikai szimuláció, számítási matematika, számítási biológia, pénzügyi számítások, adatbázisok, gáz- és folyadékdinamika, kriptográfia, adaptív sugárterápia, csillagászat, hangfeldolgozás , bioinformatika, biológiai szimulációk, számítógépes látás, adatbányászat, digitális mozi és televízió, elektromágneses szimulációk, földrajzi információs rendszerek, katonai alkalmazások, bányászati tervezés, molekuláris dinamika, mágneses rezonancia képalkotás (MRI), neurális hálózatok, oceanográfiai kutatás, részecskefizika, fehérje hajtogatás szimuláció, kvantumkémia, sugárkövetés, vizualizáció, radar, tározószimuláció, mesterséges intelligencia, műholdadatok elemzése, szeizmikus feltárás, műtét, ultrahang, videokonferencia.

Számos alkalmazás részletei megtalálhatók az Nvidia weboldalán a szoftverek részében. Mint látható, a lista elég hosszú, de ez még nem minden! Folytatható, és minden bizonnyal feltételezhetjük, hogy a jövőben a videochipeken végzett párhuzamos számítások más alkalmazási területei is megtalálhatók lesznek, amiről még nem sejtettük.

Nvidia CUDA jellemzői

A CUDA technológia az Nvidia szoftveres és hardveres számítási architektúrája a C nyelv kiterjesztése alapján, amely lehetővé teszi a grafikus gyorsító utasításkészletéhez való hozzáférés megszervezését és a memória kezelését a párhuzamos számítások szervezésekor. A CUDA segít olyan algoritmusok megvalósításában, amelyek végrehajthatók a Geforce videógyorsítók nyolcadik generációjának (Geforce 8, Geforce 9, Geforce 200 sorozat), valamint Quadro és Tesla GPU-in.

Bár a GPU-programozás bonyolultsága a CUDA-val meglehetősen magas, alacsonyabb, mint a korábbi GPGPU-megoldásoké. Az ilyen programok megkövetelik az alkalmazás felosztását több többprocesszor között, hasonlóan az MPI programozáshoz, de a megosztott videomemóriában tárolt adatok felosztása nélkül. És mivel az egyes többprocesszoros CUDA-programozás hasonló az OpenMP-programozáshoz, szükséges a memóriaszervezés alapos ismerete. De természetesen a fejlesztés és a CUDA-ra történő portolás összetettsége nagymértékben alkalmazásfüggő.

A fejlesztői készlet számos kódpéldát tartalmaz, és jól dokumentált. A tanulási folyamat körülbelül két-négy hetet vesz igénybe azok számára, akik már ismerik az OpenMP-t és az MPI-t. Az API a kiterjesztett C nyelven alapul, és a kód lefordításához erről a nyelvről a CUDA SDK tartalmazza az Open64 nyílt forráskódú fordítón alapuló nvcc parancssori fordítót.

Soroljuk fel a CUDA főbb jellemzőit:

- egységes hardver és szoftver megoldás az Nvidia videochipeken történő párhuzamos számításokhoz;

- támogatott megoldások széles skálája, a mobiltól a multichipig

- szabványos C programozási nyelv;

- Standard Numerical Analysis Libraries FFT (Fast Fourier Transform) és BLAS (Lineáris Algebra)

- optimalizált adatcsere a CPU és a GPU között;

- interakció az OpenGL és DirectX grafikus API-kkal;

- 32 és 64 bites operációs rendszerek támogatása: Windows XP, Windows Vista, Linux és MacOS X;

- az alacsony szintű fejlődés képessége.

Az operációs rendszerek támogatásával kapcsolatban hozzá kell tenni, hogy minden nagyobb Linux disztribúció hivatalosan támogatott (Red Hat Enterprise Linux 3.x / 4.x / 5.x, SUSE Linux 10.x), de a rajongók adataiból ítélve A CUDA remekül működik más összeállításokon: Fedora Core, Ubuntu, Gentoo stb.

A CUDA fejlesztői környezet (CUDA Toolkit) a következőket tartalmazza:

- nvcc fordító;

- FFT és BLAS könyvtárak;

- profilozó;

- gdb hibakereső GPU-hoz;

- CUDA futásidejű illesztőprogram a szabványos Nvidia illesztőprogramokhoz

- programozási útmutató;

- CUDA Developer SDK (forrás, segédprogramok és dokumentáció).

A forráskód példáiban: párhuzamos bitonikus rendezés, mátrix transzpozíció, nagy tömbök párhuzamos prefix összegzése, képkonvolúció, diszkrét wavelet transzformáció, példa az OpenGL és a Direct3D interakciójára, a CUBLAS és CUFFT könyvtárak használata, az opció árának kiszámítása (Black képlete Scholes, binomiális modell, Monte Carlo módszer), párhuzamos véletlenszám generátor Mersenne Twister, nagy tömb hisztogram számítása, zajcsökkentés, Sobel szűrő (határok keresése).

A CUDA előnyei és korlátai

A programozó szemszögéből a grafikus csővezeték feldolgozási szakaszok gyűjteménye. A geometria blokk háromszögeket, a raszterblokk pedig a monitoron megjelenő képpontokat generálja. A hagyományos GPGPU programozási modell így néz ki:

A számítások GPU-kra való átviteléhez egy ilyen modell keretein belül speciális megközelítésre van szükség. Még két vektor elemenkénti összeadásához is meg kell rajzolni az alakzatot a képernyőre vagy egy képernyőn kívüli pufferre. Az alakzat raszterezett, az egyes pixelek színét a megadott program szerint (pixel shader) számítjuk ki. A program minden pixelhez kiolvassa a bemeneti adatokat a textúrákból, hozzáadja azokat és a kimeneti pufferbe ír. És mindezekre a számos műveletre szükség van ahhoz, amit egy hétköznapi programozási nyelvben egyetlen operátor ír le!

Emiatt a GPGPU általános célú számítástechnikai célokra való felhasználásának korlátai vannak, mivel túl sok nehézséget okoz a fejlesztők képzésében. És van még elég megkötés, mert a pixel shader csak egy képlet a végső pixelszín koordinátától való függésére, a pixel shader nyelv pedig egy olyan nyelv, amellyel ezeket a képleteket C-szerű szintaxissal írhatjuk. A korai GPGPU technikák egy trükkös trükk a GPU erejének kihasználására, de minden kényelem nélkül. Az ott található adatokat képek (textúrák) reprezentálják, az algoritmust pedig a raszterizálási folyamat. Meg kell jegyezni egy nagyon specifikus memória- és végrehajtási modellt is.

Az Nvidia GPU-számítástechnikai hardver- és szoftverarchitektúrája abban különbözik a korábbi GPGPU-modellektől, hogy lehetővé teszi a GPU-k számára való programok írását valós C-ben szabványos szintaxissal, mutatókkal, valamint minimális bővítmény szükséges a videochipek számítási erőforrásainak eléréséhez. A CUDA független a grafikus API-któl, és rendelkezik néhány olyan funkcióval, amelyet kifejezetten az általános számítástechnikához terveztek.

A CUDA előnyei a GPGPU számítástechnika hagyományos megközelítésével szemben:

- a CUDA alkalmazásprogramozási felülete a szabványos C programozási nyelven alapszik kiterjesztésekkel, ami leegyszerűsíti a CUDA architektúra tanulásának és megvalósításának folyamatát;

- A CUDA többprocesszoronként 16 KB-os megosztott memóriához biztosít hozzáférést, amely a textúra mintáknál szélesebb sávszélességű gyorsítótár létrehozására használható;

- hatékonyabb adatátvitel a rendszer és a videomemória között

- nincs szükség redundanciával és többletköltséggel rendelkező grafikus API-kra;

- lineáris memóriacímzés, valamint összegyűjtés és szóródás, tetszőleges címekre való írás képessége;

- hardveres támogatás egész és bit műveletekhez.

A CUDA fő korlátai:

- az elvégzett funkciók rekurziós támogatásának hiánya;

- minimális blokkszélesség 32 menet;

- Zárt architektúra CUDA, az Nvidia tulajdona.

A korábbi GPGPU módszereket használó programozás gyengeségei, hogy ezek a módszerek nem használnak vertex shader végrehajtási egységeket a korábbi, nem egységes architektúrákban, az adatok textúrákban tárolódnak, hanem a képernyőn kívüli pufferbe kerülnek, a több lépéses algoritmusok pedig pixel shadert használnak. egységek. A GPGPU korlátozásai a következők lehetnek: a hardver képességeinek elégtelen használata, a memória sávszélességének korlátozása, a szórt műveletek hiánya (csak gyűjtés), a grafikus API kötelező használata.

A CUDA fő előnyei a korábbi GPGPU-módszerekkel szemben abból a tényből fakadnak, hogy ezt az architektúrát a nem grafikus számítástechnika hatékony felhasználására tervezték a GPU-n, és a C programozási nyelvet használja anélkül, hogy az algoritmusokat a koncepciónak megfelelő formába kellene átvinni. egy grafikus csővezetékről. A CUDA a GPU-számítás egy új módját kínálja, amely nem használ grafikus API-kat, és véletlenszerű hozzáférést biztosít a memóriához (szórt vagy gyűjtöget). Ez az architektúra mentes a GPGPU hátrányaitól, és minden végrehajtási egységet használ, valamint bővíti a képességeket az egész szám matematikai és biteltolási műveletei miatt.

Ezenkívül a CUDA megnyit néhány olyan hardverképességet, amely nem érhető el a grafikus API-kból, például a megosztott memóriát. Ez egy kis mennyiségű memória (többprocesszoronként 16 kilobájt), amelyhez szálblokkokkal lehet hozzáférni. Lehetővé teszi a leggyakrabban elért adatok gyorsítótárazását, és nagyobb sebességet biztosít, mint a textúralekérések használata ehhez a feladathoz. Ez viszont számos alkalmazásban csökkenti a párhuzamos algoritmusok sávszélesség-érzékenységét. Például hasznos a lineáris algebra, az FFT és a képfeldolgozó szűrőkhöz.

Kényelmesebb a CUDA-ban és a memóriaelérésben. A grafikus API programkódja 32 egyszeres pontosságú lebegőpontos érték (RGBA értékek egyidejűleg nyolc renderelési célpontban) formájában bocsát ki adatokat előre meghatározott területekre, a CUDA pedig támogatja a szórt rögzítést – korlátlan számú rekord bármilyen címet. Ezek az előnyök lehetővé teszik néhány olyan algoritmus GPU-n történő végrehajtását, amelyet nem lehet hatékonyan megvalósítani grafikus API-kon alapuló GPGPU-módszerekkel.

Ezenkívül a grafikus API-k szükségszerűen textúrákban tárolják az adatokat, ami megköveteli a nagy tömbök előzetes textúrákba történő csomagolását, ami bonyolítja az algoritmust és speciális címzés alkalmazását kényszeríti ki. A CUDA pedig lehetővé teszi az adatok olvasását bármilyen címen. A CUDA másik előnye az optimalizált adatcsere a CPU és a GPU között. Azoknak a fejlesztőknek pedig, akik alacsony szintű hozzáférést szeretnének elérni (például egy másik programozási nyelv írásakor), a CUDA alacsony szintű assembly nyelvű programozás lehetőségét kínálja.

A CUDA fejlesztési története

A CUDA fejlesztését a G80 chippel 2006 novemberében jelentették be, a CUDA SDK nyilvános bétaverziója pedig 2007 februárjában jelent meg. Az 1.0-s verzió 2007 júniusában jelent meg a G80 chipre épülő Tesla megoldások piacra dobásához, amelyeket a nagy teljesítményű számítástechnikai piacra szántak. Aztán az év végén megjelent a CUDA 1.1 béta verziója, amely a verziószám enyhe növekedése ellenére is elég sok újdonságot hozott.

A CUDA 1.1 újdonsága a CUDA funkció beépítése a szokásos Nvidia video-illesztőprogramokba. Ez azt jelentette, hogy bármely CUDA program követelményei között elegendő volt egy Geforce 8 vagy újabb videokártya megadása, valamint a minimális illesztőprogram 169.xx verziója. Ez nagyon fontos a fejlesztők számára, ha ezek a feltételek teljesülnek, a CUDA programok bármelyik felhasználó számára működni fognak. Ezenkívül hozzáadta az aszinkron végrehajtást, valamint az adatok másolását (csak G84, G86, G92 és magasabb chipekhez), aszinkron adatátvitelt a videomemóriába, az atomi memória hozzáférési műveleteket, a 64 bites Windows-verziók támogatását és a többcsipes CUDA működésének lehetőségét SLI-ben. mód.

Jelenleg a Geforce GTX 200 sorozattal együtt megjelent a GT200 - CUDA 2.0 alapú megoldások aktuális verziója, a béta verzió még 2008 tavaszán jelent meg. A második verzió kiegészítve: támogatja a dupla pontosságú számításokat (csak hardveres támogatás a GT200-hoz), végül támogatott Windows Vista (32 és 64 bites verziók) és Mac OS X, hozzáadott hibakereső és profilozó eszközök, támogatott 3D textúrák, optimalizált adatátvitel.

Ami a kettős pontosságú számításokat illeti, ezek sebessége a jelenlegi hardvergeneráción többszöröse az egyszeri pontosságnak. Az okokat a mi cikkünkben tárgyaljuk. Ennek a támogatásnak a megvalósítása a GT200-ban abban rejlik, hogy az FP32 blokkokat nem használják az eredmény négyszer kisebb sebességgel történő eléréséhez; az FP64 számítások támogatására az Nvidia úgy döntött, hogy dedikált számítási blokkokat készít. A GT200-ban pedig tízszer kevesebb van belőlük, mint az FP32 blokkokból (egy dupla precíziós blokk minden multiprocesszorhoz).

A valóságban a teljesítmény még kisebb is lehet, hiszen az architektúra 32 bites memóriából és regiszterekből történő olvasásra van optimalizálva, ráadásul a grafikus alkalmazásoknál nincs szükség dupla pontosságra, a GT200-ban pedig inkább egyszerűvé teszik. A modern négymagos processzorok pedig nem sokkal kisebb valódi teljesítményt mutatnak. De mivel még 10-szer lassabb, mint az egyszeri precizitás, ez a támogatás hasznos vegyes precíziós kialakításokhoz. Az egyik elterjedt technika az, hogy a kezdeti közelítési eredményeket egyszeres pontossággal kapjuk meg, majd dupla pontossággal finomítjuk. Most ezt közvetlenül a videokártyán is megteheti anélkül, hogy közbenső adatokat küldene a CPU-nak.

A CUDA 2.0 másik hasznos funkciója furcsa módon nem kapcsolódik a GPU-hoz. Mostanra lehetséges a CUDA-kódok rendkívül hatékony, többszálú SSE-kódokká való fordítása a CPU-n történő gyors végrehajtás érdekében. Vagyis most ez a funkció nem csak hibakeresésre alkalmas, hanem valós használatra is Nvidia videokártya nélküli rendszereken. Hiszen a CUDA normál kódban való használatát korlátozza, hogy az Nvidia videokártyák, bár a legnépszerűbbek a dedikált videómegoldások között, nem minden rendszerben elérhetőek. A 2.0-s verzió előtt pedig ilyen esetekben két különböző kódot kellett készíteni: a CUDA-hoz és külön a CPU-hoz. És most bármilyen CUDA programot végrehajthat nagy hatékonysággal egy CPU-n, bár kisebb sebességgel, mint a videochipeken.

Megoldások Nvidia CUDA támogatással

Minden CUDA-kompatibilis grafikus kártya segíthet a legigényesebb feladatok felgyorsításában, a hang- és képfeldolgozástól az orvostudományig és a tudományos kutatásig. Az egyetlen valódi korlát az, hogy sok CUDA-program legalább 256 megabájt videomemóriát igényel, ami a CUDA-alkalmazások egyik legfontosabb műszaki specifikációja.

A CUDA-kompatibilis termékek naprakész listájáért látogasson el ide. A cikk írásakor a CUDA számításai támogatták a Geforce 200, Geforce 9 és Geforce 8 sorozat összes termékét, beleértve a Geforce 8400M-től kezdődő mobiltermékeket, valamint a Geforce 8100, 8200 és 8300 lapkakészleteket is. minden Tesla: S1070, C1060, C870, D870 és S870.

Külön megjegyezzük, hogy az új Geforce GTX 260 és 280 grafikus kártyákkal együtt bejelentették a megfelelő megoldásokat a nagy teljesítményű számítástechnika számára: a Tesla C1060 és S1070 (a fenti képen látható), amelyeket idén ősszel lehet megvásárolni. A GPU ugyanaz bennük - GT200, a C1060-ban egy, az S1070-ben - négy. De a játékmegoldásoktól eltérően minden chiphez négy gigabájt memóriát használnak. Az egyetlen hátránya az alacsonyabb memóriafrekvencia és memória sávszélesség, mint a játékkártyáknál, amelyek chipenként 102 GB / s-t biztosítanak.

Nvidia CUDA névsor

A CUDA két API-t tartalmaz: magas szintű (CUDA Runtime API) és alacsony szintű (CUDA Driver API), bár nem lehet mindkettőt egyszerre használni egy programban, vagy az egyiket, vagy a másikat kell használni. A magas szintű az alacsony szintű "felül" működik, minden futásidejű hívás egyszerű utasításokká alakul, amelyeket az alacsony szintű Driver API dolgoz fel. De még a "magas szintű" API is feltételez ismereteket az Nvidia videochipek felépítéséről és működéséről, ott nincs túl magas szintű absztrakció.

Van még egy szint, még magasabb - két könyvtár:

CUBLAS- A BLAS (alapvető lineáris algebrai alprogramok) CUDA verziója, amelyet lineáris algebrai problémák kiszámítására és a GPU-erőforrásokhoz való közvetlen hozzáférésre terveztek;

BIZTOSÍTÁS- A Fast Fourier Transform könyvtár CUDA változata a gyors Fourier transzformáció kiszámításához, amelyet széles körben használnak a jelfeldolgozásban. A következő transzformációs típusok támogatottak: komplex-komplex (C2C), valós-komplex (R2C) és komplex-valós (C2R).

Nézzük meg közelebbről ezeket a könyvtárakat. A CUBLAS a CUDA nyelvre lefordított szabványos lineáris algebrai algoritmusok, jelenleg csak az alapvető CUBLAS függvények bizonyos készlete támogatott. A könyvtár használata nagyon egyszerű: a videokártya memóriájában létre kell hozni egy mátrixot és vektorobjektumokat, ezeket feltölteni adatokkal, meghívni a szükséges CUBLAS függvényeket, majd a videomemóriából vissza kell tölteni az eredményeket a rendszermemóriába. A CUBLAS speciális funkciókat tartalmaz a GPU-memóriában lévő objektumok létrehozására és megsemmisítésére, valamint adatok ebbe a memóriába történő olvasására és írására. Támogatott BLAS-függvények: 1., 2. és 3. szint valós számokhoz, 1. szintű CGEMM a komplex számokhoz. Az 1. szint a vektor-vektor műveletek, a 2. szint a vektor-mátrix műveletek, a 3. szint a mátrix-mátrix műveletek.

Cufft - a Fast Fourier Transform funkció CUDA változata - széles körben használt és nagyon fontos jelelemzésben, szűrésben stb. A CUFFT egyszerű felületet biztosít az FFT hatékony kiszámításához az Nvidia GPU-kon anélkül, hogy saját GPU FFT-t kellene kifejlesztenie. Az FFT CUDA verziója támogatja az összetett és valós adatok 1D, 2D és 3D átalakításait, kötegelt végrehajtást több 1D transzformációhoz párhuzamosan, a 2D és 3D transzformációk méretezhetők, 1D-hez akár 8 millió elem is támogatott.

CUDA programozási alapismeretek

A további szöveg megértéséhez meg kell értenie az Nvidia videochipek alapvető építészeti jellemzőit. A GPU több textúrafeldolgozó klaszterből áll. Mindegyik klaszter textúra minták kinagyított blokkjából és két vagy három streaming multiprocesszorból áll, amelyek mindegyike nyolc számítástechnikai eszközből és két szuperfunkcionális blokkból áll. Minden utasítás a SIMD-elv szerint fut, amikor egy utasítást alkalmazunk a warp összes szálára (a textiliparból származó kifejezés, a CUDA-ban ez egy 32 szálból álló csoport - a többprocesszorok által feldolgozott minimális adatmennyiség). Ezt a végrehajtási módot SIMT-nek (egy utasítás több szál) hívták.

A többprocesszorok mindegyike rendelkezik bizonyos erőforrásokkal. Tehát van egy speciális, 16 kilobájtnyi megosztott memória többprocesszoronként. De ez nem gyorsítótár, mivel a programozó bármilyen igényre használhatja, például a Cell processzorok SPU-jában a Local Store-t. Ez a megosztott memória lehetővé teszi az információcserét ugyanazon blokk szálai között. Fontos, hogy egy blokk összes szálát mindig ugyanaz a multiprocesszor hajtsa végre. És a különböző blokkokból származó adatfolyamok nem cserélhetnek adatot, és emlékeznie kell erre a korlátozásra. A megosztott memória gyakran hasznos, kivéve, ha több szál is hozzáfér ugyanahhoz a memóriabankhoz. A többprocesszorok is hozzáférhetnek a videomemóriához, de nagyobb késleltetéssel és rosszabb sávszélességgel. A hozzáférés felgyorsítása és a videomemória elérésének gyakoriságának csökkentése érdekében a többprocesszorok 8 kilobájt gyorsítótárral rendelkeznek az állandók és a textúraadatok számára.

A többprocesszor 8192-16384 (a G8x / G9x és GT2xx esetén) regisztereket használ, amelyek közösek a rajta végrehajtott összes blokk összes adatfolyamában. A blokkok maximális száma többprocesszoronként a G8x / G9x esetében nyolc, a vetemítések száma pedig 24 (768 szál többprocesszoronként). Összességében a Geforce 8 és 9 sorozat csúcskategóriás videokártyái akár 12288 adatfolyamot is képesek egyszerre feldolgozni. A GT200-ra épülő Geforce GTX 280 akár 1024 szálat kínál többprocesszoronként, 10 fürtje három többprocesszorból áll, amelyek akár 30720 szálat dolgoznak fel. Ezen korlátozások ismerete lehetővé teszi az algoritmusok optimalizálását a rendelkezésre álló erőforrásokhoz.

Egy meglévő alkalmazás CUDA-ba történő portolásának első lépése a profil létrehozása, és a kódban a teljesítményt akadályozó szűk keresztmetszetek azonosítása. Ha az ilyen szakaszok alkalmasak a gyors párhuzamos végrehajtásra, akkor ezek a funkciók a C és CUDA kiterjesztésekre portolódnak a GPU-n való végrehajtáshoz. A programot az Nvidia által szállított fordító segítségével fordítják, amely kódot generál a CPU és a GPU számára is. Egy program végrehajtásakor a központi processzor végrehajtja a kód részeit, a GPU pedig a CUDA kódot hajtja végre a legnehezebb párhuzamos számításokkal. Ezt a GPU-nak szentelt részt kernelnek hívják. A kernel határozza meg az adatokon végrehajtandó műveleteket.

A videochip kap egy magot, és másolatokat készít minden egyes adatelemről. Ezeket a másolatokat szálaknak nevezzük. A stream tartalmazza a számlálót, a regisztereket és az állapotot. Nagy mennyiségű adat, például képfeldolgozás esetén több millió szál fut. A szálak 32-ből álló csoportokban hajtódnak végre, amelyeket warp "s. Warp"-nak neveznek, és meghatározott folyam-multiprocesszorokon való végrehajtásra vannak hozzárendelve. Minden többprocesszor nyolc magból áll – stream processzorokból, amelyek egy MAD utasítást hajtanak végre órajelenként. Egy 32 szálú vetemítés végrehajtásához a multiprocesszor négy órajele szükséges (a shader tartomány frekvenciájáról beszélünk, ami 1,5 GHz és magasabb).

A többprocesszor nem egy hagyományos többmagos processzor, többszálú feldolgozásra is kiválóan alkalmas, egyszerre akár 32 warp-ot is támogat.. A hardver minden órajel ciklusban kiválasztja, hogy melyik warp-ot hajtsa végre, és óraveszteség nélkül vált át egyikről a másikra. A központi processzorhoz hasonlóan ez olyan, mintha 32 programot futtatnánk egyszerre, és minden órajelben váltanánk közöttük a kontextusváltás elvesztése nélkül. A valóságban a CPU magok támogatják egy program egyidejű végrehajtását, és több száz órajel-ciklus késéssel váltanak át a többire.

CUDA programozási modell

A CUDA ismét párhuzamos számítási modellt használ, amikor a SIMD processzorok mindegyike párhuzamosan hajtja végre ugyanazt az utasítást különböző adatelemeken. A GPU egy számítástechnikai eszköz, egy központi processzor (host) társprocesszora (eszköze), amely saját memóriával rendelkezik, és párhuzamosan nagyszámú szálat dolgoz fel. A kernel (kernel) a GPU funkciója, amelyet szálak hajtanak végre (analógia a 3D grafikából - árnyékoló).

Fentebb elmondtuk, hogy a videochip abban különbözik a CPU-tól, hogy több tízezer szálat tud egyszerre feldolgozni, ami általában a jól párhuzamosított grafikákra vonatkozik. Minden adatfolyam skaláris, és nem szükséges az adatokat 4 komponensű vektorokba csomagolni, ami a legtöbb feladatnál kényelmesebb. A logikai szálak és szálblokkok száma meghaladja a fizikai végrehajtási egységek számát, ami jó skálázhatóságot biztosít a vállalati megoldások teljes palettája számára.

A CUDA programozási modell szálcsoportosítást feltételez. A szálak szálblokkokká vannak kombinálva – egydimenziós vagy kétdimenziós szálrácsokká, amelyek megosztott memória és szinkronizálási pontok segítségével kölcsönhatásba lépnek egymással. A program (kernel) szálblokkokból álló rácson fut, lásd az alábbi ábrát. Egyszerre egy háló kerül végrehajtásra. Mindegyik blokk lehet egy-, két- vagy háromdimenziós alakú, és 512 szálat tartalmazhat a jelenlegi hardveren.

A szálblokkokat kis csoportokban, úgynevezett warp-ban hajtják végre, amelyek 32 szál méretűek. Ez a többprocesszorban feldolgozható minimális adatmennyiség. És mivel ez nem mindig kényelmes, a CUDA lehetővé teszi, hogy 64–512 szálat tartalmazó blokkokkal dolgozzon.

A blokkok rácsokba csoportosítása lehetővé teszi, hogy megszabaduljon a korlátozásoktól, és egyetlen hívásban több szálra alkalmazza a kernelt. Segít a méretezésben is. Ha a GPU-nak nincs elég erőforrása, akkor a blokkokat egymás után hajtja végre. Ellenkező esetben a blokkok párhuzamosan is végrehajthatók, ami fontos a munka optimális elosztásához a különböző szintű videochipeken, kezdve a mobil és az integrált chipekkel.

CUDA memória modell

A CUDA memóriamodelljét a bájtcímzés lehetősége, valamint az összegyűjtés és szóródás támogatása jellemzi. Egy-egy stream processzorhoz meglehetősen nagy számú regiszter áll rendelkezésre, akár 1024 darab is. Hozzáférésük nagyon gyors, 32 bites egész számokat vagy lebegőpontos számokat tárolhatunk bennük.

Mindegyik szál a következő típusú memóriákhoz fér hozzá:

Globális memória- az összes többprocesszorhoz elérhető legnagyobb memóriamennyiség egy videochipen, mérete 256 megabájttól 1,5 gigabájtig terjed a jelenlegi megoldásokon (és akár 4 GB a Teslán). Nagy sávszélességgel rendelkezik, több mint 100 gigabájt/s a legjobb Nvidia-megoldásokhoz, de nagyon magas, több száz órajelciklusos késleltetéssel. Nem gyorsítótárazott, támogatja az általános betöltési és tárolási utasításokat, valamint a memóriára mutató rendszeres mutatókat.

Helyi memória Ez egy kis mennyiségű memória, amelyhez csak egyetlen adatfolyam-processzor fér hozzá. Viszonylag lassú – ugyanaz, mint a globális.

Megosztott memória Egy 16 kilobájtos (a jelenlegi architektúra videochipjében) memóriablokk, amelyet egy többprocesszoros összes adatfolyam-processzor megoszt. Ez a memória elég gyors, akárcsak a regiszterek. Biztosítja a szálak együttműködését, közvetlenül a fejlesztő vezérli, és alacsony a késleltetése. Az osztott memória előnyei: az első szintű programozó által vezérelt gyorsítótár formájában történő felhasználás, a végrehajtási egységek (ALU) adatokhoz való hozzáférési késleltetésének csökkentése, a globális memóriába irányuló hívások számának csökkentése.

Az állandók emlékezete- 64 kilobyte-os memóriaterület (ugyanaz a jelenlegi GPU-k esetében), csak olvasható az összes többprocesszor által. Többprocesszoronként 8 kilobájt gyorsítótárban van. Elég lassú - több száz óraciklus késleltetése a szükséges adatok hiányában a gyorsítótárban.

Textúra memória- egy memóriablokk, amely az összes multiprocesszor számára olvasható. Az adatmintavétel a videochip textúra egységeivel történik, így a lineáris adatinterpoláció lehetőségei további költségek nélkül biztosítottak. Minden többprocesszorhoz 8 kilobájt van gyorsítótárban. Lassú, mint a globális – több száz órajel-ciklus a késleltetés, ha nincs adat a gyorsítótárban.

Természetesen a globális, a lokális, a textúra és az állandó memória fizikailag ugyanaz a memória, amelyet a videokártya helyi videomemóriájaként ismerünk. Különbségük a különböző gyorsítótárazási algoritmusokban és hozzáférési modellekben van. A központi processzor csak külső memóriát tud frissíteni és kérni: globális, állandó és textúra.

A fentiekből kitűnik, hogy a CUDA speciális megközelítést feltételez a fejlesztéshez, nem egészen ugyanazt, mint a CPU-hoz készült programokban. Emlékeztetni kell a különféle memóriatípusokkal kapcsolatban, hogy a lokális és a globális memória nincs gyorsítótárazva, és az elérési késleltetés sokkal nagyobb, mint a regisztermemóriáé, mivel fizikailag külön mikroáramkörökben helyezkedik el.

Tipikus, de nem kötelező problémamegoldó minta:

- a feladatot részfeladatokra bontjuk;

- A bemeneti adatok blokkokra vannak osztva, amelyek beleférnek a megosztott memóriába;

- minden blokkot egy szálblokk dolgoz fel;

- az alblokk betöltődik a megosztott memóriába a globálisból;

- a megfelelő számításokat az osztott memóriában lévő adatokon hajtják végre;

- az eredményeket a rendszer a megosztott memóriából visszamásolja a globális memóriába.

Programozási környezet

A CUDA futásidejű könyvtárakat tartalmaz:

- egy közös rész, amely CPU-n és GPU-n támogatott RTL-hívások beépített vektortípusait és részhalmazait biztosítja;

- CPU komponens egy vagy több GPU vezérléséhez;

- GPU-komponens, amely GPU-specifikus funkciókat biztosít.

A CUDA alkalmazás fő folyamata egy univerzális processzoron (host) fut, a kernelfolyamatok több példányát elindítja a videokártyán. A CPU kódja a következőket teszi: inicializálja a GPU-t, lefoglalja a memóriát a videokártyán és a rendszerben, a konstansokat bemásolja a videokártya memóriájába, elindítja a kernelfolyamatok több példányát a videokártyán, az eredményt kimásolja a videóról memória, felszabadítja a memóriát és kilép.

Példaként a megértés érdekében adjuk meg a CPU-kódot a vektorok hozzáadásához, CUDA-ban:

A videochip által végrehajtott függvényekre a következő korlátozások vonatkoznak: nincs rekurzió, a függvényeken belül nincsenek statikus változók és változó számú argumentum. A memóriakezelés két típusa támogatott: a lineáris memória 32 bites mutatókkal, és a CUDA-tömbök, amelyek csak textúra-lekérő funkciókon keresztül érhetők el.

A CUDA programok kölcsönhatásba léphetnek grafikus API-kkal: a programban generált adatok megjelenítéséhez, a renderelési eredmények kiolvasásához és CUDA-eszközökkel történő feldolgozásához (például utófeldolgozási szűrők implementálásakor). Ehhez a grafikus API erőforrásai leképezhetők (az erőforrás címének megszerzésével) a CUDA globális memóriaterébe. A következő grafikus API-erőforrástípusok támogatottak: Pufferobjektumok (PBO / VBO) OpenGL-ben, csúcspufferek és textúrák (2D, 3D és kockatérképek) Direct3D9.

A CUDA-alkalmazás összeállításának szakaszai:

A CUDA C forráskód fájlok az NVCC programmal vannak fordítva, amely egy burkoló a többi eszköz felett, és meghívja őket: cudacc, g ++, cl, stb. Az NVCC előállítja: kódot a központi processzorhoz, amely az alkalmazás többi részével együtt fordít. , tiszta C-vel írva, és a videochip PTX objektumkódja. A CUDA kódot tartalmazó végrehajtható fájlok szükségszerűen megkövetelik a CUDA futásidejű könyvtárát (cudart) és a CUDA központi könyvtárát (cuda).

CUDA programok optimalizálása

Természetesen az áttekintő cikk keretein belül nem lehet komoly optimalizálási kérdéseket mérlegelni a CUDA programozásban. Tehát csak röviden fedjük le az alapokat. A CUDA képességeinek hatékony használatához el kell felejtenie a CPU programjainak szokásos írási módszereit, és azokat az algoritmusokat kell használnia, amelyek jól párhuzamosak több ezer szálhoz. Fontos még megtalálni az optimális helyet az adatok tárolására (regiszterek, megosztott memória stb.), minimalizálni kell a CPU és a GPU közötti adatátvitelt, és pufferelni kell.

Általánosságban elmondható, hogy egy CUDA program optimalizálásakor meg kell próbálni optimális egyensúlyt elérni a mérete és a blokkok száma között. Több szál egy blokkban csökkenti a memória késleltetésének hatását, de csökkenti a rendelkezésre álló regiszterek számát is. Ráadásul az 512 szálból álló blokk nem hatékony, az Nvidia maga javasolja a 128 vagy 256 szálból álló blokkok használatát kompromisszumként az optimális késleltetés és regiszterszám elérése érdekében.

A CUDA programok optimalizálásának főbb pontjai: a megosztott memória legaktívabb használata, mivel sokkal gyorsabb, mint a videokártya globális videomemóriája; A globális memóriából származó olvasási és írási műveleteket lehetőség szerint egyesíteni kell. Ehhez speciális adattípusokat kell használni az egyszerre 32/64/128 adatbit olvasására és írására egy műveletben. Ha az olvasmányokat nehéz kombinálni, próbálkozzon textúra lekéréssel.

következtetéseket

Az Nvidia által bemutatott hardver- és szoftverarchitektúra a CUDA videochipeken történő számításokhoz kiválóan alkalmas számos feladat nagy párhuzamosság melletti megoldására. A CUDA az Nvidia GPU-k széles skáláján fut, és javítja a GPU programozási modelljét azáltal, hogy sokkal egyszerűbbé teszi, és további funkciókat ad hozzá, mint például a megosztott memória, a szálszinkronizálás, a dupla pontosság és az egész műveletek.

A CUDA egy olyan technológia, amely minden szoftverfejlesztő számára elérhető, és bármely programozó használhatja, aki ismeri a C nyelvet. Csak meg kell szoknia a párhuzamos számítástechnikában rejlő eltérő programozási paradigmát. De ha az algoritmus elvileg jól párhuzamos, akkor a CUDA-ban való tanulás és programozásra fordított idő sokszorosan visszatér.

Valószínű, hogy a videokártyák világszerte elterjedt használata miatt a párhuzamos számítástechnika fejlesztése a GPU-n nagymértékben érinti a nagy teljesítményű számítástechnikai ipart. Ezek a lehetőségek már tudományos körökben is nagy érdeklődést váltottak ki, és nem csak bennük. Végtére is, a párhuzamosításra jól alkalmas algoritmusok felgyorsításának lehetősége (a rendelkezésre álló hardveren, ami nem kevésbé fontos) nem olyan gyakran előfordul egyszerre több tucatszor.

Az univerzális processzorok meglehetősen lassan fejlődnek, nincsenek ekkora teljesítményugrások. Alapvetően, bár túl hangosan hangzik, mindenkinek, akinek gyors számítógépekre van szüksége, most egy olcsó személyi szuperszámítógép állhat az asztalán, néha további források befektetése nélkül, mivel az Nvidia grafikus kártyái annyira elterjedtek. Nem is beszélve a GFLOPS / $ és a GFLOPS / Watt teljesítménynövekedésről, amelyeket a GPU-gyártók annyira szeretnek.

Sok számítás jövője egyértelműen a párhuzamos algoritmusokban rejlik, szinte minden új megoldás és kezdeményezés ebbe az irányba irányul. Egyelőre azonban az új paradigmák fejlesztése korai stádiumban van, manuálisan kell szálakat létrehozni és a memória elérését ütemezni, ami megnehezíti a feladatokat a hagyományos programozáshoz képest. Ám a CUDA technológia tett egy lépést a helyes irányba, és jól látszik rajta a sikeres megoldás, különösen, ha az Nvidiának sikerül a lehető legjobban meggyőznie a fejlesztőket előnyeiről és kilátásairól.

De természetesen a GPU-k nem helyettesítik a CPU-kat. Jelenlegi formájukban nem erre valók. Most, hogy a videochipek fokozatosan a CPU felé haladnak, egyre univerzálisabbakká válnak (egy- és dupla pontosságú lebegőpontos számítások, egészszámú számítások), így a CPU-k egyre "párhuzamosabbak", nagyszámú magot, többszálú technológiákat szereznek be, nem is beszélve a SIMD blokkok és a Heterogeneous Processor Projects megjelenéséről. Valószínűleg a GPU és a CPU egyszerűen egyesülni fog a jövőben. Ismeretes, hogy sok vállalat, köztük az Intel és az AMD is dolgozik hasonló projekteken. Nem számít, hogy a GPU-t elnyeli a CPU, vagy fordítva.

A cikkben elsősorban a CUDA előnyeiről beszéltünk. De van légy is a kenőcsben. A CUDA egyik hátránya a rossz hordozhatóság. Ez az architektúra csak a cég videochipjein működik, sőt nem is az összesen, hanem a Geforce 8 és 9 sorozattól, valamint a megfelelő Quadrotól és Teslától kezdve. Igen, nagyon sok ilyen megoldás létezik a világon, az Nvidia 90 millió CUDA-kompatibilis videochipről ad számot. Ez rendben van, de a versenytársak a CUDA-n kívül más megoldásokat is kínálnak. Tehát az AMD-nek van Stream Computing, az Intelnek pedig Ct-je lesz a jövőben.

Melyik technológia fog nyerni, elterjedni és tovább élni, mint mások – csak az idő fogja eldönteni. De a CUDA-nak jó esélyei vannak, hiszen például a Stream Computing-hoz képest fejlettebb és könnyebben használható programozási környezetet képvisel a megszokott C nyelven. Talán egy harmadik fél segíthet a definícióban valamilyen általános megoldással. Például a következő, 11-es verzió alatti DirectX-frissítésben a Microsoft számítástechnikai shadereket ígért, amelyek egyfajta átlagos, mindenkinek, vagy szinte mindenkinek megfelelő megoldássá válhatnak.

Az előzetes adatok alapján ez az új típusú shader sokat kölcsönöz a CUDA modellből. És ha most ebben a környezetben programoz, azonnal megszerezheti az előnyöket és a szükséges készségeket a jövőre nézve. HPC szempontból a DirectX-nek egyértelmű hátránya is van a rossz hordozhatóság formájában, mivel ez az API a Windows platformra korlátozódik. Egy másik szabvány azonban fejlesztés alatt áll - a nyílt többplatformos OpenCL kezdeményezés, amelyet a legtöbb vállalat támogat, köztük az Nvidia, az AMD, az Intel, az IBM és még sokan mások.

Ne feledje, hogy a következő CUDA-cikkben a tudományos és más nem grafikus számítástechnika konkrét gyakorlati alkalmazásait fedezi fel, amelyeket a fejlesztők világszerte végeznek az Nvidia CUDA használatával.

Évtizedek óta érvényben van a Moore-törvény, amely kimondja, hogy egy chipen lévő tranzisztorok száma kétévente megduplázódik. Ez azonban 1965-ben volt, és az elmúlt 5 évben a fizikai többmagos fogyasztói processzorok ötlete gyorsan fejlődni kezdett: 2005-ben az Intel bemutatta a Pentium D-t, az AMD pedig az Athlon X2-t. Ekkor a 2 magot használó alkalmazásokat egy kéz ujjain meg lehetett számolni. Az Intel processzorok következő generációja azonban, amely forradalmat csinált, pontosan 2 fizikai magot tartalmazott. Sőt, 2007 januárjában megjelent a Quad sorozat, ugyanakkor Moore maga is elismerte, hogy törvénye hamarosan megszűnik.

És most? Kétmagos processzorok még a költségvetési irodai rendszerekben is, a 4 fizikai mag pedig mindössze 2-3 év alatt vált megszokottá. A processzorok gyakorisága nem növekszik, de javul az architektúra, nő a fizikai és virtuális magok száma. A több tucat vagy akár több száz számítási "blokk"-tal felszerelt videoadapterek használatának ötlete azonban már régóta létezik.

És bár a GPU-kkal való számítástechnika kilátásai óriásiak, a legnépszerűbb megoldás - az Nvidia CUDA ingyenes, sok dokumentációval rendelkezik, és általában nagyon egyszerűen kivitelezhető, nem sok alkalmazás használja ezt a technológiát. Alapvetően ezek mindenféle speciális számítások, amelyekkel a hétköznapi felhasználó a legtöbb esetben nem törődik. De vannak olyan programok is, amelyeket tömeges felhasználók számára terveztek, és ezekről ebben a cikkben fogunk beszélni.

Kezdésként egy kicsit magáról a technológiáról és arról, hogy mivel eszik. Mivel Egy cikk írásakor az olvasók széles köre vezérel, majd megpróbálom egy érthető nyelven, bonyolult kifejezések nélkül, kissé röviden elmagyarázni.

CUDA(angolul Compute Unified Device Architecture) egy szoftver- és hardverarchitektúra, amely lehetővé teszi a számítástechnikát a GPGPU technológiát támogató NVIDIA grafikus processzorok használatával (tetszőleges számítástechnika a videokártyákon). A CUDA architektúra először a nyolcadik generációs NVIDIA G80 chip kiadásával jelent meg a piacon, és jelen van a GeForce, Quadro és Tesla gyorsítócsaládokban használt összes későbbi grafikus chip-sorozatban. (c) Wikipedia.org

A bejövő streamek feldolgozása egymástól függetlenül történik, azaz. párhuzamos.

Ezenkívül 3 szintre osztható:

Rács- mag. Egy/két/háromdimenziós blokktömböt tartalmaz.

Blokk- sok szálat (szálat) tartalmaz. A különböző blokkokból álló adatfolyamok nem léphetnek kölcsönhatásba egymással. Miért kellett blokkokat bevezetni? Minden blokk alapvetően felelős a saját részfeladatáért. Például egy nagy kép (ami egy mátrix) több kisebb részre (mátrixra) osztható, és párhuzamosan működhet a kép egyes részeivel.

cérna- patak. Az egy blokkon belüli szálak vagy megosztott memórián keresztül, ami egyébként sokkal gyorsabb, mint a globális memórián, vagy szálszinkronizáló eszközökön keresztül léphetnek kapcsolatba.

Warp- ez az interaktív adatfolyamok uniója, minden modern GPU esetében a Warp mérete 32. Következő félláncú, ami egy warp'a fele, hiszen A memória elérése általában külön megy a vetemedés első és második felére.

Mint látható, ez az architektúra kiválóan alkalmas a feladatok párhuzamosításához. És bár a programozás bizonyos megszorításokkal C nyelven történik, a valóságban ez nem ilyen egyszerű, hiszen nem lehet mindent párhuzamosítani. Véletlen számok generálására (vagy inicializálására) szintén nincsenek szabványos funkciók, mindezt külön kell megvalósítani. És bár van elég kész lehetőség, mindez nem okoz örömet. A rekurzió használatának képessége viszonylag új.

Az áttekinthetőség kedvéért egy kis konzolos (a kód minimalizálására) programot írtak, amely két float tömbbel hajt végre műveleteket, pl. nem egész értékekkel. A fenti okok miatt az inicializálást (a tömb kitöltését különféle tetszőleges értékekkel) a CPU végezte. Ezután 25 különböző műveletet végeztünk az egyes tömbök megfelelő elemeivel, a köztes eredményeket a harmadik tömbbe írtuk. A tömb mérete megváltozott, az eredmények a következők:

Összesen 4 tesztet végeztek el:

1024 elem minden tömbben:

Jól látható, hogy ilyen kis számú elem mellett nincs sok értelme a párhuzamos számításoknak, hiszen maguk a számítások sokkal gyorsabbak, mint az előkészítésük.

4096 elem minden tömbben:

És most láthatja, hogy a videokártya 3-szor gyorsabban hajtja végre a műveleteket a tömbökön, mint a processzor. Sőt, ennek a tesztnek a végrehajtási ideje videokártyán nem nőtt (az idő enyhe csökkenése hibának tulajdonítható).

Most minden tömbben 12288 elem található:

A videokártya közötti rés megduplázódott. Ismét vegye figyelembe, hogy a videókártya végrehajtási ideje megnőtt.

jelentéktelen mértékben, de a processzoron több mint 3-szor, i.e. arányos a feladat összetettségével.

És az utolsó teszt - 36864 elem minden tömbben:

Ebben az esetben a gyorsulás lenyűgöző értékeket ér el - videokártyán majdnem 22-szer gyorsabb. És ismét a videókártya végrehajtási ideje jelentéktelenül nőtt, a processzoron pedig - az előírt 3-szor, ami ismét arányos a feladat bonyolultságával.

Ha tovább bonyolítja a számításokat, akkor a videokártya egyre jobban nyer. Bár a példa kissé eltúlzott, általánosságban világosan mutatja a helyzetet. De amint fentebb említettük, nem lehet mindent párhuzamosítani. Például a pi kiszámítása. Csak Monte Carlo módszerrel írt példák vannak, de a számítások pontossága 7 tizedesjegy, i.e. rendes úszó. A számítások pontosságának növelése érdekében hosszú aritmetika szükséges, de itt problémák merülnek fel, mert nagyon-nagyon nehéz hatékonyan megvalósítani. Az interneten nem találtam példát a CUDA használatára és a Pi 1 millió tizedesjegyig való kiszámítására. Voltak már kísérletek ilyen alkalmazás megírására, de a pi kiszámításának legegyszerűbb és leghatékonyabb módja a Brent-Salamin algoritmus vagy a Gauss-képlet. A jól ismert SuperPI-ben valószínűleg (a munka sebességéből és az iterációk számából ítélve) a Gauss-képletet használják. És abból ítélve

A SuperPI egyszálas ténye, a CUDA-ra vonatkozó példák hiánya és a próbálkozásaim kudarca miatt lehetetlen hatékonyan párhuzamosítani a Pi számítását.

Mellesleg láthatja, hogy a számítások végrehajtása során hogyan növekszik a GPU terhelése, valamint a memóriakiosztás.

Most térjünk át a CUDA gyakorlatiasabb előnyeire, nevezetesen a jelenleg létező, ezt a technológiát használó programokra. Ezek többnyire mindenféle audio/video konverter és szerkesztő.

A teszteléshez 3 különböző videófájlt használtunk:

- * Az Avatar című film története - 1920x1080, MPEG4, h.264.

- * "Hazudj nekem" sorozat – 1280x720, MPEG4, h.264.

- * „Philadelphiában mindig süt a nap” sorozat – 624x464, xvid.

Az első két fájl tárolója és mérete mkv és 1,55 gb, az utolsó .avi és 272 mb volt.

Kezdjük egy nagyon szenzációs és népszerű termékkel - Badaboom... A használt verzió: 1.2.1.74 ... A program költsége $29.90 .

A program felülete egyszerű és intuitív - a bal oldalon kiválasztjuk a forrásfájlt vagy lemezt, a jobb oldalon pedig a szükséges eszközt, amelyre kódolni fogunk. Létezik felhasználói mód is, amelyben manuálisan állítják be a paramétereket, és ezt használták.

Kezdésként nézzük meg, hogy a videó milyen gyorsan és hatékonyan kódolódik „önmagába”, azaz. azonos felbontásban és megközelítőleg azonos méretben. A sebességet fps-ben mérik, és nem az eltelt időben - kényelmesebb összehasonlítani és kiszámítani, hogy mennyi tetszőleges hosszúságú videó lesz tömörítve. Mivel ma a "zöld" technológián gondolkodunk, akkor a grafikonok megfelelőek lesznek -)

A kódolási sebesség közvetlenül a minőségtől függ, ez nyilvánvaló. Megjegyzendő, hogy a fényfelbontás (nevezzük hagyományosan - SD) nem okoz gondot a Badaboomnak - a kódolási sebesség 5,5-szerese az eredeti (24 fps) videó képkockasebességének. És még egy nehéz 1080p videót is valós időben konvertál a program. Megjegyzendő, hogy a végleges videó minősége nagyon közel áll az eredeti videóhoz, pl. nagyon-nagyon jó minőségben kódolja a Badaboom-ot.

De általában a videót lekörözik kisebb felbontásra, lássuk, hogy állnak a dolgok ebben a módban. A felbontás csökkentésével a videó bitráta is csökkent. 9500 kbps volt az 1080p kimeneti fájlnál, 4100 kbps a 720p-nél és 2400 kbps a 720x404-nél. A választás a méret/minőség ésszerű aránya alapján történt.

A megjegyzések feleslegesek. Ha 720p-ről normál SD-minőségre másol, akkor körülbelül 30 percet vesz igénybe egy 2 órás film átkódolása. Ugyanakkor a processzor terhelése jelentéktelen lesz, kellemetlen érzés nélkül folytathatja a dolgát.

De mi van akkor, ha a videót mobileszköz formátumára konvertálja? Ehhez válassza ki az iPhone profilt (bitráta 1 Mbps, 480x320), és nézze meg a kódolási sebességet:

Mondanom kell valamit? Egy kétórás film normál iPhone-minőségben kevesebb, mint 15 perc alatt átkódolódik. A HD minőség nehezebb, de még így is elég gyors. A lényeg az, hogy a kimeneti videóanyag minősége meglehetősen magas szinten maradjon a telefon kijelzőjén.

Általánosságban elmondható, hogy a Badaboom benyomásai pozitívak, a munka sebessége tetszik, a felület egyszerű és egyértelmű. A korábbi verziók mindenféle hibája (2008-ban még bétát használtam) ki lett gyógyítva. Egy dolog kivételével - a forrásfájl elérési útja, valamint a kész videó mentési mappája nem tartalmazhat orosz betűket. De a program előnyeihez képest ez a hátrány jelentéktelen.

Mi lesz a következő a sorban Super LoiLoScope... A szokásos verzióra kérik 3280 rubel, a Windows 7 érintéses vezérlését támogató érintőképernyős verzióért pedig annyit kérnek 4440 rubel... Próbáljuk meg kitalálni, miért akar a fejlesztő ennyi pénzt, és miért van szüksége a videószerkesztőnek többérintéses támogatásra. A legújabb verziót használták - 1.8.3.3 .

A program felületét meglehetősen nehéz szavakkal leírni, ezért úgy döntöttem, hogy forgatok egy rövid videót. Azonnal el kell mondanom, hogy mint minden CUDA videokonverterhez, a GPU-gyorsítást csak az MPEG4 videó kimenete támogatja a h.264 kodekkel.

A kódolás során a processzor terhelése 100%, de ez nem okoz kellemetlenséget. A böngésző és más nem nehéz alkalmazások nem lassulnak le.

Most pedig térjünk át a teljesítményre. Először is minden ugyanaz, mint a Badaboom esetében – a videó átkódolása ugyanabba a minőségbe.

Az eredmények sokkal jobbak, mint a Badaboom. A minőség is csúcson van, a különbséget az eredetihez képest csak a képkockák páros nagyító alatti összehasonlításával lehet látni.

Hú, itt a LoiloScope 2,5-szer kerüli meg a Badaboomot. Ezzel párhuzamosan könnyedén vághatunk, kódolhatunk párhuzamosan másik videót, olvashatunk híreket és akár filmet is nézhetünk, sőt a FullHD is gond nélkül lejátszható, igaz a processzorterhelés maximális.

Most próbáljunk meg videót készíteni egy mobileszközre, a profilt ugyanúgy fogjuk elnevezni, mint a Badaboom - iPhone-ban (480x320, 1 Mbps):

Nincs hiba. Mindent többször ellenőriztek, minden alkalommal ugyanaz volt az eredmény. Valószínűleg ez abból az egyszerű okból következik be, hogy az SD-fájlt más kodekkel és más tárolóban írják. Átkódoláskor a videót először dekódolják, meghatározott méretű mátrixokra osztják és tömörítik. Az xvid esetén használt ASP dekóder lassabb, mint az AVC (h.264 esetén) párhuzamos dekódolásnál. A 192 fps azonban 8-szor gyorsabb az eredeti videósebességnél, egy 23 perces sorozatot kevesebb mint 4 perc alatt tömörítenek. A helyzet megismétlődött más xvid / DivX formátumban tömörített fájlokkal.

LoiloScope csak kellemes benyomásokat hagytam magamról - az interfész szokatlansága ellenére kényelmes és funkcionális, a munka sebessége pedig dicsérhetetlen. A viszonylag gyenge funkcionalitás némileg elkeserítő, de sokszor egyszerű szerkesztéssel csak kicsit módosítani kell a színeket, simán át kell állítani a szöveget, át kell fedni a szöveget, és a LoiloScope ezzel kiváló munkát végez. Az ár is kissé ijesztő – a normál verzióért több mint 100 dollár normális külföldön, de ezek a számok még mindig kissé vadnak tűnnek számunkra. Bár bevallom, ha például gyakran forgattam és szerkesztettem házi videókat, akkor lehet, hogy elgondolkodtam a vásárláson. Ezzel egyidőben egyébként ellenőriztem, hogy a HD (vagy inkább AVCHD) tartalmat közvetlenül a kameráról szerkeszthetem anélkül, hogy először konvertáltam volna másik formátumba, a LoiloScope-nak nincs gondja az mts fájlokkal.

Térjünk vissza a történelemhez - vissza 2003-ig, amikor az Intel és az AMD részt vett a közös versenyben a legerősebb processzorért. Alig néhány év alatt ez a verseny az órajelek jelentős növekedését eredményezte, különösen az Intel Pentium 4 megjelenése óta.

De a verseny gyorsan közeledett a határához. Az órajelek hatalmas növekedési hulláma után (2001 és 2003 között a Pentium 4 órajele megduplázódott 1,5-ről 3 GHz-re) a felhasználóknak meg kellett elégedniük a gigahertzes tizedekkel, amit a gyártók ki tudtak kicsikarni (a 2003 és 2005 között az órajel 3-ról 3-ra nőtt, 8 GHz).