Dimensión de bajada · Loginom Wiki. Introducción a una disminución de la dimensión. Qué método ayuda a reducir la dimensión de los datos.

Capítulo 13. Método del componente principal.

13.1. Esencia del problema de la dimensión reducida y varios métodos de su solución.

En la investigación y el trabajo estadístico práctico, es necesario lidiar con situaciones en las que el número total de señales registrados en cada uno de los muchos temas de los sujetos (países, ciudades, empresas, familias, pacientes, sistemas técnicos o ambientales) es muy grande. alrededor de cien más y más. Sin embargo, las observaciones multidimensionales existentes.

debe someterse a procesamiento estadístico, comprender o ingrese en la base de datos para poder usarlos en el momento adecuado.

El deseo de las estadísticas representan cada una de las observaciones (13.1) en forma de un vector z de algunos indicadores auxiliares con un número significativamente menor (que) número de componentes de la saqueo se debe principalmente por las siguientes razones:

la necesidad de una representación visual (visualización) de los datos de origen (13.1), que se logra mediante su proyección en un espacio tridimensional especialmente seleccionado del plano o numérico directo (objetivos de este tipo IV);

el deseo del laconismo bajo modelos investigados debido a la necesidad de simplificar la cuenta e interpretación de las conclusiones estadísticas obtenidas;

la necesidad de comprimir sustancialmente los volúmenes de información estadística almacenada (sin pérdidas visibles en su informatividad), si se realiza a la grabación y almacenamiento de matrices de tipo (13.1) en una base de datos especial.

Al mismo tiempo, las características nuevas (auxiliares) se pueden seleccionar del número de iniciales o para determinar por cualquier regla en el conjunto de señales de origen, por ejemplo, sus combinaciones lineales. Al formar nuevo sistema Señales a este último, prevengo a nuestros diversos tipos de requisitos, como la mayor informatividad (en cierto sentido), la no corrosión mutua, la distorsión más pequeña de la estructura geométrica de un conjunto de datos de origen, etc., dependiendo de la Especificación formal de estos requisitos (ver más abajo, y también, Sección IV) Venimos a un algoritmo de reducción de dimensiones particular. Hay al menos tres tipos básicos de requisitos previos fundamentales que determinan la posibilidad de transición de una gran cantidad de indicadores de origen del estado (comportamiento, eficiencia de funcionamiento) del sistema analizado a un número significativamente menor de las variables más informativas. Esto es, en primer lugar, la información de duplicación entregó signos fuertemente interrelacionados; en segundo lugar, la no informatividad de los signos, poco cambiando durante la transición de un objeto a otra (pequeña "variabilidad" de los signos); En tercer lugar, la posibilidad de agregación, es decir, una suma simple o "ponderada", de acuerdo con algunos signos.

Formalmente, la tarea de la transición (con la pérdida más pequeña de informativo) a un nuevo conjunto de características se puede describir de la siguiente manera. Supongamos que: una función vectorial p-dimensional de las variables iniciales y la PIE, de cierta manera la medida específica del sistema de características dimensionales de informatividad, la elección específica de funcional depende de los detalles específicos de la tarea real resuelta y se basa en uno de los Criterios posibles: el criterio de la autocormatividad, dirigido a la máxima información de ahorro contenida en la matriz de origen en relación con los signos de origen; y el criterio de informatividad externa dirigido al máximo "apretón" de la información contenida en esta matriz en relación con algunos otros indicadores (externos).

La tarea es determinar dicho conjunto de signos Z, que se encuentra en la clase F de transformaciones permisibles de los indicadores iniciales que

Una u otra realización de esta formulación (definiendo elección específica Las medidas de informatividad) y la clase de transformaciones permisibles) conducen a un método de reducción de dimensión específica: al método del componente principal, análisis factorial, agrupación extrema de parámetros, etc.

Permítanos explicarlo en los ejemplos.

13.1.1. Método del componente principal (ver § 13.2-§ 13.6).

Es para los primeros componentes principales que vendrá el investigador, si la clase de transformaciones permisibles f determinará todo tipo de combinaciones de indicadores iniciales ortogonales lineales, es decir,

(Aquí) - La expectativa matemática A como medida de los indicadores del sistema-dimensional de servicios dimensionales

(Aquí, D, como antes, el signo del funcionamiento de cálculo de dispersión de la variable aleatoria correspondiente).

13.1.2. Análisis de factores (ver cap. 14).

Como se conoce (ver § 14.1), el modelo de análisis factorial explica la estructura de los vínculos entre los indicadores iniciales porque el comportamiento de cada uno de ellos depende estadísticamente del mismo conjunto de los llamados factores comunes.

cuando: la "carga" del factor general en el indicador de origen es el componente aleatorio "específico" residual, y en pares no están correlacionados.

Resulta que si F, como clase de todo tipo de combinaciones lineales, teniendo en cuenta los límites mencionados anteriormente, para elegir el valor del problema de optimización (13.2) como medida de informatividad (13.2), coincide con lo común Factores en el modelo de análisis factorial. Aquí: la matriz de correlación de los indicadores iniciales la matriz de correlación de indicadores - norma euclidiana de la matriz A.

13.1.3. Método de agrupación extrema (ver sección 14.2.1).

En este método, estamos hablando de una partición de este tipo de indicadores iniciales a un número dado de grupos que los signos que pertenecen al mismo grupo serían relativamente fuertemente fuertemente, mientras que los signos que pertenecen a diferentes grupos se correlacionarían débilmente. Al mismo tiempo, la tarea de reemplazar a cada grupo de indicadores iniciales fuertemente intercascados se resuelve mediante un indicador de "asilo" auxiliar que, por supuesto, debería estar en estrecha correlación con los signos de su grupo. Habiendo definido como una clase de transformaciones permisibles F de los indicadores iniciales, todas las combinaciones lineales normalizadas están buscando una solución maximizando (por S y) funcionalidad

¿Dónde está el coeficiente de correlación entre las variables?

13.1.4. Escalado multidimensional (ver cap. 16).

En una serie de situaciones, en primer lugar, en situaciones en las que se obtienen estadísticas iniciales utilizando encuestas especiales, cuestionarios, estimaciones de expertos, hay casos en los que el elemento de la observación primaria no es el estado del objeto descrito por el vector y la característica. de proximidad por pares (lejanía) de dos objetos (o signos) respectivamente con números

En este caso, el investigador tiene una matriz de tamaño como una matriz de datos estadísticos de origen (si se consideran las características de los pares de objetos de objetos) o (si se consideran las características de los pares de signos de signos) de las especies.

donde los valores se interpretan como distancias entre objetos (características) i y como las clasificaciones que configuran la racionalización de estas distancias. La tarea de la escala multidimensional es "sumergir" nuestros objetos (signos) en un espacio tan dimensional, es decir, para elegir el eje de coordenadas para que la configuración geométrica original del conjunto de puntos-objetos (o características de puntos) analizados se especifique Por (13.1) o (13.5), sería el menos distorsionado en el sentido de un cierto criterio para el "grado de distorsión" promedio de pares de distancias mutuas.

Uno de los esquemas generales suficientes de la escala multidimensional se determina por el criterio.

donde está la distancia entre los objetos en el espacio de origen, la distancia entre los mismos objetos en el espacio buscado de una dimensión más pequeña: parámetros libres, la selección de valores específicos de los cuales se realiza a discreción del investigador.

Identifique una medida de la informatividad del conjunto deseado de signos Z, por ejemplo, como una magnitud que se menciona inversamente por encima del valor del grado de distorsión de la estructura geométrica del conjunto original de puntos, reducimos esta tarea a la formulación general ( 13.2), creyendo

13.1.5. Selección de los indicadores más informativos en los modelos del análisis discriminante (ver § 1.4; 2.5).

Los funcionales anteriores son los medidores informativos autográficos del sistema correspondiente de signos. Ahora damos ejemplos de criterios informativos externos. En particular, estaremos interesados \u200b\u200ben la informatividad del sistema de indicadores desde el punto de vista de la corrección de la clasificación de los objetos en estos indicadores en el esquema de análisis discriminante. Al mismo tiempo, la clase de transformaciones permisibles F definimos sobre los requisitos de los requisitos que solo se pueden considerar representantes del conjunto de indicadores iniciales, es decir,.

Una tesis de origen común para resolver el problema de identificar los indicadores más informativos del conjunto original es la afirmación de que el vector de indicadores de una dimensión determinada es más informativa que la diferencia en las leyes de su distribución probabilística definida en diferentes clases en el Tarea de clasificación bajo consideración. Si ingresa el modo de una diferencia de pares en las leyes que describen la distribución de las probabilidades de las características de las características en las clases con números, es posible formalizar el principio anterior de selección de los indicadores más informativos. Determinándolos de la maximización Condición (software) de la magnitud

Las diferencias más comunes de las medidas entre las leyes de la distribución de probabilidad son la distancia. tipo de información (Distancia Doljalkak, distancia Mahalanobis), así como "distancia de variación" (vea más detalles al respecto.

13.1.6. Selección de las variables más informativas en modelos de regresión (ver).

Al construir dependencias de tipo de regresión, una de las centrales es identificar un número relativamente pequeño de variables (a partir de un conjunto a priori de los signos más significativos del resultado resultante del resultado resultante.

Por lo tanto, como en el párrafo anterior, la Clase F consiste en todo tipo de conjuntos de conjuntos de variables seleccionadas del conjunto original de factores de argumento y tratan el criterio de informatividad externa de dichos conjuntos. Su vista generalmente se establece utilizando un coeficiente de determinación múltiple: las características del grado de estanqueidad de la conexión del indicador Y con un conjunto de variables. Al mismo tiempo, para una dimensión fija, el conjunto de variables se considerará obviamente el La mayoría informativa (en términos de la precisión de la descripción del comportamiento del indicador del indicador), si el valor de la informatividad está en esto, el conjunto alcanza el máximo.

- En estadísticas, el aprendizaje de la máquina y la teoría de la información, la reducción de la dimensión es convertir los datos que consisten en reducir la cantidad de variables al recibir las variables principales. La conversión se puede dividir en la selección de características y selección de características.

Conceptos conectados

Mencionado en la literatura

- Datos de entrada de carga y preprocesamiento: diseño manual y automático de estímulos (selección de zonas de interés), - algoritmo para calcular la matriz de representación sucesor, - construir una tabla de datos extendidos con los valores de las variables de entrada requeridas para el análisis posterior - método dimensión reducida Espacios espaciales (método del componente principal), - visualización de las cargas componentes para seleccionar el componente interpretable: el algoritmo para aprender el árbol de soluciones, es un algoritmo para evaluar la capacidad predictiva del árbol, - visualización del árbol de soluciones.

Conceptos relacionados (continuación)

Las técnicas de agrupamiento espectral utilizan el espectro (valores propios) de la matriz de similitud de datos para reducir la dimensión antes de agruparse en espacios más pequeños. La matriz de similitud se suministra como una entrada y consta de estimaciones cuantitativas de la similitud relativa de cada par de puntos en los datos.

Los métodos espectrales son una clase de técnico utilizada en las matemáticas aplicadas para una solución numérica de algunas ecuaciones diferenciales, es posible involucrar una transformación rápida de Fourier. La idea consiste en el censo de resolución de ecuaciones diferenciales como la suma de algunas "funciones básicas" (por ejemplo, como las series de Fourier son la suma del sinusoide), y luego seleccione los coeficientes en la cantidad para satisfacer la ecuación diferencial tanto como sea posible.

El análisis matemático (análisis matemático clásico) es un conjunto de secciones de matemáticas correspondientes a la sección histórica bajo el nombre "Análisis de infinitamente pequeñas", combina cálculo diferencial e integral.

EVOLUCIÓN DIFERENCIAL (ESP. Evolución diferencial) - Método de optimización matemática multidimensional relacionada con la clase de algoritmos de optimización estocásticos (es decir, funciona utilizando números aleatorios) y usar algunas ideas de algoritmos genéticos, pero, a diferencia de ellos, no requiere trabajo con Variables en código binario.

El método del elemento discreto (DEM, del inglés. Método de elemento discreto) es una familia de métodos numéricos destinados a calcular el movimiento de un gran número de partículas, como moléculas, grava, grava, guijarros y otros medios granulados. El método se aplicó originalmente en Cundall en 1971 para resolver problemas de la mecánica de roca.

Propósito del estudio:

Evaluación de la efectividad de la metodología de reducción de la dimensión de datos para optimizar su solicitud en la práctica de reconocimiento (identificación).

Tareas de investigación:

1. Revisión de las fuentes literarias sobre métodos existentes Reducir la dimensión de datos.

2. Realización de investigaciones (experimentos) para comparar la efectividad de los algoritmos de reducción de datos aplicados en la práctica en las tareas de clasificación

Métodos de Investigación (Software):

Idioma de programación de C ++, Biblioteca OPENCV

La percepción de los datos de alta dimensión para una persona es difícil, y a veces es imposible. En este sentido, bastante natural fue el deseo de pasar de una muestra multidimensional a los datos de una pequeña dimensión para que "los puedan mirarlos", evaluar y usar, incluso para lograr tareas de reconocimiento. Además de la visibilidad, la reducción de la dimensión le permite deshacerse de los factores (información) que interfieren con el análisis estadístico, extendiendo el tiempo para recopilar información, lo que aumenta la dispersión de las estimaciones de los parámetros y las características de las distribuciones.

La reducción de la dimensión es la transformación de los datos de origen con una gran dimensión en una nueva representación de una dimensión más pequeña que mantiene información básica. En el caso perfecto, la dimensión de la representación convertida corresponde a la dimensión interna de los datos. La dimensión de datos interna es el número mínimo de variables requeridas para expresar todas las propiedades de datos posibles. Un modelo analítico, basado en la base de un múltiples datos reducidos, debe ser más fácil para el procesamiento, la implementación y la comprensión que el modelo construido en el conjunto de origen.

La decisión sobre la elección del método de reducción de la dimensión se basa en el conocimiento de las características de la tarea que se resuelve y los resultados esperados, así como el tiempo limitado y recursos computacionales. Según las revisiones literarias, los métodos de reducción de dimensiones más utilizados incluyen análisis de componentes principales (PCA), análisis de componentes independientes (ICA) y descomposición de valor singular (SVD).

Análisis del componente principal (PCA). - El método más fácil de reducir la dimensión de los datos. Se usa ampliamente para convertir los signos al tiempo que reduce la dimensión de los datos en las tareas de clasificación. El método se basa en la proyección de datos a un nuevo sistema de coordenadas de una dimensión más pequeña, que está determinada por sus propios vectores y los números propios de la matriz. Desde el punto de vista de las matemáticas, el método del componente principal es una transformación lineal ortogonal.

La idea principal del método es calcular los valores propios y los efervectores de la matriz de datos de covarianza para minimizar la dispersión. La matriz de covarianza se utiliza para determinar la dispersión en relación con el promedio con respecto a los demás. Covarianza de dos variables aleatorias (dimensiones) - medida de su dependencia lineal:

donde: la expectativa matemática del valor aleatorio de X, - la expectativa matemática de la variable aleatoria y. También podemos escribir la fórmula (1) en el formulario:

donde - la media x, donde, la y la media y, n es la dimensionalidad de los datos.

Después de calcular sus propios vectores y sus propios números, sus valores se clasifican en orden descendente. Por lo tanto, los componentes se obtienen para reducir la importancia. Propio vector con el número natural más grande y es el componente principal del conjunto de datos. Los componentes principales se obtienen multiplicando las filas de sus propios vectores en los valores propios ordenados. Para encontrar el espacio óptimo de una dimensión más pequeña, se usa fórmula (3), que calcula el error mínimo entre el conjunto de datos de datos y el siguiente criterio:

donde P es la dimensión del nuevo espacio, N es la dimensión de la muestra original, - EIGENVALUES, - Umbral. Durante la operación del algoritmo, obtenemos una matriz con datos MP, convertidos linealmente de MN, después de lo cual la PCA encuentra un mapeo lineal M, una función de estimación de minimización:

donde - distancia euclidiana entre puntos y, - distancia euclidiana entre puntos y ,, ![]() . El mínimo de esta función estimada se puede calcular realizando una descomposición espectral de la matriz gram y multiplicando su propio vector de esta matriz a la raíz de los valores propios correspondientes.

. El mínimo de esta función estimada se puede calcular realizando una descomposición espectral de la matriz gram y multiplicando su propio vector de esta matriz a la raíz de los valores propios correspondientes.

Análisis de componentes independientes ( ICA ) , A diferencia de PCA, un nuevo método lo suficientemente nuevo, pero rápidamente ganando popularidad. Se basa en la idea de una transformación de datos lineales en nuevos componentes, que son más estadísticamente independientes y opcionalmente ortogonales entre sí. Para la investigación en este documento, se seleccionó el algoritmo de Fastica, descrito en detalle en el artículo. Las tareas principales este método Estos están centrados (restando el promedio de datos) y "blanqueamiento" (conversión lineal de vector x en vector con coordenadas no correlacionadas, cuya dispersión es igual a una).

El criterio de independencia en Fastica es no geasura, que se mide utilizando el coeficiente excesivo:

Para las variables aleatorias gaussianas, este valor es cero, por lo que Fastica maximiza su valor. Si, los datos "blanqueados", entonces la matriz de covarianza de los datos "blanqueados" es una sola matriz.

![]()

Tal transformación es siempre posible. El método popular de "blanquear" utiliza la descomposición espectral de la matriz de covarianza. ![]() , donde - la matriz ortogonal de sus propios vectores, A es una matriz diagonal de números propios,. Resulta que el "blanqueamiento" se puede representar como:

, donde - la matriz ortogonal de sus propios vectores, A es una matriz diagonal de números propios,. Resulta que el "blanqueamiento" se puede representar como:

donde la matriz es calculada por la operación Pomoponent:

Experimentos

Para el estudio experimental de los métodos propuestos, se utilizó una secuencia de video basada en el diccionario de la base de datos de Casia Gait. La base contiene las secuencias de imágenes binarias correspondientes a los marcos individuales de la secuencia de video en los que ya se ha realizado la asignación de objetos en movimiento.

De todos los muchos videos, 15 clases fueron tomadas al azar, en las que el ángulo de tiro es de 90 grados, las personas se representan en ropa ordinaria sin invierno y sin bolsas. En cada clase había 6 secuencias. La longitud de cada secuencia fue de al menos 60 marcos. Las clases se dividieron en aprendizaje y muestras de prueba de 3 secuencias cada una.

Las características obtenidas como resultado de los métodos de PCA y ICA se utilizaron para estudiar el clasificador, que en el presente trabajo fueron los vectores de soporte (Máquinas de soporte vectorial, SVM).

Para determinar la calidad del método del método, se estimó la precisión de la clasificación, definida como la proporción de objetos correctamente clasificados. Durante el experimento, también se solucionó el tiempo dedicado al modo de entrenamiento y prueba.

Figura 1. (a) Método Componente principal (PCA) b) Método de componente independiente (ICA)

La Figura 1 (A, B) presenta la relación de la precisión de la clasificación del valor de la dimensión de salida de los datos después de la conversión. Se puede ver que en PCA, la precisión de la clasificación con un aumento en el número de componentes varía ligeramente, y cuando se utiliza ICA, la precisión a partir de un cierto valor, comienza a caer.

Figura 2. La dependencia del tiempo de clasificación en el número de componentes. pero) PCA B) ICA

La Figura 2 (A, B) presenta la dependencia del tiempo de clasificación en el número de componentes de PCA y ICA. El crecimiento de la dimensión en ambos casos fue acompañado por un aumento lineal en el tiempo de procesamiento. Los gráficos muestran que el clasificador SVM funcionó más rápido después de bajar la dimensión utilizando el método del componente principal (PCA).

El componente principal Analisysys (PCA), los análisis de componentes independientes (ICA) trabajaron lo suficientemente rápido y parámetros definidos Se obtuvieron altos resultados en la tarea de clasificación. Pero con datos con una estructura compleja, estos métodos no siempre le permiten lograr el resultado deseado. Por lo tanto B. Últimamente Los métodos locales no lineales se pagan cada vez más a la proyección de datos sobre alguna variedad, lo que le permite mantener la estructura de datos.

En el futuro, se planea expandir tanto la lista de algoritmos utilizados para formar una descripción de características y una lista de métodos de clasificación utilizados. Otro área importante de la investigación parece reducir el tiempo de procesamiento.

Bibliografía:

- Jolliffe, I.T, Análisis de componentes principales, Springer, 2002

- Hyvärinen y Erkki OJA, análisis de componentes independientes: algoritmos y aplicaciones, redes neuronales, 13, 2000

- Josiński, H. Característica de la extracción y la clasificación basada en HMM de las secuencias de video de la GAIT con fines de identificación humana / Springer, 2013 - Vol 481.

Indicio

MATEMÁTICAS / Estadísticas aplicadas / Estadísticas de matemáticas / Puntos de crecimiento / Método del componente principal. / ANÁLISIS FACTORIAL / Escala multidimensional / Evaluación de la dimensión de datos. / Estimación de la dimensión del modelo. / Matemáticas / Estadísticas / estadísticas aplicadas / Estadísticas matemáticas / Puntos de crecimiento / Análisis de componentes principales / Análisis de factores / Escala multidimensional / estimación de dimensión de datos / estimación de la dimensión del modeloanotación artículo científico en Matemáticas, Autor de Trabajo Científico - ORLOV Alexander Ivanovich, Lutsenko Evgeny Veniaminovich

Uno de los "puntos de crecimiento" estadísticas aplicadas Son métodos para reducir la dimensión del espacio de los datos estadísticos. Se utilizan cada vez más en el análisis de datos en estudios aplicados específicos, por ejemplo, sociológicos. Considere los métodos más prometedores de dimensión reducida. Método del componente principal. Es uno de los métodos de dimensión más utilizados. Para el análisis visual de los datos, se utilizan las proyecciones de los vectores iniciales en el plano de los dos primeros componentes principales. Por lo general, la estructura de datos es claramente visible, se distinguen los grupos de objetos compactos y se distinguen por separado. Método del componente principal. es uno de los métodos análisis factorial. Nueva idea en comparación con método de componentes principales. Es eso sobre la base de las cargas, los factores se dividen en grupos. En un grupo, se combinan factores, teniendo un efecto similar en los elementos de la nueva base. Luego, desde cada grupo, se recomienda dejar un representante. A veces, en lugar de elegir un representante, se forma un nuevo factor, lo que es fundamental para el grupo en consideración. La reducción de la dimensión ocurre durante la transición al sistema de factores que son representantes de grupos. Los factores restantes se descartan. Sobre el uso de distancias (medidas de proximidad, indicadores de diferencias) entre los signos y la extensa clase de métodos se basa escalamiento multidimensional. La idea principal de este método de métodos es representar cada objeto del punto geométrico (generalmente la dimensión 1, 2 o 3), cuyas coordenadas sirven como valores de factores ocultos (latentes), que son Describiendo bastante adecuadamente el objeto. Como ejemplo de la aplicación de modelado estadístico probabilístico y resultados de no estatuadores, justificamos la consistencia de la medición de la dimensión del espacio de datos en escalamiento multidimensionalpreviamente propuesto por la colromal de las consideraciones heurísticas. Considerado una serie de trabajos en evaluación de las dimensiones de los modelos. (en análisis de regresión y en la teoría de la clasificación). Dana información sobre la reducción de algoritmos de dimensión en un análisis cognitivo del sistema automatizado

Temas similares trabajo científico sobre matemáticas, autor del trabajo científico - Orlov Alexander Ivanovich, Lutsenko Evgeny Veniaminovich

-

Métodos matemáticos en la sociología durante cuarenta y cinco años.

-

Variedad de objetos de la no naturaleza.

-

Evaluación de los parámetros: las estimaciones de una etapa son preferibles a las estimaciones de máxima credibilidad

-

Estadísticas aplicadas - Estadísticas y perspectivas.

2016 / ORLOV Alexander Ivanovich -

Estado y perspectivas para el desarrollo de estadísticas aplicadas y teóricas.

2016 / ORLOV Alexander Ivanovich -

La relación de los teoremas límite y el método de Monte Carlo.

2015 / Orlov Alexander Ivanovich -

En el desarrollo de estadísticas de objetos no naturales.

2013 / Orlov Alexander Ivanovich -

Puntos de crecimiento de los métodos estadísticos.

2014 / ORLOV Alexander Ivanovich -

Sobre nuevos instrumentos matemáticos prometedores de control

2015 / Orlov Alexander Ivanovich -

Distancias en espacios estadísticos.

2014 / ORLOV Alexander Ivanovich

Uno de los "puntos de crecimiento" de estadísticas aplicadas son los métodos para reducir la dimensión de los datos estadísticos. Se utilizan cada vez más en el análisis de datos en investigación aplicada específica, como la sociología. Investigamos los métodos más prometedores para reducir la dimensionalidad. Los principales componentes son uno de los métodos más utilizados para reducir la dimensionalidad. Para el análisis visual de los datos se utilizan a menudo las proyecciones de los vectores originales en el plano de los dos primeros componentes principales. Usualmente, la estructura de datos es claramente visible, resaltó clubsers compactos de objetos y vectores asignados por separado. Los componentes principales son un método de análisis factorial. La nueva idea de análisis factorial en comparación con el método de los componentes principales es que, según las cargas, los factores se rompen en grupos. En un grupo de factores, el nuevo factor se combina con un impacto similar en los elementos de la nueva base. Luego se recomienda a cada grupo para dejar un representante. A veces, en lugar de la elección del representante por cálculo, un nuevo factor que es fundamental para el grupo en cuestión. La dimensión reducida ocurre durante la transición a los factores del sistema, que son representantes de los grupos. Los factores de OTER se descartan. El uso de la distancia (medidas de proximidad, los indicadores de diferencias) entre las características y la clase extensa se basan en métodos de escala multidimensional. La idea básica de esta clase de métodos es presentar cada objeto como punto del espacio geométrico (generalmente de la dimensión 1, 2, o 3) cuyas coordenadas son los valores de los factores ocultos (latentes) que se combinan adecuadamente. Describe el objeto. Como ejemplo de la aplicación del modelado probabilístico y estadístico y los resultados de las estadísticas de los datos no numéricos, justificamos la consistencia de los estimadores de la dimensión de los datos en la escala multidimensional, que se proponen previamente por Kruskal de las consideraciones heurísticas. Hemos considerado una serie de estimaciones consistentes de dimensión de los modelos (en análisis de regresión y en teoría de la clasificación). También le damos alguna información sobre los algoritmos para reducir la dimensionalidad en el sistema automatizado del sistema cognitivo.

Texto de trabajo científico. en el tema "Métodos para reducir la dimensión del espacio de los datos estadísticos"

UDC 519.2: 005.521: 633.1: 004.8

01.00.00 Física y matemáticas.

Métodos para reducir la dimensión del espacio de datos estadísticos.

Orlov Alexander Ivanovich

d.e.n., d.t.n., k.f.-m.n., profesor

Código de Rinz BroSh: 4342-4994

Técnico estatal de Moscú

universidad. ANUNCIO Bauman, Rusia, 105005,

Moscú, 2do Baumanskaya St., 5, [Correo electrónico protegido]t.

Lutsenko Evgeny Veniaminovich D.E.N., Ph.D., Profesor Rinz BroSh Código: 9523-7101 Kuban State Agrarian University, Krasnodar, Rusia [Correo electrónico protegido] Com.

Uno de los "puntos de crecimiento" de las estadísticas de la aplicación es métodos para reducir la dimensión del espacio de datos estadísticos. Se utilizan cada vez más en el análisis de datos en estudios aplicados específicos, por ejemplo, sociológicos. Considere los métodos más prometedores de dimensión reducida. El método del componente principal es uno de los métodos de reducción de dimensiones más utilizados. Para el análisis visual de los datos, se utilizan las proyecciones de los vectores iniciales en el plano de los dos primeros componentes principales. Por lo general, la estructura de datos es claramente visible, se distinguen los grupos de objetos compactos y se distinguen por separado. El método principal del componente es uno de los métodos de análisis factorial. La nueva idea en comparación con el método del componente principal es que, sobre la base de las cargas, los factores se dividen en grupos. En un grupo, se combinan factores, teniendo un efecto similar en los elementos de la nueva base. Luego, desde cada grupo, se recomienda dejar un representante. A veces, en lugar de elegir un representante, se forma un nuevo factor, lo que es fundamental para el grupo en consideración. La reducción de la dimensión ocurre durante la transición al sistema de factores que son representantes de grupos. Los factores restantes se descartan. Sobre el uso de distancias (medidas de proximidad, indicadores de diferencias) entre los signos y la extensa clase de métodos de escalado multidimensional. La idea principal de esta clase de métodos es representar cada objeto con un punto de espacio geométrico (generalmente dimensión 1, 2 o 3), cuyas coordenadas son los valores de los factores ocultos (latentes), en el agregado , lo suficientemente adecuadamente descripando

UDC 519.2: 005.521: 633.1: 004.8

Física y ciencias matemáticas.

Métodos de reducción de la dimensión espacial de los datos estadísticos.

Orlov Alexander Ivanovich

Dr.Sci.chon., Dr.Sci.tech., Cand.phys-math.sci.,

Universidad Técnica Estatal de Bauman Moscú, Moscú, Rusia

Lutsenko Eugeny Veniaminovich Dr.Sci.con., Cand.tech.sci., Profesor RSCI Spin-code: 9523-7101

Kuban State Agrarian University, Krasnodar, Rusia

[Correo electrónico protegido] Com.

Uno de los "puntos de crecimiento" de estadísticas aplicadas son los métodos para reducir la dimensión de los datos estadísticos. Se utilizan cada vez más en el análisis de datos en investigación aplicada específica, como la sociología. Investigamos los métodos más prometedores para reducir la dimensionalidad. Los principales componentes son uno de los métodos más utilizados para reducir la dimensionalidad. Para el análisis visual de los datos se utilizan a menudo las proyecciones de los vectores originales en el plano de los dos primeros componentes principales. Usualmente, la estructura de datos es claramente visible, resaltó clubsers compactos de objetos y vectores asignados por separado. Los componentes principales son un método de análisis factorial. La nueva idea de análisis factorial en comparación con el método de los componentes principales es que, según las cargas, los factores se rompen en grupos. En un grupo de factores, el nuevo factor se combina con un impacto similar en los elementos de la nueva base. Luego se recomienda a cada grupo para dejar un representante. A veces, en lugar de la elección del representante por cálculo, un nuevo factor que es fundamental para el grupo en cuestión. La dimensión reducida ocurre durante la transición a los factores del sistema, que son representantes de los grupos. Los factores de OTER se descartan. El uso de la distancia (medidas de proximidad, los indicadores de diferencias) entre las características y la clase extensa se basan en métodos de escala multidimensional. La idea básica de esta clase de métodos es presentar cada objeto como punto del espacio geométrico (generalmente de la dimensión 1, 2, o 3) cuyas coordenadas son los valores de los factores ocultos (latentes) que se combinan adecuadamente. Describe el objeto. Como ejemplo de la aplicación del modelado probabilístico y estadístico y los resultados de las estadísticas de los datos no numéricos, justificamos la consistencia de los estimadores de la

un objeto. Como ejemplo de la aplicación de modelos estadísticos probabilísticos y resultados de estadísticas no estadísticas, fundamentamos la consistencia de la medición de la dimensión del espacio de datos en la escala multidimensional, previamente propuesta por la colromal de las consideraciones heurísticas. Se consideró una serie de trabajos sobre la evaluación de las dimensiones de los modelos (en análisis de regresión y en la teoría de la clasificación). Dana información sobre la reducción de algoritmos de dimensión en un análisis cognitivo del sistema automatizado

Palabras clave: Matemáticas, estadísticas aplicadas, estadísticas matemáticas, puntos de crecimiento, método de componente principal, análisis factorial, escalado multidimensional, estimación de dimensión de datos, estimación del modelo de dimensión

dimensión de los datos en la escala multidimensional, que se proponen previamente por Kruskal de las consideraciones heurísticas. Hemos considerado una serie de estimaciones consistentes de dimensión de los modelos (en análisis de regresión y en teoría de la clasificación). También le damos alguna información sobre los algoritmos para reducir la dimensionalidad en el sistema automatizado del sistema cognitivo.

Palabras clave: Matemáticas, estadísticas aplicadas, estadísticas matemáticas, puntos de crecimiento, análisis de componentes principales, análisis factorial, escalado multidimensional, estimación de la dimensión de datos, estimación de la dimensión modelo

1. Introducción

Como ya se señaló, uno de los "puntos de crecimiento" de las estadísticas de la aplicación son métodos para reducir la dimensión del espacio de datos estadísticos. Se utilizan cada vez más en el análisis de datos en estudios aplicados específicos, por ejemplo, sociológicos. Considere los métodos más prometedores de dimensión reducida. Como ejemplo de la aplicación del modelado estadístico probabilístico y los resultados de las no estadísticas, justificamos la consistencia del tamaño del tamaño del espacio previamente propuesto por el curromo de las consideraciones heurísticas.

En el análisis estadístico multidimensional, cada objeto se describe por un vector, cuya dimensión es arbitraria (pero lo mismo para todos los objetos). Sin embargo, una persona puede percibir directamente solo datos numéricos o puntos en el plano. Analizar las acumulaciones de puntos en el espacio tridimensional ya es mucho más difícil. La percepción directa de los datos de la dimensión superior es imposible. Por lo tanto, bastante natural es el deseo de pasar de una muestra multidimensional a los datos de una pequeña dimensión para que "puedan

mira". Por ejemplo, un comercializador puede ver claramente cuántos tipos diferentes de comportamiento del consumidor (es decir, cuánto es aconsejable asignar segmentos de mercado) y qué propiedades son (con las propiedades) los consumidores en ellos.

Además del deseo de claridad, hay otros motivos para reducir la dimensión. Aquellos factores de los cuales la variable está interesada en el investigador no solo interfiere con el análisis estadístico. Los recursos primeros, financieros, temporales, temporales, se gastan en la recopilación de información sobre ellos. En segundo lugar, cómo demostrar, su inclusión en el análisis empeora las propiedades de los procedimientos estadísticos (en particular, aumenta la dispersión de las estimaciones de los parámetros y las características de las distribuciones). Por lo tanto, es deseable deshacerse de tales factores.

Al analizar datos multidimensionales, no uno, sino muchas tareas, en particular, la elección de variables independientes y dependientes de diferentes maneras. Por lo tanto, consideramos el problema de la dimensión reducida en la siguiente redacción. Muestra multidimensional Dana. Se requiere que se mueva de él a la totalidad de los vectores de una dimensión más pequeña, mientras que guarda la estructura de los datos de origen, si es posible, sin perder información contenida en los datos. La tarea se especifica dentro de cada método particular de la dimensión reducida.

2. Método del componente principal.

Es uno de los métodos de dimensión más utilizados. La idea principal es consistente con la detección de áreas en las que los datos tienen la mayor dispersión. Deje que la muestra consiste en vectores distribuidos igualmente con el vector x \u003d (x (1), x (2), ..., x (n)). Considerar combinaciones lineales

7 (^ (1), x (2) ,., L (n)) \u003d x (1) x (1) + x (2) x (2) + ... + l (n) x (n) .

X2 (1) + x2 (2) + ... + x2 (n) \u003d 1. Aquí, vector x \u003d (x (1), x (2), ..., x (n)) se encuentra en la unidad Esfera en el espacio p-dimensional.

En el método principal del componente, primero encontrará la dirección de la dispersión máxima, es decir, Dicha X, a la que la máxima dispersión de una variable aleatoria es 7 (x) \u003d 7 (x (1), x (2), ..., x (n)). Luego, el vector X establece el primer componente principal, y el valor de 7 (x) es la proyección del vector aleatorio X en el eje del primer componente principal.

Luego, expresar los términos de álgebra lineal, considere el hiperplano en el espacio p-dimensional, perpendicular al primer componente principal, y diseñe todos los elementos de la muestra en este hiperplano. La dimensión del hiperplano es 1 menor que la dimensión del espacio fuente.

En el hiperplano en consideración, se repite el procedimiento. Encuentra la dirección de la mayor dispersión, es decir,. Segundo componente principal. Luego se aísla el hiperplano perpendicular a los dos primeros componentes principales. Su dimensión es 2 menos que la dimensión del espacio fuente. Siguiente - la siguiente iteración.

Desde el punto de vista del álgebra lineal, estamos hablando de construir una nueva base en un espacio de p-dimensional, cuyos ITS sirven como los componentes principales.

Dispersión correspondiente a cada nuevo componente principal, menor que para el anterior. Por lo general, se detiene cuando es menor que el umbral especificado. Si se selecciona a los componentes principales, esto significa que desde el espacio de P-Dimensional fue posible ir a K-Dimensional, es decir, Reduzca la dimensión con P-A K, prácticamente sin distorsionar la estructura de los datos de origen.

Para el análisis visual de los datos, se utilizan las proyecciones de los vectores iniciales en el plano de los dos primeros componentes principales. Por lo general

la estructura de datos es claramente visible, se distinguen los grupos de objetos compactos y se distinguen por separado.

3. Análisis de factores

El método principal del componente es uno de los métodos de análisis factorial. Varios algoritmos para el análisis factorial se combinan por el hecho de que en todos ellos hay una transición a una nueva base en el espacio n-dimensional inicial. Importante es el concepto de "carga de factor" utilizada para describir el papel del factor de origen (variable) en la formación de un cierto vector de la nueva base.

La nueva idea en comparación con el método del componente principal es que, sobre la base de las cargas, los factores se dividen en grupos. En un grupo, se combinan factores, teniendo un efecto similar en los elementos de la nueva base. Luego, desde cada grupo, se recomienda dejar un representante. A veces, en lugar de elegir un representante, se forma un nuevo factor, lo que es fundamental para el grupo en consideración. La reducción de la dimensión ocurre durante la transición al sistema de factores que son representantes de grupos. Los factores restantes se descartan.

El procedimiento descrito se puede llevar a cabo no solo con la ayuda del análisis factorial. Estamos hablando En un análisis de clústeres de signos (factores, variables). Para dividir signos de grupos, se pueden aplicar varios algoritmos de análisis de clústeres. Es suficiente para ingresar la distancia (medida de proximidad, el indicador de diferencia) entre los signos. Sea x e y se dos signos. La diferencia D (X, Y) entre ellos se puede medir utilizando coeficientes de correlación selectiva:

di (x, y) \u003d 1 - \\ rn (x, y) \\, d2 (x, y) \u003d 1 - \\ pn (x, y) \\, donde RN (X, Y) es un coeficiente de correlación de Pearson lineal selectivo , PN (X, Y) es un coeficiente selectivo de la correlación del río del SPIRME.

4. Escalada multidimensional.

Sobre el uso de distancias (medidas de proximidad, indicadores de diferencias) D (x, y) entre los signos X y U, se basa la extensa clase de métodos de escalado multidimensional. La idea principal de este método de métodos es representar cada objeto del punto geométrico (generalmente la dimensión 1, 2 o 3), cuyas coordenadas sirven como valores de factores ocultos (latentes), que son Describiendo bastante adecuadamente el objeto. Al mismo tiempo, las relaciones entre objetos son reemplazadas por relaciones entre puntos: sus representantes. Entonces, datos sobre la similitud de los objetos, distancias entre puntos, los datos sobre superioridad, la ubicación mutua de los puntos.

5. El problema de evaluar la verdadera dimensión del espacio de factores.

En la práctica de analizar los datos sociológicos utilizados. diferentes modelos Escalamiento multidimensional. En todos ellos, el problema de evaluar la verdadera dimensión del espacio de factores. Considere este problema en el ejemplo de los datos de procesamiento sobre la similitud de los objetos que utilizan la escala métrica.

Sea los objetos N 0 (1), O (2), ..., O (n), para cada par de objetos 0 (/), O (J), se da la medida de su similitud S (IJ) . Creemos que siempre s (I, J) \u003d S (J, I). El origen del número S (IJ) no importa describir la operación del algoritmo. Podrían obtenerse mediante medición directa, o utilizando expertos, o calculando la combinación de características descriptivas, o de alguna manera, de alguna manera.

En el espacio euclidiano, los objetos n en consideración deben estar representados por la configuración de N puntos, y la distancia euclidiana D (I, J) aparece como la medida de la proximidad de los Puntos-Representantes

entre los puntos correspondientes. El grado de conformidad entre el conjunto de objetos y la combinación de sus puntos se determina comparando las matrices de similitud || I (,) || y distancias de la funcionalidad métrica SM de similitudes.

i \u003d £ | * (/,]) - th (/, m

La configuración geométrica debe seleccionarse para que los functantes cumplan su valor más pequeño.

Comentario. En la escala no conocida, en lugar de la proximidad de la proximidad y las distancias, se considera la proximidad de los pedidos en el conjunto de medidas de proximidad y el conjunto de distancias correspondientes. En lugar de los S funcionales, se utilizan los análogos de los coeficientes de rango de la correlación del Espíritu y Kendalla. En otras palabras, la escala no métrica proviene de la suposición de que las medidas de proximidad se miden en la escala ordinal.

Deje que el espacio euclidiano sea la dimensión t. Considere al menos el error cuadrado medio

donde se toma el mínimo en todas las configuraciones posibles de puntos en el espacio euclidiano T-MERNE. Se puede demostrar que el mínimo en cuestión se logra en alguna configuración. Está claro que con el crecimiento de T, el valor de la disminución de los de manera monótona (más precisamente, no aumenta). Se puede mostrar que en T\u003e P - 1 es igual a 0 (si - métrico). Para aumentar las posibilidades de interpretación significativa, es deseable actuar en el espacio posible menos dimensión. Sin embargo, al mismo tiempo, la dimensión debe ser elegida para que los puntos representen objetos sin una gran distorsión. Surge la pregunta: cómo elegir racionalmente la dimensión del espacio, es decir. Número natural t?

6. Modelos y métodos para estimar la dimensión del espacio de datos.

Como parte del análisis determinista de los datos de una respuesta razonable a esta pregunta, aparentemente no. Por lo tanto, es necesario estudiar el comportamiento de la AM en ciertos modelos probabilísticos. Si la proximidad de S (IJ) es valores aleatorios, la distribución de la cual depende de la "dimensión verdadera" M0 (y posiblemente de cualquier otro parámetro), en el estilo estadístico matemático clásico, para establecer la tarea de estimación M0, a Busque evaluaciones ricas y etc.

Vamos a empezar a construir modelos probabilísticos. Asumiremos que los objetos son puntos en el espacio euclidiano de la dimensión a, donde lo suficientemente grande. El hecho de que la "verdadera dimensión" sea igual a M0, significa que todos estos puntos se encuentran en el hiperplano de la dimensión M0. Aceptamos la certeza de que el conjunto de los puntos bajo consideración es una muestra de distribución normal circular con dispersión O (0). Esto significa que los objetos 0 (1), 0 (2), ..., O (n) son independientes en el agregado de vectores aleatorios, cada uno de los cuales se construye como

Z (1) e (1) + z (2) e (2) + ... + z (m0) e (m0), donde E (1), E (2), ..., E (M0) - base ortonormal en el subespacio de la dimensión M0, en la que los puntos considerados en consideración, y z (1), z (2), z (m0) son independientes en las variables aleatorias normales unidimensionales agregadas con expectativa matemática 0 y dispersión O (0).

Considere dos modelos para obtener la proximidad S (IJ). En la primera de estas, S (IJ) difieren de la distancia euclidiana entre los puntos correspondientes debido al hecho de que los puntos son conocidos por la distorsión. Deje que con (1), con (2), ..., c (n) - los puntos bajo consideración. Luego

s (I, J) \u003d D (C (I) + E (i), C (J) + S (/)), IJ \u003d 1, 2, ..., N,

donde Y es la distancia euclidiana entre los puntos en el espacio de medición, el vector E (1), E (2), ..., E (P) son una muestra de una distribución circular normal de un espacio de medición con una expectativa matemática cero. y una matriz de covarianza en (1) /, donde la matriz i-a -edite. En otras palabras,

e (0 \u003d P (1) E (1) + P (2) E (2) + ... + C (k) en (k), donde E (1), E (2), ... e (k) - base orthonormal en un espacio de medición, y [C ^^), I \u003d 1, 2, ..., P,? \u003d 1, 2, ..., K) es un conjunto de independientes en el agregado de variables aleatorias unidimensionales con cero expectativa matemática y dispersión de O (1).

En el segundo modelo de distorsión se impone directamente a las distancias en sí mismas:

Kch) \u003d th (f \\ s)) + £ (uh y \u003d 1, 2., n, i f j,

donde y, y en el primer intervalo, disminuye más rápido que en el segundo. Desde aquí sigue esa estadística

m * \u003d arg minam + 1 - 2am + an-x)

es una evaluación rica de la verdadera dimensión M0.

Por lo tanto, de la teoría probabilística implica la recomendación, como estimación de la dimensión del espacio factorial para usar t *. Tenga en cuenta que tal recomendación se formuló como una heurística de los fundadores de la escala multidimensional por J. Kraskal. Procedió de la experiencia del uso práctico de la escala multidimensional y los experimentos computacionales. La teoría probabilística hizo posible justificar esta recomendación heurística.

7. Evaluación de la dimensión del modelo.

Si es posible, los subconjuntos de signos forman una familia en expansión, por ejemplo, el grado de polinomio se estima, es natural introducir el término "dimensión modelo" (este concepto es en gran medida similar a la dimensión del espacio de datos en escala multidimensional). El autor de este artículo tiene una serie de trabajos en la evaluación de la dimensión del modelo, que es aconsejable comparar con el trabajo sobre la estimación de la dimensión del espacio de datos, discutido anteriormente.

El primer trabajo de este tipo fue realizado por el autor de este artículo durante un viaje a Francia en 1976. Se estudió una evaluación de la dimensión del modelo en regresión, a saber, una evaluación del grado de polinomio bajo el supuesto de que la dependencia Se describe por el polinomio. Esta estimación se conocía en la literatura, pero más tarde se equivocó a atribuir al autor de este artículo, que solo estudió sus propiedades, en particular, encontró que no es rico y encontró su distribución geométrica límite. Otros, ya se propusieron y estudiaron estimaciones ricas de la dimensión del modelo de regresión. Este ciclo completó el trabajo que contiene una serie de refinamientos.

La publicación extrema sobre este tema incluye una discusión sobre los resultados de estudiar la velocidad de la convergencia en los teoremas límite obtenidos por Monte Carlo.

Similar a la metodología para estimar la dimensión del modelo en el problema de las mezclas de división (parte de la teoría de la clasificación) se considera en el artículo.

Las estimaciones anteriores de la dimensión del modelo en la escala multidimensional se estudian en las obras. En las mismas obras, el comportamiento límite de las características del método de los componentes principales (utilizando la teoría asintótica del comportamiento de las decisiones de los problemas estadísticos extremos).

8. Algoritmos de reducción de dimensiones en un análisis automatizado del sistema cognitivo

El sistema automatizado-análisis cognitivo (ASC-análisis) también se propone en el sistema EIDOS, se implementa otro método de dimensión reducida. Se describe en el trabajo en las secciones 4.2 "Descripción de los algoritmos de las operaciones cognitivas básicas del análisis del sistema (BKOS)" y 4.3 "Los algoritmos de BKOS detallados (análisis de la solicitud)". Aquí breve descripción Dos algoritmos - BKOS-4.1 y BKOS-4.2.

BKosa-4.1. "La abstracción de factores (reduciendo la dimensión del espacio semántico de los factores)"

Usando el método de aproximaciones consecutivas (algoritmo iterativo), a una condición de límites dadas, la dimensión del espacio de atributos se reduce sin una disminución significativa en su volumen. El criterio para detener el proceso iterativo es lograr una de las condiciones de los límites.

BKOS-4.2. "Abstracción de clases (disminución de la dimensión del espacio semántico de las clases)"

Usando el método de aproximaciones consecutivas (algoritmo iterativo), en condiciones de límite específicas, el tamaño del espacio de las clases se reduce sin una reducción significativa en su volumen. El criterio para detener el proceso iterativo es lograr una de las condiciones de los límites.

Aquí están todos los algoritmos reales implementados en el sistema EIDOS de la versión que se implementó en el momento de la preparación del trabajo (2002): http: //lc.kubagro .ru / Aidos / Aidos02 / 4.3 .htm

La esencia de los algoritmos es la siguiente.

1. La cantidad de información se calcula en los valores de la transición del objeto al estado correspondiente a las clases.

2. Calcula el valor del valor del factor para la diferenciación del objeto por las clases. Este valor es simplemente la variabilidad de los informativos de los valores de los factores (medidas cuantitativas de variabilidad mucho: la desviación promedio de la media, la desviación del cuadrático promedio, etc.). En otras palabras, si en el valor del factor en promedio, hay poca información sobre la pertenencia y no pertenece al objeto a la clase, entonces este valor no es muy valioso, y si mucho es valioso.

3. Calcula el valor de las escalas descriptivas para la diferenciación de los objetos por las clases. En las obras de E.V. Lutsenko ahora se hace tan promedio de los valores de las gradaciones de esta escala.

4. Luego se realiza la optimización de la optimización de los valores de factores y escalas descriptivas:

Los valores de los factores (las gradaciones de la escala descriptiva) se clasifican en el orden de la disminución del valor y se eliminan del modelo el menos valioso, que van a la derecha de la Pareto-curva de 45 °;

Los factores (escalas descriptivas) se clasifican en orden de valor descendente y se eliminan del modelo de lo menos valioso, que van a la derecha de 45 ° la curva de paso.

Como resultado, la dimensión del espacio construida en las escalas descriptivas se reduce significativamente al eliminar las escalas que se correlacionan entre sí, es decir,. En esencia, es el espacio orthonormaling en una métrica de información.

Este proceso puede repetirse, es decir, ser iterativo al mismo tiempo nueva versión El sistema "Eidos" se inicia manualmente.

Del mismo modo, se omite el espacio de información de las clases.

La escala y las gradaciones pueden ser numéricas (entonces se procesan los valores de intervalo), y también pueden ser texto (ordinal o incluso nominal).

Por lo tanto, con la ayuda de los algoritmos BKOS (análisis de la solicitud), la dimensión del espacio se reduce al máximo con la pérdida mínima de información.

Para analizar los datos estadísticos en las estadísticas aplicadas, se han desarrollado una serie de algoritmos de reducción de dimensiones. Las tareas de este artículo no incluyen una descripción de todo el colector de tales algoritmos.

Literatura

1. ORLOV A.I. Puntos de crecimiento de métodos estadísticos // Polygrap Network Electronic Scientific Journal de la Universidad Agraria del Estado Kuban. 2014. No. 103. P. 136-162.

2. Pinte J. Relación entre la escala multidimensional y el análisis de clústeres // Clasificación y clúster. M.: Mir, 1980. C.20-41.

4. Harman G. Análisis de factores moderno. M.: Estadísticas, 1972. 489 p.

5. ORLOV A.I. Notas sobre la teoría de la clasificación. / Sociología: Metodología, Métodos, Modelos matemáticos. 1991. No. 2. C.28-50.

6. ORLOV A.I. Resultados básicos de la teoría matemática de la clasificación // Red Polymatic Diario Científico Electrónico de la Universidad Agraria del Estado Kuban. 2015. № 110. P. 219-239.

7. ORLOV A.I. Métodos matemáticos Teorías de clasificación // Red de polígrafo Diario Científico Electrónico de la Universidad Agraria del Estado Kuban. 2014. No. 95. P. 23 - 45.

8. Terekhina a.yu. Análisis de estos métodos de escala multidimensional. -M.: Ciencia, 1986. 168 p.

9. Perekrest V. T. Análisis tipológico no lineal de información socioeconómica: métodos matemáticos y computacionales. - L.: Ciencia, 1983. 176 p.

10. TYURIN YU.N., LITVAK B.G., ORLOV A.I., Sparariov G.A., Smerling D.S.S. Análisis de información no válida. M.: Consejo Científico de la Academia de Ciencias de la URSS en el complejo problema "Cybernetics", 1981. - 80 s.

11. ORLOV A.I. Una visión general de las estadísticas de objetos no naturales // análisis de información no informativa en estudios sociológicos. - M.: Ciencia, 1985. S.58-92.

12. ORLOV A.I. La distribución límite de una estimación del número de funciones básicas en la regresión // análisis estadístico multidimensional aplicado. Científicos en estadísticas, T.33. - M.: Ciencia, 1978. P.380-381.

13. ORLOV A.I. Evaluación de la dimensión del modelo en regresión // algorítmica y software Análisis estadístico aplicado. Científicos para estadísticas, T.36. - M.: Ciencia, 1980. P.92-99.

14. ORLOV A.I. Asintóticos de algunas estimaciones de la dimensión del modelo en regresión // estadísticas aplicadas. Científicos para estadísticas, T.35. - M.: Ciencia, 1983. P.260-265.

15. ORLOV A.I. En la evaluación del laboratorio de regresión polinomial // fábrica. Diagnóstico de materiales. 1994. T.60. № 5. P.43-47.

16. ORLOV A.I. Algunas preguntas de la teoría de la clasificación probabilística // estadísticas aplicadas. Científicos para estadísticas, T.35. - M.: Ciencia, 1983. C.166-179.

17. ORLOV A.I. En el desarrollo de las estadísticas de objetos no numéricos // diseño de experimentos y análisis de datos: nuevas tendencias y resultados. - M.: Antal, 1993. R.52-90.

18. ORLOV A.I. Métodos de reducción de la dimensión // Apéndice 1 al libro: Tolstova Yu.n. Conceptos básicos de la escala multidimensional: Tutorial Para las universidades. - M.: Editor CDU, 2006. - 160 p.

19. ORLOV A.I. Asintóticos de problemas estadísticos extremales // Análisis de datos no numéricos en estudios del sistema. Colección de labores. Vol. 10. - M.: Instituto de Investigación All-Union of System Research, 1982. P. 412.

20. ORLOV A.I. Modelado organizativo y económico: tutorial: en 3 horas. Parte 1: Estadísticas no compartidas. - M.: Publishing House MSTU. ANUNCIO Bauman. - 2009. - 541 p.

21. Lutsenko E.V. Análisis automatizado del sistema-cognitivo en la gestión de objetos activos (teoría del sistema de información y su aplicación en el estudio de los sistemas económicos, socio-psicológicos, tecnológicos y organizativos y técnicos): monografía (publicación científica). -Srasnodar: Kubgu. 2002. - 605 p. http://elibrary.ru/item.asp?id\u003d18632909.

1. ORLOV A.I. Tochki Rosta Statisticheskih Metodov // Politematicheskij setevoj Jelektronnyj Nauchnyj Zhurnal Kubanskogo Gosudarstvennogo Agrararnogo Universita. 2014. № 103. S. 136-162.

2. Kraskal DZH. Vzaimosvjaz "Mezhdu MNogomernym Shkalirovaniem I Klaster-Analizom // Klassifikacija I Klaster. M.: Mir, 1980. S.20-41.

3. Kruskal J.B., Wish M. M. Multidimensional Scaling // Sage University Paper Series: Aplicaciones cualitativas en las ciencias sociales. 1978. №11.

4. Harman G. Sovremennyj Faktorntyj Analiz. M.: Statistika, 1972. 489 s.

5. ORLOV A.I. Zametki Po Teorii Klassifikacii. / Sociologija: Metodologija, Metody, Matematicheskie Modeli. 1991. No. 2. S.28-50.

6. ORLOV A.I. Bazovye Rezul "Taty Matematicheskoj Teorii Klassifikacii // Politematicheskij setevoj Jelektronnyj Nauchnyj Zhurnal Kubanskogo Gosudarstvennogo Agrarnogo UniversiteTETA. 2015. № 110. S. 219-239.

7. ORLOV A.I. Matematicheskie metody teorii klassifikacii // politematicheskij setevoj jelektronnyj nauchnyj zhurnal kubanskogo gosudarstvennogo agranogo universita. 2014. № 95. S. 23 - 45.

8. Terehina a.JU. Analiz Dannyh Metodami MNOGOMERNOGO Shkalirovanija. - M.: Nauka, 1986. 168 s.

9. Perekrest v.t. Ninejnyj Tipologicheskij Analiz Social "No-Jekonomicheskoj Informacii: Matematicheskie I Vychislitel" Nye metody. - L.: Nauka, 1983. 176 s.

10. TJURIN JU.N., LITVAK B.G., ORLOV A.I., SAPAROV G.A., Shellling D.S.S. Analiz Nechislovoj Informacii. M.: NAUCHNYJ SOVET UN SSSR PO KOMPLEKSNOJ EUESTE "KIBERNETIKA", 1981. - 80 S.

11. ORLOV A.I. OBSHHIJ VZGLJAD NA Statistiku OB # Ektov Nechislovoj Prirodio // Analiz Nechislovoj Informacii V Sociologicheskih Issledovanijah. - M.: Nauka, 1985. S.58-92.

12. ORLOV A.I. PREDEL "NOE RASPREDLENIE ODNOJ Ocenki Chisla Bazisnyh Funkcij V Regressii // prikladnoj mnogomernyj statisticheskij analiz. Uchenye Zapiski Po Statistike, T.33. - M.: Nauka, 1978. S.380-381.

13. ORLOV A.I. Ocenka Razmernosti Modeli V Regressii // AlgoritMicheskoe I Programmnoe Obespechnie Prikladnogo Statisticheskogo Analiza. Uchenye Zapiski PO Statistikike, T.36. - M.: Nauka, 1980. S.92-99.

14. ORLOV A.I. Asimtotika Nekotoryh Ocenok Razmernosti Modeli V Regressii // PRIKLADNAJA Statistika. Uchenye Zapiski PO Statistike, T.45. - M.: Nauka, 1983. S.260-265.

15. ORLOV A.I. OB OCENIVANIII REGRESIONNOGO POLINOMA // ZAVODSKAA LaboratorIJA. Diagnostika Materialv. 1994. T.60. № 5. S.43-47.

16. ORLOV A.I. Nekotorye VerojatnostNOE VOPROSY TEORII KLASSIFIKACII // PRIKLADNAJA Statistika. Uchenye Zapiski PO Statistike, T.45. - M.: Nauka, 1983. S.166-179.

17. ORLOV A.I. En el desarrollo de las estadísticas de objetos no numéricos // diseño de experimentos y análisis de datos: nuevas tendencias y resultados. - M.: Antal, 1993. R.52-90.

18. ORLOV A.I. Metody Snizhenija Razmernosti // Prilozenie 1 K KNIGE: TOLSTOVA JU.N. Osnovy MNogomernogo Shkalirovanija: Uchebnoe Posobre DLJA VUZOV. - M.: IZDATEL "STVO KDU, 2006. - 160 S.

19. ORLOV A.I. Asimptotika resenij jekstremal "NYH Statisticheskih Zadach // Analiz Nechislovyh Dannyh v Sistemnyh Issledovanijah Sbornik Trudov Vyp.10 -... M.: Vsesojuznyj Nauchno-Issledovatel" Skij Institut Sistemnyh Issledovanij, 1982. S. 4-12.

20. ORLOV A.I. OrganizacionNo-Jekonomicheskoe Modelirovanie: Uchebnik: v 3 CH. CHAST "1: NechIstovaja Statistika. - M.: IZD-VO MGTU IM. N.JE. BAUMANA. - 2009. - 541 s.

21. Lucenko E.V. Avtomatizirovannyj sistemno-kognitivnyj analiz v upravlenii aktivnymi ob # ektami (sistemnaja teorija informácií i ee primenenie v issledovanii jekonomicheskih, social "no-psihologicheskih, tehnologicheskih i-organizacionno tehnicheskih Sistem): Monografija (nauchnoe Izdanie) - Krasnodar :. KubGAU 2002. -. 605 s. Http://elibrary.ru/item.asp?id\u003d18632909

Como resultado del estudio del material del Capítulo 5, el estudiante debe:

saber

- Conceptos básicos y tareas de dimensión inferior:

- Se acerca a resolver el problema de la transformación del espacio de características;

ser capaz de

- Use el método del componente principal para la transición a las características ortogonales estandarizadas;

- evaluar la reducción de datos informativos cuando una disminución en la dimensión del espacio de características;

- resolver el problema de construir escalas óptimas multidimensionales para investigar objetos;

propio

- Métodos para reducir la dimensión para resolver tareas aplicadas de análisis estadístico;

- Habilidades de interpretación de variables en un signo transformado.

Conceptos básicos y tareas de dimensión inferior.

A primera vista que más información Los objetos del estudio en forma de un conjunto de caracterización de sus signos se utilizarán para crear un modelo, mejor. Sin embargo, la cantidad excesiva de información puede llevar a una disminución en la efectividad del análisis de datos. Incluso hay el término "maldición de la dimensión" Maldición de dimensionalidad), caracterizando problemas de trabajo con datos altamente de productos. Con la necesidad de reducir la dimensión de una forma u otra, la solución se asocia con varios problemas estadísticos.

Las características no informativas son una fuente de ruido adicional y afectan la precisión de la valoración de los parámetros del modelo. Además, los conjuntos de datos con una gran cantidad de características pueden contener grupos de variables correlacionadas. La presencia de tales signos de signos significa duplicar información que puede distorsionar la especificación del modelo y afectar la calidad de sus parámetros. Cuanto mayor sea la dimensión de los datos, mayor será el volumen de cálculos durante su procesamiento algorítmico.

Dos direcciones se pueden distinguir para reducir la dimensión del espacio de características en el principio de las variables utilizadas para esto: selección de señales del conjunto de fuentes existentes y la formación de nuevas características mediante la transformación de los datos iniciales. En el caso ideal, la representación abreviada de los datos debe tener dimensión correspondiente a la dimensión, datos inherentes internamente. Dimensión intrínseca.

La búsqueda de las características más informativas que caracteriza el fenómeno estudiado es una dirección obvia de reducir la dimensión del problema que no requiere la transformación de las variables de origen. Esto le permite hacer que un modelo sea más compacto y evite las pérdidas asociadas con el efecto interferido de las características de baja informativa. La selección de características informativas es encontrar el mejor subconjunto de muchas variables de origen. Los criterios del concepto de "mejor" pueden servir o más. alta calidad Simulación con una dimensión dada del espacio de características, o la dimensión más pequeña de los datos en los que es posible crear un modelo de la calidad especificada.

Solución directa a la tarea de crear. mejor modelo Relacionado con el busto de todas las combinaciones posibles de señales, que suele ser excesivamente laborioso. Por lo tanto, como regla general, recurren a la selección de señales directas o revertidas. En los procedimientos de selección directa, se realiza una adición secuencial de variables del conjunto original para lograr la calidad deseada del modelo. En los algoritmos de la reducción constante del espacio de características original (selección inversa), existe una eliminación gradual de las variables menos informativas a la reducción permitida en el contenido de información del modelo.

Debe tenerse en cuenta que la informatividad de los signos es relativa. La selección debe garantizar una alta informatividad del conjunto de características, y no la información total de los componentes de sus variables. Por lo tanto, la presencia de correlación entre señales reduce su informatividad general debido a la duplicación de la información común a ellos. Por lo tanto, agregar una nueva característica a la ya seleccionada asegura un aumento en la informatividad en la medida en que contiene información útilADULTEBLE en variables previamente seleccionadas. La situación más simple es la situación de la selección de signos mutuamente ortogonales, en los que el algoritmo de selección es muy simple: las variables se clasifican en la informatividad, y se utiliza la composición de los primeros signos en esta clasificación, lo que garantiza la informatividad específica.

El método limitado de los métodos de selección para reducir la dimensión del espacio se asocia con el supuesto de la presencia inmediata de los signos necesarios en los datos de origen, lo que suele ser incorrecto. Un enfoque alternativo a una reducción en la dimensión proporciona la conversión de características en un conjunto reducido de nuevas variables. A diferencia de la selección de los signos originales, la formación de un nuevo espacio de características implica la creación de nuevas variables, que generalmente son funciones de los signos de origen. Estas variables observadas directamente a menudo se llaman ocultas, o latente. En el proceso de creación, estas variables pueden dotarse de diversas propiedades útiles, como la ortogonalidad. En la práctica, los signos iniciales generalmente se interrelacionan, por lo tanto, la transformación de su espacio a ortogonal genera nuevas coordenadas, en las que no hay efecto de duplicar información sobre los objetos estudiados.

La visualización de objetos en un nuevo espacio de características ortogonales crea la capacidad de presentar visualmente la utilidad de cada uno de los signos desde el punto de vista de las diferencias entre estos objetos. Si las coordenadas de la nueva base están organizadas por dispersión caracterizando el rango de valores en ellos para las observaciones en consideración, se convierte en una imposibilidad obvia desde un punto de vista práctico de algunas características con pequeñas variables, ya que los objetos en estas características son prácticamente indistinguible en comparación con sus diferencias en variables más informativas. En tal situación, podemos hablar de la llamada degeneración del espacio inicial de características de k. Variables y la dimensión real de este espacio. t. puede ser menos fuente (m< k.).

La reducción del espacio de características se acompaña de una cierta disminución en la información de datos, pero el nivel de reducción permisible puede determinarse de antemano. La selección de características es proyectar un conjunto de variables de origen en un espacio de dimensión más pequeño. La compresión del espacio de características a dos-tridimensionales puede ser útil para la visualización de datos. Por lo tanto, el proceso de formación de un nuevo espacio de características generalmente conduce a un conjunto más pequeño de variables realmente informativas. En su base, se puede construir un modelo mejor en función de un número menor de las características más informativas.

La formación de nuevas variables basadas en la fuente se utiliza para el análisis semántico latente, la compresión de datos, la clasificación y el reconocimiento de las imágenes, aumentan la velocidad y la eficiencia de los procesos de aprendizaje. Los datos comprimidos se aplican generalmente a un análisis y modelado adicionales.

Una de las aplicaciones importantes para la transformación del espacio de características y reducir la dimensión es construir categorías latentes sintéticas basadas en los signos medidos de signos. Estos signos latentes pueden caracterizar las características específicas generales del fenómeno que integran las propiedades privadas de los objetos observados, lo que nos permite crear indicadores integrados de varios niveles de generalización de la información.

El papel de los métodos para la reducción del espacio de características en el estudio del problema de la duplicación de la información en los signos iniciales, lo que lleva a la "hinchazón" de la dispersión de las estimaciones de los coeficientes de los modelos de regresión, es esencial. Transición al nuevo caso ideal ortogonal y significativo interpretable, las variables es herramienta efectiva Modelado bajo las condiciones de la multicolinealidad de los datos de origen.

La transformación del espacio de características iniciales en orthogonal es conveniente para resolver las tareas de clasificación, ya que hace posible aplicar razonablemente ciertas medidas de proximidad o diferencias en los objetos, como la distancia euclidiana o el cuadrado de la distancia euclidiana. En el análisis de regresión, la construcción de la ecuación de regresión en los componentes principales permite resolver el problema de la multicolinealidad.

Magnetometría en la versión más sencilla El Ferrozond consiste en un núcleo ferromagnético y dos bobinas en él

Magnetometría en la versión más sencilla El Ferrozond consiste en un núcleo ferromagnético y dos bobinas en él Búsqueda de curso de búsqueda de trabajo efectivo

Búsqueda de curso de búsqueda de trabajo efectivo Las principales características y parámetros del fotodiodo.

Las principales características y parámetros del fotodiodo. Cómo editar PDF (cinco aplicaciones para cambiar archivos PDF) Cómo eliminar páginas individuales de PDF

Cómo editar PDF (cinco aplicaciones para cambiar archivos PDF) Cómo eliminar páginas individuales de PDF ¿Por qué la ventana del programa de despedida se desarrolla durante mucho tiempo?

¿Por qué la ventana del programa de despedida se desarrolla durante mucho tiempo? DXF2TXT - Exportación y traducción del texto desde AutoCAD para mostrar un punto de tráfico DWG en TXT

DXF2TXT - Exportación y traducción del texto desde AutoCAD para mostrar un punto de tráfico DWG en TXT Qué hacer si el cursor del mouse desaparece.

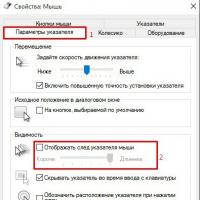

Qué hacer si el cursor del mouse desaparece.