Análisis de grandes cantidades de información y. El uso de grandes datos en medicina. Grandes problemas de uso Big Data

Se prevé que el volumen global general de datos creados y replicados en 2011 puede ascender a aproximadamente 1,8 SATETTA (1,8 billones de gigabyte), aproximadamente 9 veces más que lo que se creó en 2006.

Definición más compleja

Sin embargo ` datos grandes`Invite más que un análisis de enormes cantidades de información. El problema no es que las organizaciones creen enormes cantidades de datos, y en el hecho de que la mayoría de ellos se presentan en un formato, poco relevante para el formato de base de datos estructurado tradicional: estos son registros web, grabaciones de video, documentos de texto, código de máquina o , por ejemplo, datos geoespaciales. Todo esto se almacena en muchos repositorios diversos, a veces incluso fuera de la organización. Como resultado, la corporación puede tener acceso a la gran cantidad de sus datos y no tener herramientas requeridasPara establecer relaciones entre estos datos y hacer conclusiones significativas basadas en ellos. Agregue aquí el hecho de que los datos ahora se actualizan cada vez más y más a menudo, y obtendrá una situación en la que los métodos tradicionales para analizar la información no pueden afectar las enormes cantidades de datos actualizados, que al final y abre las tecnologías de la carretera. datos grandes.

Mejor definición

En esencia, el concepto. datos grandes Implica trabajar con la información de un gran volumen y una variedad de composición, muy a menudo actualizada y ubicada en diferentes fuentes para aumentar la eficiencia del trabajo, crear nuevos productos y aumentar la competitividad. La empresa de consultoría Forrester ofrece una breve redacción: ` Datos grandes Combine las técnicas y tecnologías que eliminan el significado de los datos sobre el límite extremo de la practicidad.

¿Qué tan grande es la diferencia entre la analítica empresarial y los grandes datos?

Craig Bati, Director Ejecutivo de Marketing y Director de Fujitsu Australia Technologies, indicó que el análisis empresarial es un proceso descriptivo para analizar los resultados logrados por el negocio en un determinado período de tiempo, mientras que la velocidad de procesamiento datos grandes Le permite hacer un análisis predictivo, capaz de ofrecer recomendaciones de negocios para el futuro. La tecnología de datos grande también le permite analizar más tipos de datos en comparación con las herramientas de análisis empresarial, lo que hace posible que se centre no solo en las instalaciones de almacenamiento estructuradas.

Matt Slocum de O "Reilly Radar cree que aunque datos grandes Y los analistas de negocios tienen el mismo objetivo (búsqueda de respuestas a la pregunta), difieren entre sí en tres aspectos.

- Los datos grandes están diseñados para manejar cantidades más significativas de información que el analista de negocios, y esto, por supuesto, corresponde a la definición tradicional de datos grandes.

- Los grandes datos están destinados a su procesamiento más rápidamente obtenido y cambiando información, lo que significa investigación profunda e interactividad. En algunos casos, los resultados se forman más rápido de lo que se carga la página web.

- Los datos grandes están destinados a procesar datos no estructurados, cuyos métodos de uso solo comenzamos a estudiar después de poder establecer su recopilación y almacenamiento, y requerimos algoritmos y la posibilidad de diálogo para facilitar la búsqueda de tendencias contenidas dentro de estas matrices.

Según un libro blanco publicado de Oracle "Oracle Information Architecture: Guía de arquitecto para grandes datos. (Arquitectura de la información de Oracle: la guía de un arquitecto de los grandes datos), cuando se trabaja con grandes datos, abordamos información de lo contrario al realizar el análisis de negocios.

Trabajar con datos grandes no es similar al proceso de inteligencia de negocios habitual, donde una simple adición de valores conocidos trae el resultado: por ejemplo, el resultado de la adición de las cuentas pagadas se está convirtiendo en un volumen de ventas para el año. Cuando se trabaja con datos grandes, el resultado se obtiene en el proceso de limpieza por el modelado sucesivo: primero se presenta la hipótesis, se construye un modelo estadístico, visual o semántico, la lealtad a las hipótesis extendidas su base se verifica y luego la El siguiente se presenta. Este proceso requiere un investigador o interpretación de los valores visuales o la compilación de consultas basadas en el conocimiento interactivo, o el desarrollo de la formación de máquinas de algoritmos adaptativos, capaz de obtener el resultado deseado. Y la vida útil de un algoritmo de este tipo puede ser bastante corta.

Métodos para analizar grandes datos.

Hay muchos métodos diversos para analizar las matrices de datos, que se basan en herramientas tomadas prestadas de estadísticas y informática (por ejemplo, aprendizaje automático). La lista no pretende estar completa, pero refleja los enfoques más demandados en diversas industrias. Al mismo tiempo, debe entenderse que los investigadores continúan trabajando para crear nuevas técnicas y mejorar las existentes. Además, algunos de estos métodos no se aplican necesariamente exclusivamente a datos grandes y se pueden usar con éxito para arreglos más pequeños (por ejemplo, pruebas A / B, análisis de regresión). Por supuesto, se analiza la matriz más volumétrica y diversificada, los datos más precisos y relevantes se pueden obtener en la salida.

Pruebas A / B. La técnica en la que la muestra de control se compara alternativamente con otros. Por lo tanto, es posible identificar la combinación óptima de indicadores para lograr, por ejemplo, la mejor respuesta de los consumidores para una oferta de marketing. Datos grandes Le permite pasar una gran cantidad de iteraciones y, por lo tanto, obtener un resultado estadísticamente confiable.

Regla de la asociación Aprendizaje. Un conjunto de técnicas para identificar las relaciones, es decir, Reglas asociativas entre variables en grandes matrices de datos. Utilizado B. procesamiento de datos..

Clasificación. Un conjunto de técnicas que le permite predecir el comportamiento de los consumidores en un segmento de mercado específico (tomando decisiones sobre la compra, la salida, el volumen de consumo, etc.). Utilizado B. procesamiento de datos..

Análisis de conglomerados.. El método estadístico de clasificar los objetos por grupos mediante la detección de características comunes no conocidas. Utilizado B. procesamiento de datos..

Crowdsourcing.. Metodología de recolección de datos de gran número Fuentes.

Fusión de datos y integración de datos.. Un conjunto de técnicas que le permite analizar los comentarios de los usuarios de las redes sociales y comparar los resultados de las ventas en tiempo real.

Procesamiento de datos.. Un conjunto de técnicas que le permite determinar lo más susceptible a la categoría de producto o servicio progresivo de los consumidores, identificar las características de los empleados más exitosos, predicen un modelo de comportamiento de los consumidores.

Ensemble Aprendizaje. En este método, muchos modelos predicativos están involucrados a expensas de los cuales se realizan la calidad de las predicciones.

Algoritmos genéticos.. En esta técnica soluciones posibles Representan en la forma `cromosoma`, que se puede combinar y mutuamente. Como en el proceso de evolución natural, el individuo más adaptado sobrevive.

Aprendizaje automático. La dirección en la ciencia informática (históricamente, el nombre de la "inteligencia artificial) se arraigó históricamente, lo que persigue el objetivo de crear algoritmos de autoaprendizaje basados \u200b\u200ben un análisis de datos empíricos.

Procesamiento natural del lenguaje (NLP.). Conjunto de prestados de técnicas de informática y lingüística para reconocer el lenguaje natural de una persona.

Análisis de red. Un conjunto de métodos para analizar enlaces entre nodos en redes. Con respecto a las redes sociales le permite analizar la relación entre usuarios individuales, empresas, comunidades, etc.

Mejoramiento. Un conjunto de métodos numéricos para rediseñar sistemas complejos y procesos para mejorar uno o más indicadores. Ayuda a tomar decisiones estratégicas, por ejemplo, la composición de la línea de productos se inició al mercado, el análisis de inversiones, etc.

Reconocimiento de patrones. Un conjunto de técnicas con elementos de autoaprendizaje para predecir un modelo de comportamiento del consumidor.

Modelado predictivo. Un conjunto de técnicas que permiten crear un modelo matemático antes del escenario de desarrollo de eventos probable especificado. Por ejemplo, se le solicitará un análisis de las indicaciones de base de datos de CRM para las posibles condiciones que se le pedirá a los suscriptores que cambien el proveedor.

Regresión. Un conjunto de métodos estadísticos para identificar patrones entre un cambio en la variable dependiente y uno o más independientes. A menudo se utiliza para pronosticar y predicciones. Utilizado en la minería de datos.

Análisis de los sentimientos. Los métodos para evaluar el sentimiento del consumidor se basan en las técnicas de reconocimiento del idioma humano. Te permiten ser sacado del general flujo de información Mensajes relacionados con el tema de interés (por ejemplo, por el producto del consumidor). Luego de estimar la polaridad del juicio (positivo o negativo), el grado de emocionalidad, y así sucesivamente.

Procesamiento de la señal.. Tomado prestado de la ingeniería de radio Un conjunto de técnicas que persiguen el objetivo de reconocimiento objetivo contra el fondo del ruido y su análisis adicional.

Análisis espacial. El conjunto de parcialmente prestados de los métodos estadísticos para analizar datos espaciales: topología del terreno, coordenadas geográficas, geometría de objetos. Fuente datos grandes En este caso, los sistemas de información geográfica a menudo realizan (GIS).

Estadísticas. Recolección de ciencia, organización e interpretación de datos, incluido el desarrollo de cuestionarios y experimentos de conducción. Los métodos estadísticos se utilizan a menudo para conjugaciones estimadas sobre las relaciones entre esas u otros eventos.

Aprendizaje supervisado. Métodos de mecanizado basados \u200b\u200ben técnicas de aprendizaje de la máquina que le permiten identificar relaciones funcionales en las matrices de datos analizadas.

Simulación. El modelado del comportamiento de los sistemas complejos se usa a menudo para predecir, la predicción y el estudio de varios scripts al planificar.

Análisis de series temporales. Conjunto de prestados de estadísticas y procesamiento digital Señales de analizar los métodos repetidos a lo largo del tiempo de las secuencias de datos. Algunas de las aplicaciones obvias están rastreando el mercado de valores o la incidencia de pacientes.

Aprendizaje sin supervisión. Un conjunto de técnicas de aprendizaje de la máquina basadas en técnicas de aprendizaje de la máquina que le permiten identificar relaciones funcionales ocultas en las matrices de datos analizadas. Tiene características comunes con Análisis de conglomerados..

Visualización. Métodos representación gráfica Los resultados del análisis de grandes datos en forma de diagramas o imágenes animadas para simplificar la interpretación de facilitar la comprensión de los resultados obtenidos.

Una representación visual de los resultados de un gran análisis de datos es de importancia fundamental para su interpretación. No es un secreto que la percepción humana es limitada, y los científicos continúan realizando investigaciones en el campo de mejorar los métodos de presentación de datos modernos en forma de imágenes, diagramas o animaciones.

Kit de herramientas analíticas

Para 2011, algunos de los enfoques enumerados en la subsección anterior o su combinación definitiva permiten implementar motores analíticos para trabajar con grandes datos en la práctica. De los sistemas de análisis de big Data Big Free o relativamente económicos, puede recomendar:

- Revolución Analytics (basada en el lenguaje R para la estera. Piezas).

De particular interés en esta lista, representa a Apache Hadoop, por código abierto, que en los últimos cinco años se ha probado como analizador de los datos por la mayoría de las acciones de rastreadores. Tan pronto como Yahoo abrió el código Hadoop con una comunidad de código abierto, una dirección completa para crear productos basados \u200b\u200ben Hadoop apareció en la industria de TI. Casi todos los medios modernos de análisis. datos grandes Proporcionar herramientas de integración con Hadoop. Sus desarrolladores actúan como startups y compañías mundiales bien conocidas.

Mercados soluciones para gestionar grandes datos.

Grandes plataformas de datos (BDP, plataforma de datos grandes) como un medio para combatir las tareas digitales

Capacidad para analizar datos grandes, En la sorpresa llamados grandes datos, percibidos como un bien, y definitivamente. ¿Pero es realmente? ¿Qué puede la acumulación de datos rampantes? Lo más probable es que el hecho de que los psicólogos nacionales en relación con el hombre se llaman almacenamiento patológico, silhloromicia o síndrome de piel figurativamente ". En inglés, una pasión viciosa de recoger todo en una fila se llama Hording (de la acumulación de inglés - "Stock"). Según la clasificación de las enfermedades mentales, el coro de coroderado se cuenta para trastornos mentales. El acaparamiento digital (acaparamiento digital) se agrega a la era digital, pueden sufrir tanto identidades individuales como a empresas y organizaciones completas ().

Mercado mundial y ruso

Big Data Paisaje - Principales proveedores

Interés en las herramientas para la recopilación, procesamiento, gestión y análisis. datos grandes Expuso todas las compañías líderes de TI, que es bastante natural. Primero, enfrentan directamente este fenómeno en su propio negocio, en segundo lugar, datos grandes Abrir excelentes oportunidades para el desarrollo de nuevos nichos del mercado y atraer nuevos clientes.

Muchas detenciones de startups aparecieron en el mercado que hacen un negocio en el procesamiento de enormes matrices de datos. Algunos de ellos usan la infraestructura de nube terminada proporcionada por jugadores grandes Como Amazon.

Teoría y práctica de grandes datos en industrias.

Historia del desarrollo

2017

TmaxSoft Prevetast: Los siguientes datos de "WAVE" requerirán la actualización del DBMS

Se sabe que las empresas en sus enormes cantidades de datos, existe información importante sobre sus negocios y clientes. Si la compañía puede aplicar con éxito esta información, entonces tendrá una ventaja significativa en comparación con los competidores, y podrá ofrecer lo mejor que ellos, productos y servicios. Sin embargo, muchas organizaciones aún no pueden usar efectivamente datos grandes Debido al hecho de que su infraestructura de TI heredada no puede proporcionar la capacidad necesaria de los sistemas de almacenamiento, los procesos de intercambio de datos, las utilidades y las aplicaciones necesarias para procesar y analizar grandes matrices de datos no estructurados para extraer información valiosa de ellos indicados en TmaxSoft.

Además, un aumento en la capacidad del procesador necesaria para el análisis de los volúmenes de datos que aumentan constantemente puede requerir inversiones significativas en la infraestructura de TI desactualizada de la organización, así como recursos adicionales de apoyo que podrían usarse para desarrollar nuevas aplicaciones y servicios.

El 5 de febrero de 2015, la Casa Blanca publicó un informe en el que se discutió la pregunta de cómo datos grandes»Establecer diversos precios para diferentes compradores: práctica conocida como" discriminación de precios "o" precios diferenciados "(precios personalizados). El informe describe el beneficio de "grandes datos", tanto para vendedores como para compradores, y sus autores llegan a la conclusión de que muchos problemas problemáticos derivados del advenimiento de los grandes datos y los precios diferenciados se pueden resolver en el marco de la legislación existente contra la discriminación y Leyes que protegen los derechos del consumidor.

El informe señala que en este momento solo hay hechos individuales que indican cómo las empresas utilizan grandes datos en el contexto de la comercialización individualizada y los precios diferenciados. Esta información muestra que los vendedores utilizan métodos de precios que se pueden dividir en tres categorías:

- estudio de la curva de la demanda;

- Orientación (dirección) y precios diferenciados basados \u200b\u200ben datos demográficos; y

- marketing de comportamiento objetivo (focalización de comportamiento: objetivo conductual) y precios individualizados.

Estudiando curva de demanda: Para aclarar la demanda y el estudio del comportamiento de los consumidores, los comercializadores a menudo realizan experimentos en esta área, durante los cuales, una de las dos categorías de precios posibles es nombrada aleatoriamente por parte de los clientes. "Técnicamente, estos experimentos son la forma de precios diferenciados, ya que su consecuencia se convierte en precios diferentes para los clientes, incluso si son" no discriminatorios "en el sentido de que todos los clientes tienen la probabilidad de" obtener "a un precio más alto de la misma. "

DIRECCION): Esta es la práctica de presentar productos a los consumidores en función de su pertenencia a un grupo demográfico específico. Así, sitio web empresa informática puede ofrecer una y la misma computadora portátil con varios tipos de compradores a precios diferentes, se estableció sobre la base de la información reportada por ellos (por ejemplo, dependiendo de si este usuario Representante de organismos estatales, instituciones científicas o comerciales, o por una persona privada) o de su ubicación geográfica (por ejemplo, definida por la dirección IP de la computadora).

Marketing de comportamiento objetivo y precios individualizados.: En estos casos, los datos personales de los compradores se utilizan para publicidad dirigida y precios personalizados para ciertos productos. Por ejemplo, los anunciantes en línea utilizan recopilados por redes de publicidad y a través de las cookies de datos de terceros sobre la actividad de los usuarios en Internet para apuntar a enviar sus materiales promocionales. Tal enfoque, por un lado, hace posible que los consumidores reciban publicidad de bienes y servicios para ellos, sin embargo, pueden causar las preocupaciones de aquellos consumidores que no desean ciertos tipos de sus datos personales (como información sobre Los sitios visitantes relacionados con los problemas médicos y financieros) fueron recolectados sin su consentimiento.

Aunque el marketing conductual específico está generalizado, existe una evidencia relativamente pequeña de precios individualizados en el entorno en línea. El informe sugiere que esto puede deberse al hecho de que aún se están desarrollando los métodos correspondientes, o con el hecho de que las empresas no tienen prisa por usar precios individuales (o prefieren alabar al respecto), tal vez, temiendo la reacción negativa de la reacción negativa de consumidores.

Los autores del informe creen que "para un consumidor individual, el uso de grandes datos se debe, sin duda, a ambos posibles retornos y riesgos". Al reconocer que al usar datos grandes, aparecen problemas de transparencia y discriminación, el informe al mismo tiempo afirma que las leyes existentes contra la discriminación y las leyes de protección al consumidor son suficientes para resolverlas. Sin embargo, el informe también enfatiza la necesidad de "control continuo" en los casos en que las empresas usen información confidencial por una manera opaca o métodos que no están cubiertos por un marco regulatorio existente.

Este informe es una continuación de los esfuerzos de la Casa Blanca para estudiar el uso de "Big Data" y los precios discriminatorios en Internet, y las consecuencias relevantes para los consumidores estadounidenses. Anteriormente, ya se ha informado de que el grupo de trabajo de la Casa Blanca para grandes datos ha publicado su informe sobre este tema en mayo de 2014. La Comisión Federal de Comercio (FTC) también consideró estos temas durante el seminario sobre la discriminación en septiembre de 2014 en septiembre de 2014 debido al uso de grandes datos.

2014

Gartner disipa los mitos sobre "Big Data"

En la nota analítica de la caída de 2014, Gartner enumeró varios de los mitos comunes entre los gerentes de TI con respecto a grandes datos y su refutación.

- Todos están implementando grandes sistemas de procesamiento de datos más rápido que nosotros

Se registra el interés en las tecnologías de datos más grandes: 73% de las organizaciones encuestadas por los analistas de Gartner este año ya invierten en proyectos relevantes o se recopilan. Pero la mayoría de estas iniciativas todavía están en las primeras etapas, y solo el 13% de los encuestados ya han implementado tales soluciones. Lo más difícil es determinar cómo extraer los ingresos de los datos grandes, decida dónde comenzar. En muchas organizaciones están atrapadas en la etapa piloto, porque no pueden unirse. nueva tecnología a procesos de negocios específicos.

- Tenemos tantos datos que no hay que preocuparse por pequeños errores en ellos.

Algunos gerentes de TI creen que las fallas pequeñas en los datos no afectan los resultados generales del análisis de enormes volúmenes. Cuando hay muchos datos, cada error por separado, tiene menos afecta el resultado, los analistas siguen, pero también se vuelven más. Además, la mayoría de los datos analizados son una estructura u origen externa, desconocida, por lo que la probabilidad de errores está creciendo. Así, en el mundo de los grandes datos, la calidad es en realidad mucho más importante.

- Gran tecnología de datos cancelará la necesidad de integrar datos.

Las grandes datos prometen la capacidad de procesar datos en un formato original con formación automática del circuito a medida que se lee. Se cree que esto permitirá analizar información de las mismas fuentes utilizando múltiples modelos de datos. Muchos creen que también permitirá a los usuarios finales interpretar cualquier conjunto de datos a su discreción. En realidad, la mayoría de los usuarios a menudo necesitan una forma tradicional con esquema terminadoCuando los datos se formaten en consecuencia, existen acuerdos sobre el nivel de integridad de la información y cómo debe relacionarse con el escenario de uso.

- El almacén de datos no tiene sentido usar para un análisis complejo.

Muchos administradores de los sistemas de gestión de la información creen que no tiene sentido dedicar tiempo a crear un almacén de datos, teniendo en cuenta que los sistemas analíticos complejos utilizan nuevos tipos de datos. De hecho, en muchos sistemas de análisis complejos utiliza información del almacenamiento de datos. En otros casos, los nuevos tipos de datos deben estar preparados adicionalmente para analizar en grandes sistemas de procesamiento de datos; Es necesario tomar decisiones sobre la idoneidad de los datos, los principios de agregación y el nivel de calidad necesario, dicha preparación puede ocurrir fuera del repositorio.

- Los lagos de datos llegarán a cambiar las instalaciones de almacenamiento de datos.

En realidad, los proveedores son clientes engañosos, posicionando los lagos de datos (Data Lake) como reemplazo de instalaciones de almacenamiento o como elementos críticos de la infraestructura analítica. Las tecnologías fundamentales de los lagos de los datos carecen de la madurez y la latitud de la funcionalidad inherente a las instalaciones de almacenamiento. Por lo tanto, los líderes responsables de administrar los datos deben esperar hasta que los lagos alcancen el mismo nivel de desarrollo, creen en Gartner.

Accenture: el 92% del sistema de implementación de datos grandes se satisface con el resultado

Entre las principales ventajas de los grandes datos, los encuestados llamados:

- "Búsqueda de nuevas fuentes de ingresos" (56%),

- "Mejora de la experiencia del cliente" (51%),

- "Nuevos productos y servicios" (50%) y

- "La afluencia de nuevos clientes y la preservación de la lealtad más antigua" (47%).

En la introducción de nuevas tecnologías, muchas empresas enfrentaron problemas tradicionales. Para un resumen del 51%, la seguridad fue, por 47% - presupuesto, para el 41%: la falta de marcos necesarios, y para una complejidad del 35% al \u200b\u200bintegrarse con un sistema existente. Casi todas las compañías encuestadas (alrededor del 91%) están planeando resolver el problema con la falta de personal y contratar especialistas de grandes datos.

Las empresas optimistas evalúan las futuras tecnologías de los grandes datos. El 89% cree que cambiarán el negocio tanto como Internet. El 79% de los encuestados señaló que las compañías que no disfrutan de grandes datos perderán una ventaja competitiva.

Sin embargo, los encuestados trataron con la opinión de que valía la pena ser grande. El 65% de los encuestados creen que estas son "grandes tarjetas de datos", el 60% confía en que es "Análisis avanzado y análisis", y el 50% es que estos son "datos de herramientas de visualización".

Madrid gasta 14,7 millones de euros en la gestión de grandes datos.

En julio de 2014, se sabía que Madrid usaría una gran tecnología de datos para gestionar la infraestructura urbana. El costo del proyecto es de 14,7 millones de euros, la base de las soluciones implementables serán tecnologías para el análisis y la gestión de grandes datos. Con su ayuda, la administración urbana administrará el trabajo con cada proveedor de servicios y que lo pague en consecuencia dependiendo del nivel de servicios.

Estamos hablando de los contratistas de la Administración, que son seguidos por el estado de calles, iluminación, riego, plantaciones verdes, realizan la limpieza del territorio y la exportación, así como el procesamiento de la basura. Durante el proyecto, se desarrollaron 300 indicadores clave del desempeño de los servicios urbanos para inspectores especialmente seleccionados, sobre la base de los cuales 1,5 mil controles y mediciones diferentes se llevarán a cabo diariamente. Además, la ciudad comenzará a usar una plataforma tecnológica innovadora llamada Madrid Inteligente (MINT) - Smart Madrid.

2013

Expertos: Moda Pico en grandes datos

Todos sin excepción al proveedor en el mercado de gestión de datos en este momento, las tecnologías están desarrollando tecnologías para la gran gestión de datos. Esta nueva tendencia tecnológica también es discutida activamente por la comunidad profesional, tanto los desarrolladores como los analistas sectoriales y los consumidores potenciales de tales soluciones.

Como se enteró de Datashift, a partir de enero de 2013, una ola de discusiones en torno a " datos grandes"Superó todos los tamaños imaginables. Después de analizar la cantidad de menciones de grandes datos en las redes sociales, se calculó datos que en 2012 este término se usó alrededor de 2 mil millones de veces en puestos creados alrededor de 1 millón de autores diferentes de todo el mundo. Esto es equivalente a 260 postes por hora, con la cima de las referencias ascendió a 3070 referencias por hora.

GARTNER: Cada segundo director de TI está listo para gastar dinero en grandes datos

Después de varios años de experimentos con grandes tecnologías de datos y primeras introducciones en 2013 Adaptación tales soluciones Aumentará significativamente, predicho en Gartner. Los investigadores entrevistaron a los líderes de todo el mundo y encontraron que el 42% de los encuestados ya han invertido en tecnología de Big Data o planean realizar dichas inversiones durante el próximo año (datos de marzo de 2013).

Las empresas se ven obligadas a gastar dinero en la tecnología de procesamiento. datos grandesDado que el panorama de la información está cambiando rápidamente, exigiendo nuevos enfoques para el procesamiento de la información. Muchas empresas ya se han dado cuenta de que las grandes matrices de datos son críticas, y el trabajo con ellos le permite lograr beneficios que no están disponibles cuando se utilizan fuentes tradicionales de información y métodos de procesamiento. Además, el deber permanente del tema de los "grandes datos" en los medios de comunicación está calentando el interés en las tecnologías relevantes.

Frank Buytendijk, vicepresidente de Gartner, incluso llamó a la compañía a moderar el polvo, ya que a algunos les preocupa que se rezaguen de los competidores en el desarrollo de grandes datos.

"No es necesario preocuparse por la oportunidad de implementar ideas sobre la base de las tecnologías de" Big Data ", en realidad no tienen fin", dijo.

Según Gartner, para 2015, el 20% de las compañías globales de 1000 listas tomarán un enfoque estratégico en la "infraestructura".

En anticipación de nuevas características que traerán con ellos la tecnología de procesar "grandes datos", ahora muchas organizaciones organizan el proceso de recopilación y almacenamiento de diversos tipos de información.

Para las organizaciones educativas y gubernamentales, así como las empresas de la industria, el mayor potencial de transformación empresarial se coloca en combinación de datos acumulados con los llamados datos oscuros (literalmente "datos oscuros"), este último incluye mensajes correo electrónico, Multimedia y otros contenidos similares. Según Gartner, es aquellos que aprenderán cómo manejar los datos de las fuentes de información más diferentes.

Encuesta de Cisco: los grandes datos ayudarán a aumentar los presupuestos de TI

Durante el estudio (Spring 2013), denominado Informe de Tecnología Mundial conectada Cisco, realizado en 18 países por una compañía analítica independiente InsightExpress, se entrevistó a 1,800 estudiantes universitarios y la misma cantidad de jóvenes profesionales de 18 a 30 años. Se realizó la encuesta para averiguar el nivel de preparación de los departamentos de TI a la implementación del proyecto. Big Data. y obtener una idea de temas relacionados, fallas tecnológicas y valor estratégico de dichos proyectos.

La mayoría de las compañías recopilan, escribe y analiza los datos. Sin embargo, dice el informe, muchas compañías en relación con grandes datos se enfrentan a una serie de problemas complejos de tecnología de negocios e información. Por ejemplo, el 60 por ciento de los encuestados reconoce que las grandes soluciones de datos pueden mejorar los procesos de toma de decisiones y aumentar la competitividad, pero solo el 28 por ciento declaró que las ventajas estratégicas reales de la información acumulada ya se obtienen.

Más de la mitad de los gerentes de TI, los encuestados creen que los grandes proyectos de datos ayudarán a aumentar los presupuestos de TI en sus organizaciones, ya que habrá mayores requisitos para tecnologías, personal y habilidades profesionales. Al mismo tiempo, más de la mitad de los encuestados esperan que tales proyectos aumenten los presupuestos de TI en sus compañías ya en 2012. El 57 por ciento confía en que los grandes datos aumentarán sus presupuestos en los próximos tres años.

El 81 por ciento de los encuestados dijeron que todos los proyectos de datos grandes (o al menos algunos) requerirán aplicaciones. computación en la nube. Por lo tanto, la distribución de las tecnologías en la nube puede afectar la velocidad de distribución de las soluciones de BIG DATA y en los valores de estas soluciones comerciales.

Las empresas recopilan y usan datos más. diferentes tiposTales como estructurado y no estructurado. Aquí es de qué fuentes reciben los datos de los participantes de la encuesta (Informe de tecnología mundial conectada a Cisco):

Casi la mitad (48 por ciento) de los gerentes de TI predice la duplicación de la carga en su red en los próximos dos años. (Esto es especialmente característico de China, donde el 68 por ciento de los encuestados y Alemania se adhieren a un punto de vista, 60 por ciento). El 23 por ciento de los encuestados espera a la triplicación de la carga de la red durante los próximos dos años. Al mismo tiempo, solo el 40 por ciento de los encuestados declararon su disposición al aumento explosivo en el tráfico de la red.

El 27 por ciento de los encuestados reconoció que necesitan mejores políticas de TI y medidas de seguridad de la información.

El 21 por ciento necesita ampliar el ancho de banda.

Los grandes datos abre nuevas oportunidades antes de que los departamentos de TI aumentaran el valor y forman una relación cercana con las unidades de negocios, lo que permite aumentar los ingresos y fortalecer la posición financiera de la compañía. Los grandes proyectos de datos lo hacen divisiones con un socio estratégico de unidades de negocios.

Según el 73 por ciento de los encuestados, es el departamento de TI que se convertirá en la locomotora principal de la implementación de la gran estrategia de datos. Al mismo tiempo, consideran que los encuestados, otros departamentos también se conectarán a la implementación de esta estrategia. En primer lugar, se refiere a los departamentos de finanzas (24 por ciento de los encuestados), investigación (20 por ciento), operativa (20 por ciento), ingeniería (19 por ciento), así como departamentos de marketing (15 por ciento) y ventas (14 por ciento) .

GARTNER: Para administrar grandes datos, se necesitan millones de nuevos empleos.

Los costos de TI de TI han alcanzado los $ 3.7 mil millones para 2013, que es un 3,8% más de gastos para la tecnología de la información en 2012 (el pronóstico a finales de año es de $ 3.6 mil millones). Segmento datos grandes (Big Data) desarrollará tasas mucho más altas, dice el informe de Gartner.

Para 2015, se crearán 4,4 millones de empleos en el campo de las tecnologías de la información para satisfacer datos grandes, de los cuales se encuentran 1.9 millones de empleos. Por otra parte, cada uno lugar de trabajo Él implicará la creación de tres empleos adicionales fuera del sector de TI, por lo que solo en los Estados Unidos en los próximos cuatro años, 6 millones de personas trabajarán para mantener la economía de la información.

Según los expertos de Gartner, el principal problema es que en la industria no tiene suficientes talentos: tanto el sistema educativo privado como el estado, por ejemplo, en los Estados Unidos no puede suministrar a la industria un número suficiente de personal calificado. Por lo tanto, los nuevos empleos mencionados en los marcos de TI se asegurarán solo uno de los tres.

Los analistas creen que el papel de la pintura calificó al personal de TI debería enfrentarse directamente a la compañía, que se debe a las necesidades de ellos, ya que tales empleados pasarán por ellos a la nueva economía de la información del futuro.

2012

El primer escepticismo para "grandes datos".

Los analistas de las compañías de Ovum y Gartner sugieren que de la moda en los temas 2012 datos grandes Puede llegar el tiempo de liberación de las ilusiones.

El término "grandes datos", en este momento, como regla general, denota la cantidad de información cada vez mayor que viene en modo operacional Desde las redes sociales, desde las redes de sensores y otras fuentes, así como una creciente gama de herramientas utilizadas para el procesamiento de datos e identificando importantes tendencias de negocios según ellas.

"Debido a la exageración (o a pesar de eso) con respecto a la idea de grandes datos, los fabricantes en 2012 con una gran esperanza miraron esta tendencia", dijo Tony Bayer, analista de óvulos.

Bayer dijo que DataSift realizó un análisis retrospectivo de la mención de grandes datos en

Qué Big Data. (literalmente - datos grandes)? Veamos primero al diccionario de Oxford:

Datos - Valores, signos o símbolos que opera la computadora y que pueden almacenarse y transmitirse en forma de señales eléctricas, registradas en medios magnéticos, ópticos o mecánicos.

Término Big Data. Se utiliza para describir una gran y creciente exponencialmente con un tiempo de conjunto de datos. Para procesar dicha cantidad de datos, no lo hagan sin.

Las ventajas que proporciona grandes datos:

- Colección de datos de diferentes fuentes.

- Mejora de los procesos de negocios a través de analíticos en tiempo real.

- Almacenar una gran cantidad de datos.

- Perspectivas. Los datos grandes son más perceptivos para la información oculta utilizando datos estructurados y semiestructurados.

- Los grandes datos ayudan a reducir el riesgo y hacer soluciones inteligentes debido a un análisis de riesgo adecuado.

Ejemplos de grandes datos.

Bolsa de Nueva York Genera diariamente 1 terabyte Datos sobre el comercio durante la sesión pasada.

Medios de comunicación social: Las estadísticas muestran que la base de datos de Facebook está cargada diariamente. 500 terabytes Los nuevos datos se generan principalmente debido a descargas de fotos y videos sobre servidores de redes sociales, mensajes, comentarios bajo publicaciones, etc.

Motor de reacción Genera 10 terabytes Datos cada 30 minutos durante el vuelo. Dado que miles de vuelos se realizan diariamente, la cantidad de datos llega a Petabytes.

Clasificación de grandes datos.

Formas de datos grandes:

- Estructurado

- No estructurado

- Semiestructurado

Forma estructurada

Los datos que se pueden almacenar, estar disponibles y procesarse en forma con un formato fijo se denomina estructura. Durante mucho tiempo, las ciencias de la computación han logrado un gran éxito en la mejora del técnico para trabajar con este tipo de datos (donde el formato se conoce de antemano) y aprendió a beneficiarse. Sin embargo, hoy en día existen problemas asociados con el aumento de los volúmenes al tamaño medido en el rango de varios zeetabitas.

1 Zettabyte corresponde a un billón de terabyte.

Al observar estos números, es fácil verificar la veracidad del término big Data y las dificultades de conjugarse con el procesamiento y almacenamiento de dichos datos.

Los datos almacenados en la base relacional se estructuran y tienen un formulario, por ejemplo, la tabla de empleados de la empresa

Forma no estructurada

Los datos de una estructura desconocida se clasifican como no estructurados. Además de los tamaños grandes, tal forma se caracteriza por una serie de dificultades para procesar y eliminar información útil. Un ejemplo típico de datos no estructurados es una fuente heterogénea que contiene una combinación de archivos de texto simples, imágenes y video. Hoy en día, las organizaciones tienen acceso al gran volumen de datos crudos o no estructurados, pero no saben cómo beneficiarse de ellos.

Forma semiestructurada

Esta categoría contiene ambos descritos anteriormente, por lo que los datos semiestructurados poseen algún tipo, pero en realidad no se definen utilizando tablas en bases relacionales. Un ejemplo de esta categoría es los datos personales presentados en el archivo XML.

Características grandes datos.

Crecimiento de grandes datos con el tiempo:

Datos estructurados presentados azules (datos empresariales), que se almacenan en bases relacionales. Otros colores son datos no estructurados de diferentes fuentes (telefonía IP, dispositivos y sensores, redes sociales y aplicaciones web).

De acuerdo con Gartner, los datos grandes difieren en volumen, tasas de generación, variedad y variabilidad. Considere estas características con más detalle.

- Volumen. Por sí mismo, el término grandes datos se asocia con un gran tamaño. El tamaño de los datos es el indicador más importante al determinar el posible valor recuperable. Daily 6 millones de personas usan medios digitales, que estimaciones preliminares generan 2.5 bytes de datos de quintillion. Por lo tanto, el volumen es el primero en considerar la característica.

- Diversidad - El siguiente aspecto. Se refiere a fuentes heterogéneas y naturaleza de datos, que pueden ser estructurados y no estructurados. Anteriormente, las hojas de cálculo y las bases de datos fueron las únicas fuentes de información consideradas en la mayoría de las aplicaciones. Hoy en día, los datos en forma de correos electrónicos, fotos, video, archivos PDF, audio también se consideran en aplicaciones analíticas. Dicha variedad de datos no estructurados conduce a problemas en el almacenamiento, la minería y el análisis: el 27% de las empresas no confian en que trabajan con datos adecuados.

- Tasa de generación. Qué rapidez se acumulan y procesan los datos para cumplir con los requisitos, determina el potencial. La velocidad determina la velocidad de entrada de la información de las fuentes: procesos de negocios, registros de aplicaciones, sitios de redes sociales y medios de comunicación, sensores, dispositivos móviles. El flujo de datos es enorme y continuo a tiempo.

- Variabilidad Describe la inconstancia de los datos en algunos puntos en el tiempo que complica el procesamiento y la administración. Por ejemplo, la mayoría de los datos no están estructurados por la naturaleza.

Big Data Analytics: ¿Cuál es el beneficio de los grandes datos?

Promoción de bienes y servicios.: El acceso a los datos de los motores de búsqueda y los sitios, como Facebook y Twitter, permite a las empresas desarrollar con mayor precisión estrategias de marketing.

Mejora del servicio para compradores.: Los sistemas de comentarios de compradores tradicionales se reemplazan por los nuevos en los que se utilizan grandes datos y el procesamiento del lenguaje natural para leer y evaluar la revisión del cliente.

Cálculo de riesgoasociado con la liberación de un nuevo producto o servicio.

Eficiencia operativa: Los datos grandes están estructurados para eliminar rápidamente la información necesaria y dar prontamente el resultado exacto. Dicha combinación de grandes tecnologías de datos y almacenes ayuda a las organizaciones a optimizar el trabajo con información utilizada rara vez.

Solo perezoso no habla datos grandes, pero lo que es y cómo funciona, es poco probable. Empecemos con la terminología más simple. En ruso, los grandes datos son varias herramientas, enfoques y métodos de procesamiento de datos estructurados y no estructurados para usarlos para tareas y objetivos específicos.

Los datos no estructurados son la información que no tiene una estructura predeterminada o no está organizada en un determinado orden.

El término "grandes datos" presentó el editor de la revista Nature Clifford Lynch en 2008 en 2008 en un tema especial dedicado al crecimiento explosivo de los volúmenes de información mundial. Aunque, por supuesto, existían grandes datos. Según los expertos, la categoría de grandes datos incluye la mayoría de los flujos de datos superiores a 100 GB por día.

Ver también:

Hoy en día, bajo este simple término, solo dos palabras están ocultas: almacenamiento y procesamiento de datos.

Big Data - Palabras simples

En el mundo moderno, los grandes datos son un fenómeno socioeconómico, que se asocia con el hecho de que las nuevas capacidades tecnológicas parecían analizar una gran cantidad de datos.

Ver también:

Para facilitar la comprensión, imagine un supermercado en el que todos los bienes no se encuentren en el orden habitual. Pan al lado de la fruta, pasta de tomate cerca de la pizza congelada, líquido para encender frente al bastidor con tampones, en los que, entre otros, se encuentra el aguacate, el tofu o los hongos de Shiitake. Los grandes datos establecen todo en su lugar y lo ayudan a encontrar leche de nueces, averigüe la fecha de costo y caducidad, y también, y también, además de usted, compra una leche de este tipo y cómo es mejor que la leche de vaca.

Kenneth Cucier: Big Data - Los mejores datos

Tecnología Big Data.

Se procesan enormes volúmenes de datos para que una persona pueda obtener los resultados específicos y necesarios para ellos para su uso más efectivo.

Ver también:

De hecho, los grandes datos son una solución a los problemas y una alternativa a los sistemas de gestión de datos tradicionales.

Técnicas y métodos de análisis aplicables a grandes datos de McKinsey:

Crowdsourcing;

Mezcla y integración de datos;

Aprendizaje automático;

Redes neuronales artificiales;

Reconocimiento de patrones;

Pronóstico de Analytics;

Simulación;

Análisis espacial;

Análisis estadístico;

- Visualización de datos analíticos.

Escalabilidad horizontal, que proporciona procesamiento de datos: el principio básico de procesamiento de datos grandes. Los datos se distribuyen a los nodos informáticos, y el procesamiento se produce sin la degradación de la productividad. McKinsey incluía sistemas de control relacional y inteligencia empresarial en el contexto de aplicabilidad.

Tecnologías:

- NOSQL;

- Mapa reducido;

- Hadoop;

- Soluciones de hardware.

Ver también:

Para obtener datos grandes, las características definitorias tradicionales producidas por el grupo meta aún en 2001, que se llaman " Tres V.»:

- VOLUMEN. - La magnitud del volumen físico.

- Velocidad. - La tasa de crecimiento y la necesidad de un procesamiento rápido de datos para obtener resultados.

- Variedad. - La capacidad de procesar simultáneamente varios tipos de datos.

Big Data: Aplicación y características.

Los volúmenes de información digital inhomogénosa y rápida no se pueden tratar con herramientas tradicionales. El análisis de datos en sí le permite ver ciertos y discutibles patrones que una persona no puede ver. Esto le permite optimizar todas las esferas de nuestra vida, del gobierno hasta la producción y las telecomunicaciones.

Por ejemplo, algunas compañías han defendido a sus clientes del fraude hace unos años, y cuida al dinero del cliente es la preocupación por su propio dinero.

Susan Etlyger: ¿Cómo lidiar con los grandes datos?

Big Data Solutions: Sberbank, Be Beeline y otras empresas

BILAIN tiene una gran cantidad de datos de suscriptores que utilizan no solo para trabajar con ellos, sino también para crear productos analíticos, como consultoría externa o análisis de IPTV. Beeline segmentó la base y los clientes protegidos de fraude en efectivo y virus, utilizando HDFS y Apache Spark, y para el procesamiento de datos, RapidMiner y Python.

Ver también:

O recuerde a Sberbank con su antiguo caso llamado SAFI. Este es un sistema que analiza las fotos para identificar a los clientes del Banco y evita el fraude. El sistema se introdujo en 2014, el sistema se basa en una comparación de fotografías de la base, que vienen allí desde webcams en bastidores debido a la visión de la computadora. La base del sistema es una plataforma biométrica. Debido a esto, los casos de fraude disminuyeron 10 veces.

Grandes datos en el mundo

Para 2020, según las previsiones, la humanidad formará 40-44 Zettabites de información. Y para 2025 crecerá 10 veces, el informe de los datos de 2025 años, que fue preparado por los analistas de IDC. El informe señala que las propias empresas se generarán la mayoría de los datos y no consumidores comunes.

Los analistas de la investigación creen que los datos se convertirán en un activo vital, y la seguridad es una base crítica en la vida. Además, los autores del trabajo confían en que la tecnología cambiará el panorama económico, y el usuario habitual se comunicará con dispositivos conectados alrededor de 4800 veces al día.

Gran mercado de datos en Rusia

Típicamente, los datos grandes provienen de tres fuentes:

- Internet (redes sociales, foros, blogs, medios de comunicación y otros sitios);

- Archivos corporativos de documentos;

- Indicaciones de sensores, dispositivos y otros dispositivos.

Big Data en bancos

Además del sistema descrito anteriormente, en la Estrategia de Sberbank para 2014-2018. Se dice acerca de la importancia de analizar las supermaisiones de datos para el servicio al cliente de calidad, la gestión de riesgos y la optimización de costos. Ahora, el banco utiliza grandes datos para controlar los riesgos, combatir los costos crediticios de fraude, segmentación y calidad crediticia, gestión de personal, predecir las colas en oficinas, cálculo de bonificaciones para empleados y otras tareas.

VTB24 goza de grandes datos para la segmentación y gestión de la salida del cliente, formación de estados financieros, análisis de retroalimentación en redes sociales y foros. Para hacer esto, aplica Teradata, SAS Visual Analytics y SAS Marketing Optimizer Solutions.

Los datos grandes (o datos grandes) son un conjunto de métodos de trabajo con grandes volúmenes de información estructurada o no estructurada. Los especialistas en el trabajo con datos grandes se dedican a su procesamiento y análisis para obtener resultados visuales y percibidos. Mírame con los profesionales y descubrió cuál es la situación con el procesamiento de grandes datos en Rusia, dónde y qué es mejor aprender a aquellos que quieren trabajar en esta área.

Alexey Rupin en las direcciones principales en el campo de grandes datos, comunicación con los clientes y el mundo de los números

Estudié en el Instituto de Tecnología Electrónica de Moscú. Lo principal que logré sacar, son el conocimiento fundamental de la física y las matemáticas. Al mismo tiempo, trabajé en el Centro de I + D, donde se dedicó al desarrollo e implementación de algoritmos de codificación nobles para los medios de transferencia de datos protegidos. Después del final del estudiante de pregrado, ingresé a la magistratura de la Informática empresarial de la Escuela Superior de Economía. Después de eso, quería trabajar en IBS. Tuve suerte de que en ese momento en relación con gran cantidad Los proyectos fueron un conjunto adicional de pasantes, y después de varias entrevistas comencé a trabajar en IBS, una de las compañías rusas más grandes de esta área. Durante tres años, me fui del tren ante el arquitecto de las soluciones corporativas. Ahora estoy involucrado en el desarrollo de grandes tecnologías de datos para las empresas de clientes del sector financiero y de telecomunicaciones.

Hay dos especializaciones principales para las personas que desean trabajar con grandes datos: analistas y consultores de TI que crean tecnologías para trabajar con datos grandes. Además, también puede hablar sobre la profesión de Big Data Analyst, es decir, personas que trabajan directamente con los datos con la plataforma de TI del cliente. Anteriormente, eran analistas de matemáticas ordinarias que conocían estadísticas y matemáticas y utilizando el software estadístico para resolver las tareas de análisis de datos. Hoy en día, además del conocimiento de las estadísticas y las matemáticas, también es necesaria una comprensión de la tecnología y un ciclo de vida de datos. En esto, en mi opinión, es la diferencia entre el analista de datos modernos de aquellos analistas que fueron anteriores.

Mi especialización es consultora, es decir, estoy inventando y ofreciendo a los clientes cómo resolver las tareas comerciales con las tecnologías de TI. Las personas vienen a consultar con diversas experiencias, pero las cualidades más importantes para esta profesión son la capacidad de comprender las necesidades del cliente, el deseo de ayudar a las personas y organizaciones, las buenas habilidades de comunicación y equipo (ya que siempre está trabajando con el cliente y En un equipo), buenas habilidades analíticas. La motivación interna es muy importante: trabajamos en un entorno competitivo, y el cliente está esperando soluciones e intereses inusuales en el trabajo.

La mayoría de las veces, tengo que comunicarme con los clientes, formalizando sus necesidades comerciales y asistencia para desarrollar la arquitectura tecnológica más adecuada. Los criterios de selección aquí tienen sus propias características: además de la funcionalidad y la TSO (costo total de propiedad, el costo total de la propiedad) son requisitos no importantes para el sistema, la mayoría es el tiempo de respuesta, el procesamiento de la información hora. Para convencer al cliente, a menudo usamos la prueba del enfoque del concepto: ofrecemos la tecnología gratuita para "probar" para alguna tarea, en un conjunto de datos estrechos para asegurarse de que la tecnología funcione. La decisión debe crear una ventaja competitiva para el cliente a expensas de beneficios adicionales (por ejemplo, venta X, transversal) o resolver algún tipo de problema comercial, digamos, reduzca el alto nivel de fraude de préstamos.

Sería mucho más fácil si los clientes vinieran de la tarea terminada, Pero siempre y cuando no entiendan que ha aparecido una tecnología revolucionaria, lo que puede cambiar el mercado durante un par de años.

¿Qué problemas tienen que enfrentar? El mercado no está listo para usar la tecnología "Big Data". Sería mucho más fácil si los clientes vinieran de una tarea listosizada, pero hasta que entiendan que una tecnología revolucionaria que podría cambiar el mercado durante un par de años. Es por eso que, de hecho, trabajamos en el modo de inicio, no solo vendan tecnología, sino que siempre hemos convencido a los clientes que necesita invertir en estas soluciones. Esta es una posición de visionarios. Mostramos a los clientes cómo puede cambiar su negocio con la atracción de los datos y ello. Creamos esto nuevo mercado - Mercado de consultoría comercial de TI en el área de Big Data.

Si una persona quiere participar en el análisis de datos o su consultoría en la esfera de los grandes datos, entonces lo primero que es importante es la educación matemática o técnica con una buena preparación matemática. También es útil dominar tecnologías específicas, digamos SAS, Hadoop, R lenguaje o solución IBM. Además, es necesario estar interesado activamente en las tareas de aplicación para grandes datos, por ejemplo, ya que se pueden usar para mejorar la puntuación de crédito en un banco o administración del ciclo de vida del cliente. Estos y otros conocimientos se pueden obtener de las fuentes disponibles: por ejemplo, Coursera y Big Data University. También hay una iniciativa de Analytics de clientes en la Universidad Wharton de Pennsylvania, que ha publicado muchos materiales interesantes.

Un problema serio para aquellos que desean trabajar en nuestra área es una falta explícita de información sobre grandes datos. No puede ir a la librería o en algunos sitios y obtener, por ejemplo, una columna exhaustiva de casos para todas las aplicaciones de grandes tecnologías de datos en bancos. No hay tales libros de referencia. Parte de la información está en los libros, otra parte se recoge en conferencias, y a algo que tiene que alcanzarte.

Otro problema es que los analistas se sienten bien en el mundo de los números, pero no siempre se sienten cómodos en los negocios. Tales personas a menudo son introvertidas, es difícil para ellos comunicarse y, por lo tanto, es difícil para ellos que transmitan convincentemente a la información de los clientes sobre los resultados de la investigación. Para el desarrollo de estas habilidades, recomendaría los libros como el "principio de pirámide", "Habla en diagramas". Ayudan a desarrollar habilidades de presentación, declaran de manera concisa y clara.

Fui muy útil la participación en diferentes campeonatos de caso mientras estudiaba en HSE. Los campeonatos de casos son competiciones inteligentes para los estudiantes, donde necesita estudiar problemas de negocios y ofrecer su decisión. Son dos especies: campeonatos de casos de consultoría, tales como McKinsey, BCG, Accenture, así como campeonatos de casos de tipo de cambio independiente. Durante la participación en ellos, aprendí a ver y resolver tareas complejas, desde la identificación del problema y su estructuración a la protección de las recomendaciones para su solución.

Oleg Mikhalsky sobre el mercado ruso y los detalles de crear un nuevo producto en el campo de los grandes datos

Antes de llegar a Acronis, ya estaba comprometido en el lanzamiento de nuevos productos al mercado en otras compañías. Siempre es interesante y difícil al mismo tiempo, por lo que estaba inmediatamente interesado en la posibilidad de trabajar en servicios en la nube y soluciones para el almacenamiento de datos. En esta área, toda mi experiencia anterior en la industria de TI fue útil, incluido su propio proyecto de inicio i-Accelerator. La presencia de educación empresarial (MBA) también ayudó además de la ingeniería básica.

En Rusia, las grandes empresas: bancos, operadores móviles, etc.) es necesario analizar grandes datos, por lo que en nuestro país hay perspectivas para aquellos que desean trabajar en esta área. Es cierto que muchos proyectos ahora están integrando, es decir, sobre la base de desarrollos extranjeros o tecnologías de código abierto. En tales proyectos, no se crean enfoques y tecnologías fundamentalmente nuevos, sino que se adaptan los desarrollos existentes. En Acronis, fuimos a otra forma y, después de analizar las alternativas existentes, decidimos invertir en nuestro propio desarrollo, creando un sistema de almacenamiento confiable para datos grandes, que no es inferior al costo, por ejemplo, Amazon S3, pero funciona De manera confiable y eficiente en una escala significativamente menor. El desarrollo propio para grandes datos también se encuentra entre las principales empresas de Internet, pero están bastante concentradas en las necesidades internas que la satisfacción de las necesidades de los clientes externos.

Es importante entender las tendencias y las fuerzas económicas que afectan el área de procesamiento de grandes datos. Para hacer esto, lea mucho, escuche las actuaciones de especialistas autorizados en la industria de TI, visite las conferencias temáticas. Ahora, casi todas las conferencias tienen una gran sección de datos, pero todos hablan de ello en diferentes ángulos: desde el punto de vista de la tecnología, las empresas o la comercialización. Puede ir por trabajo de diseño o pasantía en la empresa, que ya realiza proyectos sobre este tema. Si tiene confianza en sus habilidades, no es demasiado tarde para organizar una puesta en marcha en la esfera de los grandes datos.

Sin contacto constante con el mercado. Nuevos riesgos de desarrollo que deben ser no reclamados.

VERDADERO, cuando usted es responsable de un nuevo producto, se hace mucho tiempo a Analytics del mercado y comunicarse con clientes potenciales, socios, analistas profesionales que conocen mucho sobre los clientes y sus necesidades. Sin contacto constante con el mercado, los nuevos riesgos de desarrollo no son reclamados. Siempre hay mucha incertidumbre: debe entender quién se convertirá en los primeros usuarios (adoptantes tempranos) que tiene valiosos para ellos y luego atraer a una audiencia masiva. La segunda tarea más importante es formar y transmitir a los desarrolladores una visión clara y holística del producto final para motivarlos a trabajar en tales condiciones cuando algunos requisitos aún pueden cambiar, y las prioridades dependen de realimentaciónviniendo de los primeros clientes. Por lo tanto, una tarea importante es administrar las expectativas de los clientes en un lado y desarrolladores en el otro. Para que ninguno de los demás haya perdido el interés y haya traído el proyecto antes de su finalización. Después del primer proyecto exitoso, se vuelve más fácil, y la tarea principal encontrará el modelo de crecimiento adecuado para el nuevo negocio.

A la vez, escuché el término "grandes datos" de German Gref (Jefe de Sberbank). Dicen que ahora trabajan activamente en la introducción, porque les ayudará a cortar el tiempo de trabajar con cada cliente.

La segunda vez que corrí a este concepto en la tienda en línea del cliente, sobre la cual trabajamos y aumentamos el rango de un par de miles a un par de decenas de miles de posiciones de productos básicos.

Por tercera vez, cuando vi que se requiere el analista de grandes datos en Yandex. Luego decidí atreverme a resolverlo en este tema y al mismo tiempo escribir un artículo que diría cuál es el término para el término que excita la mente de los principales gerentes y el espacio de Internet.

Vvv o vvvvv

Por lo general, cualquiera de su artículo comience con la explicación que para el término. Este artículo no será una excepción.

Sin embargo, esto es causado en primer lugar sin el deseo de mostrar lo que soy inteligente, pero el hecho de que el tema es verdaderamente complejo y requiere una explicación cuidadosa.

Por ejemplo, puede leer qué datos grandes están en Wikipedia, no entienden nada, y luego regrese a este artículo para que aún comprenda la definición y la aplicabilidad para los negocios. Por lo tanto, comencemos con la descripción, y luego a los ejemplos de negocios.

Los grandes datos son grandes datos. Sorprendentemente, ¿sí? Realmente, se traduce del inglés como "grandes datos". Pero esta definición se puede decir para los maniquíes.

Importante. Big Data Technology es un enfoque / método para procesar un mayor número de datos para obtener una nueva información que es difícil de manejar de manera convencional.

Los datos pueden ser procesados \u200b\u200b(estructurados) y dispares (es decir, no estructurados).

El término en sí parecía relativamente recientemente. En 2008, este enfoque se predice en la revista científica como algo necesario para trabajar con una gran cantidad de información, que aumenta en la progresión geométrica.

Por ejemplo, la información anual en Internet, que debe ser almacenada, bueno, para procesar, aumentar un 40%. De nuevo. + 40% Cada año aparece en Internet de nueva información.

Si los documentos impresos son claros y sus métodos de procesamiento también son claros (transferencia a forma electrónica, coser a una carpeta, numerados), qué hacer con la información que se presenta en otros "medios" y otros volúmenes:

- documentos de Internet;

- blogs y redes sociales;

- fuentes de audio / video;

- aparatos de medición;

Existen características que le permiten atribuir información y datos a grandes datos.

Es decir, no todos los datos pueden ser adecuados para analíticos. En estas características, se establece el concepto clave de la fecha grande. Todos ellos encajan en tres V.

- Volumen (de Ing. Volumen). Los datos se miden en la magnitud del volumen físico del "documento" a analizar;

- Velocidad (de eng. Velocidad). Los datos no cuestan en su desarrollo, sino que crezcan constantemente, es por eso que se requiere su procesamiento rápido para obtener resultados;

- Maduro (de inglés. Variedad). Los datos pueden no ser de un solo formato. Es decir, pueden ser dispares, estructurados o estructurados parcialmente.

Sin embargo, agregue periódicamente a VVV y la cuarta v (veracidad - confiabilidad / creibilidad de los datos) e incluso la quinta V (en algunas realizaciones es la viabilidad: la viabilidad, en otras, es valor: valor).

En algún lugar, también vi 7V, lo que caracteriza los datos relacionados con la fecha grande. Pero en mi opinión, esto es de la serie (donde P se agrega periódicamente, aunque es para comprender la inicial 4-X).

Ya tenemos más de 29,000 personas.

Ingresar

¿Quién lo necesita?

Se trata de una pregunta lógica, ¿cómo puedo usar la información (si eso, la fecha grande es cientos y miles de Terabyte)? Ni siquiera así.

Aquí está la información. Entonces, ¿qué se acercó la gran cita entonces? ¿Cuál es el uso de grandes datos en marketing y en el negocio?

- Las bases de datos ordinarias no se pueden almacenar y procesar (ahora hablo, ni siquiera sobre el análisis, sino también el almacenamiento y el procesamiento) de una gran cantidad de información.

Gran fecha resuelve esta tarea principal. Almacena con éxito información y gestiona información con un gran volumen;

- Estructuras de información provenientes de diversas fuentes (video, imágenes, audio y documentos de texto), en una sola mirada, comprensible y respondida;

- Formación de análisis y creación de pronósticos precisos basados \u200b\u200ben información estructurada y procesada.

Es complicado. Para hablar simplemente, cualquier comercializador que entienda que si explore una gran cantidad de información (sobre usted, su empresa, sus competidores, su industria), puede obtener resultados muy decentes:

- Comprensión completa de su empresa y su negocio por parte de los números;

- Explora a tus competidores. Y esto, a su vez, dará la oportunidad de salir adelante debido a la prevalencia de ellos;

- Aprende nueva información sobre sus clientes.

Y precisamente porque la alta tecnología de datos da los siguientes resultados, todo está usado con él.

Tratando de sujetar este caso a su empresa para obtener un aumento en las ventas y reducir los costos. Y si específicamente, entonces:

- Aumentar la cruz de las ventas y las ventas adicionales debido a un mejor conocimiento de las preferencias del cliente;

- Encontrar productos populares y razones por las que se compran (y por el contrario);

- Mejorar el producto o servicio;

- Mejorar el nivel de servicio;

- Raying lealtad y enfoque al cliente;

- Advertencia de fraude (más relevante para el sector bancario);

- Reduce el exceso de costos.

El ejemplo más común, que se da en todas las fuentes, es, por supuesto, compañía de manzanasque recopila datos en sus usuarios (teléfono, reloj, computadora).

Se debe a la presencia del eco-sistema que la corporación conoce tanto a sus usuarios y en adelante utiliza esto para obtener ganancias.

Estos y otros ejemplos de usar usted pueden leer en cualquier otro artículo, excepto esto.

Vamos al futuro

Te diré sobre otro proyecto. Más bien, sobre una persona que construye el futuro utilizando las grandes soluciones de datos.

Esta es la máscara de Ilon y su empresa Tesla. Su principal sueño es hacer autónomos autónomos, es decir, se pone detrás de la rueda, enciende el piloto automático de Moscú a Vladivostok y ... se duerme, porque absolutamente no necesito conducir un automóvil, porque lo hará todo mismo. .

¿Parecería fantasía? ¡Pero no! Solo Ilon se volvió mucho más sabio que Google, que maneja automóviles con decenas de satélites. Y fue a otra manera:

- En cada automóvil se vende, se establece una computadora, que recopila toda la información.

Todo - esto significa todo el todo. Acerca del conductor, el estilo de su conducción, caminos alrededor, el movimiento de otros autos. El volumen de dichos datos alcanza los 20-30 GB por hora;

- A continuación, esta información satelital se transmite a la computadora central, que se dedica a procesar estos datos;

- Basado en datos de grandes datos que procesan este computador, Se está construyendo un modelo de un automóvil no tripulado.

Por cierto, si el negocio de Google vaya bastante mal y sus autos llegan al accidente, entonces la máscara, debido al hecho de que el trabajo con grandes datos va mucho mejor, porque los modelos de prueba muestran resultados muy buenos.

Pero ... todo es de la economía. ¿Qué somos todos sobre las ganancias, sí sobre el beneficio? Mucho, lo que puede decidir la cita grande, no se reconoce completamente con las ganancias y el dinero.

Las estadísticas de Google, solo se basan en grandes datos, muestra algo interesante.

Antes de que los médicos declaren el comienzo de la epidemia de la enfermedad en alguna región, la cantidad de consultas de búsqueda en el tratamiento de esta enfermedad está aumentando significativamente.

Por lo tanto, el estudio correcto de los datos y su análisis puede formar predicciones y predecir el inicio de la epidemia (y, en consecuencia, su prevención) es mucho más rápida que la conclusión de los organismos oficiales y sus acciones.

Aplicación en Rusia

Sin embargo, Rusia, como siempre, ligeramente "se ralentiza". Por lo tanto, la definición de grandes datos en Rusia no apareció hace más de 5 años (ahora estoy acerca de las empresas regulares).

Y, a pesar del hecho de que este de los mercados de más rápido crecimiento en el mundo (drogas y armas fuman nerviosamente en el costado), porque anualmente el mercado para recolectar y analizar grandes datos se incendiará en un 32%.

Para caracterizar el gran mercado de datos en Rusia, recuerdo una vieja broma. La fecha grande es como el sexo hasta los 18 años.

Se les dice a todos, hay muchos ruidos y pocas acciones reales a su alrededor, y todos se avergüenzan de admitir que no están comprometidos en esto. Y la verdad es, alrededor de esto mucho ruido, pero pequeñas acciones reales.

Aunque la conocida compañía de investigación de Gartner ya ha anunciado que la gran fecha es una tendencia creciente (según el camino y la inteligencia artificial), y los instrumentos bastante independientes para analizar y desarrollar tecnologías avanzadas.

Los nichos más activos, donde se aplica grandes datos en Rusia, estos son bancos / seguros (no es de extrañar que comencé un artículo con el jefe de Sberbank), esfera de telecomunicaciones, minoristas, bienes raíces y ... sector público.

Por ejemplo, le informaré más sobre un par de sectores de la economía, que utilizan grandes algoritmos de datos.

Bancos

Comencemos con los bancos y la información que recopilen sobre nosotros y nuestras acciones. Por ejemplo, tomé los 5 mejores bancos rusos que invierten activamente en grandes datos:

- Sberbank;

- Gazprombank;

- VTB 24;

- Alfa banco;

- Tinkoff Bank.

Es especialmente agradable ver entre los líderes rusos del banco alfa. Como mínimo, es bueno darse cuenta de que el Banco, el socio oficial de los cuales está, entiende la necesidad de introducir nuevas herramientas de marketing en su empresa.

Pero los ejemplos de usar e implementar con éxito grandes datos que quiero mostrar en un banco que me gustan para un look no estándar y una escritura de su fundador.

Estoy hablando de Tinkoff Bank. Su tarea principal fue desarrollar un sistema para analizar datos grandes en tiempo real debido a la creciente base de clientes.

Resultados: El tiempo de los procesos internos disminuyó al menos 10 veces, y durante algunos más de 100 veces.

Bueno, y un poco de distracción. ¿Sabes por qué hablé de ensayos y acciones no estándar de Oleg Tinkov?

En mi opinión, lo ayudaron a resultar de un hombre de negocios de la mano media, Koi Mil en Rusia, en uno de los empresarios más famosos y reconocibles. En confirmación, mira este inusual y video interesante:

La propiedad

En bienes raíces, todo es mucho más difícil. Y este es exactamente el ejemplo que quiero traerlo a comprender la gran fecha para comprender el negocio habitual. Datos iniciales:

- Gran cantidad de documentación de texto;

- Fuentes abiertas (satélites privados que transmiten datos en los cambios de la Tierra);

- Gran cantidad de información incontrolada en Internet;

- Cambios continuos en las fuentes y datos.

Y sobre la base de esto, es necesario preparar y evaluar el valor de la parcela de la tierra, por ejemplo, bajo el pueblo de Ural. El profesional tomará una semana.

Los tasadores de la sociedad rusa y Roseco, que en realidad es un análisis de grandes datos con la ayuda de software, se irán para esto no más de 30 minutos de trabajo pausado. Comparar, semana y 30 minutos. La diferencia colosal.

Bueno, para un bocadillo.

Por supuesto, las grandes cantidades de información no se pueden almacenar y procesar en unidades duros simples.

Y el software que estructura y analiza los datos es generalmente propiedad intelectual y cada vez que el desarrollo del autor. Sin embargo, hay herramientas basadas en todo este encanto:

- Hadoop y MapReduce;

- Bases de datos NOSQL;

- Herramientas de clase de descubrimiento de datos.

Para ser honesto, no podré explicar claramente lo que difieren entre sí, ya que están aprendiendo a familiarizarse y trabajar con estas cosas en instituciones físicas y matemáticas.

¿Por qué hablé de eso si no puedo explicar? ¿Recuerda en todas las películas, los ladrones ingresan a cualquier banco y vea una gran cantidad de todo tipo de hardware conectado a los cables?

Lo mismo en la cita grande. Por ejemplo, aquí hay un modelo que actualmente es uno de los más líderes del mercado.

Herramienta grande Fecha

El costo en la configuración máxima tiene hasta 27 millones de rublos por bastidor. Esto es, por supuesto, la versión de lujo. Tengo que asegurarme de que siga la creación de grandes datos en su negocio.

Brevemente sobre lo principal

¿Puedes preguntar por qué usted, pequeño y medio negocio trabajo con una gran cita?

En esto, le responderé una cita de una persona: "En un futuro próximo, los clientes estarán en demanda por parte de las empresas que comprendan mejor su comportamiento, los hábitos y los coincidan tanto como sea posible".

Pero tomemos una verdad en los ojos. Para introducir la fecha general en las pequeñas empresas, es necesario poseer no solo los grandes presupuestos para el desarrollo e implementación del software, sino también en el contenido de especialistas, al menos, como analista de grandes datos y SYSADMIN.

Y ahora estoy en silencio que tiene que tener dichos datos para su procesamiento.

Bueno. Para las pequeñas empresas, el tema casi no es aplicable. Pero esto no significa que necesite olvidar todo lo que lea anteriormente.

Solo estudia sus datos, sino los resultados de análisis de datos conocidos como empresas extranjeras y rusas.

Por ejemplo, la red minorista de destino que utiliza grandes analistas de datos descubrió que las mujeres embarazadas frente al segundo trimestre del embarazo (de la 1ª a la 12ª semana del embarazo) están comprando activamente medios no aromáticos.

Gracias a estos datos, les envían cupones con descuentos en medios osarativos con un período limitado.

¿Y si eres solo un café muy pequeño, por ejemplo? Sí, muy simple. Utilice la solicitud de lealtad.

Y después de un tiempo, gracias a la información acumulada, no solo puede ofrecer a los clientes relevantes a sus necesidades, sino también a ver los platos más poco fiables y marginales, literalmente, un par de clics del mouse.

De ahí la salida. La introducción de la gran fecha de las pequeñas empresas apenas vale la pena, sino utilizar los resultados y desarrollos de otras compañías, asegúrese de.

Cómo pagar un nombre de dominio

Cómo pagar un nombre de dominio Zona de dominio de las islas Tokelau

Zona de dominio de las islas Tokelau ¿Qué es el dominio qué problemas pueden ser?

¿Qué es el dominio qué problemas pueden ser? YANDEX WORDSTAT: Instrucciones detalladas para usar los operadores de servicio y agrupación y una solicitud complicada

YANDEX WORDSTAT: Instrucciones detalladas para usar los operadores de servicio y agrupación y una solicitud complicada Edición de archivos DBF

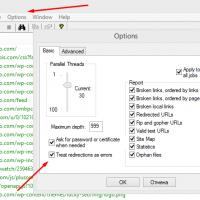

Edición de archivos DBF Xenu Link Sleuth: ¿Qué es este programa cómo usar el programa XENU?

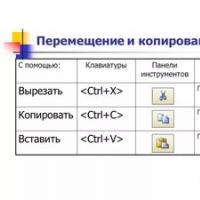

Xenu Link Sleuth: ¿Qué es este programa cómo usar el programa XENU? Métodos Copia e inserte texto desde el teclado sin usar el mouse

Métodos Copia e inserte texto desde el teclado sin usar el mouse