Підготовка данних. Факторний аналіз. Основні рівняння і процедури факторного аналізу Метод головних компонент. матриця рахунків

Являють собою сукупність статистичних процедур, спрямованих на виділення із заданої множини змінних підмножин змінних, тісно пов'язаних (корелюють) між собою. Змінні, що входять в одне підмножина і корелюють між собою, але в значній мірі незалежні від змінних з інших підмножин, утворюють фактори. Мета факторного аналізу - ідентифікувати явно не спостерігаються чинники за допомогою безлічі спостережуваних змінних. Додатковим способом перевірки числа виділених факторів є обчислення кореляційної матриці, яка близька вихідної, якщо фактори виділені правильно. Ця матриця називається відтвореної кореляційної матрицею. Для того щоб побачити, як ця матриця відхиляється від вихідної кореляційної матриці (з якої починався аналіз), можна обчислити різницю між ними. Залишкова матриця може вказати на "незгоду", т. Е. На те, що розглянуті коефіцієнти кореляції не можуть бути отримані з достатньою точністю на основі наявних факторів. У методах головних компонент і факторного аналізу не існує такого зовнішнього критерію, що дозволяє судити про правильність рішення. Друга проблема полягає в тому, що після виділення факторів виникає безліч варіантів обертання, що базуються на тих самих вихідних змінних, що дають різні рішення (факторні структури визначаються дещо в інший спосіб). Остаточний вибір між можливими альтернативами всередині нескінченної кількості математично рівнозначних рішень залежить від змістовного осмислення дослідниками результатів інтерпретації. А оскільки об'єктивного критерію для оцінки різних рішень немає, пропоновані обґрунтування вибору рішення можуть здаватися голослівними і непереконливими.

Треба відзначити, що чітких статистичних критеріїв повноти факторизации не існує. Проте, низькі її значення, наприклад менше 0,7, свідчать про бажаність скорочення кількості ознак або збільшення кількості факторів.

Мет Коефіцієнт взаємозв'язку між деякими ознакою і загальним фактором, що виражає міру впливу фактора на ознаку, називається факторною навантаженням даної ознаки з даного загального фактору.

Матриця, що складається з факторних навантажень і має число стовпців, яка дорівнює кількості загальних факторів, і число рядків, яка дорівнює кількості вихідних ознак, називається факторною матрицею.

Основою для обчислення факторної матриці є матриця парних коефіцієнтів кореляції вихідних ознак.

Кореляційна матриця фіксує ступінь взаємозв'язку між кожною парою ознак. Аналогічно факторная матриця фіксує ступінь лінійного зв'язку кожної ознаки з кожним загальним фактором.

Величина факторной навантаження не перевищує по модулю одиниці, а знак її говорить про позитивної чи негативної зв'язку ознаки з фактором.

Чим більше абсолютна величина факторної навантаження ознаки по деякому фактору, тим більшою мірою цей фактор визначає цей показник.

Значення факторной навантаження по деякому фактору, близьке до нуля, говорить про те, що цей фактор практично на даний ознака не впливає.

Факторна модель дає можливість обчислювати вклади факторів в загальну дисперсію всіх ознак. Підсумовуючи квадрати факторних навантажень для кожного фактора за всіма ознаками, отримуємо його внесок в загальну дисперсію системи ознак: чим вище частка цих надходжень, тим більш значущим, важливим є даний фактор.

При цьому можна виявити і оптимальна кількість загальних факторів, досить добре описують систему вихідних ознак.

Значення (міра прояви) фактора у окремого об'єкта називається факторний вагою об'єкта з даного фактору. Факторні ваги дозволяють ранжувати, впорядкувати об'єкти по кожному фактору.

Чим більше факторний вагу деякого об'єкту, тим більше в ньому проявляється та сторона явища чи та закономірність, від якої потерпають даними фактором.

Факторні ваги можуть бути як позитивними, так і негативними.

В силу того, що фактори є стандартизованими величинами із середнім значенням, рівним нулю, факторні ваги, близькі до нуля, кажуть про середнього ступеня прояву фактора, позитивні - про те, що ця ступінь вище середньої, негативні - про те. ч то вона нижча за середню.

Практично, якщо число вже знайдених головних компонент (або факторів) не більш, ніж m/ 2, яка пояснюється ними дисперсія не менше 70%, а наступна компонента дає внесок в сумарну дисперсію не більше 5%, факторна модель вважається досить хорошою.

Якщо Ви хочете знайти значення факторів і зберегти їх у вигляді додаткових змінних задійте вимикач Scores ... (Значення) факторний значення, як правило, лежить в межах -3 до +3.

Факторний аналіз - більш потужний і складний апарат, ніж метод головних

компонент, тому він застосовується в тому випадку, якщо результати

компонентного аналізу не цілком влаштовують. Але оскільки ці два методи

вирішують однакові завдання, необхідно порівняти результати компонентного і

факторного аналізів, т. е. матриці навантажень, а також рівняння регресії на

головні компоненти і загальні чинники, прокоментувати схожість і відмінності

результатів.

Максимально можливу кількість чинників m при заданому числі ознак р визначається нерівністю

(Р + m)<(р-m)2,

На завершення всієї процедури факторного аналізу за допомогою математичних перетворень висловлюють фактори fj через вихідні ознаки, тобто отримують в явному вигляді параметри лінійної діагностичної моделі.

Методи головних компонент і факторного аналізу є сукупність статистичних процедур, спрямованих на виділення із заданої множини змінних підмножин змінних, тісно пов'язаних (корелюють) між собою. Змінні, що входять в одне підмножина і корелюють між собою, але в значній мірі незалежні від змінних з інших підмножин, утворюють чинники 1 . Мета факторного аналізу - ідентифікувати явно не спостерігаються чинники за допомогою безлічі спостережуваних змінних.

Загальна вираз для j-го фактора може бути записано так:

де Fj (j змінюється від 1 до k) - це загальні фактори, Ui - характерний, Aij - константи, що використовуються в лінійної комбінації k чинників. Характерні чинники можуть не корелювати один з одним і з загальними факторами.

Процедури факторно-аналітичної обробки, що застосовуються до отриманих даних, різні, але структура (алгоритм) аналізу складається з одних і тих же основних етапів: 1. Підготовка вихідної матриці даних. 2. Обчислення матриці взаємозв'язків ознак. 3. Факторизация (При цьому необхідно вказати кількість факторів, що виділяються в ході факторного рішення, і метод обчислення). На цьому етапі (як і на наступному) можна також оцінити, наскільки добре отримане факторний рішення зближує вихідні дані. 4. Обертання - перетворення факторів, що полегшує їх інтерпретацію. 5. Підрахунок факторних значень по кожному фактору для кожного спостереження. 6. інтерпретація даних.

винахід факторного аналізу було пов'язано саме з необхідністю одночасного аналізу великої кількості коефіцієнтів кореляції різних шкал між собою. Одна з проблем, пов'язаних з методами головних компонент і факторного аналізу полягає в тому, що критеріїв, які дозволяли б перевірити правильність знайденого рішення, не існує. Наприклад, при регресійному аналізі можна зіставити показники по залежним змінним, отримані емпіричним шляхом, з показниками, обчисленими теоретично на основі запропонованої моделі, і використовувати кореляцію між ними як критерій правильності рішення по схемі кореляційного аналізу для двох наборів змінних. У дискримінантному аналізі правильність рішення базується на тому, наскільки точно передбачена приналежність випробовуваних до тих чи інших класів (якщо порівнювати з реальною належністю, що має місце в житті). На жаль, в методах головних компонент і факторного аналізу не існує такого зовнішнього критерію, що дозволяє судити про правильність рішення, Друга проблема полягає в тому, що після виділення факторів виникає безліч варіантів обертання, що базуються на тих самих вихідних змінних, що дають різні рішення ( факторні структури визначаються дещо в інший спосіб). Остаточний вибір між можливими альтернативами всередині нескінченної кількості математично рівнозначних рішень залежить від змістовного осмислення дослідниками результатів інтерпретації. А оскільки об'єктивного критерію для оцінки різних рішень немає, пропоновані обґрунтування вибору рішення можуть здаватися голослівними і непереконливими.

Третя проблема полягає в тому, що факторний аналіз досить часто застосовують з метою врятувати погано продумане дослідження, коли стає ясно, що жодна статистична процедура не дає бажаного результату. Міць методів головних компонент і факторного аналізу дозволяє з хаотичною інформації вибудувати впорядковану концепцію (що і створює їм сумнівну репутацію).

Друга група термінів відноситься до матриць, які будуються і інтерпретуються як частина рішення. поворот факторів - це процес пошуку найбільш легко інтерпретується рішення для даної кількості факторів. Існують два основні класи поворотів: ортогональний і скіс. У першому випадку все чинники апріорно вибираються ортогональними (не корелює один з одним) і будується матриця факторних навантажень, Що представляє собою матрицю взаємозв'язків між що спостерігаються змінними і факторами. Величина навантажень відображає ступінь зв'язку кожної спостерігається змінної і кожним фактором і інтерпретується як коефіцієнт кореляції між спостерігається змінної і фактором (латентної змінної), а тому змінюється в межах від -1 до 1. Рішення, отримане після ортогонального повороту, інтерпретується на основі аналізу матриці факторних навантажень шляхом виявлення того, з яким з факторів в максимальному ступені пов'язана та чи інша спостерігається змінна. Таким чином, кожен фактор виявляється заданим групою первинних змінних, що мають по ньому найбільші факторні навантаження.

Якщо виконується косокутність обертання (т. Е. Апріорно допускається можливість кореляції факторів між собою), то будується ще кілька додаткових матриць. Матриця факторной кореляції містить кореляції між факторами. Матриця факторних навантажень, Згадана вище, розщеплюється на дві: структурну матрицю взаємозв'язків між факторами і змінними і матрицю факторного відображення, Яка має лінійні взаємозв'язку між кожною спостерігається змінної і кожним фактором (без урахування впливу накладення одних факторів на інші, що виражається кореляцією факторів між собою). Після косокутного обертання інтерпретація факторів відбувається на основі угруповання первинних змінних (подібно до того, як було описано вище), але вже з використанням в першу чергу матриці факторного відображення.

Нарешті, для обох поворотів обчислюється матриця коефіцієнтів факторних значень, Яка використовується в спеціальних рівняннях регресійного типу для обчислення факторних значень (факторних балів, показників по факторам) для кожного спостереження на основі значень для них первинних змінних.

Порівнюючи методи головних компонент і факторного аналізу, зазначимо таке. В ході виконання аналізу за методом головних компонент будується модель для найкращого пояснення (максимального відтворення) повної дисперсії експериментальних даних, отриманих по всім змінним. В результаті виділяються «компоненти». При факторному аналізі передбачається, що кожна змінна пояснюється (детермінується) деякою кількістю гіпотетичних загальних факторів (впливають на всі змінні) і характерними факторами (для кожної змінної своїми). І обчислювальні процедури виконуються таким чином, щоб звільнитися як від дисперсії, отриманої в результаті помилки вимірювання, так і від дисперсії, що пояснюється специфічними факторами, і аналізувати тільки дисперсії, що пояснюється гіпотетично існуючими загальними факторами. В результаті виходять об'єкти, звані чинниками. Однак, як уже згадувалося, з змістовно-психологічної точки зору ця різниця в математичних моделях істотного значення не має, тому в подальшому, якщо не дається особливих пояснень, про який саме разі йдеться, ми будемо використовувати термін «фактор» як по відношенню до компонентів, так і по відношенню до факторів.

Розміри вибірки і пропущені дані. Чим більше вибірка, тим більше вірогідність показників взаємозв'язку. Тому дуже важливо мати достатньо велику вибірку. Необхідний розмір вибірки також залежить від ступеня взаємозв'язку показників в популяції в цілому і кількості факторів: при сильній і достовірної взаємозв'язку і невеликій кількості чітко окреслених чинників буде досить і не дуже великий вибірки.

Так, вибірка, розмір якої 50 випробовуваних, оцінюється як дуже погана, 100 - погана, 200 - середня, 300 - хороша, 500 - дуже хороша і 1000 - чудова ( Comrey, Lee, 1992). Виходячи з цих міркувань, як загальний принцип можна порекомендувати досліджувати вибірки не менше 300 випробовуваних. Для вирішення, що базується на достатній кількості маркерних змінних з високими факторними навантаженнями (\u003e 0.80) досить вибірки близько 150 випробовуваних ( Guadagnoli, Velicer, 1988). нормальність для кожної змінної окремо перевіряється по асиметрії (Наскільки крива досліджуваного розподілу зрушена вправо або вліво в порівнянні з теоретично нормальної кривої) і ексцесу (Ступінь витягнутості вгору або прогнутися вниз «дзвони» наявного розподілу, візуально представленого в частотної діаграмі, в порівнянні з «дзвоном» графіка щільності, характерним для нормального розподілу). Якщо змінна має суттєві асиметрію і ексцес, то її можна перетворити, ввівши нову змінну (як однозначну функцію від розглянутої) таким чином, щоб ця нова змінна була розподілена нормально (докладніше про це див .: Tabachnik, Fidell, 1996, гл. 4).

Власні вектори і відповідні власні числа

для розглянутого навчального прикладу

Власний вектор 1 | Власний вектор 2 |

Власне значення 1 | Власне значення 2 |

Оскільки кореляційна матриця діагоналізіруема, то для отримання результатів факторного аналізу до неї можна застосовувати матричну алгебру власних векторів і власних величин (див. Додаток 1). Якщо матриця діагоналізіруема, то вся суттєва інформація про факторной структурі міститься в її діагональної формі. У факторному аналізі власні числа відповідають дисперсії, що пояснюється факторами. Фактор з найбільшою власної величиною пояснює найбільшу дисперсію і т. Д., Поки не доходить до факторів з невеликими або негативними власними величинами, які зазвичай не враховуються при аналізі. Матриця факторних навантажень є матрицею взаємозв'язків (інтерпретованих як коефіцієнти кореляцій) між факторами і змінними. Перший стовпець - це кореляції між першим фактором і кожної змінної по черзі: вартість путівки (-.400), комфортабельність комплексу (.251), температура повітря (.932), температура води (.956). Другий стовпець - це кореляції між другим фактором і кожної змінної: вартість путівки (.900), комфортабельність комплексу (-.947), температура повітря (.348), температура води (.286). Фактор інтерпретується на основі сильно пов'язаних з ним (т. Е. Мають по ньому високі навантаження) змінних. Так, перший фактор головним чином «кліматичний» ( температура повітря і води), В той час як другий «економічний» ( вартість путівки і комфортабельність комплексу).

Інтерпретуючи ці фактори, слід звернути увагу на те, що змінні, які мають високі навантаження на першу фактору ( температура повітря і температура води), Взаємопов'язані позитивно, тоді як змінні, що мають високі навантаження по другому фактору ( вартість путівки і комфортабельність комплексу), Взаємопов'язані негативно (від дешевого курорту можна очікувати великий комфортабельності). Перший фактор називається уніполярним (всі змінні згруповані на одному полюсі), а другий - біполярним (Змінні розпалися на дві протилежні за змістом групи - два полюси). Змінні, що мають факторні навантаження зі знаком «плюс», утворюють позитивний полюс, а зі знаком «мінус» - негативний. При цьому назви полюсів «позитивний» і «негативний» при інтерпретації фактора не мають оцінного сенсу «поганий» і «хороший». Вибір знака відбувається під час обчислень випадковим чином. ортогональное обертання

Обертання зазвичай застосовується після виділення факторів для максимізації високих кореляцій і мінімізації низьких. Існують численні методи обертання, але найчастіше використовується поворот варимакс, Що представляє собою процедуру максимізації дисперсій. Цей поворот максимізує дисперсії факторних навантажень, роблячи високі навантаження вище, а низькі нижче для кожного з факторів. Ця мета досягається за допомогою матриці перетворення Λ:

матриця перетворення - це матриця синусів і косинусів кута Ψ, на який виконується поворот. (Звідси і назва перетворення - поворот, Тому що з геометричної точки зору відбувається поворот осей навколо початку координат факторного простору.) Виконавши поворот і отримавши матрицю факторних навантажень після повороту, можна проаналізувати серію інших показників (див. Табл. 4). спільність змінної - це дисперсія, розрахована за допомогою факторних навантажень. Це квадратична множинна кореляція змінної, передбачена моделлю чинника. Спільність обчислюється як сума квадратів факторних навантажень (СКН) для змінної за всіма чинниками. У табл. 4 спільність для вартості путівки дорівнює (-.086) 2 + (. 981) 2 \u003d .970, т. е. 97% дисперсії вартості путівки пояснюється факторами 1 і 2.

Частка дисперсії фактора по всім змінним - це СКН по фактору, поділена на кількість змінних (в разі ортогонального обертання) 7 . Для першого чинника частка дисперсії дорівнює:

[(-.086)2+(-.071)2+(.994)2+(.997)2]/4 = 1.994/4 = .50,

т. е. перший фактор пояснює 50% дисперсії змінних. Другий фактор пояснює 48% дисперсії змінних і (в силу ортогональності обертання) два фактора в сумі пояснюють 98% дисперсії змінних.

Зв'язок між факторними навантаженнями, спільнотами, СКН,

дисперсією і коваріації ортогональних факторів після повороту

спільності ( h2) |

|||

вартість путівки | Σa2=.970 |

||

рівень комфорту | Σa2=.960 |

||

Температура повітря | Σa2=.989 |

||

Температура води | Σa2=.996 |

||

Σa2=1.994 | Σa2=1.919 | ||

частка дисперсії | |||

частка ковариации |

Частка дисперсії рішення, яка пояснюється фактором, - частка ковариации - це СКН для фактора, поділена на суму спільнот (суму СКН по змінним). Перший фактор пояснює 51% дисперсії рішення (1.994 / 3.915); другий - 49% (1.919 / 3.915); два фактори разом пояснюють всю ковариацию.

Eigenval - відображають величину дисперсії відповідної кількості факторів. В якості вправи рекомендуємо виписати всі ці формули для отримання розрахункових значень по змінним. Наприклад, для першого респондента:

1.23 = -.086(1.12) + .981(-1.16)

1.05 = -.072(1.12) - .978(-1.16)

1.08 = .994(1.12) + .027(-1.16)

1.16 = .997(1.12) - .040(-1.16)

Або в алгебраїчній формі:

Z вартості путівки = a11F1 + a12F2

Z комфортабельності комплексу = a2l F1 + a22F2

Z температури повітря = a31F1 + a32F2

Z температури води = a41F1 + a42F2

Чим більше навантаження, тим з більшою впевненістю можна вважати, що змінна визначає фактор. Комрі і Лі ( Comrey, Lee, 1992) припускають, що навантаження, що перевищують 0.71 (пояснює 50% дисперсії), - чудові, 0% дисперсії) - дуже хороші, 0%) - хороші, 0%) - задовільні і 0.32 (пояснює 10% дисперсії) - слабкі.

Припустимо, що ви проводите (до деякої міри "дурне") дослідження, в якому вимірюєте зростання ста людей в дюймах і сантиметрах. Таким чином, у вас є дві змінні. Якщо далі ви захочете дослідити, наприклад, вплив різних харчових добавок на ріст, чи будете ви продовжувати використовувати обидві змінні? Ймовірно, немає, т. К. Зростання є однією характеристикою людини, незалежно від того, в яких одиницях він вимірюється.

Залежність між змінними можна виявити за допомогою діаграми розсіювання. Отримана шляхом підгонки лінія регресії дає графічне представлення залежності. Якщо визначити нову змінну на основі лінії регресії, зображеної на цій діаграмі, то така змінна буде включити в себе найбільш суттєві риси обох змінних. Отже, фактично, ви скоротили число змінних і замінили дві однієї. Відзначимо, що новий фактор (змінна) в дійсності є лінійною комбінацією двох вихідних змінних.

ЕТАПИ ВИКОНАННЯ факторний аналіз

Можна виділити дев'ять етапів факторного аналізу. Для наочності представимо ці етапи на схемі, а потім дамо їм коротку характеристику.

Етапи виконання факторного аналізу наведені на рис.

Мал.

Формулювання ПРОБЛЕМИ І ПОБУДОВА кореляційної МАТРИЦІ

Формулювання проблеми.Необхідно чітко визначити цілі факторного аналізу. Змінні, що піддаються факторному аналізу, задаються виходячи з минулих досліджень, теоретичних викладок або на розсуд дослідника. Необхідно, щоб змінні вимірювалися в інтервального або відносноїшкалою. Досвід показує, що обсяг вибірки повинен бути більше в чотири - п'ять разів, ніж число змінних.

Побудова кореляційної матриці.В основі аналізу лежить матриця кореляції між змінними. Доцільність виконання факторного аналізу визначається наявністю кореляцій між змінними. Якщо ж кореляції між усіма змінними невеликі, то факторний аналіз проводити марно. Змінні, тісно взаємопов'язані між собою, як правило, тісно корелюють з одним і тим же фактором або факторами.

Для перевірки доцільності використання факторної моделі існує кілька статистик. За допомогою критерію сферичності Бартлетта перевіряється нульова гіпотеза про відсутність кореляції між змінними в генеральної сукупності. Це означає, що розглядається твердження про те, що кореляційна матриця сукупності - це одинична матриця, в якій всі діагональні елементи дорівнюють одиниці, а всі інші дорівнюють нулю. Перевірка за допомогою критерію сферичності заснована на перетворенні детермінанта кореляційної матриці в статистику хі-квадрат. При великому значенні статистики нульову гіпотезу відхиляють. Якщо ж нульову гіпотезу не відхиляють, то виконання факторного аналізу недоцільно. Інша корисна статистика - критерій адекватності вибірки Кайзера-Мейера-Олкіна (КМО). Даний коефіцієнт порівнює значення спостережуваних коефіцієнтів кореляції зі значеннями приватних коефіцієнтів кореляції. Невеликі значення КМО - статистики вказують на те, що кореляції між парами змінних не можна пояснити іншими змінними, а це значить, що використання факторного аналізу недоцільно.

ФАКТОРНИЙ АНАЛІЗ

Ідея факторного аналізу

При дослідженні складних об'єктів, явищ, систем фактори, що визначають властивості цих об'єктів, дуже часто неможливо виміряти безпосередньо, а іноді невідомо навіть їх число і сенс. Але для вимірювання можуть бути доступні інші величини, так чи інакше залежать від цікавлять нас факторів. Причому, коли вплив невідомого цікавить нас фактора проявляється в декількох вимірюваних ознаках або властивостях об'єкта, ці ознаки можуть виявляти тісний зв'язок між собою і загальне число факторів може бути набагато менше, ніж число вимірюваних змінних.

Для виявлення факторів, що визначають вимірювані ознаки об'єктів, використовуються методи факторного аналізу

Як приклад застосування факторного аналізу можна вказати вивчення властивостей особистості на основі психологічних тестів. Властивості особистості не піддаються прямому вимірюванню. Про них можна судити лише по поведінці людини або характером відповідей на питання. Для пояснення результатів дослідів їх піддають факторному аналізу, який і дозволяє виявити ті особистісні властивості, які впливають на поведінку індивідуума.

В основі різних методів факторного аналізу лежить наступна гіпотеза: спостерігаються або вимірюються параметри є лише непрямими характеристиками досліджуваного об'єкта, в дійсності існують внутрішні (приховані, латентні, що не спостерігаються безпосередньо) параметри і властивості, число яких мало і які визначають значення спостережуваних параметрів. Ці внутрішні параметри прийнято називати факторами.

Мета факторного аналізу - сконцентрувати вихідну інформацію, висловлюючи велику кількість розглянутих ознак через меншу кількість більш ємних внутрішніх характеристик явища, які, однак, не піддаються безпосередньому виміру

Встановлено, що виділення і подальше спостереження за рівнем загальних факторів дає можливість виявляти предотказние стану об'єкта на дуже ранніх стадіях розвитку дефекту. Факторний аналіз дозволяє відслідковувати стабільність кореляційних зв'язків між окремими параметрами. Саме кореляційні зв'язки між параметрами, а також між параметрами та спільними факторами містять основну діагностичну інформацію про процеси. Застосування інструментарію пакета Statistica при виконанні факторного аналізу виключає необхідність використання додаткових обчислювальних засобів і робить аналіз наочним і зрозумілим для користувача.

Результати факторного аналізу будуть успішними, якщо вдається дати інтерпретацію виявлених чинників, виходячи зі змісту показників, що характеризують ці чинники. Дана стадія роботи дуже відповідальна; вона вимагає чіткого уявлення про змістовному сенсі показників, які залучені для аналізу і на основі яких виділено чинники. Тому при попередньому ретельному відборі показників для факторного аналізу слід керуватися їх змістом, а не прагненням до включення в аналіз якомога більшого їх числа.

Сутність факторного аналізу

Наведемо кілька основних положень факторного аналізу. Нехай для матриці Х виміряних параметрів об'єкта існує ковариационная (кореляційний) матриця C, де р - число параметрів, n - число спостережень. Шляхом лінійного перетворення X=QY+U можна зменшити розмірність вихідного факторного простору Х до рівня Y, при цьому р"<<р. Це відповідає перетворенню точки, що характеризує стан об'єкта в jвимірному просторі, в новий простір вимірювань з меншою розмірністю р". Очевидно, що геометрична близькість двох або безлічі точок в новому факторному просторі означає стабільність стану об'єкта.

матриця Y містить неспостережувані фактори, які по суті є гіперпараметрамі, що характеризують найбільш загальні властивості аналізованого об'єкта. Загальні чинники найчастіше вибирають статистично незалежними, що полегшує їх фізичну інтерпретацію. Вектор спостережуваних ознак Х має сенс слідства зміни цих гіперпараметров.

матриця U складається з залишкових факторів, які включають в основному помилки вимірювання ознак x(i). прямокутна матриця Q містить факторні навантаження, що визначають лінійну зв'язок між ознаками і гіперпараметрамі.

Факторні навантаження - це значення коефіцієнтів кореляції кожного з вихідних ознак з кожним з виявлених факторів. Чим тісніше зв'язок даної ознаки з даним фактором, тим вище значення факторної навантаження. Позитивний знак факторной навантаження вказує на пряму (а негативний знак - на зворотну) зв'язок даної ознаки з фактором.

Таким чином, дані про факторних навантаженнях дозволяють сформулювати висновки про набір вихідних ознак, що відображають той чи інший фактор, і про відносне вазі окремого ознаки в структурі кожного фактора.

Модель факторного аналізу схожа на моделі багатовимірного регресійного і дисперсійного аналізу. Принципова відмінність моделі факторного аналізу в тому, що вектор Y - це неспостережувані чинники, а в регресійному аналізі - це реєстровані параметри. У правій частині рівняння (8.1) невідомими є матриця факторних навантажень Q і матриця значень загальних факторів Y.

Для знаходження матриці факторних навантажень використовують уравненіеQQ т \u003d S-V, де Q т - транспонована матриця Q, V - матриця ковариаций залишкових факторів U, тобто . Рівняння вирішується шляхом ітерацій при завданні деякого нульового наближення ковариационной матриці V (0). Після знаходження матриці факторних навантажень Q обчислюються загальні фактори (гіперпараметри) за рівнянням

Y \u003d (Q т V -1) Q -1 Q т V -1 X

Пакет статистичного аналізу Statistica дозволяє в діалоговому режимі обчислити матрицю факторних навантажень, а також значення декількох заздалегідь заданих головних чинників, найчастіше двох - за першими двома головних компонентів вихідної матриці параметрів.

Факторний аналіз в системі Statistica

Розглянемо послідовність виконання факторного аналізу на прикладі обробки результатів анкетного опитування працівників підприємства. Потрібно виявити основні чинники, які визначають якість трудового життя.

На першому етапі необхідно відібрати змінні для проведення факторного аналізу. Використовуючи кореляційний аналіз, дослідник намагається виявити взаємозв'язок досліджуваних ознак, що, в свою чергу, дає йому можливість виділити повний і безизбиточний набір ознак шляхом об'єднання сильно корелюють ознак.

Якщо проводити факторний аналіз по всім змінним, то результати можуть вийти не зовсім об'єктивними, так як деякі змінні визначається іншими даними, і не можуть регулюватися співробітниками даної організації.

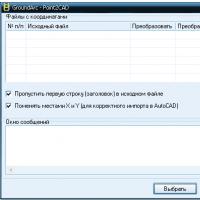

Для того щоб зрозуміти, які показники слід виключити, побудуємо за наявними даними матрицю коефіцієнтів кореляції в Statistica: Statistics / Basic Statistics / Correlation Matrices / Ok. У стартовому вікні цієї процедури Product-Moment and Partial Correlations (рис. 4.3) для розрахунку квадратної матриці використовується кнопка One variable list. Вибираємо всі змінні (select all), Ok, Summary. Отримуємо кореляційну матрицю.

Якщо коефіцієнт кореляції змінюється в межах від 0,7 до 1, то це означає сильну кореляцію показників. В цьому випадку можна виключити одну змінну з сильною кореляцією. І навпаки, якщо коефіцієнт кореляції малий, можна виключити змінну через те, що вона нічого не додасть до загальної суми. У нашому випадку сильної кореляції між будь-якими змінними не спостерігається, і факторний аналіз будемо проводити для повного набору змінних.

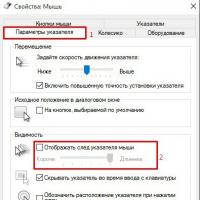

Для запуску факторного аналізу необхідно викликати модуль Statistics / Multivariate Exploratory Techniques (багатовимірні дослідні методи) / Factor Analysis (факторний аналіз). На екрані з'явиться вікно модуля Factor Analysis.

Для аналізу вибираємо всі змінні електронної таблиці; Variables (змінні): select all, Ok. У рядку Input file (тип файлу вхідних даних) вказується Raw Data (вихідні дані). У модулі можливі два типи вихідних даних - Raw Data (вихідні дані) і Correlation Matrix - кореляційна матриця.

У розділі MD deletion задається спосіб обробки пропущених значень:

* Casewise - спосіб виключення пропущених значень (за замовчуванням);

* Pairwise - парний спосіб виключення пропущених значень;

* Mean substitution - підстановка середнього замість пропущених значень.

Спосіб Casewise полягає в тому, що в електронній таблиці, що містить дані, ігноруються всі рядки, в яких є хоча б одне пропущене значення. Це відноситься до всіх змінним. У способі Pairwise ігноруються пропущені значення не для всіх змінних, а лише для вибраної пари.

Виберемо спосіб обробки пропущених значень Casewise.

Statistica обробить пропущені значення тим способом, який вказано, вирахує кореляційну матрицю і запропонує на вибір кілька методів факторного аналізу.

Після натискання кнопки Ok з'являється вікно Define Method of Factor Extraction (визначити метод виділення факторів).

Верхня частина вікна є інформаційною. Тут повідомляється, що пропущені значення оброблені методом Casewise. Опрацьовано 17 спостережень і 17 спостережень прийнято для подальших обчислень. Кореляційна матриця обчислена для 7 змінних. Нижня частина вікна містить 3 вкладки: Quick, Advanced, Descriptives.

У вкладці Descriptives (описові статистики) є дві кнопки:

1 переглянути кореляції, середні і стандартні відхилення;

2 побудувати множинну регресію.

Натиснувши на першу кнопку, можна подивитися середні і стандартні відхилення, кореляції, ковариации, побудувати різні графіки і гістограми.

У вкладці Advanced, в лівій частині, виберемо метод (Extraction method) факторного аналізу: Principal components (метод головних компонент). У правій частині вибираємо максимальне число факторів (2). Задається або максимальне число факторів (Max no of factors), або мінімальне власне значення: 1 (eigenvalue).

Натискаємо Ok, і Statistica швидко проізвёдет \u200b\u200bобчислення. На екрані з'являється вікно Factor Analysis Results (результати факторного аналізу). Як говорилося раніше, результати факторного аналізу виражаються набором факторних навантажень. Тому далі будемо працювати з вкладкою Loadings.

Верхня частина вікна - інформаційна:

Number of variables (число аналізованих змінних): 7;

Method (метод виділення факторів): Principal components (головних компонент);

Log (10) determinant of correlation matrix (десятковий логарифм детермінанта кореляційної матриці): -1,6248;

Number of factors extracted (число виділених факторів): 2;

Eigenvalues \u200b\u200b(власні значення): 3,39786 і 1,19130.

У нижній частині вікна знаходяться функціональні кнопки, що дозволяють всебічно ознайомитись з результатами аналізу, чисельно і графічно.

Factor rotation - обертання факторів, в даному випадаючому вікні можна вибрати різні повороти осей. За допомогою повороту системи координат можна отримати безліч рішень, з якого необхідно вибрати інтерпретується рішення.

Існують різні методи обертання координат простору. Пакет Statistica пропонує вісім таких методів, представлених в модулі факторного аналізу. Так, наприклад, метод варимакс відповідає перетворенню координат: обертання, максимізуючи дисперсію. У методі варимакс отримують спрощене опис стовпців факторной матриці, зводячи все значення до 1 або 0. При цьому розглядається дисперсія квадратів навантажень фактора. Факторна матриця, що отримується за допомогою методу обертання варимакс, більшою мірою інваріантна стосовно вибору різних множин змінних.

Обертання методом квартімакс ставить за мету аналогічне спрощення тільки по відношенню до рядків факторной матриці. Еквімакс займає проміжне положення? при обертанні факторів за цим методом одночасно робиться спроба спростити і стовпці, і рядки. Розглянуті методи обертання відносяться до ортогональним обертанням, тобто в результаті виходять некорельовані чинники. Методи прямого обліміна і ПРОМАКС обертання відносяться до косокутних обертанням, в результаті яких виходять корельовані між собою фактори. Термін? Normalized? в назвах методів вказує на те, що факторні навантаження нормуються, тобто діляться на квадратний корінь з відповідною дисперсії.

З усіх пропонованих методів, ми спочатку подивимося результат аналізу без обертання системи координат - Unrotated. Якщо отриманий результат виявиться інтерпретується і буде нас влаштовувати, то на цьому можна зупинитися. Якщо немає, можна обертати осі і подивитися інші рішення.

Клацаємо по кнопці "Factor Loading" і дивимося факторні навантаження чисельно.

Нагадаємо, що факторні навантаження - це значення коефіцієнтів кореляції кожної з змінних з кожним з виявлених факторів.

Значення факторной навантаження, більше 0,7 показує, що дана ознака або змінна тісно пов'язаний з даним фактором. Чим тісніше зв'язок даної ознаки з даним фактором, тим вище значення факторної навантаження. Позитивний знак факторной навантаження вказує на пряму (а негативний знак? На зворотну) зв'язок даної ознаки з фактором.

Отже, з таблиці факторних навантажень було виявлено два фактора. Перший визначає ОСБ - відчуття соціального благополуччя. Решта змінні обумовлені другим фактором.

У рядку Expl. Var (рис. 8.5) наведена дисперсія, яка припадає на той чи інший фактор. У рядку Prp. Totl приведена частка дисперсії, яка припадає на перший і другий фактор. Отже, на перший фактор доводиться 48,5% всієї дисперсії, а на другий фактор - 17,0% всієї дисперсії, все решта припадає на інші невраховані фактори. У підсумку, два виявлених фактори пояснюють 65,5% всієї дисперсії.

Тут ми також бачимо дві групи чинників - ОСБ і інше безліч змінних, з яких виділяється ЖСР - бажання змінити роботу. Мабуть, має сенс досліджувати це бажання грунтовніше на основі збору додаткових даних.

Вибір і уточнення кількості факторів

Як тільки отримано інформацію про те, скільки дисперсії виділив кожен фактор, можна повернутися до питання про те, скільки чинників слід залишити. За своєю природою це рішення довільно. Але є деякі загальновживані рекомендації, і на практиці дотримання ним дає найкращі результати.

Кількість загальних факторів (гіперпараметров) визначається шляхом обчислення власних чисел (рис. 8.7) матриці Х в модулі факторного аналізу. Для цього у вкладці Explained variance (рис. 8.4) необхідно натиснути кнопку Scree plot.

Максимальне число загальних факторів може дорівнювати кількості власних чисел матриці параметрів. Але зі збільшенням числа факторів істотно зростають труднощі їх фізичної інтерпретації.

Спочатку можна відібрати тільки фактори, з власними значеннями, більшими 1. По суті, це означає, що якщо фактор не виділяє дисперсію, еквівалентну, принаймні, дисперсії однієї змінної, то він опускається. Цей критерій використовується найбільш широко. У наведеному вище прикладі на основі цього критерію слід зберегти тільки 2 фактора (дві головні компоненти).

Можна знайти таке місце на графіку, де спадання власних значень зліва направо максимально сповільнюється. Передбачається, що праворуч від цієї точки знаходиться тільки "факторіальна осип". Відповідно до цього критерію можна залишити в прикладі 2 або 3 фактори.

З рис. видно, що третій фактор незначно збільшує частку загальної дисперсії.

Факторний аналіз параметрів дозволяє виявити на ранній стадії порушення робочого процесу (виникнення дефекту) в різних об'єктах, яке часто неможливо помітити шляхом безпосереднього спостереження за параметрами. Це пояснюється тим, що порушення кореляційних зв'язків між параметрами виникає значно раніше, ніж зміна одного параметра. Таке спотворення кореляційних зв'язків дозволяє своєчасно виявити факторний аналіз параметрів. Для цього достатньо мати масиви зареєстрованих параметрів.

Можна дати загальні рекомендації по використанню факторного аналізу незалежно від предметної області.

* На кожен фактор має припадати не менше двох виміряних параметрів.

* Число вимірювань параметрів повинно бути більше числа змінних.

* Кількість чинників повинне обґрунтовуватися, виходячи з фізичної інтерпретації процесу.

* Завжди слід домагатися того, щоб кількість чинників було набагато менше числа змінних.

Критерій Кайзера іноді зберігає занадто багато факторів, в той час як критерій кам'янистій осипи іноді зберігає занадто мало факторів. Однак обидва критерії цілком хороші при нормальних умовах, коли є відносно невелике число факторів і багато змінних. На практиці більш важливим є питання про те, коли отримане рішення може бути інтерпретовано. Тому зазвичай досліджується кілька рішень з більшим чи меншим числом факторів, і потім вибирається один найбільш осмислене.

Простір вихідних ознак повинно бути представлено в однорідних шкалах виміру, т. К. Це дозволяє при обчисленні використовувати кореляційні матриці. В іншому випадку виникає проблема "ваг" різних параметрів, що призводить до необхідності застосування при обчисленні коваріаційних матриць. Звідси може з'явитися додаткова проблема повторюваності результатів факторного аналізу при зміні кількості ознак. Слід зазначити, що зазначена проблема просто вирішується в пакеті Statistica шляхом переходу до стандартизованої формі представлення параметрів. При цьому всі параметри стають рівнозначними за ступенем їх зв'язку з процесами в об'єкті дослідження.

Якщо в наборі вихідних даних є надлишкові змінні і не проведено їх виключення кореляційним аналізом, то не можна обчислити обернену матрицю (8.3). Наприклад, якщо змінна є сумою двох інших змінних, відібраних для цього аналізу, то кореляційна матриця для такого набору змінних не може бути звернена, і факторний аналіз принципово не може бути виконаний. На практиці це відбувається, коли намагаються застосувати факторний аналіз до безлічі сильно залежних змінних, що іноді трапляється, наприклад, в обробці анкет. Тоді можна штучно знизити всі кореляції в матриці шляхом додавання малої константи до діагональним елементам матриці, і потім стандартизувати її. Ця процедура зазвичай призводить до матриці, яка може бути звернена, і тому до неї можна застосувати факторний аналіз. Більш того, ця процедура не впливає на набір факторів, але оцінки виявляються менш точними.

Факторний і регресійні моделювання систем зі змінними станамиСистемою зі змінними станами (СПС) називається система, відгук якої залежить не тільки від вхідного впливу, а й від узагальненого постійного в часі параметра, що визначає стан. Регульований підсилювач або аттенюатор? це приклад найпростішої СПС, в якому коефіцієнт передачі може дискретно або плавно змінюватися по якому-небудь закону. Дослідження СПС зазвичай проводиться для лінеаризованих моделей, в яких перехідний процес, пов'язаний зі зміною параметра стану, вважається завершеним.

Атенюатори, виконані на основі Г-, Т- і П-подібного з'єднання послідовно і паралельно включених діодів набули найбільшого поширення. Опір діодів під впливом керуючого струму може змінюватися в широких межах, що дозволяє змінювати АЧХ і загасання в тракті. Незалежність фазового зсуву при регулюванні загасання в таких аттенюатором досягається за допомогою реактивних ланцюгів, включених в базову структуру. Очевидно, що при різному співвідношенні опорів паралельних і послідовних діодів може бути отриманий один і той же рівень внесеного ослаблення. Але зміна фазового зсуву буде різним.

Досліджуємо можливість спрощення автоматизованого проектування аттенюаторов, що виключає подвійну оптимізацію коригувальних ланцюгів і параметрів керованих елементів. Як досліджуваної СПС будемо використовувати електрично керований атенюатор, схема заміщення якого наведена на рис. 8.8. Мінімальний рівень загасання забезпечується в разі малого опору елемента Rs і великого опору елемента Rp. У міру збільшення опору елемента Rs і зменшення опору елемента Rp внесене ослаблення збільшується.

Залежності зміни фазового зсуву від частоти і загасання для схеми без корекції і з корекцією наведені на рис. 8.9 і 8.10 відповідно. У коригувати аттенюатор в діапазоні послаблень 1,3-7,7 дБ і смузі частот 0,01? 4,0 ГГц досягнуто зміна фазового зсуву не більше 0,2 °. У аттенюатор без корекції зміна фазового зсуву в тій же смузі частот і діапазоні послаблень досягає 3 °. Таким чином, фазовий зсув зменшений за рахунок корекції майже в 15 разів.

Будемо вважати параметри корекції і управління незалежними змінними або чинниками, що впливають на загасання і зміна фазового зсуву. Це дає можливість за допомогою системи Statistica провести факторний і регресійний аналіз СПС з метою встановлення фізичних закономірностей між параметрами ланцюга і окремими характеристиками, а також спрощення пошуку оптимальних параметрів схеми.

Вихідні дані формувалися в такий спосіб. Для параметрів корекції та опорів управління, що відрізняються від оптимальних у велику і меншу сторони на сітці частот 0,01? 4 ГГц, були обчислені внесене ослаблення і зміна фазового зсуву.

Методи статистичного моделювання, зокрема, факторний і регресійний аналіз, які раніше не використовувалися для проектування дискретних пристроїв зі змінними станами, дозволяють виявити фізичні закономірності роботи елементів системи. Це сприяє створенню структури пристрою виходячи із заданого критерію оптимальності. Зокрема, в даному розділі розглядалося фазоінваріантний атенюатор як типовий приклад системи зі змінними станами. Виявлення та інтерпретація факторних навантажень, що впливають на різні досліджувані характеристики, дозволяє змінити традиційну методологію і істотно спростити пошук параметрів корекції і параметрів регулювання.

Встановлено, що використання статистичного підходу до проектування подібних пристроїв виправдано як для оцінки фізики їх роботи, так і для обгрунтування принципових схем. Статистичне моделювання дозволяє істотно скоротити обсяг експериментальних досліджень.

результати

- Спостереження за загальними факторами і відповідними факторними навантаженнями - це необхідна виявлення внутрішніх закономірностей процесів.

- З метою визначення критичних значень контрольованих відстаней між факторними навантаженнями слід накопичувати і узагальнювати результати факторного аналізу для однотипних процесів.

- Застосування факторного аналізу не обмежена фізичними особливостями процесів. Факторний аналіз є як потужним методом моніторингу процесів, так і застосуємо до проектування систем самого різного призначення.

Факультет бізнес-інформатики та управління

комплексними системами

Кафедра економіки та менеджменту

в промисловості (№ 71)

Математичні і інструментальні методи обробки

статистичної інформації

Кірєєв В.С.,

к.т.н., доцент

Email:

Москва 2017

1

нормалізація

десяткове масштабуваннямінімаксна нормалізація

Нормалізація за допомогою стандартного перетворення

Нормалізація за допомогою поелементний перетворень

2

десяткове масштабування

Vi"

Vi k, max (Vi) 1

10

"

3

мінімаксна нормалізація

ViVi min (Vi)

"

i

max (Vi) min (Vi)

i

i

4

Нормалізація за допомогою стандартного відхилення

Vi"

V

V

Vi V

V

- вибіркове

середнє

- вибіркове середньоквадратичне

відхилення

5

Нормалізація за допомогою поелементний перетворень

Vi f Vi"

Vi 1

"

log Vi

, Vi log Vi

"

Vi exp Vi

"

Vi Vi, Vi 1 y

Vi

"

y

"

6

Факторний аналіз

(ФА) являє собою сукупність методів, які наоснові реально існуючих зв'язків аналізованих ознак, зв'язків самих

спостережуваних об'єктів, дозволяють виявляти приховані (неявні, латентні)

узагальнюючі характеристики організаційної структури та механізму розвитку

досліджуваних явищ, процесів.

Методи факторного аналізу в дослідницькій практиці застосовуються головним

чином з метою стиснення інформації, отримання невеликого числа узагальнюючих

ознак, що пояснюють варіативність (дисперсію) елементарних ознак (Rтехніка факторного аналізу) або варіативність спостережуваних об'єктів (Q-техніка

факторного аналізу).

Алгоритми факторного аналізу грунтуються на використанні скороченої

матриці парних кореляцій (ковариаций). Скорочена матриця - це матриця, на

головній діагоналі якої розташовані не одиниці (оцінки) повної кореляції або

оцінки повної дисперсії, а їх скорочені, кілька зменшені величини. при

цьому постулюється, що в результаті аналізу буде пояснена не вся дисперсія

досліджуваних ознак (об'єктів), а її деяка частина, зазвичай велика. Частина, що залишилася

непояснена частина дисперсії - це характерність, що виникає через специфічність

спостережуваних об'єктів, або помилок, що допускаються при реєстрації явищ, процесів,

тобто ненадійності вступних даних.

7

Класифікація методів ФА

8Метод головних компонент

(МГК) застосовується для зниження розмірностіпростору спостережуваних векторів, не приводячи до істотної втрати

інформативності. Передумовою МГК є нормальний закон розподілу

багатовимірних векторів. У МГК лінійні комбінації випадкових величин визначаються

характеристичними

векторами

ковариационной

матриці.

Головні

компоненти являють собою ортогональную систему координат, в якій дисперсії

компонент характеризують їх статистичні властивості. МГК не відносять до ФА, хоча він має

схожий алгоритм і вирішує схожі аналітичні завдання. Його головна відмінність

полягає в тому, що обробці підлягає не скорочена, а звичайна матриця

парних кореляцій, ковариаций, на головній діагоналі якої розташовані одиниці.

Нехай дано вихідний набір векторів X лінійного простору Lk. застосування

методу головних компонент дозволяє перейти до базису простору Lm (m≤k), такому

що: перша компонента (перший вектор базису) відповідає напрямку, уздовж

якого дисперсія векторів вихідного набору максимальна. напрямок другий

компоненти (другого вектора базису) вибрано таким чином, щоб дисперсія вихідних

векторів уздовж нього була максимальною за умови ортогональності першого вектору

базису. Аналогічно визначаються інші вектори базису. В результаті, напрямки

векторів базису обрані так, щоб максимізувати дисперсію вихідного набору

вздовж перших компонентів, які називаються головними компонентами (або головними

осями) .Получается, що основна мінливість векторів вихідного набору векторів

представлена \u200b\u200bкількома першими компонентами, і з'являється можливість, відкинувши

менш істотні компоненти, перейти до простору меншої розмірності.

9

10. Метод головних компонент. схема

1011. Метод головних компонент. матриця рахунків

Матриця рахунків T дає нам проекції вихідних зразків (J -мірнихвекторів

x1, ..., xI)

на

підпростір

головних

компонент

(A-мірне).

Рядки t1, ..., tI матриці T - це координати зразків в новій системі координат.

Стовпці t1, ..., tA матриці T - ортогональні і представляють проекції всіх зразків на

одну нову координатну вісь.

При дослідженні даних методом PCA, особлива увага приділяється графіками

рахунків. Вони несуть в собі інформацію, корисну для розуміння того, як влаштовані

дані. На графіку рахунків кожен зразок зображується в координатах (ti, tj), найчастіше

- (t1, t2), що позначаються PC1 і PC2. Близькість двох точок означає їх схожість, тобто

позитивну кореляцію. Точки, розташовані під прямим кутом, є

некоррелірованні, а розташовані діаметрально протилежно - мають

негативну кореляцію.

11

12. Метод головних компонент. матриця навантажень

Матриця навантажень P - це матриця переходу з початкового просторузмінних x1, ... xJ (J-мірного) в простір головних компонент (A-мірне). кожна

рядок матриці P складається з коефіцієнтів, що пов'язують змінні t і x.

Наприклад, a-й рядок - це проекція всіх змінних x1, ... xJ на a-ю вісь головних

компонент. Кожен стовпець P - це проекція відповідної змінної xj на нову

систему координат.

Графік навантажень застосовується для дослідження ролі змінних. На цьому

графіку кожна змінна xj відображається точкою в координатах (pi, pj), наприклад

(P1, p2). Аналізуючи його аналогічно графіку рахунків, можна зрозуміти, які змінні

пов'язані, а які є незалежними. Спільне дослідження парних графіків рахунків і

навантажень, також може дати багато корисної інформації про дані.

12

13. Особливості методу головних компонент

В основі методу головних компонент лежать такі припущення:допущення про те, що розмірність даних може бути ефективно знижена

шляхом лінійного перетворення;

допущення про те, що найбільше інформації несуть ті напрямки, в яких

дисперсія вхідних даних максимальна.

Можна легко бачити, що ці умови далеко не завжди виконуються. наприклад,

якщо точки вхідного безлічі розташовуються на поверхні гіперсфери, то ніяке

лінійне перетворення не зможе знизити розмірність (але з цим легко впорається

нелінійне перетворення, що спирається на відстань від точки до центру сфери).

Це недолік в рівній мірі властивий всім лінійним алгоритмам і може бути

подолано за рахунок використання додаткових фіктивних змінних, що є

нелінійними функціями від елементів набору вхідних даних (т.зв. kernel trick).

Другий недолік методу головних компонент полягає в тому, що напрямки,

максимізує дисперсію, далеко не завжди максимізують інформативність.

Наприклад, змінна з максимальною дисперсією може не нести майже ніякої

інформації, в той час як змінна з мінімальною дисперсією дозволяє

повністю розділити класи. Метод головних компонент в даному випадку віддасть

перевагу першій (менше інформативною) змінної. Вся додаткова

інформація, пов'язана з вектором (наприклад, приналежність образу до одного з

класів), ігнорується.

13

14. Приклад даних для МГК

К. Есбенсен. Аналіз багатовимірних даних, скор. пер. з англ. підред. О. Родіонової, Вид-во ІПХФ РАН, 2005

14

15. Приклад даних для МГК. позначення

HeightЗріст: в сантиметрах

Weight

Вага: в кілограмах

Hair

Волосся: коротке: -1, або довгі:

+1

Shoes

Взуття: розмір за європейським

стандарту

Age

Вік: в роках

Income

Дохід: в тисячах євро в рік

Beer

Пиво: споживання в літрах на рік

Wine

Вино: споживання в літрах на рік

Sex

Стать: чоловіча: -1, або жіночий: +1

Strength

Сила: індекс, заснований на

перевірці фізичних здібностей

Region

Регіон: північ: -1, або південь: +1

IQ

Коефіцієнт інтелекту,

вимірюваний по стандартному тесту

15

16. Матриця рахунків

1617. Матриця навантажень

1718. Об'єкти вибірки в просторі нових компонент

Жінки (F) позначені кружками ● і ●, ачоловіки (M) - квадратами ■ і ■. Північ (N)

представлений блакитним ■, а південь (S) - червоним

кольором ●.

Розмір і колір символів відображає дохід - чим

більше і світліше, тим він більше. числа

представляють вік

18

19. Вихідні змінні в просторі нових компонент

1920. Графік «кам'янистої осипи» (scree plot)

2021. Метод головних чинників

У парадигмі методу головних факторів завдання зниження розмірності простору ознакпростору виглядає так, що n ознак можна пояснити за допомогою меншого

кількості m-латентних ознак - загальних факторів, де m<

враховують за допомогою так званих характерних факторів.

Кінцева мета статистичного дослідження, проведеного з залученням

апарату факторного аналізу, як правило, полягає у виявленні та інтерпретації

латентних загальних факторів з одночасним прагненням мінімізувати як їх

число, так і ступінь залежності від своїх специфічних залишкових випадкових

компонент.

кожна ознака

є результатом

впливу m гіпотетичних загальних і

одного характерного факторів:

X 1 a11 f1 a12 f 2 a1m f m d1V1

X a f a f a f d V

2

21 1

22 2

2m m

2

X n a n1 f1 a n 2 f 2 a nm f m d nVn

21

22. Обертання факторів

Обертання - це спосіб перетворення факторів, отриманих на попередньому етапі,в більш осмислені. Обертання ділиться на:

графічне (проведення осей, не застосовується при більш ніж двомірному

аналізі),

аналітичне (вибирається якийсь критерій обертання, розрізняють ортогональное і

косокутність) і

матрично-наближене (обертання полягає в наближенні до якоїсь заданої

цільової матриці).

Результатом обертання є вторинна структура факторів. первинна

факторная структура (що складається з первинних навантажень (отриманих на попередньому

етапі) - це, фактично, проекції точок на ортогональні осі координат. Очевидно, що

якщо проекції будуть нульовими, то структура буде простіше. А проекції будуть нульовими,

якщо точка лежить на якійсь осі. Таким чином, можна вважати обертання переходом від

однієї системи координат до іншої при відомих координатах в одній системі (

первинні фактори) і итеративно підбираються координатах в іншій системі

(Вторинні фактори). При отриманні вторинної структури прагнуть перейти до такої

системі координат, щоб провести через точки (об'єкти) якомога більше осей, щоб

якомога більше проекції (і відповідно навантажень) були нульовими. При цьому можуть

зніматися обмеження ортогональности і убування значущості від першого до останнього

факторів, характерні для первинної структури.

22

23. Ортогональное обертання

має на увазі, що ми будемо обертати фактори, але небудемо порушувати їх ортогональності один одному. ортогональное обертання

має на увазі множення вихідної матриці первинних навантажень на ортогональну

матрицю R (таку матрицю, що

V \u003d BR

Алгоритм ортогонального обертання в загальному випадку такий:

0. B - матриця первинних факторів.

1.

шукаємо

ортогональную

матрицю

RT

розміру

2*2

для

двох

стовпців (факторів) bi і bj матриці B таку, що критерій для матриці

R максимальний.

2.

Замінюємо стовпці bi і bj на стовпці

3.

Перевіряємо, чи всі стовпці перебрали. Якщо немає, то перехід на 1.

4.

Перевіряємо, що критерій для всієї матриці виріс. Якщо так, то перехід на 1. Якщо

немає, то кінець алгоритму.

.

23

24. Варімаксное обертання

Цей критерій використовує формалізаціюдисперсію квадратів навантажень змінної:

складності

фактор А

через

Тоді критерій в загальному вигляді можна записати як:

При цьому, факторні навантаження можуть нормуватись для позбавлення від

впливу окремих змінних.

24

25. Квартімаксное обертання

Формалізуємо поняття факторной складності q i-ой змінної черездисперсію квадратів факторних навантажень чинників:

де r - число стовпців факторной матриці, bij - факторна навантаження j-го

фактора на i-ю змінну, - середнє значення. Критерій квартімакс намагається

максимізувати складність всієї сукупності змінних, щоб досягти

легкості інтерпретації чинників (прагне полегшити опис стовпців):

Враховуючи що

- константа (сума власних чисел матриці

ковариации) і розкривши середнє значення (а також врахувавши, що статечна функція

росте пропорційно аргументу), отримаємо остаточний вид критерію для

максимізації:

25

26. Критерії визначення числа факторів

Головною проблемою факторного аналізу є виділення та інтерпретаціяголовних чинників. При відборі компонент дослідник зазвичай стикається з

істотними труднощами, так як не існує однозначної критерію виділення

факторів, і тому тут неминучий суб'єктивізм інтерпретацій результатів.

Існує кілька часто вживаних критеріїв визначення числа факторів.

Деякі з них є альтернативними по відношенню до інших, а частина цих

критеріїв можна використовувати разом, щоб один доповнював інший:

Критерій Кайзера або критерій власних чисел. Цей критерій запропонований

Кайзером, і є, ймовірно, найбільш широко використовуваним. відбираються тільки

фактори з власними значеннями рівними або більшими 1. Це означає, що якщо

фактор не виділяє дисперсію, еквівалентну, принаймні, дисперсії однієї

змінної, то він опускається.

Критерій кам'янистій осипи (англ. Scree) або критерій відсіювання. Він являється

графічним методом, вперше запропонованим психологом Кеттела. власні

значення можливо зобразити у вигляді простого графіка. Кеттел запропонував знайти таке

місце на графіку, де спадання власних значень зліва направо максимально

сповільнюється. Передбачається, що праворуч від цієї точки знаходиться тільки

«Факторіальна осип» - «осип» є геологічним терміном, що позначає

уламки гірських порід, які скупчуються в нижній частині скелястого схилу.

26

27. Критерії визначення числа факторів. продовження

Критерій значущості. Він особливо ефективний, коли модель генеральноїсукупності відома і відсутні другорядні фактори. Але критерій непридатний

для пошуку змін в моделі і реалізуємо тільки в факторному аналізі за методом

найменших квадратів або максимальної правдоподібності.

Критерій частки відтворюється дисперсії. Фактори ранжуються за часткою

детерминируемой дисперсії, коли відсоток дисперсії виявляється несуттєвим,

виділення слід зупинити. Бажано, щоб виділені чинники пояснювали

більше 80% розкиду. Недоліки критерію: по-перше, суб'єктивність виділення, по-друге, специфіка даних може бути така, що всі головні чинники не зможуть

сукупно пояснити бажаного відсотка розкиду. Тому головні чинники

повинні разом пояснювати не менше 50,1% дисперсії.

Критерій інтерпретується і інваріантності. Цей критерій поєднує

статистичну точність з суб'єктивними інтересами. Згідно з ним, головні чинники

можна виділяти до тих пір, поки буде можлива їх ясна інтерпретація. Вона, в свою

чергу, залежить від величини факторних навантажень, тобто якщо в факторі є хоча б

одна сильне навантаження, він може бути інтерпретований. Можливий і зворотний варіант -

якщо сильні навантаження є, однак інтерпретація скрутна, від цієї

компоненти переважно відмовитися.

27

28. Приклад використання МГК

нехайє

наступні

показники

економічної

діяльності

підприємства: трудомісткість (x1), питома вага покупних виробів в продукції (x2),

коефіцієнт змінності обладнання (x3), питома вага робітників у складі підприємства

(X4), премії і винагороди на одного працівника (x5), рентабельність (y). лінійна

регресійна модель має вигляд:

y \u003d b0 + b1 * x1 + b2 * x2 + b3 * x3 + b4 * x4 + b5 * x5

x1

x2

x3

x4

x5

y

0,51

0,2

1,47

0,72

0,67

9,8

0,36

0,64

1,27

0,7

0,98

13,2

0,23

0,42

1,51

0,66

1,16

17,3

0,26

0,27

1,46

0,69

0,54

7,1

0,27

0,37

1,27

0,71

1,23

11,5

0,29

0,38

1,43

0,73

0,78

12,1

0,01

0,35

1,5

0,65

1,16

15,2

0,02

0,42

1,35

0,82

2,44

31,3

0,18

0,32

1,41

0,8

1,06

11,6

0,25

0,33

1,47

0,83

2,13

30,1

28

29. Приклад використання МГК

Побудова регресійній моделі в статистичному пакеті показує,коефіцієнт X4 не означає (p-Value\u003e α \u003d 5%), і його можна виключити з моделі.

що

Після виключення X4 знову запускається процес побудови моделі.

29

30. Приклад використання МГК

Критерій Кайзера для МГК показує, що можна залишити 2 компоненти, що пояснюютьблизько 80% початкової дисперсії.

Для виділених компонент можна побудувати рівняння в вихідної системі координат:

U1 \u003d 0,41 * x1 - 0,57 * x2 + 0,49 * x3 - 0,52 * x5

U2 \u003d 0,61 * x1 + 0,38 * x2 - 0,53 * x3 - 0,44 * x5

30

31. Приклад використання МГК

Тепер можна побудувати в нових компонентах нову регресійну модель:y \u003d 15,92 - 3,74 * U1 - 3,87 * U2

31

32. Метод сингулярного розкладання (SVD)

Beltrami і Jordan вважаються засновниками теорії сингулярногорозкладання. Beltrami - за те, що він першим опублікував роботу про

сингулярному розкладанні, а Jordan - за елегантність і повноту своєї

роботи. Робота Beltrami з'явилася в журналі "Journal of Mathematics for

the Use of the Students of the Italian Universities "в 1873 році, основна

мета якої полягала в тому, щоб ознайомити студентів з

білінійну формамі.Суть методу в розкладанні матриці A розміру n

x m з рангом d \u003d rank (M)<= min(n,m) в произведение матриц меньшего

рангу:

A \u003d UDVT,

де матриці U розміру n x d і V розміру m x d складаються з

ортонормального стовпців, які є власними векторами при

ненульових власних значеннях матриць AAT і ATA відповідно і

UTU \u003d V TV \u003d I, а D розміру d x d - діагональна матриця з

позитивними діагональними елементами, відсортованими в

порядку убування. Стовпці матриці U є,

ортонормального базис простору стовпців матриці A, а стовпці

матриці V - ортонормального базис простору рядків матриці A.

32

33. Метод сингулярного розкладання (SVD)

Важливою властивістю SVD-розкладання є той факт, що якщодля k

залишити в матрицях U і V тільки k перших шпальт, то матриця

Ak \u003d UkDkVkT

буде кращою апроксимацією матриці A щодо

норми Фробениуса серед всіх матриць з рангом k.

Це усічення по-перше зменшує розмірність векторного

простору, знижує вимоги зберігання і обчислювальні

вимоги до моделі.

По-друге, відкидаючи малі сингулярні числа, малі

спотворення в результаті шуму в даних видаляються, залишаючи

тільки найсильніші ефекти і тенденції в цій моделі.

Наступний приклад заснований на вигаданих даних, що відносяться до вивчення задоволеності життям. Припустимо, що запитальник був направлений 100 випадково обраних дорослим. Запитальник містив 10 пунктів, призначених для визначення задоволеності на роботі, задоволеності своїм хобі, задоволеністю сімейним життям і загальної задоволеністю в інших сферах життя. Відповіді на питання були введені в комп'ютер і промасштабіровани таким чином, щоб середнє для всіх пунктів стало рівним приблизно 100.

Результати були поміщені в файл даних Factor.sta. Відкрити цей файл можна за допомогою опції Файл - Відкрити; найбільш ймовірно, що цей файл даних знаходиться в директорії / Examples / Datasets. Нижче наводиться роздруківка змінних цього файлу (для отримання списку виберіть Всі специфікації змінних в меню Дані).

мета аналізу . Метою аналізу є вивчення співвідношень між задоволеністю в різних сферах діяльності. Зокрема, бажано вивчити питання про кількість факторів, "які переховуються" за різними областями діяльності та їх значимість.

Вибір аналізу. Виберіть Аналіз в меню Аналіз - Багатомірний розвідувальний аналіз для відображення стартовою панелі модуля Аналіз. Натисніть на кнопку Змінні на стартовій панелі (див. Нижче) і виберіть всі 10 змінних в цьому файлі.

інші опції . Для виконання стандартного факторного аналізу в цьому діалоговому вікні є все необхідне. Для отримання короткого огляду інших команд, доступних з стартовою панелі, ви можете вибрати в якості вхідного файлу кореляційну матрицю (використовуючи поле Файл даних). В поле Видалення ПД ви можете вибрати порядкове або попарне виключення або підстановка середнього для пропущених даних.

Задайте метод виділення факторів. Натиснемо тепер кнопку OK для переходу до наступного діалогового вікна з назвою Задайте метод виділення факторів. За допомогою цього вікна діалогу ви зможете переглянути описові статистики, виконати множинний регресійний аналіз, вибрати метод виділення факторів, вибрати максимальне число факторів, мінімальні власні значення, а також інші дії, що відносяться до специфіки методів виділення факторів. А тепер перейдемо у вкладку Описові.

Перегляд описових статистик. Тепер натисніть на кнопку Переглянути кор. / Середні / ст.откл. в цьому вікні для того, щоб відкрити вікно Перегляд описових статистик.

Тепер ви можете розглянути описові статистики графічно або за допомогою таблиць результатів.

Обчислення кореляційної матриці. Натисніть на кнопку Кореляції у вкладці Додатково для того, щоб відобразити таблицю результатів з корреляциями.

Все кореляції в цій таблиці результатів позитивні, а деякі кореляції мають значну величину. Наприклад, змінні Hobby_1 і Miscel_1 коррелірованни на рівні 0.90. Деякі кореляції (наприклад, кореляції між задоволеністю на роботі і задоволеністю будинку) здаються порівняно малими. Це виглядає так, як ніби матриця має деяку чітку структуру.

Метод виділення. Тепер натиснемо кнопку Скасування в діалоговому вікні Перегляд описових статистик для того, щоб повернутися в діалогове вікно Задайте метод виділення факторів. Ви можете зробити вибір з кількох методів виділення у вкладці Додатково (див. Вкладку Додатково діалогового вікна Задайте метод виділення факторів для опису кожного методу, а також Вступний огляд з описом методу Головних компонент і методу Головних чинників). У цьому прикладі за замовчуванням приймається метод Головних компонент, поле Макс. число чинників містить значення 10 (максимальне число факторів в цьому прикладі) і поле Мін. собств. значення містить 0 (мінімальне значення для цієї команди).

Для продовження аналізу натисніть кнопку OK.

Перегляд результатів. Ви можете ознайомитись з результатами факторного аналізу в вікні діалогу Результати факторного аналізу. Спочатку виберіть вкладку пояснення дисперсія.

Відображення власних значень . Призначення власних значень і їх корисність для користувача при прийнятті рішення про те, скільки слід залишити факторів (інтерпретувати) були описані в Вступне огляді. Тепер натиснемо на кнопку Власні значення, щоб отримати таблицю з власними значеннями, відсотком загальної дисперсії, накопиченими власними значеннями і накопиченими відсотками.

Як видно з таблиці, власне значення для першого фактора одно 6.118369; тобто частка дисперсії, обумовлена \u200b\u200bпершим фактором дорівнює приблизно 61.2%. Зауважимо, що ці значення випадково опинилися тут легко порівнянними, так як аналізу піддаються 10 змінних, і тому сума всіх власних значень виявляється рівною 10. Другий фактор включає в себе близько 18% дисперсії. Інші фактори містять не більше 5%загальної дисперсії.Вибір числа факторів. У розділі Вступний огляд коротко описаний спосіб, як отримані власні значення можна використовувати для вирішення питання про те, скільки чинників слід залишити в моделі. Відповідно до критерію Кайзера (Kaiser, 1960), ви повинні залишити чинники з власними значеннями великими 1. З наведеної вище таблиці випливає, що критерій призводить до вибору двох факторів.

Критерій кам'янистій осипи . Тепер натисніть на кнопку Графік кам'янистій осипи, щоб отримати графік власних значень з метою застосування критерію осипи Кеттела (Cattell, 1966). Графік, представлений нижче, був доповнений відрізками, що з'єднують сусідні власні значення, щоб зробити критерій більш наочним. Кеттел (Cattell) стверджує, грунтуючись на методі Монте-Карло, що точка, де безперервне падіння власних значень сповільнюється і після якої рівень інших власних значень відображає тільки випадковий "шум". На графіку, наведеному нижче, ця точка може відповідати фактору 2 або 3 (як показано стрілками). Тому випробуйте обидва рішення і подивіться, яке з них дає більш адекватну картину.

Тепер розглянемо факторні навантаження.

факторні навантаження . Як було описано в розділі Вступний огляд, факторні навантаження можна інтерпретувати як кореляції між факторами і змінними. Тому вони представляють найбільш важливу інформацію, на якій грунтується інтерпретація факторів. Спочатку подивимося на (неповернутие) факторні навантаження для всіх десяти факторів. У вкладці Навантаження діалогового вікна Результати факторного аналізу в поле Обертання факторів задамо значення без обертання і натиснемо на кнопку Факторні навантаження для відображення таблиці навантажень.

Згадаймо, що виділення факторів відбувалося таким чином, що наступні фактори включали в себе все меншу і меншу дисперсію (див. Розділ Вступний огляд). Тому не дивно, що перший фактор має найвищу навантаження. Відзначимо, що знаки факторних навантажень мають значення лише для того, щоб показати, що змінні з протилежними навантаженнями на один і той же фактор взаємодіють з цим фактором протилежним чином. Однак ви можете помножити все навантаження в стовпці на -1 і звернути знаки. У всьому іншому результати виявляться незмінними.

Обертання факторного рішення. Як описано в розділі Вступний огляд, дійсна орієнтація факторів в факторному просторі довільна, і всяке обертання факторів відтворює кореляції так само добре, як і інші обертання. Отже, здається природним повернути фактори таким чином, щоб вибрати найпростішу для інтерпретації факторну структуру. Фактично, термін проста структура був придуманий і визначено Терстоуном (Thurstone, 1947) головним чином для опису умов, коли фактори відзначені високими навантаженнями на деякі змінні і низькими - для інших, а також коли є кілька великих перехресних навантажень, тобто є кілька змінних з істотними навантаженнями на більш ніж один фактор. Найбільш стандартними обчислювальними методами обертання для отримання простої структури є метод обертання варимакс, запропонований Кайзером (Kaiser, 1958). Іншими методами, запропонованими Харманом (Harman, 1967), є методи квартімакс, біквартімакс і еквімакс (див. Harman, 1967).

вибір обертання . Спочатку розглянемо кількість чинників, яке ви бажаєте залишити для обертання і інтерпретації. Раніше було вирішено, що найбільш правдоподібним і прийнятним числом факторів є два, однак на основі критерію осипи було вирішено враховувати також і рішення з трьома факторами. Натисніть на кнопку Скасування для того, щоб повернутися у вікно діалогу Задайте метод виділення факторів, і змініть поле Максимальне число факторів у вкладці Швидкий з 10 на 3, потім натисніть кнопку OK для того, щоб продовжити аналіз.

Тепер виконаємо обертання за методом варимакс. У вкладці Навантаження діалогового вікна Результати факторного аналізу в поле Обертання факторів встановіть значення варімакс вихідних.

Натиснемо кнопку Факторні навантаження для відображення в таблиці результатів одержуваних факторних навантажень.

Відображення рішення при обертанні трьох чинників. У таблиці наведено суттєві навантаження на перший фактор для всіх змінних, крім включених до дому. Фактор 2 має досить значні навантаження для всіх змінних, крім змінних пов'язаних з задоволеністю на роботі. Фактор 3 має тільки одну значне навантаження для змінної Home_1. Той факт, що на третій фактор надає високе навантаження тільки одна змінна, наводить на думку, а чи не може вийти такий же хороший результат без третього фактора?

Огляд рішення при обертанні двох факторів . Знову натисніть на кнопку Скасування в вікні діалогу Результати факторного аналізу для того, щоб повернутися до діалогового вікна Задайте метод виділення факторів. Змініть поле Максимальне число факторів у вкладці Швидкий з 3 до 2 і натисніть кнопку OK для того, щоб перейти в діалогове вікно Результати факторного аналізу. У вкладці Навантаження в поле Обертання факторів встановіть значення варімакс вихідних і натисніть кнопку Факторні навантаження.

Фактор 1, як видно з таблиці, має найвищі навантаження для змінних, що відносяться до задоволеності роботою. Найменші навантаження він має для змінних, що відносяться до задоволеності будинком. Інші навантаження приймають проміжні значення. Фактор 2 має найвищі навантаження для змінних, пов'язаних з задоволеністю будинку, нижчі навантаження - для задоволеності на роботі середні навантаження для інших змінних.

Інтерпретація рішення для двухфакторного обертання . Чи можна інтерпретувати цю модель? Все виглядає так, як ніби два фактора найкраще ідентифікувати як фактор задоволення роботою (фактор 1) і як фактор задоволення сімейним життям (фактор 2). Задоволення своїм хобі і різними іншими аспектами життя здається відносяться до обох факторів. Ця модель передбачає в деякому сенсі, що задоволеність роботою і сімейним життям згідно з цією вибіркою можуть бути незалежними один від одного, але обидва дають внесок в задоволення хобі та іншими сторонами життя.

Діаграма рішення, заснованого на обертанні двох факторів . Для отримання діаграми розсіювання двох факторів натисніть на кнопку 2М графік навантажень у вкладці Навантаження діалогового вікна Результати факторного аналізу. Діаграма, показана нижче, просто показує дві навантаження для кожної змінної. Зауважимо, що діаграма розсіювання добре ілюструє два незалежні фактори і 4 змінних (Hobby_1, Hobby_2, Miscel_1, Miscel_2) з перехресними навантаженнями.

Тепер подивимося, наскільки добре може бути відтворена спостерігається ковариационная матриця по двухфакторную рішенням.

Відтворена і залишкова кореляційна матриця. Натисніть на кнопку Відтворені і залишкові кореляції у вкладці пояснення дисперсія, для того щоб отримати дві таблиці з відтвореною кореляційної матрицею і матрицею залишкових кореляцій (спостережуваних мінус відтворених кореляцій).

Входи в таблиці Залишкових кореляцій можуть бути інтерпретовані як "сума" кореляцій, за які не можуть відповідати два отриманих фактора. Звичайно, діагональні елементи матриці містять стандартне відхилення, за яке не можуть бути відповідальні ці фактори і які дорівнюють квадратному кореню з одиниця мінус відповідні спільності для двох факторів (згадаємо, що спільністю змінної є дисперсія, яка може бути пояснена обраним числом факторів). Якщо ви ретельно розглянете цю матрицю, то зможете побачити, що тут фактично немає остаточних кореляцій, великих 0.1 або менші -0.1 (в дійсності тільки мала кількість з них близько до цієї величини). Додамо до цього, що перші два фактори включають близько 79% загальної дисперсії (див. Накопичений% власних значень в таблиці результатів).

"Секрет" вдалий приклад . Приклад, який ви тільки що вивчили, насправді дає рішення двухфакторной завдання, близьке до ідеального. Воно визначає більшу частину дисперсії, має розумну інтерпретацію і відтворює кореляційну матрицю з помірними відхиленнями (залишковими корреляциями). Насправді реальні дані рідко дозволяють отримати таке просте рішення, і в дійсності це фіктивне безліч даних було отримано за допомогою генератора випадкових чисел з нормальним розподілом, доступного в системі. Спеціальним чином в дані були "введені" два ортогональних (незалежних) фактора, за якими були згенеровані кореляції між змінними. Цей приклад факторного аналізу відтворює два фактора такими, як вони і були, (тобто фактор задоволеності роботою і фактор задоволеності сімейним життям). Таким чином, якби явище (а не штучні, як в прикладі, дані) містило ці два фактори, то ви, виділивши їх, могли б дещо дізнатися про прихованою або латентною структурі явища.

інші результати . Перш, ніж зробити остаточний висновок, дамо короткі коментарі до інших результатів.

спільності . Для отримання спільнот рішення натисніть на кнопку Спільності у вкладці пояснення дисперсія діалогового вікна Результати факторного аналізу. Згадаймо, що спільність змінної - це частка дисперсії, яка може бути відтворена при заданому числі факторів. Обертання факторного простору не впливає на величину спільності. Дуже низькі спільності для однієї або двох змінних (з багатьох в аналізі) можуть вказувати на те, що ці змінні не дуже добре пояснені моделлю.

Коефіцієнти значень. Коефіцієнти факторів можуть бути використані для обчислення значень факторів для кожного спостереження. Самі коефіцієнти представляє зазвичай малий інтерес, проте факторні значення корисні при проведенні подальшого аналізу. Для відображення коефіцієнтів натисніть кнопку Коефіцієнти значень факторів у вкладці Значення діалогового вікна Результати факторного аналізу.

Значення факторів. Факторні значення можуть розглядатися як поточні значення для кожного опитуваного респондента (тобто для кожного спостереження вихідної таблиці даних). Кнопка Значення факторів у вкладці Значення діалогового вікна Результати факторного аналізу дозволяє обчислити факторні значення. Ці значення можна зберегти для подальшого натисканням кнопки Зберегти значення.