Configuration requise pour g-sync hdr. Comment activer la prise en charge de NVIDIA G-SYNC et libérer tout son potentiel La synchronisation g ne fonctionne pas dans les jeux

Aperçu de la technologie G-Sync | Histoire courte taux de rafraîchissement fixe

Il y a longtemps, les moniteurs étaient encombrants et contenaient des tubes à rayons cathodiques et des canons à électrons. Des canons à électrons bombardent l'écran de photons pour illuminer des points de phosphore colorés, que nous appelons pixels. Ils dessinent de gauche à droite chaque ligne de balayage de haut en bas. Ajuster la vitesse d'un canon à électrons d'une mise à niveau complète à l'autre n'était pas très pratique auparavant, et cela n'était pas particulièrement nécessaire avant l'avènement des jeux 3D. Par conséquent, les tubes cathodiques et les normes vidéo analogiques associées ont été développés avec un taux de rafraîchissement fixe.

Les moniteurs LCD ont progressivement remplacé les tubes cathodiques et les connecteurs numériques (DVI, HDMI et DisplayPort) ont remplacé l'analogique (VGA). Mais les associations de normalisation vidéo (menées par VESA) ne sont pas passées d'un taux de rafraîchissement fixe. Les films et les téléviseurs reposent toujours sur des entrées à fréquence d'images constante. Encore une fois, passer à un taux de rafraîchissement variable ne semble pas nécessaire.

Les fréquences d'images réglables et les fréquences de rafraîchissement fixes ne correspondent pas

Avant l'avènement des graphiques 3D modernes, les taux de rafraîchissement fixes n'étaient pas un problème pour les écrans. Mais cela est apparu lorsque nous avons rencontré pour la première fois des GPU puissants : la fréquence à laquelle le GPU a rendu des images individuelles (ce que nous appelons la fréquence d'images, généralement exprimée en FPS ou images par seconde) n'est pas constante. Il change avec le temps. Dans les scènes graphiques lourdes, la carte peut fournir 30 FPS, et en regardant un ciel vide - 60 FPS.

La désactivation de la synchronisation entraîne des pauses

Il s'avère que la fréquence d'images variable du GPU et la fréquence de rafraîchissement fixe de l'écran LCD ne fonctionnent pas très bien ensemble. Dans cette configuration, nous rencontrons un artefact graphique appelé déchirement. Il apparaît lorsque deux images incomplètes ou plus sont rendues ensemble pendant le même cycle de rafraîchissement du moniteur. Ils se déplacent généralement, ce qui donne un effet très désagréable pendant la conduite.

L'image ci-dessus montre deux artefacts bien connus qui sont courants mais difficiles à capturer. Étant donné qu'il s'agit d'artefacts d'affichage, vous ne le verrez pas dans les captures d'écran de jeu classiques, mais nos clichés montrent ce que vous voyez réellement en jouant. Pour les photographier, vous avez besoin d'un appareil photo avec un mode de prise de vue à grande vitesse. Ou si vous avez une carte avec prise en charge de la capture vidéo, vous pouvez enregistrer un flux vidéo non compressé à partir du port DVI et voir clairement la transition d'une image à l'autre ; c'est la méthode que nous utilisons pour les tests FCAT. Cependant, il est préférable d'observer l'effet décrit de vos propres yeux.

L'effet de déchirure est visible dans les deux images. Celui du haut est fait avec une caméra, celui du bas est fait avec une fonction de capture vidéo. L'image du bas est "coupée" horizontalement et semble déplacée. Dans les deux images du haut, la gauche est sur un écran Sharp 60 Hz et la droite sur un écran Asus 120 Hz. L'écart sur l'écran 120 Hz n'est pas aussi prononcé car le taux de rafraîchissement est deux fois plus élevé. Cependant, l'effet est visible et apparaît de la même manière que dans l'image de gauche. Un artefact de ce type indique clairement que les images ont été prises avec la synchronisation V désactivée.

Battlefield 4 sur GeForce GTX 770 avec synchronisation V désactivée

Le deuxième effet observé dans BioShock: Infinite images est appelé ghosting. Elle est surtout visible en bas de l'image de gauche et est liée au délai de rafraîchissement de l'écran. En bref, les pixels individuels ne changent pas de couleur assez rapidement, ce qui conduit à ce type de lueur. Un seul coup ne peut pas transmettre l'effet des images fantômes sur le jeu lui-même. Un panneau avec des temps de réponse gris à gris de 8 ms comme Sharp se traduira par une image floue avec n'importe quel mouvement sur l'écran. C'est pourquoi ces écrans ne sont généralement pas recommandés pour les tireurs à la première personne.

V-sync: "gaspillé de savon"

La synchronisation verticale, ou V-sync, est une solution très ancienne au problème de déchirure. Lorsque cette fonction est activée, la carte vidéo essaie de correspondre au taux de rafraîchissement de l'écran en supprimant complètement les déchirures. Le problème est que si votre carte vidéo est incapable de maintenir la fréquence d'images au-dessus de 60 FPS (sur un écran avec une fréquence de rafraîchissement de 60 Hz), la fréquence d'images effective sautera entre des multiples de la fréquence de rafraîchissement de l'écran (60, 30, 20 , 15 FPS, etc.), ce qui entraînera à son tour des ralentissements notables.

Lorsque la fréquence d'images tombe en dessous du taux de rafraîchissement alors que la synchronisation V est active, vous ressentirez un bégaiement

De plus, comme la synchronisation verticale force la carte graphique à attendre et s'appuie parfois sur le tampon de surface caché, la synchronisation V peut ajouter une latence d'entrée supplémentaire à la chaîne de rendu. Ainsi, la synchronisation V peut être à la fois un salut et une malédiction, résolvant certains problèmes, mais provoquant en même temps d'autres inconvénients. Une enquête informelle auprès de notre personnel a révélé que les joueurs ont tendance à désactiver la synchronisation verticale et à ne l'activer que lorsque les larmes deviennent insupportables.

Soyez créatif : Nvidia dévoile G-Sync

Lors du démarrage d'une nouvelle carte vidéo GeForce GTX680 Nvidia a activé un mode de pilote appelé Adaptive V-sync (synchronisation verticale adaptative), qui tente d'atténuer les problèmes lorsque la synchronisation V est activée lorsque la fréquence d'images est supérieure à la fréquence de rafraîchissement du moniteur, et le désactive rapidement en cas de chute spectaculaire dans des performances inférieures au taux de rafraîchissement. Bien que la technologie remplisse sa fonction de bonne foi, il ne s'agissait que d'une solution de contournement pour éviter les déchirures lorsque la fréquence d'images était inférieure à la fréquence de rafraîchissement du moniteur.

Mise en œuvre G-Sync beaucoup plus intéressant. De manière générale, Nvidia montre qu'au lieu de forcer les cartes graphiques à fonctionner à une fréquence d'affichage fixe, nous pouvons faire fonctionner les nouveaux moniteurs à une fréquence incohérente.

La fréquence d'images du GPU détermine la fréquence de rafraîchissement du moniteur, en supprimant les artefacts associés à l'activation et à la désactivation de la synchronisation V

Le mécanisme de transmission en rafale DisplayPort a ouvert de nouvelles possibilités. En utilisant des intervalles de suppression variables dans le signal vidéo DisplayPort et en remplaçant le scaler du moniteur par un module de suppression variable, le panneau LCD peut fonctionner à une fréquence de rafraîchissement variable liée à la fréquence d'images émise par la carte graphique (dans les limites de la fréquence de rafraîchissement du moniteur). En pratique, Nvidia a fait preuve de créativité avec les fonctionnalités spéciales de l'interface DisplayPort et a essayé de faire d'une pierre deux coups.

Avant de commencer les tests, je tiens à remercier l'approche créative pour résoudre un problème réel affectant les jeux PC. C'est l'innovation à son meilleur. Mais quels sont les résultats G-Sync sur la pratique ? Découvrons-le.

Nvidia nous a envoyé un échantillon technique du moniteur Asus VG248QE, dans lequel le détartreur est remplacé par un module G-Sync... Nous connaissons déjà cet affichage. L'article lui est dédié "Asus VG248QE Review: moniteur de jeu 24" 144 Hz pour 400 $ ", dans lequel le moniteur a remporté le prix Tom's Hardware Smart Buy. Il est maintenant temps de voir comment la nouvelle technologie de Nvidia aura un impact sur les jeux les plus populaires.

Aperçu de la technologie G-Sync | LightBoost 3D, mémoire embarquée, normes et 4K

En parcourant les supports de presse de Nvidia, nous nous sommes posé de nombreuses questions, à la fois sur la place de la technologie dans le présent et son rôle dans le futur. Lors d'un récent voyage au siège de la société à Santa Clara, nos confrères américains ont reçu quelques réponses.

G-Sync et LightBoost 3D

La première chose que nous avons remarquée, c'est que Nvidia a envoyé un moniteur Asus VG248QE modifié pour prendre en charge G-Sync... Ce moniteur prend également en charge Technologie Nvidia 3D LightBoost, qui a été conçu à l'origine pour égayer les écrans 3D, mais a longtemps été utilisé officieusement en mode 2D, en utilisant un rétroéclairage de panneau pulsé pour réduire les images fantômes (ou le flou de mouvement). Naturellement, il est devenu intéressant si cette technologie est utilisée dans G-Sync.

Nvidia a répondu par la négative. Alors que les deux technologies seraient idéales en même temps, le rétroéclairage stroboscopique à des taux de rafraîchissement variables provoque aujourd'hui des problèmes de scintillement et de luminosité. Les résoudre est incroyablement difficile, car vous devez ajuster la luminosité et suivre les impulsions. En conséquence, il doit désormais choisir entre les deux technologies, même si l'entreprise essaie de trouver un moyen de les utiliser simultanément à l'avenir.

Mémoire intégrée du module G-Sync

Comme on le sait déjà G-Syncélimine le décalage d'entrée incrémentiel associé à la synchronisation V car il n'est plus nécessaire d'attendre la fin du balayage du panneau. Cependant, nous avons remarqué que le module G-Sync a une mémoire intégrée. Le module peut-il tamponner les trames tout seul ? Si oui, combien de temps faut-il à une trame pour traverser le nouveau canal ?

Selon Nvidia, les trames ne sont pas mises en mémoire tampon dans la mémoire du module. Au fur et à mesure que les données sont reçues, elles s'affichent à l'écran et la mémoire exécute d'autres fonctions. Cependant, le délai de traitement des G-Sync sensiblement moins d'une milliseconde. En fait, on rencontre quasiment le même délai lorsque V-sync est désactivé, et il est associé aux particularités du jeu, du pilote vidéo, de la souris, etc.

G-Sync sera-t-il standardisé ?

Cette question a été posée dans une récente interview avec AMD, lorsque le lecteur voulait connaître la réaction de l'entreprise à la technologie. G-Sync... Cependant, nous voulions demander cela directement au développeur et savoir si Nvidia prévoyait d'amener la technologie au standard de l'industrie. En théorie, une entreprise peut offrir G-Sync en tant que mise à niveau vers la norme DisplayPort, qui fournit des taux de rafraîchissement variables. Après tout, Nvidia est membre de l'association VESA.

Cependant, aucune nouvelle spécification n'est prévue pour DisplayPort, HDMI ou DVI. G-Sync et il prend donc en charge DisplayPort 1.2, c'est-à-dire que la norme n'a pas besoin d'être modifiée.

Comme indiqué, Nvidia travaille sur la compatibilité G-Sync avec une technologie désormais appelée 3D LightBoost (mais qui aura bientôt un autre nom). De plus, l'entreprise cherche un moyen de réduire le coût des modules. G-Sync et les rendre plus accessibles.

G-Sync aux résolutions Ultra HD

Nvidia promet un support pour les moniteurs G-Sync et des résolutions jusqu'à 3840x2160 pixels. Cependant, le modèle d'Asus, que nous allons tester aujourd'hui, ne supporte que 1920x1080 pixels. Au ce moment Les moniteurs Ultra HD utilisent le contrôleur STMicro Athena, qui dispose de deux dispositifs de mise à l'échelle pour créer un affichage en mosaïque. Nous nous demandons si le module G-Sync prendre en charge la configuration MST ?

En vérité, les écrans 4K VFR devront attendre. Il n'y a pas encore d'upscaler 4K autonome, le plus proche est attendu au premier trimestre 2014, et les moniteurs n'en sont équipés qu'au deuxième trimestre. Depuis le module G-Sync remplace le dispositif de zoom, les panneaux compatibles commenceront à apparaître après ce point. Heureusement, le module supporte nativement l'Ultra HD.

Que se passe-t-il jusqu'à 30 Hz ?

G-Sync peut modifier le taux de rafraîchissement de l'écran jusqu'à 30 Hz. Cela s'explique par le fait qu'à très basses fréquences Au fur et à mesure que l'écran se rafraîchit, l'image sur l'écran LCD commence à se détériorer, ce qui entraîne des artefacts visuels. Si la source fournit moins de 30 FPS, le module mettra à jour le panneau automatiquement, évitant problèmes possibles... Cela signifie qu'une image peut être lue plusieurs fois, mais le seuil inférieur est de 30 Hz, ce qui fournira une image de la plus haute qualité.

Aperçu de la technologie G-Sync | Panneaux 60 Hz, SLI, Surround et disponibilité

La technologie est-elle limitée aux seuls panneaux à taux de rafraîchissement élevé ?

Vous remarquerez que le premier moniteur avec G-Sync a initialement un taux de rafraîchissement très élevé (au-dessus du niveau requis pour la technologie) et une résolution de 1920x1080 pixels. Mais l'écran Asus a ses propres limites, comme la dalle TN 6 bits. Nous sommes devenus curieux de l'introduction de la technologie G-Sync Est-il prévu uniquement pour les écrans avec un taux de rafraîchissement élevé, ou pourrons-nous le voir sur des moniteurs 60 Hz plus courants ? De plus, je souhaite avoir accès à 2560x1440 pixels dès que possible.

Nvidia a réitéré que la meilleure expérience de G-Sync peut être obtenu lorsque votre carte vidéo maintient la fréquence d'images dans la plage de 30 à 60 FPS. Ainsi, la technologie peut vraiment bénéficier des moniteurs et modules 60 Hz conventionnels G-Sync .

Mais pourquoi utiliser un moniteur 144 Hz alors ? Il semble que de nombreux fabricants de moniteurs aient décidé de mettre en œuvre une fonction de faible flou de mouvement (3D LightBoost), qui nécessite un taux de rafraîchissement élevé. Mais ceux qui ont décidé de ne pas utiliser cette fonction (et pourquoi pas, car elle n'est pas encore compatible avec G-Sync) peut créer un panneau avec G-Sync pour beaucoup moins d'argent.

En parlant de résolutions, on peut noter que tout se passe ainsi : des écrans QHD avec un taux de rafraîchissement de plus de 120 Hz pourraient commencer à sortir dès 2014.

Y a-t-il des problèmes avec SLI et G-Sync ?

Que faut-il pour voir G-Sync en mode Surround ?

De nos jours, bien sûr, vous n'avez pas besoin de combiner deux adaptateurs graphiques pour afficher des images en qualité 1080p. Même une carte graphique de milieu de gamme basée sur Kepler sera en mesure de fournir le niveau de performances nécessaire pour jouer confortablement à cette résolution. Mais il n'y a pas non plus moyen de faire fonctionner deux cartes en SLI pendant trois G-Sync-moniteurs en mode Surround.

Cette limitation est due aux sorties d'affichage modernes sur les cartes Nvidia, qui ont généralement deux ports DVI, un HDMI et un DisplayPort. G-Sync nécessite DisplayPort 1.2 et l'adaptateur ne fonctionnera pas (ni un hub MST). La seule option est de connecter trois moniteurs en mode Surround à trois cartes, c'est-à-dire une carte séparée pour chaque moniteur. Naturellement, nous nous attendons à ce que les partenaires de Nvidia commencent à expédier des cartes "G-Sync Edition" avec davantage de connexions DisplayPort.

G-Sync et triple mise en mémoire tampon

Une triple mise en mémoire tampon active était nécessaire pour jouer confortablement avec Vsync. En ai-je besoin pour G-Sync? La réponse est non. G-Sync non seulement ne nécessite pas de triple mise en mémoire tampon, puisque le canal ne s'arrête jamais, au contraire, cela nuit G-Sync car il ajoute une trame supplémentaire de latence sans aucun gain de performance. Malheureusement, les jeux à triple mise en mémoire tampon sont souvent définis par eux-mêmes et ne peuvent pas être contournés manuellement.

Qu'en est-il des jeux qui ont tendance à mal réagir lorsque la synchronisation V est désactivée ?

Des jeux comme Skyrim, qui fait partie de notre suite de tests, sont conçus pour fonctionner avec la synchronisation V sur un panneau à 60 Hz (bien que cela nous rende parfois la vie difficile en raison du décalage d'entrée). Pour les tester, vous devez modifier certains fichiers avec l'extension .ini. Comme il se comporte G-Sync avec des jeux basés sur des moteurs Gamebryo et Creation sensibles à la synchronisation ? Sont-ils limités à 60 FPS ?

Deuxièmement, vous avez besoin d'un moniteur avec un module Nvidia G-Sync... Ce module remplace le scaler d'affichage. Et, par exemple, ajoutez à l'écran divisé Ultra HD G-Sync impossible. Pour l'examen d'aujourd'hui, nous utilisons un prototype avec une résolution de 1920x1080 pixels et un taux de rafraîchissement allant jusqu'à 144Hz. Mais même avec cela, vous pourrez vous faire une idée de l'impact que cela aura G-Sync si les fabricants commencent à l'installer dans des panneaux 60 Hz moins chers.

Troisièmement, un câble DisplayPort 1.2 est requis. DVI et HDMI ne sont pas pris en charge. À court terme, cela signifie que la seule option pour le travail G-Sync sur trois moniteurs en mode Surround, ils sont connectés via un triple bundle SLI, puisque chaque carte n'a qu'un seul connecteur DisplayPort, et les adaptateurs pour DVI vers DisplayPort ne fonctionnent pas dans ce cas. Il en va de même pour les hubs MST.

Enfin, n'oubliez pas la prise en charge des pilotes. Le dernier package, la version 331.93 bêta, est déjà compatible avec G-Sync et nous nous attendons à ce que les futures versions certifiées WHQL en soient équipées.

Banc d'essai

| Configuration du banc d'essai | |

| CPU | Intel Core i7-3970X (Sandy Bridge-E), fréquence de base de 3,5 GHz, overclocké à 4,3 GHz, LGA 2011, 15 Mo de cache L3 partagé, Hyper-Threading activé, Fonctions d'économie d'énergie activées |

| Carte mère | Chipset X79 Express MSI X79A-GD45 Plus (LGA 2011), BIOS 17.5 |

| RAM | G.Skill 32 Go (8 x 4 Go) DDR3-2133, F3-17000CL9Q-16GBXM x2 @ 9-11-10-28 et 1,65 V |

| Périphérique de stockage | Samsung 840 Pro SSD 256Go SATA 6Go/s |

| Cartes vidéo | Nvidia GeForce GTX 780 Ti 3 Go Nvidia GeForce GTX 760 2 Go |

| Source de courant | Corsaire AX860i 860 W |

| Logiciel système et pilotes | |

| Système d'exploitation | Windows 8 Professionnel 64 bits |

| DirectX | DirectX 11 |

| Pilote vidéo | Nvidia GeForce 331.93 bêta |

Maintenant, vous devez déterminer dans quels cas G-Sync a le plus d'impact. Il y a de fortes chances que vous utilisiez déjà un moniteur avec un taux de rafraîchissement de 60 Hz. Parmi les joueurs, les modèles 120 et 144 Hz sont plus populaires, mais Nvidia suppose à juste titre que la plupart des passionnés du marché s'en tiendront toujours à 60 Hz.

Avec la synchronisation verticale active sur un moniteur à 60 Hz, les artefacts les plus visibles apparaissent lorsque la carte ne peut pas fournir 60 ips, ce qui entraîne des sauts gênants entre 30 et 60 ips. Il y a des ralentissements notables ici. Avec la synchronisation V désactivée, l'effet de déchirure sera plus visible dans les scènes où vous devez faire pivoter fréquemment l'appareil photo ou dans lesquelles il y a beaucoup de mouvement. Certains joueurs sont tellement distraits par cela qu'ils activent simplement la synchronisation V et subissent des ralentissements et des retards d'entrée.

À 120 Hz et 144 Hz et à des fréquences d'images plus élevées, l'affichage s'actualise plus fréquemment, réduisant ainsi le temps de rétention d'une image sur plusieurs balayages d'écran lorsque les performances sont insuffisantes. Cependant, les problèmes de synchronisation verticale active et inactive persistent. Pour cette raison, nous allons tester le moniteur Asus à 60 et 144 Hz avec la technologie allumée et éteinte. G-Sync .

Aperçu de la technologie G-Sync | Test de G-Sync avec V-Sync activé

Il est temps de commencer à tester G-Sync... Il ne reste plus qu'à installer une carte de capture vidéo, une matrice de plusieurs SSD et procéder aux tests, non ?

Non, c'est faux.

Aujourd'hui, nous ne mesurons pas la productivité, mais la qualité. Dans notre cas, les tests ne peuvent montrer qu'une seule chose : la fréquence d'images à un moment donné. Sur la qualité et l'expérience d'utilisation avec la technologie allumée et éteinte G-Sync ils ne disent rien du tout. Par conséquent, vous devrez vous fier à notre description soigneusement vérifiée et éloquente, que nous essaierons de rapprocher le plus possible de la réalité.

Pourquoi ne pas simplement enregistrer une vidéo et la donner aux lecteurs pour qu'ils les jugent ? Le fait est que la caméra enregistre la vidéo à une vitesse fixe de 60 Hz. Votre moniteur lit également la vidéo à un taux de rafraîchissement constant de 60 Hz. Dans la mesure où G-Sync implémente un taux de rafraîchissement variable, vous ne verrez pas la technologie en action.

Compte tenu du nombre de jeux disponibles, le nombre de combinaisons de tests possibles est incalculable. V-sync activé, V-sync désactivé, G-Sync y compris, G-Sync off, 60 Hz, 120 Hz, 144 Hz, ... La liste est longue. Mais nous allons commencer avec un taux de rafraîchissement de 60 Hz et une synchronisation verticale active.

Le point de départ le plus simple est probablement le propre utilitaire de démonstration de Nvidia, dans lequel le pendule oscille d'un côté à l'autre. L'utilitaire peut simuler des fréquences d'images de 60, 50 ou 40 FPS. Ou la fréquence peut fluctuer entre 40 et 60 FPS. Ensuite, vous pouvez désactiver ou activer la synchronisation V et G-Sync... Bien que le test soit fictif, il démontre bien les capacités de la technologie. Vous pouvez regarder la scène à 50 FPS avec la synchronisation verticale activée et penser : « Tout va très bien, et les ralentissements visibles peuvent être tolérés. Mais après activation G-Sync J'ai tout de suite envie de dire : « A quoi je pensais ? La différence est flagrante, comme le jour et la nuit. Comment pouvais-je vivre avec ça avant ?

Mais n'oublions pas qu'il s'agit d'une démo technique. Je voudrais des preuves basées sur de vrais jeux. Pour ce faire, vous devez exécuter un jeu avec une configuration système élevée, comme Arma III.

Arma III peut être installé dans une voiture d'essai GeForce GTX770 et définissez les paramètres ultra. Lorsque la synchronisation verticale est désactivée, la fréquence d'images varie entre 40 et 50 FPS. Mais si vous activez la synchronisation V, il tombe à 30 FPS. Les performances ne sont pas assez élevées pour voir des fluctuations constantes entre 30 et 60 FPS. Au lieu de cela, la fréquence d'images de la carte vidéo est simplement réduite.

Puisqu'il n'y avait pas de gel de l'image, une différence significative lors de l'activation G-Sync invisible, sauf que la fréquence d'images réelle saute de 10 à 20 FPS plus haut. Le décalage d'entrée doit également être réduit, car la même image n'est pas enregistrée sur plusieurs balayages du moniteur. On sent qu'Arma est globalement moins nerveux que beaucoup d'autres jeux, donc le lag ne se fait pas sentir.

D'un autre côté, Metro: Last Light est influencé par G-Sync plus prononcé. Avec carte vidéo GeForce GTX770 Le jeu peut être exécuté à 1920x1080 avec des paramètres de détail très élevés, y compris AF 16x, tessellation normale et flou de mouvement. Dans ce cas, vous pouvez sélectionner les paramètres SSAA de 1x à 2x à 3x pour réduire progressivement la fréquence d'images.

De plus, l'environnement du jeu comprend un couloir, qui est facile à parcourir d'avant en arrière. Après avoir commencé le niveau avec une synchronisation verticale active à 60 Hz, nous sommes sortis en ville. Fraps a montré qu'avec le triple SSAA, la fréquence d'images était de 30 FPS, et avec l'anticrénelage désactivé, elle était de 60 FPS. Dans le premier cas, des ralentissements et des retards sont perceptibles. Avec SSAA désactivé, vous obtiendrez une image absolument fluide à 60 FPS. Cependant, l'activation de 2x SSAA entraîne des fluctuations de 60 à 30 FPS, à partir desquelles chaque trame dupliquée crée des inconvénients. C'est l'un des jeux dans lesquels nous désactiverions définitivement la synchronisation verticale et ignorerions simplement le déchirement. Beaucoup de gens ont déjà développé une habitude.

mais G-Syncélimine tous les effets négatifs. Vous n'avez plus à regarder le compteur Fraps en attendant des drawdowns inférieurs à 60 FPS pour baisser un autre paramètre graphique. Au contraire, vous pouvez augmenter certains d'entre eux, car même si vous ralentissez à 50 - 40 FPS, il n'y aura pas de ralentissements évidents. Que faire si vous désactivez la synchronisation verticale ? Vous en apprendrez plus à ce sujet plus tard.

Aperçu de la technologie G-Sync | Test de G-Sync avec V-Sync désactivé

Les conclusions de ce matériel sont basées sur une enquête auprès des auteurs et amis de Tom "s Hardware sur Skype (en d'autres termes, l'échantillon de répondants est petit), mais presque tous comprennent ce qu'est la synchronisation verticale et quels sont les inconvénients des utilisateurs à supporter à cet égard. , ils ne recourent à la synchronisation verticale que lorsque les écarts deviennent insupportables en raison de la grande variation des fréquences d'images et des taux de rafraîchissement des moniteurs.

Comme vous pouvez l'imaginer, l'impact visuel de Vsync off est difficile à confondre, bien qu'il soit fortement influencé par le jeu et ses paramètres de détail.

Prends pour exemple Crise 3... Le jeu peut facilement mettre votre sous-système graphique à genoux avec les paramètres graphiques les plus élevés. Et depuis Crise 3 est un jeu de tir à la première personne avec un gameplay très dynamique, les pauses peuvent être assez palpables. Dans l'exemple ci-dessus, la sortie FCAT a été capturée entre deux trames. Comme vous pouvez le voir, l'arbre est complètement coupé.

D'un autre côté, lorsque nous désactivons de force Vsync dans Skyrim, les pauses ne sont pas si fortes. Notez que dans ce cas, la fréquence d'images est très élevée et plusieurs images apparaissent à l'écran à chaque balayage. Pour ces revues, le nombre de mouvements par image est relativement faible. Il y a des problèmes lors de la lecture de Skyrim dans cette configuration, et ce n'est peut-être pas la plus optimale. Mais cela montre que même avec la synchronisation verticale désactivée, la sensation du jeu peut changer.

Pour le troisième exemple, nous avons choisi un cliché de l'épaule de Lara Croft de Tomb Raider, qui montre une cassure assez nette dans l'image (regardez aussi les cheveux et la bretelle de la chemise). Tomb Raider est le seul jeu de notre échantillon qui vous permet de choisir entre le double et le triple buffering lorsque la synchronisation verticale est activée.

Le dernier graphique montre que Metro: Last Light avec G-Syncà 144 Hz, fournit généralement les mêmes performances que lorsque la synchronisation verticale est désactivée. Cependant, l'absence de lacunes n'est pas visible sur le graphique. Si vous utilisez une technologie avec un écran à 60 Hz, la fréquence d'images s'arrêtera à 60 FPS, mais il n'y aura pas de ralentissements ni de décalages.

Dans tous les cas, ceux d'entre vous (et nous) qui ont passé un nombre incalculable de temps sur des tests graphiques, à regarder le même benchmark encore et encore, pourraient s'y habituer et déterminer visuellement la qualité d'un résultat particulier. C'est ainsi que nous mesurons les performances absolues des cartes vidéo. Changements dans l'image avec actif G-Sync frappant immédiatement, car il y a une douceur, comme avec la V-sync activée, mais sans les pauses inhérentes à la V-sync désactivée. C'est dommage que maintenant nous ne puissions pas montrer la différence dans la vidéo.

Aperçu de la technologie G-Sync | Compatibilité de jeu : presque parfaite

Vérifier d'autres jeux

Nous avons testé quelques autres jeux. Crise 3, Tomb Raider, Skyrim, BioShock: Infinite, Battlefield 4 visité le banc d'essai. Tous sauf Skyrim ont bénéficié de la technologie. G-Sync... L'effet dépendait du jeu compétitif. Mais si vous le voyiez, vous admettriez immédiatement que vous avez ignoré les défauts qui étaient présents plus tôt.

Les artefacts peuvent toujours apparaître. Par exemple, l'effet de fluage associé à l'anticrénelage est plus visible avec un mouvement fluide. Très probablement, vous voudrez régler l'anticrénelage aussi haut que possible pour supprimer les bosses désagréables qui n'étaient pas si visibles auparavant.

Skyrim : cas particulier

Le moteur graphique de création de Skyrim active la synchronisation V par défaut. Pour tester le jeu à des fréquences d'images supérieures à 60 FPS, ajoutez la ligne iPresentInterval = 0 à l'un des fichiers .ini du jeu.

Ainsi, Skyrim peut être testé de trois manières : dans l'état initial, permettant au pilote Nvidia "d'utiliser les paramètres de l'application", activez G-Sync dans le pilote et laissez les paramètres de Skyrim intacts, puis activez G-Sync et désactivez la synchronisation V dans le fichier du jeu avec l'extension .ini.

La première configuration, dans laquelle le prototype de moniteur est réglé sur 60 Hz, a montré un 60 FPS stable sur les paramètres ultra avec une carte vidéo GeForce GTX770... Par conséquent, nous avons obtenu une image lisse et agréable. Cependant, la saisie de l'utilisateur souffre toujours de latence. De plus, le mitraillage latéral a révélé un flou de mouvement notable. Cependant, c'est ainsi que la plupart des gens jouent sur PC. Vous pouvez bien sûr acheter un écran 144Hz et cela éliminera vraiment le flou. Mais depuis GeForce GTX770 fournit un taux de rafraîchissement d'environ 90 à 100 images par seconde, des ralentissements notables apparaîtront lorsque le moteur oscillera entre 144 et 72 FPS.

À 60 Hz G-Sync a un effet négatif sur l'image, probablement en raison de la synchronisation verticale active, alors que la technologie devrait fonctionner avec la synchronisation V désactivée. Désormais, le mitraillage latéral (surtout plus près des murs) entraîne des ralentissements prononcés. C'est un problème potentiel pour les panneaux 60 Hz avec G-Sync au moins dans des jeux comme Skyrim. Heureusement, dans le cas du moniteur Asus VG248Q, vous pouvez passer en mode 144Hz, et malgré la V-sync active, G-Sync fonctionnera parfaitement à cette fréquence d'images.

La désactivation complète de la synchronisation verticale dans Skyrim permet un contrôle plus fluide de la souris. Cependant, une déchirure dans l'image apparaît (sans parler d'autres artefacts tels que l'eau miroitante). Allumer G-Sync laisse la décélération à 60 Hz, mais à 144 Hz la situation s'améliore sensiblement. Bien que dans nos critiques de cartes vidéo, nous testions le jeu avec Vsync désactivé, nous ne recommandons pas de jouer sans.

Pour Skyrim, peut-être le plus la meilleure solution désactivera G-Sync et jouez à 60 Hz, ce qui donnera une constante de 60 images par seconde avec les paramètres graphiques choisis.

Aperçu de la technologie G-Sync | Est-ce que G-Sync est ce que vous attendiez ?

Avant même d'avoir notre échantillon de test du moniteur Asus avec la technologie G-Sync On se réjouit déjà du fait que Nvidia travaille sur un problème bien réel affectant les jeux, dont la solution n'a pas encore été proposée. Jusqu'à présent, vous pouvez ou non activer la synchronisation verticale à votre guise. Dans ce cas, toute décision était accompagnée de compromis qui affectent négativement l'expérience de jeu. Si vous préférez ne pas activer la synchronisation V jusqu'à ce que la déchirure devienne insupportable, alors vous pouvez dire que vous choisissez le moindre de deux maux.

G-Sync résout le problème en donnant au moniteur la possibilité de balayer l'écran à une fréquence variable. Une telle innovation est le seul moyen de continuer à faire progresser notre industrie tout en maintenant avantage technique Ordinateur personnel sur les consoles de jeux et les plateformes. Nvidia résistera sans aucun doute aux critiques pour ne pas avoir développé une norme que ses concurrents pourraient appliquer. Cependant, la société utilise DisplayPort 1.2 pour sa solution. En conséquence, deux mois seulement après l'annonce de la technologie G-Sync elle s'est retrouvée entre nos mains.

La question est de savoir si Nvidia fait tout ce qu'il a promis dans G-Sync ?

Trois développeurs talentueux vantant des qualités technologiques que vous n'avez jamais vues en action peuvent inspirer n'importe qui. Mais si votre première expérience avec G-Sync Sur la base du test de démonstration du pendule de Nvidia, vous vous demanderez certainement si une différence aussi énorme est possible, ou si le test présente un scénario spécial trop beau pour être vrai.

Naturellement, lorsque l'on teste la technologie dans de vrais jeux, l'effet n'est pas si clair. D'un côté, il y avait des exclamations de "Wow!" et "Deviens fou !", de l'autre - "Je pense que je peux voir la différence." Le meilleur de tous l'impact de l'activation G-Sync perceptible lors du changement du taux de rafraîchissement de l'affichage de 60 Hz à 144 Hz. Mais nous avons également essayé d'exécuter le test à 60 Hz avec G-Sync pour voir ce que vous obtiendrez (espérons-le) avec des écrans moins chers à l'avenir. Dans certains cas, passer simplement de 60 Hz à 144 Hz vous submergera, surtout si votre carte graphique peut fournir des fréquences d'images élevées.

Aujourd'hui, nous savons qu'Asus envisage de mettre en place un support G-Sync dans le modèle Asus VG248QE, qui, selon la société, se vendra 400 $ l'année prochaine. Le moniteur a une résolution native de 1920x1080 pixels et un taux de rafraîchissement de 144 Hz. Version sans G-Sync a déjà remporté notre Smart Buy Award pour ses performances exceptionnelles. Mais pour nous personnellement, la dalle TN 6 bits est un inconvénient. J'aimerais voir 2560x1440 pixels sur une matrice IPS. Nous nous contenterons même d'un taux de rafraîchissement de 60 Hz si cela permet de réduire le prix.

Bien que sur au CES nous attendons tout un tas d'annonces, des commentaires officiels de Nvidia concernant d'autres écrans avec modules G-Sync et nous n'avons pas entendu leurs prix. De plus, nous ne savons pas quels sont les plans de l'entreprise pour un module de mise à niveau qui devrait vous permettre de mettre en œuvre le module. G-Sync dans un moniteur déjà acheté Asus VG248QE Dans 20 Minutes.

Maintenant, nous pouvons dire que cela vaut la peine d'attendre. Vous verrez que dans certains jeux l'influence nouvelles technologies ne peut pas être confondu, mais dans d'autres, il est moins prononcé. Mais peu importe G-Sync répond à la question "barbu", s'il faut ou non activer la synchronisation verticale.

Il y a une autre pensée intéressante. Après avoir testé G-Sync Combien d'AMD sera-t-il encore capable d'échapper aux commentaires ? La société a taquiné nos lecteurs dans son entretien(Anglais), notant qu'elle se prononcera bientôt sur cette opportunité. Si elle a quelque chose dans les plans ? La fin 2013 et le début 2014 nous préparent beaucoup de nouvelles intéressantes à discuter, notamment Battlefield 4 Versions Mantle, architecture Nvidia Maxwell à venir, G-Sync, moteur AMD xDMA avec support CrossFire et rumeurs de nouvelles cartes graphiques à double GPU. Nous manquons maintenant de cartes vidéo avec plus de 3 Go (Nvidia) et 4 Go (AMD) de mémoire GDDR5, mais elles coûtent moins de 1000 $ ...

Il y a des choses qui sont non seulement difficiles à écrire, mais très difficiles. Qu'il suffit de voir une fois, d'en entendre parler une centaine de fois ou de lire sur Internet. Par exemple, il est impossible de décrire certaines merveilles naturelles, comme le majestueux Grand Canyon ou les montagnes enneigées de l'Altaï. Vous pouvez regarder cent fois de belles images avec leurs images et admirer des vidéos, mais tout cela ne peut pas remplacer les impressions en direct.

Le sujet de la sortie fluide des images sur le moniteur à l'aide de la technologie Nvidia G-Sync fait également référence à de tels sujets - selon les descriptions textuelles, les changements ne semblent pas si importants, mais dans les toutes premières minutes d'un jeu 3D sur un système avec un Carte vidéo Nvidia Geforce connectée au moniteur G-Sync, il devient clair à quel point un saut qualitatif est important. Et bien que plus d'un an se soit écoulé depuis l'annonce de la technologie, la technologie ne perd pas de sa pertinence, elle n'a toujours pas de concurrents (parmi les solutions qui sont entrées sur le marché) et les moniteurs correspondants continuent d'être produits.

Nvidia se concentre depuis un certain temps sur l'amélioration de l'expérience utilisateur des GPU Geforce pour les séquences vidéo dans les jeux modernes en rendant le rendu plus fluide. Vous pouvez rappeler la technologie Adaptive V-Sync, qui est un hybride qui combine les modes avec V-Sync On et V-Sync Off, respectivement. Dans le cas où le GPU fournit un rendu à une fréquence d'images inférieure à la fréquence de rafraîchissement du moniteur, la synchronisation est désactivée, et pour les FPS dépassant la fréquence de rafraîchissement, elle est activée.

Tous les problèmes de fluidité n'ont pas été résolus avec la synchronisation adaptative, mais c'était quand même un pas important dans la bonne direction. Mais pourquoi était-il nécessaire de faire quelque modes spéciaux synchronisation et même publier des solutions matérielles et logicielles ? Quel est le problème avec les technologies qui existent depuis des décennies ? Aujourd'hui, nous allons vous montrer comment la technologie G-Sync de Nvidia peut aider à éliminer tous les artefacts d'affichage connus tels que le déchirement, les images floues et le décalage accru.

En regardant loin, nous pouvons dire que la technologie de synchronisation G-Sync vous permet d'obtenir une fréquence d'images fluide avec les performances et le confort les plus élevés possibles, ce qui est très visible lorsque vous jouez derrière un tel moniteur - cela est perceptible même pour un utilisateur domestique ordinaire. , et pour les joueurs passionnés, cela peut signifier une amélioration du temps de réaction et en même temps des réalisations de jeu.

Aujourd'hui, la plupart des joueurs sur PC utilisent des moniteurs 60 Hz - les écrans LCD typiques qui sont les plus populaires aujourd'hui. En conséquence, à la fois avec V-Sync activé et désactivé, il y a toujours des inconvénients associés aux problèmes de base des technologies anciennes, dont nous parlerons plus loin : des retards élevés et des saccades de FPS avec V-Sync activé et des images de pause désagréables lorsqu'elles sont désactivées.

Et comme les retards et les fréquences d'images irrégulières sont plus perturbateurs et ennuyeux pour le jeu, les joueurs activent rarement la synchronisation. Et même certains modèles de moniteurs avec un taux de rafraîchissement de 120 et 144 Hz qui sont apparus sur le marché ne peuvent pas aider à éliminer complètement les problèmes, ils les rendent simplement un peu moins visibles, mettant à jour le contenu de l'écran deux fois plus souvent, mais les mêmes artefacts sont présents : décalages et l'absence de la même douceur confortable.

Et puisque les moniteurs avec G-Sync associés à une carte graphique Nvidia Geforce appropriée sont capables non seulement de fournir un taux de rafraîchissement élevé, mais également d'éliminer tous ces inconvénients, l'achat de telles solutions peut être considéré comme encore plus important que même la mise à niveau vers un GPU plus puissant. . Mais voyons d'abord pourquoi il était nécessaire de faire quelque chose de différent des solutions connues de longue date - quel est le problème ici ?

Problèmes avec les méthodes de sortie vidéo existantes

Les technologies d'affichage d'images sur un écran avec un taux de rafraîchissement fixe existent depuis l'époque où les moniteurs à tube cathodique (CRT) étaient utilisés. La plupart des lecteurs devraient s'en souvenir - les gros ventres, comme les anciennes télévisions. Ces technologies ont été développées à l'origine pour afficher des images de télévision avec une fréquence d'images fixe, mais dans le cas des dispositifs d'affichage d'une image 3D calculée dynamiquement sur un PC, cette solution pose de gros problèmes qui n'ont pas encore été résolus.

Même les moniteurs LCD les plus modernes ont un taux de rafraîchissement fixe à l'écran, bien que technologiquement rien ne les empêche de changer l'image à tout moment, avec n'importe quelle fréquence (dans des limites raisonnables, bien sûr). Mais les joueurs sur PC ont longtemps dû s'accommoder d'une solution apparemment imparfaite au problème de synchronisation de la fréquence d'images du rendu 3D et de la fréquence de rafraîchissement du moniteur. Jusqu'à présent, il y a eu très peu d'options pour afficher une image - deux, et les deux ont des inconvénients.

La racine de tous les problèmes réside dans le fait qu'avec un taux de rafraîchissement fixe de l'image sur le moniteur, la carte vidéo restitue chaque image à un moment différent - cela est dû à la complexité en constante évolution de la scène et à la charge sur le GPU. Et le temps de rendu de chaque image n'est pas constant, il change à chaque image. Il n'est pas surprenant que lorsque vous essayez d'afficher un certain nombre d'images sur le moniteur, il y ait des problèmes de synchronisation, car certaines d'entre elles prennent beaucoup plus de temps à être rendues que d'autres. De ce fait, il s'avère que le temps de préparation est différent pour chaque trame : puis 10 ms, puis 25 ms, par exemple. Et les moniteurs existant avant l'avènement de G-Sync ne pouvaient afficher des images qu'après un certain laps de temps - ni plus tôt, ni plus tard.

La question est encore compliquée par la richesse des configurations matérielles et logicielles des PC gamers, combinées à une charge très différente selon les jeux, des paramètres de qualité, des paramètres de pilotes vidéo, etc. De ce fait, il est impossible de configurer chaque système de jeu de manière à ce que la formation est effectuée avec des temps constants ou du moins pas trop différents dans toutes les applications et conditions 3D - comme cela est possible sur les consoles de jeux avec leur configuration matérielle unique.

Naturellement, contrairement aux consoles avec leurs temps de rendu d'image prévisibles, les joueurs PC sont toujours sévèrement limités dans leur capacité à réaliser un jeu fluide sans pertes ni décalages notables. Dans un cas idéal (lecture - impossible en réalité), l'image sur le moniteur doit être mise à jour strictement après que la prochaine image a été calculée et préparée par le processeur graphique :

Comme vous pouvez le voir, dans cet exemple hypothétique, le GPU parvient toujours à dessiner une trame avant le moment où elle doit être transmise au moniteur - le temps de trame est toujours légèrement inférieur au temps entre les mises à jour des informations sur l'écran et le GPU se repose un peu pendant les pauses. Mais en réalité, après tout, tout est complètement différent - le temps de rendu des images est très différent. Imaginez si le GPU n'a pas le temps de rendre l'image dans le temps imparti - alors l'image doit être affichée plus tard, en sautant une mise à jour de l'image sur le moniteur (la synchronisation verticale est activée - V-Sync activé), ou afficher les images par parties avec la synchronisation désactivée, puis sur le moniteur en même temps, des morceaux de plusieurs images adjacentes seront présents.

La plupart des utilisateurs désactivent V-Sync pour obtenir une latence plus faible et une sortie d'image plus fluide, mais cette solution provoque des artefacts de déchirure visibles. Et avec la synchronisation activée, il n'y aura pas de rupture d'image, puisque les images sont affichées exclusivement en intégralité, mais le délai entre l'action du joueur et la mise à jour de l'image à l'écran augmente, et le taux de sortie des images s'avère très inégal , puisque le GPU ne dessine jamais les images en stricte conformité avec l'heure de mise à jour de l'image sur le moniteur.

Ce problème existe depuis de nombreuses années et interfère clairement avec le confort lors de la visualisation du résultat du rendu 3D, mais jusqu'à récemment, personne ne s'est soucié de le résoudre. Et la solution est, en théorie, assez simple - il vous suffit d'afficher les informations à l'écran uniquement lorsque le GPU a fini de travailler sur la prochaine image. Mais d'abord, examinons de plus près le fonctionnement des technologies d'affichage existantes et la solution que Nvidia nous propose dans sa technologie G-Sync.

Inconvénients de la sortie lorsque la synchronisation est désactivée

Comme nous l'avons déjà mentionné, la grande majorité des joueurs préfèrent garder la synchronisation désactivée (V-Sync Off) afin d'obtenir l'affichage des images rendues par le GPU sur le moniteur le plus rapidement possible et avec un délai minimum entre les actions du joueur ( frappes, commandes de la souris) et leur affichage. Pour les joueurs sérieux, cela est nécessaire pour gagner, et pour les joueurs ordinaires dans ce cas, les sensations seront plus agréables. Voici à quoi ressemble schématiquement le travail avec V-Sync désactivé :

Il n'y a pas de problèmes et de retards avec la sortie des trames. Mais tandis que la désactivation de Vsync résout le problème du décalage autant que possible, en fournissant une latence minimale, des artefacts apparaissent dans l'image - le déchirement de l'image, lorsque l'image à l'écran se compose de plusieurs morceaux d'images adjacentes, rendues par le GPU. On remarque également le manque de fluidité de la séquence vidéo en raison de l'irrégularité des images provenant du GPU vers l'écran - l'image se brise à différents endroits.

Ces déchirures résultent de l'affichage d'une image composée de deux images ou plus, rendues sur le GPU pendant un cycle de mise à jour des informations sur le moniteur. De plusieurs - lorsque la fréquence d'images dépasse le taux de rafraîchissement du moniteur, et des deux - lorsqu'il lui correspond approximativement. Regardez le diagramme ci-dessus - si le contenu du tampon de trame est mis à jour au milieu entre les moments d'affichage des informations sur le moniteur, alors l'image finale sur celui-ci sera déformée - certaines des informations dans ce cas appartiennent à la précédente frame, et le reste au rendu en cours.

Lorsque la synchronisation est désactivée, les trames sont transmises au moniteur sans tenir compte de la fréquence et de l'heure de son rafraîchissement, de sorte qu'elles ne coïncident jamais avec le taux de rafraîchissement du moniteur. En d'autres termes, avec V-Sync désactivé, les moniteurs sans prise en charge de G-Sync subiront toujours une telle déchirure.

Il ne s'agit pas seulement du fait que le joueur est désagréable de voir des rayures sur tout l'écran, mais aussi du fait que le rendu simultané de parties de différentes images peut désinformer le cerveau, ce qui est particulièrement visible avec des objets dynamiques dans l'image. - le joueur voit des parties d'objets décalées les unes par rapport aux autres. Vous devez le supporter uniquement parce que la désactivation de V-Sync fournit des délais de sortie minimes pour le moment, mais loin de la qualité idéale d'une image dynamique, comme vous pouvez le voir dans les exemples suivants (les images en pleine résolution sont disponibles au clic) :

Dans les exemples ci-dessus, tournés à l'aide du complexe logiciel et matériel FCAT, vous pouvez vous assurer que l'image réelle à l'écran peut être composée de morceaux de plusieurs cadres adjacents - et parfois de manière inégale, lorsqu'une bande étroite est extraite de l'un des cadres. , et les voisins occupent la partie restante (notablement plus grande) de l'écran.

Encore plus clairement, les problèmes de déchirure d'image sont perceptibles en dynamique (si votre système et/ou navigateur ne prend pas en charge la lecture de vidéos MP4/H.264 à une résolution de 1920 × 1080 pixels avec un taux de rafraîchissement de 60 FPS, alors vous devez les télécharger et les visualiser localement à l'aide d'un lecteur multimédia doté des capacités appropriées) :

Comme vous pouvez le voir, même en dynamique, des artefacts désagréables sous forme de coupures d'image sont facilement perceptibles. Voyons à quoi cela ressemble schématiquement - dans le diagramme, qui montre la méthode de sortie lorsque la synchronisation est désactivée. Dans ce cas, les images sont reçues sur le moniteur immédiatement après que le GPU a fini de les rendre, et l'image est affichée sur l'écran même si les informations de sortie de l'image actuelle ne sont pas encore complètement terminées - le reste de la mémoire tampon tombe sur la prochaine rafraîchissement de l'écran. C'est pourquoi chaque image de notre exemple affichée sur le moniteur se compose de deux images rendues sur le GPU - avec une pause dans l'image à l'endroit marqué en rouge.

Dans cet exemple, la première image (Draw 1) est dessinée par le GPU vers la mémoire tampon d'écran plus rapidement que son temps de rafraîchissement de 16,7 ms — et avant que l'image ne soit envoyée au moniteur (Scan 0/1). Le GPU commence immédiatement à travailler sur l'image suivante (Draw 2), ce qui casse l'image sur le moniteur, contenant une autre moitié de l'image précédente.

En conséquence, dans de nombreux cas, une bande clairement distinguable apparaît sur l'image - la frontière entre l'affichage partiel des images adjacentes. À l'avenir, ce processus se répétera, puisque le GPU travaille sur chaque image pendant un laps de temps différent, et sans synchroniser le processus, les images du GPU et celles affichées sur le moniteur ne coïncident jamais.

Avantages et inconvénients de la synchronisation verticale

Lorsque vous activez la synchronisation verticale traditionnelle (V-Sync On), les informations sur le moniteur ne sont mises à jour que lorsque le travail sur le cadre est complètement terminé par le GPU, ce qui élimine le déchirement de l'image, car les cadres sont affichés sur le écran exclusivement dans son ensemble. Mais, étant donné que le moniteur ne met à jour le contenu qu'à certains intervalles (en fonction des caractéristiques du périphérique de sortie), cette liaison entraîne déjà d'autres problèmes.

La plupart des moniteurs LCD modernes mettent à jour les informations à 60 Hz, c'est-à-dire 60 fois par seconde - environ toutes les 16 millisecondes. Et avec la synchronisation activée, le temps de sortie de l'image est strictement lié au taux de rafraîchissement du moniteur. Mais comme nous le savons, le taux de rendu des images sur le GPU est toujours variable et le temps de rendu de chaque image diffère en fonction de la complexité en constante évolution de la scène 3D et des paramètres de qualité.

Elle ne peut pas toujours être égale à 16,7 ms, mais elle sera soit inférieure à cette valeur, soit supérieure. Lorsque la synchronisation est activée, le travail du GPU sur les trames se termine à nouveau plus tôt ou plus tard que le temps de rafraîchissement de l'écran. Si le cadre a été tracé plus rapidement que ce moment, alors il n'y a pas de problèmes particuliers - les informations visuelles n'attendent que le temps de rafraîchissement du moniteur pour afficher l'intégralité du cadre à l'écran et le GPU est inactif. Mais si le cadre n'a pas le temps de s'afficher dans le temps imparti, il doit alors attendre le prochain cycle de mise à jour de l'image sur le moniteur, ce qui entraîne une augmentation du délai entre les actions du joueur et leur affichage visuel à l'écran. . Dans ce cas, l'image de l'"ancien" cadre précédent s'affiche à nouveau à l'écran.

Bien que tout cela se passe assez rapidement, l'augmentation de la latence est facilement perceptible visuellement, et pas seulement par les joueurs professionnels. Et comme le temps de rendu des trames est toujours variable, l'activation de la liaison au taux de rafraîchissement du moniteur provoque des à-coups lors de l'affichage d'une image dynamique, car les trames s'affichent soit rapidement (égales au taux de rafraîchissement du moniteur), soit deux, trois ou quatre fois Ralentissez. Considérons un exemple schématique d'un tel travail:

L'illustration montre comment les cadres sont affichés sur le moniteur avec V-Sync activé. La première image (Draw 1) est dessinée par le GPU plus rapidement que 16,7 ms, donc le GPU ne va pas travailler sur le dessin de l'image suivante, et ne déchire pas l'image, comme dans le cas de V-Sync Off, mais attend pour que la première image soit entièrement affichée sur le moniteur. Et seulement après cela, la prochaine image (Draw 2) commence à être dessinée.

Mais le travail sur la deuxième image (Dessin 2) prend plus de 16,7 ms, donc après leur expiration, les informations visuelles de l'image précédente s'affichent à l'écran et s'affichent à l'écran pendant 16,7 ms supplémentaires. Et même une fois que le GPU a fini de travailler sur l'image suivante, elle ne s'affiche pas à l'écran, car le moniteur a un taux de rafraîchissement fixe. En général, il faut attendre 33,3 ms pour que la deuxième image s'affiche, et tout ce temps s'ajoute au délai entre l'action du joueur et la fin de l'affichage de l'image sur le moniteur.

Au problème du décalage temporel, il existe également un écart dans la fluidité du métrage, perceptible par les contractions de l'animation 3D. Le problème est montré très clairement dans une courte vidéo :

Mais même les GPU les plus puissants des jeux modernes exigeants ne peuvent pas toujours fournir une fréquence d'images suffisamment élevée, dépassant le taux de rafraîchissement typique des moniteurs de 60 Hz. Et, par conséquent, ils ne donneront pas la possibilité d'un jeu confortable avec la synchronisation activée et l'absence de problèmes comme le déchirement de l'image. Surtout lorsqu'il s'agit de jeux tels que le multijoueur Battlefield 4, le très exigeant Far Cry 4 et Assassin's Creed Unity en haute résolution et avec des paramètres de jeu maximum.

C'est-à-dire que le lecteur moderne n'a guère le choix - soit obtenir un manque de fluidité et des retards accrus, soit se contenter d'une qualité d'image imparfaite avec des morceaux de cadres déchirés. Bien sûr, en réalité, tout n'a pas l'air si mal, car d'une manière ou d'une autre, nous avons joué tout ce temps, n'est-ce pas ? Mais à une époque où ils essaient d'atteindre l'idéal à la fois en termes de qualité et de confort, vous en voulez plus. De plus, les écrans LCD ont une capacité technologique fondamentale à afficher des trames lorsque le processeur graphique l'indique. Il y a peu à faire - pour connecter le GPU et le moniteur, et il existe déjà une telle solution - la technologie Nvidia G-Sync.

Technologie G-Sync - Résoudre les problèmes de Nvidia

Ainsi, la plupart des jeux modernes dans la version avec synchronisation désactivée provoquent une déchirure de l'image et, avec l'activation, des changements de cadre irréguliers et des retards accrus. Même à des taux de rafraîchissement élevés, les moniteurs traditionnels ne résolvent pas ces problèmes. Probablement, le choix entre deux options loin d'être idéales pour la sortie d'images dans des applications 3D au fil des ans a tellement dérangé les employés de Nvidia qu'ils ont décidé de se débarrasser des problèmes en offrant aux joueurs une approche fondamentalement nouvelle pour mettre à jour les informations sur l'écran.

La différence entre la technologie G-Sync et les méthodes d'affichage existantes est que le temps et la fréquence d'images dans le cas de la variante Nvidia sont déterminés par le GPU Geforce, et qu'ils changent dynamiquement et ne sont pas fixes, comme c'était le cas auparavant. En d'autres termes, dans ce cas, le GPU prend le contrôle total de la sortie d'image - dès qu'il a fini de travailler sur l'image suivante, elle s'affiche sur le moniteur, sans retards ni interruptions d'image.

L'utilisation d'une connexion similaire entre le GPU et le matériel spécialement adapté du moniteur donne aux joueurs meilleure méthode la conclusion est tout simplement idéale, du point de vue de la qualité, privant de tous les problèmes ci-dessus. G-Sync fournit des changements de trame parfaitement fluides sur le moniteur, sans aucun retard, saccades et artefacts causés par l'affichage d'informations visuelles sur l'écran.

Naturellement, G-Sync ne fonctionne pas par magie, et pour que la technologie fonctionne côté moniteur, elle nécessite l'ajout d'une logique matérielle spéciale sous la forme d'une petite carte fournie par Nvidia.

La société travaille avec les fabricants de moniteurs pour inclure les cartes G-Sync dans leurs modèles d'affichage de jeu. Pour certains modèles, il existe même une option de mise à niveau par l'utilisateur, mais cette option est plus chère et n'a pas de sens, car il est plus facile d'acheter un moniteur G-Sync tout de suite. À partir d'un PC, il suffit d'avoir l'une des cartes vidéo Nvidia Geforce modernes dans sa configuration et le pilote vidéo optimisé G-Sync installé - n'importe laquelle des nouvelles versions fera l'affaire.

Lorsque la technologie Nvidia G-Sync est activée, après avoir traité l'image suivante d'une scène 3D, le GPU Geforce envoie un signal spécial à la carte contrôleur G-Sync intégrée au moniteur, qui indique au moniteur quand mettre à jour l'image à l'écran . Cela vous permet d'obtenir une fluidité et une réactivité parfaites lorsque vous jouez sur un PC - vous pouvez le voir en regardant une courte vidéo (toujours à 60 images par seconde !) :

Voyons comment fonctionne la configuration avec la technologie G-Sync activée, selon notre schéma :

Comme vous pouvez le voir, tout est très simple. L'activation de G-Sync lie le taux de rafraîchissement du moniteur à la fin du rendu de chaque image sur le GPU. Le GPU contrôle entièrement le travail : dès qu'il a fini de rendre le cadre, l'image est immédiatement affichée sur un moniteur compatible G-Sync, et par conséquent, ce n'est pas un taux de rafraîchissement d'affichage fixe, mais variable - exactement comme la fréquence d'images du GPU. Cela élimine les problèmes de déchirure d'image (après tout, il contient toujours des informations d'une image), minimise les à-coups de fréquence d'images (le moniteur n'attend pas plus longtemps que l'image est physiquement traitée sur le GPU) et réduit les retards de sortie par rapport à la méthode avec Vsync activé .

Je dois dire que cette solution n'était clairement pas suffisante pour les joueurs, une nouvelle méthode de synchronisation GPU et Moniteur Nvidia G-Sync a vraiment un effet très fort sur le confort de jeu sur PC - cette fluidité presque parfaite apparaît, ce qui n'était pas là jusqu'à présent - à notre époque de cartes vidéo surpuissantes ! Depuis l'annonce de la technologie G-Sync, les anciennes méthodes sont instantanément devenues un anachronisme, et passer à un moniteur G-Sync capable d'un taux de rafraîchissement variable jusqu'à 144 Hz semble être une option très intéressante, permettant enfin de s'en débarrasser. de problèmes, de décalages et d'artefacts.

G-Sync a-t-il des inconvénients ? Bien sûr, comme toute technologie. Par exemple, G-Sync a une limitation désagréable, à savoir qu'il fournit un affichage fluide des images à l'écran à une fréquence de 30 FPS. Et le taux de rafraîchissement sélectionné pour le moniteur en mode G-Sync définit la barre supérieure pour le taux de rafraîchissement du contenu de l'écran. C'est-à-dire qu'avec le taux de rafraîchissement défini de 60 Hz, une douceur maximale sera fournie à une fréquence de 30 à 60 FPS et à 144 Hz - de 30 à 144 FPS, mais pas moins que la limite inférieure. Et avec une fréquence variable (par exemple, de 20 à 40 FPS), le résultat ne sera plus idéal, même s'il est nettement meilleur que le V-Sync traditionnel.

Mais le plus gros inconvénient de G-Sync est qu'il s'agit de la propre technologie de Nvidia à laquelle les concurrents n'ont pas accès. Par conséquent, au début de l'année sortante, AMD a annoncé une technologie FreeSync similaire - consistant également à modifier dynamiquement la fréquence d'images du moniteur en fonction de la préparation des images du GPU. Une différence importante Le fait est que le développement d'AMD est ouvert et ne nécessite pas de solutions matérielles supplémentaires sous la forme de moniteurs spécialisés, puisque FreeSync a été converti en Adaptive-Sync, qui est devenu une partie facultative de la norme DisplayPort 1.2a du célèbre Video Electronics Standards. Association (VESA). Il s'avère qu'AMD utilisera habilement le thème développé par un concurrent à son propre profit, car sans l'apparition et la vulgarisation de G-Sync, ils n'auraient pas de FreeSync, comme on le pense.

Fait intéressant, Adaptive-Sync fait également partie de la norme DisplayPort intégrée VESA (eDP) et est déjà utilisé dans de nombreux composants d'affichage qui utilisent eDP pour la transmission du signal. Une autre différence par rapport à G-Sync est que les membres VESA peuvent utiliser Adaptive-Sync sans rien payer. Cependant, il est très probable que Nvidia prendra également en charge Adaptive-Sync à l'avenir dans le cadre de la norme DisplayPort 1.2a, car une telle prise en charge ne leur demandera pas grand-chose. Mais l'entreprise ne refusera pas non plus de G-Sync, car elle considère ses propres solutions comme une priorité.

Les premiers moniteurs avec support Adaptive-Sync devraient apparaître au premier trimestre 2015, ils auront non seulement des ports DisplayPort 1.2a, mais aussi un support spécial Adaptive-Sync (tous les moniteurs compatibles DisplayPort 1.2a ne pourront pas s'en vanter ). Ainsi, en mars 2015, Samsung prévoit de commercialiser la gamme de moniteurs Samsung UD590 (23,6 et 28 pouces) et UE850 (23,6, 27 et 31,5 pouces) prenant en charge la résolution UltraHD et la technologie Adaptive-Sync. AMD affirme que les moniteurs prenant en charge cette technologie seront jusqu'à 100 $ moins chers que les appareils similaires prenant en charge G-Sync, mais il est difficile de les comparer, car tous les moniteurs sont différents et sortent à des moments différents. De plus, il existe déjà des modèles G-Sync pas si chers sur le marché.

Différence visuelle et impressions subjectives

Ci-dessus, nous avons décrit la théorie, et maintenant il est temps de tout montrer clairement et de décrire vos sentiments. Nous avons testé la technologie Nvidia G-Sync en pratique dans plusieurs applications 3D en utilisant la carte graphique Inno3D iChill Geforce GTX 780 HerculeZ X3 Ultra et le moniteur Asus PG278Q avec la technologie G-Sync. Il existe plusieurs modèles de moniteurs prenant en charge G-Sync sur le marché de différents fabricants : Asus, Acer, BenQ, AOC et autres, et pour le moniteur du modèle Asus VG248QE, vous pouvez même acheter un kit pour le mettre à niveau pour prendre en charge G-Sync par vous-même.

La plus jeune carte graphique à utiliser la technologie G-Sync est la Geforce GTX 650 Ti, avec une exigence extrêmement importante pour un connecteur DisplayPort à bord. Parmi les autres exigences système, nous notons le système d'exploitation au moins Microsoft Windows 7, l'utilisation d'un bon câble DisplayPort 1.2 et l'utilisation d'une souris de qualité avec une sensibilité et un taux d'interrogation élevés est recommandée. La technologie G-Sync fonctionne avec toutes les applications 3D plein écran utilisant les API graphiques OpenGL et Direct3D lorsqu'elles sont lancées sur les systèmes d'exploitation Windows 7 et 8.1.

Tout pilote moderne est adapté au travail, ce qui - G-Sync est pris en charge par tous les pilotes de l'entreprise depuis plus d'un an. Si vous disposez de tous les composants requis, il vous suffit d'activer G-Sync dans les pilotes, si vous ne l'avez pas déjà fait, et la technologie fonctionnera dans toutes les applications plein écran - et uniquement dans celles-ci, sur la base du principe même de la technologie.

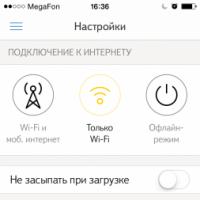

Pour activer la technologie G-Sync pour les applications plein écran et obtenir la meilleure expérience possible, vous devez activer le taux de rafraîchissement de 144 Hz dans le panneau de configuration Nvidia ou les paramètres du bureau. système opérateur... Ensuite, vous devez vous assurer que l'utilisation de la technologie est autorisée sur la page appropriée "Configurer G-Sync" ...

Et aussi - sélectionnez l'élément correspondant sur la page "Gérer les paramètres 3D" dans le paramètre "Impulsion de synchronisation verticale" des paramètres 3D globaux. Là, vous pouvez également désactiver l'utilisation de la technologie G-Sync à des fins de test ou en cas de problème (pour l'avenir - lors de nos tests, nous n'en avons trouvé aucun).

La technologie G-Sync fonctionne sur toutes les résolutions prises en charge par les moniteurs, jusqu'à l'UltraHD, mais dans notre cas nous avons utilisé la résolution native de 2560 × 1440 pixels à 144 Hz. Dans nos comparaisons avec l'état actuel des choses, nous avons utilisé un taux de rafraîchissement de 60 Hz avec G-Sync désactivé pour émuler le comportement des moniteurs non G-Sync typiques de la plupart des joueurs. La plupart d'entre eux utilisent des moniteurs Full HD capables d'un mode maximum de 60 Hz.

N'oubliez pas de mentionner que même si G-Sync est activé, le rafraîchissement de l'écran sera à la fréquence idéale - lorsque le GPU "le voudra", le mode optimal sera toujours rendu avec une fréquence d'images d'environ 40-60 FPS - c'est la fréquence d'images la plus appropriée pour les jeux modernes. Pas trop petite pour atteindre la limite inférieure de 30 FPS, mais ne nécessitant pas non plus de réglages inférieurs. Soit dit en passant, c'est exactement la fréquence à laquelle le programme Geforce Experience de Nvidia s'efforce, en fournissant les paramètres appropriés pour les jeux populaires dans le logiciel du même nom fourni avec les pilotes.

En plus des jeux, nous avons également testé une application de test spécialisée de Nvidia -. Cette application affiche une scène 3D pendulaire facile à utiliser pour évaluer la fluidité et la qualité, vous permet de simuler différentes fréquences d'images et de sélectionner le mode d'affichage : V-Sync Off / On et G-Sync. Avec ce logiciel de test, il est très facile de montrer la différence entre les différents modes de synchronisation - par exemple, entre V-Sync On et G-Sync :

L'application Pendulum Demo vous permet de tester différentes méthodes de synchronisation dans différentes conditions, elle simule une fréquence d'images précise de 60 FPS pour comparer V-Sync et G-Sync dans des conditions idéales pour l'ancienne méthode de synchronisation - dans ce mode, il ne devrait tout simplement pas y en avoir différence entre les méthodes. Mais le mode 40-50 FPS place V-Sync On dans une position inconfortable, lorsque les retards et les changements de trame non fluides sont visibles à l'œil nu, car le temps de rendu de la trame dépasse la période de rafraîchissement à 60 Hz. Lorsque vous activez G-Sync, tout devient parfait.

Lorsqu'il s'agit de comparer les modes avec V-Sync désactivé et G-Sync activé, l'application de Nvidia permet également de voir la différence ici - à des fréquences d'images comprises entre 40 et 60 FPS, les ruptures d'image sont clairement visibles, bien qu'il y ait moins de décalages qu'avec V -Sync sur. Et même une séquence vidéo non fluide concernant le mode G-Sync est perceptible, bien qu'en théorie cela ne devrait pas l'être - c'est peut-être ainsi que la perception du cerveau des images "déchirées" affecte.

Eh bien, avec G-Sync activé, l'un des modes d'application de test (fréquence d'images constante ou variable - peu importe) fournit toujours la séquence vidéo la plus fluide. Et dans les jeux, tous les problèmes de l'approche traditionnelle de mise à jour des informations sur un moniteur avec un taux de rafraîchissement fixe sont parfois encore plus perceptibles - dans ce cas, vous pouvez clairement évaluer la différence entre les trois modes en utilisant l'exemple de StarCraft II (visualisation un enregistrement précédemment sauvegardé) :

Si votre système et votre navigateur prennent en charge la lecture du format vidéo MP4 / H.264 avec une fréquence de 60 FPS, vous verrez clairement que dans le mode de synchronisation désactivé, il y a des déchirures évidentes dans l'image, lorsque V-Sync est activé, il y a des saccades et des séquences vidéo non fluides. Tout cela disparaît lorsque vous activez Nvidia G-Sync, dans lequel il n'y a pas d'artefacts dans l'image, aucune augmentation des retards ou une fréquence d'images "en lambeaux".

Bien sûr, G-Sync n'est pas une baguette magique, et cette technologie ne vous évitera pas des retards et des ralentissements causés non par le processus d'affichage des images sur un moniteur avec un taux de rafraîchissement fixe. Si le jeu lui-même a des problèmes avec la fluidité de la sortie des images et de grandes secousses dans les FPS causées par le chargement des textures, le traitement des données sur le processeur, un travail sous-optimal avec la mémoire vidéo, le manque d'optimisation du code, etc., ils resteront en place. De plus, ils deviendront encore plus visibles, car la sortie du reste des images sera parfaitement lisse. Cependant, en pratique, sur des systèmes puissants, les problèmes ne surviennent pas très souvent, et G-Sync améliore vraiment la perception des séquences dynamiques.

Étant donné que la nouvelle technologie de sortie de Nvidia affecte l'ensemble du pipeline de sortie, elle peut théoriquement provoquer des artefacts et une gigue dans les fréquences d'images, en particulier si le jeu limite artificiellement les FPS à tout moment. Probablement, de tels cas, s'il y en a, sont si rares que nous ne les avons même pas remarqués. Mais ils ont noté une nette amélioration du confort de lecture - lors de la lecture sur un moniteur avec la technologie G-Sync activée, il semble que le PC soit devenu si puissant qu'il soit capable d'une fréquence d'images constante d'au moins 60 FPS sans aucun rabattement.

La sensation que vous ressentez lorsque vous jouez avec un moniteur G-Sync est très difficile à décrire avec des mots. La différence est particulièrement visible à 40-60 FPS - la fréquence d'images très souvent trouvée dans les jeux modernes exigeants. La différence par rapport aux moniteurs conventionnels est tout simplement incroyable, et nous essaierons non seulement de la mettre en mots et de la montrer dans des exemples vidéo, mais aussi de montrer les graphiques de fréquence d'images obtenus avec différents modes d'affichage.

Dans les jeux de genres tels que la stratégie en temps réel et autres, comme StarCraft II, League of Legends, DotA 2, etc., les avantages de la technologie G-Sync sont clairement visibles, comme vous pouvez le voir dans l'exemple de la vidéo ci-dessus. . De plus, de tels jeux nécessitent toujours une action rapide qui ne tolère pas les retards et les irrégularités de la fréquence d'images, et le défilement fluide joue un rôle assez important dans le confort, ce qui est grandement entravé par la déchirure de l'image lorsque V-Sync Off, les retards et les retards lorsque V-Sync est activé. La technologie G-Sync est donc idéale pour ce type de jeux.

Les jeux de tir à la première personne comme Crysis 3 et Far Cry 4 sont encore plus courants, ils sont également très exigeants en ressources informatiques, et avec des paramètres de haute qualité, les joueurs obtiennent souvent une fréquence d'images d'environ 30-60 FPS - une option idéale pour une utilisation G-Sync, qui améliore vraiment considérablement le confort de jeu dans de telles conditions. La méthode de synchronisation verticale traditionnelle vous obligera très souvent à sortir des images à une fréquence de seulement 30 FPS, augmentant les décalages et les saccades.

Il en va à peu près de même pour les jeux à la troisième personne comme Batman, Assassin's Creed et Tomb Raider. Ces jeux utilisent également les dernières technologies graphiques et nécessitent des GPU assez puissants pour atteindre des fréquences d'images élevées. À paramètres maximum dans ces jeux et en désactivant V-Sync, des FPS de l'ordre de 30 à 90 sont souvent obtenus, ce qui provoque un déchirement désagréable de l'image. L'activation de V-Sync n'est utile que dans certaines scènes nécessitant moins de ressources, et la fréquence d'images passe de 30 à 60 étapes, ce qui provoque des ralentissements et des saccades. Et l'activation de G-Sync résout tous ces problèmes, et cela est parfaitement perceptible dans la pratique.

Résultats des tests de pratique

Dans cette section, nous examinerons l'impact de G-Sync et V-Sync sur les fréquences d'images en examinant les graphiques de performances pour vous aider à comprendre le fonctionnement des différentes technologies. Lors des tests, nous avons testé plusieurs jeux, mais il est loin d'être pratique de montrer la différence entre V-Sync et G-Sync - certains benchmarks de jeux ne permettent pas de forcer V-Sync, d'autres jeux n'ont pas d'outil pratique pour jouer au séquence de jeu exacte (la plupart des jeux modernes, malheureusement), d'autres sont exécutés sur notre système de test soit trop rapidement, soit avec des fréquences d'images étroites.

Nous avons donc opté pour Just Cause 2 avec des paramètres maximum, ainsi que quelques références : Unigine Heaven et Unigine Valley - également avec des paramètres de qualité maximum. La fréquence d'images dans ces applications varie sur une plage assez large, ce qui est pratique pour notre objectif - pour montrer ce qui arrive à la sortie des images dans différentes conditions.

Malheureusement, pour le moment, nous n'utilisons pas le système logiciel et matériel FCAT et nous ne serons pas en mesure d'afficher de vrais graphiques FPS et des vidéos enregistrées dans différents modes. Au lieu de cela, nous avons testé les fréquences d'images moyennes et instantanées par seconde à l'aide d'un utilitaire bien connu à des taux de rafraîchissement du moniteur de 60 et 120 Hz à l'aide des méthodes de rafraîchissement d'écran V-Sync On, V-Sync Off, Adaptive V-Sync et G-Sync. à 144 Hz pour montrer la différence entre la nouvelle technologie et les moniteurs 60 Hz actuels avec synchronisation verticale traditionnelle.

G-Sync vs V-Sync activé

Nous commencerons notre exploration en comparant V-Sync On à G-Sync - c'est la comparaison la plus révélatrice qui montrera la différence entre les méthodes sans déchirure. Tout d'abord, nous allons regarder l'application de test Heaven avec des paramètres de qualité maximum dans une résolution de 2560 × 1440 pixels (en cliquant sur les vignettes, des graphiques en pleine résolution s'ouvrent) :

Comme vous pouvez le voir sur le graphique, la fréquence d'images avec G-Sync activé et sans synchronisation est pratiquement la même, à l'exception d'une fréquence supérieure à 60 FPS. Mais le FPS dans le mode avec la méthode de synchronisation verticale activée est sensiblement différent, car la fréquence d'images peut être inférieure ou égale à 60 FPS et un multiple d'entiers : 1, 2, 3, 4, 5, 6 ... , car le moniteur doit parfois afficher la même image précédente pendant plusieurs périodes de mise à jour (deux, trois, quatre, etc.). C'est-à-dire les "pas" possibles de la fréquence d'images à V-Sync On et 60 Hz : 60, 30, 20, 15, 12, 10, ... FPS.

Cette irrégularité est clairement visible sur la ligne rouge du graphique - lors de l'exécution de ce test, la fréquence d'images était souvent de 20 ou 30 FPS, et beaucoup moins souvent - 60 FPS. Bien qu'avec G-Sync et V-Sync Off (No Sync), c'était souvent dans une plage plus large : 35-50 FPS. Avec V-Sync activé, un tel taux de sortie n'est pas possible, donc le moniteur affiche toujours 30 FPS dans de tels cas - limitant les performances et ajoutant des retards au temps de sortie total.

Il convient de noter que le graphique ci-dessus ne montre pas la fréquence d'images instantanée, mais des valeurs moyennes en une seconde, mais en réalité, le FPS peut "sauter" beaucoup plus - presque chaque image, ce qui provoque des irrégularités et des décalages désagréables. Afin de voir cela clairement, voici quelques graphiques avec FPS instantanés - plus précisément, avec des graphiques de temps de rendu pour chaque image en millisecondes. Premier exemple (les lignes sont quelque peu décalées les unes par rapport aux autres, seul le comportement approximatif dans chaque mode est affiché) :

Comme vous pouvez le voir, dans cet exemple, la fréquence d'images dans le cas de G-Sync change plus ou moins doucement, et avec V-Sync On - par étapes (il y a des sauts simples dans le temps de rendu dans les deux cas - c'est normal) . Avec Vsync activé, les temps de rendu et de sortie d'image peuvent être de 16,7 ms ; 33,3 ms ; 50 ms, comme le montre le graphique. En termes de FPS, cela correspond à 60, 30 et 20 images par seconde. De plus, il n'y a pas de différence particulière entre le comportement des deux lignes, il y a des pics dans les deux cas. Considérez une autre période importante :

Dans ce cas, il y a un "lancement" évident du temps de rendu des images, et avec eux le FPS dans le cas de la synchronisation verticale activée. Regardez, avec V-Sync On, il y a un changement brusque dans le temps de rendu de l'image de 16,7 ms (60 FPS) à 33,3 ms (30 FPS) et vice versa - en réalité cela provoque l'irrégularité très inconfortable et des secousses clairement visibles de la séquence vidéo. La fluidité du changement d'image dans le cas de G-Sync est beaucoup plus élevée et il sera beaucoup plus confortable de jouer dans ce mode.

Jetons un coup d'œil au graphique FPS dans la deuxième application de test - Unigine Valley :

Dans ce repère, nous marquons à peu près la même chose que dans Heaven. Les fréquences d'images dans les modes G-Sync et V-Sync Off sont presque les mêmes (à l'exception d'un pic au-dessus de 60 Hz), et lorsque V-Sync est activé, cela provoque un changement clair de FPS, affichant le plus souvent 30 FPS , tombant parfois à 20 FPS et s'élevant à 60 FPS - Comportement typique de cette méthode, provoquant un décalage, des saccades et des images non fluides.

Dans cette sous-section, il nous reste à considérer un segment du test intégré du jeu Just Cause 2: