Le meilleur processeur quad-core. En quoi un processeur dual-core diffère-t-il d'un processeur monocœur ?

Les processeurs multicœurs sont des unités centrales de traitement contenant plus de deux cœurs de traitement. Ces cœurs peuvent être situés soit dans un seul boîtier, soit sur une seule puce de processeur.

Qu'est-ce qu'un processeur multicœur ?

Le plus souvent, les processeurs multicœurs désignent des processeurs centraux dans lesquels plusieurs cœurs de calcul sont intégrés dans une seule puce (c'est-à-dire qu'ils sont situés sur une seule puce de silicium).

En règle générale, la vitesse d'horloge des processeurs multicœurs est délibérément inférieure. Ceci est fait afin de réduire la consommation d'énergie tout en maintenant les performances requises du processeur. Chaque cœur est un microprocesseur à part entière, caractérisé par les caractéristiques de tous les processeurs modernes : il utilise un cache à plusieurs niveaux, prend en charge l'exécution de code dans le désordre et les instructions vectorielles.

Hyper-Threading

Les cœurs des processeurs multicœurs peuvent prendre en charge la technologie SMT, qui vous permet d'exécuter plusieurs threads de calcul et de créer plusieurs processeurs logiques basés sur chaque cœur. Sur les processeurs produits par Intel, cette technologie est appelée « Hyper-threading ». Grâce à lui, vous pouvez doubler le nombre de processeurs logiques par rapport au nombre de puces physiques. Dans les microprocesseurs prenant en charge cette technologie, chaque processeur physique est capable de maintenir l'état de deux threads simultanément. Pour le système d’exploitation, cela ressemblera à deux processeurs logiques. S'il y a une pause dans le travail de l'un d'eux (par exemple, il attend que les données soient reçues de la mémoire), l'autre processeur logique commence à exécuter son propre thread.

Types de processeurs multicœurs

Les processeurs multicœurs sont divisés en plusieurs types. Ils peuvent ou non prendre en charge l'utilisation d'un cache partagé. La communication entre cœurs est mise en œuvre sur les principes d'utilisation d'un bus partagé, d'un réseau sur liaisons point à point, d'un réseau avec un switch ou d'un cache partagé.

Principe d'opération

La plupart des processeurs multicœurs modernes fonctionnent selon le schéma suivant. Si une application en cours d'exécution prend en charge le multithreading, elle peut forcer le processeur à effectuer plusieurs tâches en même temps. Par exemple, si l'ordinateur utilise un processeur à 4 cœurs avec une fréquence d'horloge de 1,8 GHz, le programme peut « charger » les quatre cœurs en même temps, tandis que la fréquence totale du processeur sera de 7,2 GHz. Si plusieurs programmes s'exécutent en même temps, chacun d'eux peut utiliser une partie des cœurs du processeur, ce qui entraîne également une augmentation des performances de l'ordinateur.

De nombreux systèmes d'exploitation prennent en charge le multithreading, donc l'utilisation de processeurs multicœurs peut accélérer votre ordinateur même dans les applications qui ne prennent pas en charge le multithreading. Si l'on considère le fonctionnement d'une seule application, alors l'utilisation de processeurs multicœurs ne sera justifiée que si cette application est optimisée pour le multithreading. Sinon, la vitesse d'un processeur multicœur ne sera pas différente de la vitesse d'un processeur classique, et parfois même il fonctionnera plus lentement.

...au cours du processus de développement, le nombre de cœurs augmentera de plus en plus.

(Développeurs Intel)

Plus cœur, et aussi cœur, et bien d'autres encore cœur!..

...Jusqu'à récemment, nous n'avions pas entendu parler de multicœur processeurs, et aujourd'hui, ils remplacent de manière agressive les processeurs monocœur. Le boom des processeurs multicœurs a commencé, ce qui n'est encore que modeste ! – sont freinés par leurs prix relativement élevés. Mais personne ne doute que l’avenir réside dans les processeurs multicœurs !..

Qu'est-ce qu'un cœur de processeur

Au centre d'un microprocesseur central moderne ( CPU– abbr. de l'anglais unité centrale de traitement– dispositif informatique central) est le noyau ( cœur) est un cristal de silicium d'une superficie d'environ un centimètre carré, sur lequel le schéma de circuit du processeur, appelé architecture (architecture de puce).

Le noyau est connecté au reste de la puce (appelé le « package » Paquet CPU) utilisant la technologie flip-chip ( puce à bascule, liaison par puce retournée– noyau inversé, fixation par la méthode du cristal inversé). Cette technologie tire son nom du fait que la partie du noyau tournée vers l'extérieur - visible - est en fait son "fond" - pour fournir un contact direct avec le dissipateur thermique du refroidisseur pour un meilleur transfert de chaleur. Au verso (invisible) se trouve « l’interface » elle-même – la connexion entre le cristal et l’emballage. La connexion entre le cœur du processeur et le packaging se fait à l'aide de broches pin ( Bosses de soudure).

Le noyau est situé sur une base en textolite, le long de laquelle des chemins de contact mènent aux « pattes » (plots de contact), remplis d'une interface thermique et recouverts d'un couvercle métallique de protection.

Le premier microprocesseur (bien sûr monocœur !) Intel 4004 a été introduit le 15 novembre 1971 par Intel Corporation. Il contenait 2 300 transistors, cadencés à 108 kHz, et coûtait 300 dollars.

Les exigences en matière de puissance de calcul du microprocesseur central n'ont cessé de croître et continuent de croître. Mais si les anciens fabricants de processeurs devaient constamment s'adapter aux demandes actuelles pressantes (toujours croissantes !) des utilisateurs, les fabricants de puces ont désormais une longueur d'avance !

Pendant longtemps, les améliorations des performances des processeurs monocœurs traditionnels étaient principalement dues à une augmentation constante de la fréquence d'horloge (environ 80 % des performances du processeur étaient déterminées par la fréquence d'horloge) tout en augmentant simultanément le nombre de transistors sur un seul cœur. ébrécher. Cependant, une nouvelle augmentation de la fréquence d'horloge (à une fréquence d'horloge supérieure à 3,8 GHz, les puces surchauffent tout simplement !) se heurte à un certain nombre de barrières physiques fondamentales (puisque le processus technologique s'approche presque de la taille d'un atome) : aujourd'hui, les processeurs sont produits à l'aide de la technologie 45 nm et la taille d'un atome de silicium est d'environ 0,543 nm) :

Premièrement, à mesure que la taille des cristaux diminue et que la fréquence d’horloge augmente, le courant de fuite des transistors augmente. Cela entraîne une augmentation de la consommation d'énergie et une augmentation de la production de chaleur ;

Deuxièmement, les avantages des vitesses d'horloge plus élevées sont partiellement annulés par la latence d'accès à la mémoire, car les temps d'accès à la mémoire ne suivent pas l'augmentation des vitesses d'horloge ;

Troisièmement, pour certaines applications, les architectures série traditionnelles deviennent inefficaces à mesure que les vitesses d'horloge augmentent en raison de ce que l'on appelle le « goulot d'étranglement de von Neumann », une limitation des performances résultant du flux de calcul séquentiel. Dans le même temps, les délais de transmission des signaux RC augmentent, ce qui constitue un goulot d'étranglement supplémentaire associé à une augmentation de la fréquence d'horloge.

L'utilisation de systèmes multiprocesseurs n'est pas non plus répandue, car elle nécessite des cartes mères multiprocesseurs complexes et coûteuses. Par conséquent, il a été décidé d’améliorer encore les performances des microprocesseurs par d’autres moyens. Le concept a été reconnu comme la direction la plus efficace multithreading, originaire du monde des superordinateurs, est le traitement parallèle simultané de plusieurs flux de commandes.

Alors au plus profond de l'entreprise Intel est né Technologie Hyper-Threading (HTT) est une technologie de traitement de données super-thread qui permet au processeur d'exécuter simultanément jusqu'à quatre threads de programme en parallèle sur un processeur monocœur. Hyper-Threading augmente considérablement l'efficacité de l'exécution d'applications gourmandes en ressources (par exemple, celles liées au montage audio et vidéo, 3D-simulation), ainsi que le fonctionnement de l'OS en mode multitâche.

CPU Pentium4 avec inclus Hyper-Threading en a un physique noyau divisé en deux logique, le système d'exploitation l'identifie donc comme deux processeurs différents (au lieu d'un).

Hyper-Threading est en fait devenu un tremplin vers la création de processeurs avec deux cœurs physiques sur une seule puce. Dans une puce à 2 cœurs, deux cœurs (deux processeurs !) fonctionnent en parallèle, ce qui, à une fréquence d'horloge inférieure, fournit Ô de meilleures performances, puisque deux flux d'instructions indépendants sont exécutés en parallèle (simultanément !).

La capacité d'un processeur à exécuter plusieurs threads de programme simultanément est appelée parallélisme au niveau du thread (TLP – parallélisme au niveau du thread). Besoin de TLP Cela dépend de la situation spécifique (dans certains cas, c'est tout simplement inutile !).

Les principaux problèmes de création de processeurs

Chaque cœur de processeur doit être indépendant, avec une consommation électrique indépendante et une puissance contrôlable ;

Le marché des logiciels devrait être doté de programmes capables de diviser efficacement l'algorithme de branchement des instructions en un nombre pair (pour les processeurs avec un nombre pair de cœurs) ou impair (pour les processeurs avec un nombre impair de cœurs) de threads ;

…

Selon le service de presse DMLA, aujourd'hui, le marché des processeurs à 4 cœurs ne représente plus que 2 % du volume total. De toute évidence, pour un acheteur moderne, l'achat d'un processeur à 4 cœurs pour les besoins domestiques n'a toujours pas de sens pour de nombreuses raisons. Premièrement, il n'existe aujourd'hui pratiquement aucun programme capable de tirer parti efficacement de 4 threads exécutés simultanément ; deuxièmement, les fabricants positionner les processeurs à 4 cœurs comme Salut-End-solutions en ajoutant à l'équipement les cartes vidéo les plus modernes et les gros disques durs - et cela augmente finalement le coût de déjà coûteux …

Développeurs Intel ils disent : « …au cours du processus de développement, le nombre de cœurs augmentera de plus en plus… ».

Ce qui nous attend dans le futur

Dans une société Intel ils ne parlent plus de « Multi-core » ( Multicœur) processeurs, comme cela se fait pour les solutions à 2, 4, 8, 16 ou même 32 cœurs, mais à propos du « Multi-cœur » ( Plusieurs cœurs), impliquant une toute nouvelle macrostructure architecturale de la puce, comparable (mais pas similaire) à l'architecture du processeur Cellule.

La structure d'un tel Plusieurs cœurs-chip implique de travailler avec le même ensemble d'instructions, mais en utilisant un noyau central puissant ou plusieurs puissants CPU, « entouré » de nombreux cœurs auxiliaires, qui permettront de traiter plus efficacement des applications multimédias complexes en mode multithread. En plus des cœurs « à usage général », les processeurs Intel disposera également de noyaux spécialisés pour effectuer diverses classes de tâches, telles que les graphiques, les algorithmes de reconnaissance vocale et le traitement des protocoles de communication.

C'est exactement l'architecture présentée par Justin Rattner ( Justin R. Rattner), chef de secteur Groupe technologique d'entreprise Intel, lors d'une conférence de presse à Tokyo. Selon lui, un nouveau processeur multicœur pourrait contenir plusieurs dizaines de cœurs auxiliaires de ce type. Contrairement à l'accent mis sur les grands cœurs de calcul énergivores et à forte dissipation thermique, les cristaux multicœurs Intel activera uniquement les cœurs nécessaires pour terminer la tâche en cours, tandis que les cœurs restants seront désactivés. Cela permettra au cristal de consommer exactement autant d'électricité que nécessaire à un moment donné.

En juillet 2008, la société Intel a indiqué qu'il envisageait la possibilité d'intégrer plusieurs dizaines, voire milliers de cœurs de calcul dans un seul processeur. Ingénieur principal de la société Envar Galum ( Anwar Ghuloum) a écrit sur son blog : "En fin de compte, je recommande de suivre les conseils suivants de ma part... Les développeurs devraient commencer à penser à des dizaines, des centaines et des milliers de cœurs dès maintenant." Selon lui, à l'heure actuelle Intel explore des technologies qui pourraient faire évoluer l’informatique « en fonction du nombre de cœurs que nous ne vendons pas encore ».

En fin de compte, le succès des systèmes multicœurs dépendra des développeurs, qui devront probablement changer de langage de programmation et réécrire les bibliothèques existantes, a déclaré Galum.

Au début du nouveau millénaire, lorsque les fréquences des processeurs ont finalement dépassé la barre des 1 GHz, certaines entreprises (ne pointons pas du doigt Intel) ont prédit que la nouvelle architecture NetBurst pourrait atteindre des fréquences d'environ 10 GHz à l'avenir. Les passionnés s'attendaient à l'avènement d'une nouvelle ère où la vitesse d'horloge du processeur augmenterait comme des champignons après la pluie. Besoin de plus de performances ? Passez simplement à un processeur cadencé plus rapide.

La pomme de Newton est tombée bruyamment sur la tête des rêveurs qui considéraient le mégahertz comme le moyen le plus simple de continuer à augmenter les performances de leur PC. Les limitations physiques ne permettaient pas une augmentation exponentielle de la fréquence d'horloge sans une augmentation correspondante de la génération de chaleur, et d'autres problèmes liés aux technologies de production ont également commencé à surgir. En effet, depuis quelques années les processeurs les plus rapides fonctionnent à des fréquences de 3 à 4 GHz.

Bien sûr, le progrès ne peut pas être arrêté lorsque les gens sont prêts à payer pour cela - de nombreux utilisateurs sont prêts à payer une somme considérable pour un ordinateur plus puissant. Par conséquent, les ingénieurs ont commencé à rechercher d'autres moyens d'augmenter les performances, notamment en augmentant l'efficacité de l'exécution des commandes, et pas seulement en s'appuyant sur la vitesse d'horloge. Le parallélisme s'est également avéré être une solution : si vous ne pouvez pas rendre le processeur plus rapide, alors pourquoi ne pas ajouter un deuxième processeur du même type pour augmenter les ressources informatiques ?

Le Pentium EE 840 est le premier processeur double cœur à apparaître dans le commerce.

Le principal problème de la concurrence est que le logiciel doit être spécifiquement écrit pour répartir la charge sur plusieurs threads, ce qui signifie que vous n'en aurez pas pour votre argent immédiatement, contrairement à la fréquence. Lorsque les premiers processeurs double cœur sont sortis en 2005, ils n'offraient pas beaucoup d'amélioration des performances car les ordinateurs de bureau disposaient de très peu de logiciels pour les prendre en charge. En fait, la plupart des processeurs double cœur étaient plus lents que les processeurs monocœur dans la plupart des tâches, car les processeurs monocœur fonctionnaient à des vitesses d'horloge plus élevées.

Cependant, quatre années se sont déjà écoulées et beaucoup de choses ont changé au cours de celles-ci. De nombreux développeurs de logiciels ont optimisé leurs produits pour tirer parti de plusieurs cœurs. Les processeurs monocœur sont désormais plus difficiles à trouver en vente, et les processeurs double, triple et quadricœur sont considérés comme assez courants.

Mais la question se pose : de combien de cœurs de processeur avez-vous réellement besoin ? Un processeur triple cœur est-il suffisant pour les jeux, ou vaut-il mieux payer un supplément et obtenir une puce quadricœur ? Un processeur dual-core est-il suffisant pour l'utilisateur moyen, ou est-ce que plus de cœurs font vraiment une différence ? Quelles applications sont optimisées pour plusieurs cœurs et lesquelles répondront uniquement aux changements de spécifications telles que la fréquence ou la taille du cache ?

Nous avons pensé que ce serait le bon moment pour tester les applications de la suite mise à jour (bien que la mise à jour ne soit pas encore terminée) sur des configurations monocœur, double, triple et quadricœur pour voir à quel point les processeurs multicœurs sont précieux. devenu en 2009.

Pour garantir des tests équitables, nous avons choisi un processeur quad-core : un Intel Core 2 Quad Q6600 overclocké à 2,7 GHz. Après avoir exécuté les tests sur notre système, nous avons ensuite désactivé l'un des cœurs, redémarré et répété les tests. Nous avons désactivé les cœurs séquentiellement et obtenu des résultats pour différents nombres de cœurs actifs (de un à quatre), tandis que le processeur et sa fréquence n'ont pas changé.

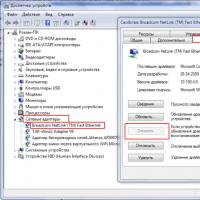

La désactivation des cœurs de processeur sous Windows est très simple à faire. Si vous voulez savoir comment procéder, tapez « msconfig » dans la fenêtre « Démarrer la recherche » de Windows Vista et appuyez sur « Entrée ». Cela ouvrira l'utilitaire de configuration du système.

Dans celui-ci, allez dans l'onglet « Démarrage » et appuyez sur le bouton « Options avancées ».

Cela fera apparaître la fenêtre Options avancées de BOOT. Cochez la case "Nombre de processeurs" et spécifiez le nombre requis de cœurs de processeur qui seront actifs dans le système. Tout est très simple.

Après confirmation, le programme vous demandera de redémarrer. Après le redémarrage, vous pouvez voir le nombre de cœurs actifs dans le Gestionnaire des tâches de Windows. Le "Gestionnaire des tâches" est appelé en appuyant sur les touches Crtl+Shift+Esc.

Sélectionnez l'onglet "Performances" dans le "Gestionnaire des tâches". Dans celui-ci, vous pouvez voir des graphiques de charge pour chaque processeur/cœur (qu'il s'agisse d'un processeur/cœur séparé ou d'un processeur virtuel, comme c'est le cas du Core i7 avec prise en charge active de l'Hyper-Threading) dans l'élément « Historique d'utilisation du processeur ». . Deux graphiques signifient deux cœurs actifs, trois à trois cœurs actifs, etc.

Maintenant que vous êtes familiarisé avec la méthodologie de nos tests, passons à un examen détaillé de la configuration de l'ordinateur et des programmes de test.

Configuration des tests

| Matériel système | |

| CPU | Intel Core 2 Quad Q6600 (Kentsfield), 2,7 GHz, FSB-1200, 8 Mo de cache L2 |

| Plate-forme | MSI P7N SLI Platine, Nvidia nForce 750i, BIOS A2 |

| Mémoire | A-Data EXTREME DDR2 800+, 2 x 2 048 Mo, DDR2-800, CL 5-5-5-18 à 1,8 V |

| Disque dur | Western Digital Caviar WD50 00AAJS-00YFA, 500 Go, 7 200 tr/min, 8 Mo de cache, SATA 3,0 Gbit/s |

| Filet | Contrôleur Ethernet Gigabit nForce 750i intégré |

| Cartes vidéo | Gigabyte GV-N250ZL-1GI 1 Go DDR3 PCIe |

| Unité de puissance | Ultra HE1000X, ATX 2.2, 1 000 W |

| Logiciels et pilotes | |

| système opérateur | Microsoft Windows Vista Intégral 64 bits 6.0.6001, SP1 |

| Version DirectX | DirectX10 |

| Pilote de plateforme | Pilote nForce version 15.25 |

| Pilote graphique | Nvidia Forceware 182.50 |

Tests et réglages

| Jeux 3D | |

| Crise | Paramètres de qualité définis sur le plus bas, Détails de l'objet sur Élevé, Physique sur Très élevé, version 1.2.1, 1 024 x 768, outil de référence, moyenne sur 3 exécutions |

| Laissé pour mort | Paramètres de qualité définis au plus bas, 1024 x 768, version 1.0.1.1, démo chronométrée. |

| Monde en conflit | Paramètres de qualité définis au plus bas, 1024 x 768, patch 1.009, benchmark intégré. |

| iTunes | Version : 8.1.0.52, CD audio ("Terminator II" SE), 53 min., Format par défaut AAC |

| Boiteux MP3 | Version : 3.98 (64 bits), CD audio ""Terminator II" SE, 53 min, wave to MP3, 160 Kb/s |

| TMPEG4.6 | Version : 4.6.3.268, fichier d'importation : DVD SE "Terminator II" (5 minutes), résolution : 720x576 (PAL) 16:9 |

| DivX 6.8.5 | Mode d'encodage : qualité insensée, multithreading amélioré, activé via SSE4, recherche par quart de pixel |

| XVID 1.2.1 | Afficher l'état d'encodage=off |

| Référence du concept principal 1.6.1 | MPEG2 vers MPEG2 (H.264), codec MainConcept H.264/AVC, 28 secondes HDTV 1920 x 1080 (MPEG2), audio : MPEG2 (44,1 KHz, 2 canaux, 16 bits, 224 Kb/s), mode : PAL (25 FPS), Profil : Paramètres matériels de Tom pour Qct-Core |

| Autodesk 3D Studio Max 2009 (64 bits) | Version : 2009, rendu de l'image Dragon à 1 920 x 1 080 (HDTV) |

| Adobe Photoshop CS3 | Version : 10.0x20070321, filtrage à partir d'une photo TIF de 69 Mo, référence : Tomshardware-Benchmark V1.0.0.4, filtres : hachures, verre, Sumi-e, bords accentués, traits inclinés, traits pulvérisés |

| Grisoft AVG Antivirus 8 | Version : 8.0.134, Base de virus : 270.4.5/1533, Benchmark : Analyser un dossier de 334 Mo de fichiers compressés ZIP/RAR |

| WinRAR 3.80 | Version 3.80, Benchmark : THG-Workload (334 Mo) |

| WinZip12 | Version 12, Compression=Meilleure, Benchmark : THG-Workload (334 Mo) |

| Vue 3DMark | Version : 1.02, scores GPU et CPU |

| PCMark Vantage | Version : 1.00, Système, Mémoire, benchmarks sur disque dur, Windows Media Player 10.00.00.3646 |

| SiSoftware Sandra 2009 SP3 | Test CPU = Arithmétique CPU/Multimédia, Test mémoire = Benchmark de bande passante |

Résultats de test

Commençons par les résultats des tests synthétiques, afin de pouvoir ensuite évaluer dans quelle mesure ils correspondent aux tests réels. Il est important de se rappeler que les tests synthétiques sont écrits en pensant à l’avenir, ils devraient donc être plus réactifs aux changements du nombre de cœurs que les applications réelles.

Nous commencerons par le test de performances de jeu synthétique 3DMark Vantage. Nous avons choisi l'exécution "Entrée", que 3DMark exécute à la résolution disponible la plus basse afin que les performances du processeur aient un plus grand impact sur les résultats.

La croissance presque linéaire est assez intéressante. L'augmentation la plus importante est observée lors du passage d'un cœur à deux, mais même dans ce cas, l'évolutivité est tout à fait perceptible. Passons maintenant au test PCMark Vantage, conçu pour montrer les performances globales du système.

Les résultats de PCMark suggèrent que l'utilisateur final bénéficiera d'une augmentation du nombre de cœurs de processeur à trois, et que le quatrième cœur, au contraire, réduira légèrement les performances. Voyons ce qui cause ce résultat.

Dans le test du sous-système de mémoire, nous constatons à nouveau la plus forte augmentation des performances lors du passage d'un cœur de processeur à deux.

Le test de productivité, nous semble-t-il, a le plus grand impact sur le résultat global du test PCMark, puisque dans ce cas l'augmentation des performances se termine à trois cœurs. Voyons si les résultats d'un autre test synthétique, SiSoft Sandra, sont similaires.

Nous commencerons par les tests arithmétiques et multimédia de SiSoft Sandra.

Les tests synthétiques démontrent une augmentation assez linéaire des performances lors du passage d'un cœur de processeur à quatre. Ce test est spécifiquement écrit pour utiliser efficacement quatre cœurs, mais nous doutons que les applications du monde réel connaissent la même progression linéaire.

Le test de mémoire Sandra suggère également que trois cœurs donneront plus de bande passante mémoire dans les opérations iSSE2 avec tampon d'entiers.

Après les tests synthétiques, il est temps de voir ce que nous obtenons dans les tests d'application.

L'encodage audio est traditionnellement un segment dans lequel les applications ne bénéficient pas grandement de plusieurs cœurs ou n'étaient pas optimisées par les développeurs. Vous trouverez ci-dessous les résultats de Lame et iTunes.

Lame ne présente pas beaucoup d'avantages lors de l'utilisation de plusieurs cœurs. Fait intéressant, nous constatons une légère augmentation des performances avec un nombre pair de cœurs, ce qui est assez étrange. Cependant, la différence est faible et peut donc simplement se situer dans la marge d’erreur.

Quant à iTunes, nous constatons une légère amélioration des performances après l'activation de deux cœurs, mais plus de cœurs ne font rien.

Il s'avère que ni Lame ni iTunes ne sont optimisés pour plusieurs cœurs de processeur pour l'encodage audio. D'un autre côté, à notre connaissance, les programmes d'encodage vidéo sont souvent hautement optimisés pour plusieurs cœurs en raison de leur nature intrinsèquement parallèle. Regardons les résultats de l'encodage vidéo.

Nous commencerons nos tests d'encodage vidéo avec la référence MainConcept.

Remarquez à quel point l'augmentation du nombre de cœurs a un impact sur le résultat : le temps d'encodage passe de neuf minutes sur un processeur Core 2 monocœur à 2,7 GHz à seulement deux minutes et 30 secondes lorsque les quatre cœurs sont actifs. Il est bien clair que si vous transcodez souvent des vidéos, il est préférable de prendre un processeur à quatre cœurs.

Verrons-nous des avantages similaires dans les tests TMPGEnc ?

Ici vous pouvez voir l'impact sur la sortie de l'encodeur. Bien que l'encodeur DivX soit hautement optimisé pour plusieurs cœurs de processeur, Xvid ne présente pas un avantage aussi notable. Cependant, même Xvid réduit le temps d'encodage de 25 % lors du passage d'un cœur à deux.

Commençons les tests graphiques avec Adobe Photoshop.

Comme vous pouvez le constater, la version CS3 ne remarque pas l'ajout de noyaux. Un résultat étrange pour un programme aussi populaire, même si nous admettons que nous n'utilisions pas la dernière version de Photoshop CS4. Les résultats de CS3 ne sont toujours pas inspirants.

Jetons un coup d'œil aux résultats du rendu 3D dans Autodesk 3ds Max.

Il est bien évident qu'Autodesk 3ds Max « adore » les cœurs supplémentaires. Cette fonctionnalité était présente dans 3ds Max même lorsque le programme s'exécutait dans un environnement DOS, car la tâche de rendu 3D prenait si longtemps qu'il était nécessaire de la répartir sur plusieurs ordinateurs du réseau. Encore une fois, pour de tels programmes, il est hautement souhaitable d'utiliser des processeurs quadricœurs.

Le test d’analyse antivirus est très proche des conditions réelles puisque presque tout le monde utilise un logiciel antivirus.

L'antivirus AVG démontre une merveilleuse augmentation des performances avec l'augmentation des cœurs de processeur. Lors d'une analyse antivirus, les performances de l'ordinateur peuvent chuter considérablement et les résultats montrent clairement que plusieurs cœurs réduisent considérablement le temps d'analyse.

WinZip et WinRAR n'offrent pas de gains notables sur plusieurs cœurs. WinRAR démontre une augmentation des performances sur deux cœurs, mais sans plus. Il sera intéressant de voir comment fonctionne la version 3.90 qui vient de sortir.

En 2005, lorsque les ordinateurs de bureau double cœur ont commencé à apparaître, aucun jeu n'affichait tout simplement des gains de performances lors du passage des processeurs monocœur aux processeurs multicœurs. Mais les temps ont changé. Comment plusieurs cœurs de processeur affectent-ils les jeux modernes ? Lançons quelques jeux populaires et voyons. Nous avons effectué nos tests de jeu avec une faible résolution de 1024 x 768 et avec un faible niveau de détails graphiques pour minimiser l'impact de la carte graphique et déterminer dans quelle mesure les performances du processeur sont affectées par ces jeux.

Commençons par Crysis. Nous avons réduit toutes les options au minimum, à l'exception du détail des objets, que nous avons réglé sur "Élevé", ainsi que de la Physique, que nous avons réglé sur "Très élevé". En conséquence, les performances du jeu devraient dépendre davantage du processeur.

Crysis a montré une dépendance impressionnante au nombre de cœurs du processeur, ce qui est assez surprenant puisque nous pensions qu'il répondait davantage aux performances de la carte vidéo. Dans tous les cas, vous pouvez voir que dans Crysis, les processeurs monocœur donnent des fréquences d'images deux fois moins élevées qu'avec quatre cœurs (cependant, rappelez-vous que si le jeu dépend davantage des performances de la carte vidéo, alors la répartition des résultats avec des nombres différents des cœurs de processeur seront plus petits). Il est également intéressant de noter que Crysis ne peut utiliser que trois cœurs, car en ajouter un quatrième ne fait pas de différence notable.

Mais nous savons que Crysis utilise les calculs physiques au sérieux, voyons donc quelle serait la situation dans un jeu avec une physique moins avancée. Par exemple, dans Left 4 Dead.

Fait intéressant, Left 4 Dead montre un résultat similaire, bien que la part du lion de l'augmentation des performances vienne après l'ajout d'un deuxième cœur. Il y a une légère augmentation lors du passage à trois cœurs, mais ce jeu ne nécessite pas de quatrième cœur. Tendance intéressante. Voyons à quel point ce sera typique pour la stratégie en temps réel World in Conflict.

Les résultats sont encore une fois similaires, mais nous constatons une caractéristique surprenante : trois cœurs de processeur offrent des performances légèrement meilleures que quatre. La différence est proche de la marge d'erreur, mais cela confirme encore une fois que le quatrième cœur n'est pas utilisé dans les jeux.

Il est temps de tirer des conclusions. Puisque nous avons reçu beaucoup de données, simplifions la situation en calculant l'augmentation moyenne des performances.

Tout d'abord, je voudrais dire que les résultats des tests synthétiques sont trop optimistes lorsque l'on compare l'utilisation de plusieurs cœurs avec des applications réelles. Le gain de performances pour les tests synthétiques lors du passage d'un cœur à plusieurs semble presque linéaire, chaque nouveau cœur ajoutant 50 % de performances.

Dans les applications, nous constatons des progrès plus réalistes : une augmentation d'environ 35 % par rapport au deuxième cœur de processeur, une augmentation de 15 % par rapport au troisième et une augmentation de 32 % par rapport au quatrième. Il est étrange que lorsque nous ajoutons un troisième cœur, nous n'obtenons que la moitié du bénéfice offert par le quatrième cœur.

Toutefois, dans les applications, il est préférable d’examiner les programmes individuels plutôt que le résultat global. En effet, les applications d’encodage audio, par exemple, ne bénéficient pas du tout de l’augmentation du nombre de cœurs. D'un autre côté, les applications d'encodage vidéo bénéficient grandement d'un plus grand nombre de cœurs de processeur, bien que cela dépende beaucoup de l'encodeur utilisé. Dans le cas du programme de rendu 3D 3ds Max, on constate qu'il est fortement optimisé pour les environnements multicœurs, et les applications de retouche photo 2D comme Photoshop ne répondent pas au nombre de cœurs. L'antivirus AVG a montré une augmentation significative des performances sur plusieurs cœurs, mais le gain sur les utilitaires de compression de fichiers n'est pas si important.

Quant aux jeux, en passant d'un cœur à deux, les performances augmentent de 60 %, et après avoir ajouté un troisième cœur au système, nous obtenons un écart supplémentaire de 25 %. Le quatrième noyau n'apporte aucun avantage dans les jeux que nous avons sélectionnés. Bien sûr, si nous nous occupions de plus de jeux, la situation pourrait changer, mais dans tous les cas, les processeurs triple cœur Phenom II X3 semblent être un choix très attractif et peu coûteux pour un joueur. Il est important de noter qu'à mesure que vous passez à des résolutions plus élevées et ajoutez des détails visuels, la différence due au nombre de cœurs sera moindre, car la carte graphique deviendra le facteur décisif dans les fréquences d'images.

Quatre noyaux.

Tout cela étant dit et fait, un certain nombre de conclusions peuvent être tirées. Dans l’ensemble, vous n’avez pas besoin d’être un utilisateur professionnel pour bénéficier de l’installation d’un processeur multicœur. La situation a considérablement changé par rapport à ce qu’elle était il y a quatre ans. Bien sûr, la différence ne semble pas si significative à première vue, mais il est assez intéressant de constater à quel point les applications ont été optimisées pour le multithreading au cours des dernières années, en particulier les programmes qui peuvent apporter des gains de performances significatifs grâce à cette optimisation. En fait, on peut dire qu'aujourd'hui cela ne sert à rien de recommander des CPU monocœur (si on peut encore en trouver), à l'exception des solutions basse consommation.

De plus, il existe des applications pour lesquelles il est conseillé aux utilisateurs d'acheter des processeurs avec autant de cœurs que possible. Parmi eux, on note des programmes d'encodage vidéo, de rendu 3D et des applications de travail optimisées, dont des logiciels antivirus. Quant aux joueurs, l’époque où un processeur monocœur doté d’une carte graphique puissante suffisait est révolue.

Le module de recherche n'est pas installé.

Single core ou dual core ?

Victor Kuts

L'événement récent le plus important dans le domaine des microprocesseurs a été la généralisation des processeurs équipés de deux cœurs de calcul. La transition vers une architecture dual-core est due au fait que les méthodes traditionnelles pour augmenter les performances des processeurs se sont complètement épuisées - le processus d'augmentation de leurs fréquences d'horloge s'est récemment arrêté.

Par exemple, au cours de la dernière année avant l'avènement des processeurs dual-core, Intel a pu augmenter les fréquences de ses processeurs de 400 MHz, et AMD encore moins - de seulement 200 MHz. D'autres méthodes d'amélioration des performances, telles que l'augmentation de la vitesse du bus et de la taille du cache, ont également perdu leur efficacité d'antan. Ainsi, l'introduction de processeurs dual-core, qui possèdent deux cœurs de processeur dans une seule puce et partagent la charge, s'avère désormais être l'étape la plus logique sur le chemin complexe et épineux de l'augmentation des performances des ordinateurs modernes.

Qu'est-ce qu'un processeur dual-core ? En principe, un processeur double cœur est un système SMP (Symmetric MultiProcessing ; terme désignant un système avec plusieurs processeurs égaux) et n'est essentiellement pas différent d'un système double processeur ordinaire composé de deux processeurs indépendants. De cette façon, nous bénéficions de tous les avantages des systèmes à double processeur sans avoir besoin de cartes mères à double processeur complexes et très coûteuses.

Avant cela, Intel avait déjà tenté de paralléliser les instructions en cours d'exécution - nous parlons de la technologie HyperThreading, qui assure la division des ressources d'un processeur « physique » (cache, pipeline, unités d'exécution) entre deux processeurs « virtuels » . Le gain de performances (dans les applications individuelles optimisées pour HyperThreading) était d'environ 10 à 20 %. Alors qu'un processeur dual-core à part entière, qui comprend deux cœurs physiques « honnêtes », offre une augmentation des performances du système de 80 à 90 % et même plus (naturellement, avec la pleine utilisation des capacités de ses deux cœurs).

Le principal initiateur de la promotion des processeurs dual-core a été AMD, qui a lancé début 2005 le premier processeur pour serveur Opteron dual-core. En ce qui concerne les processeurs de bureau, Intel a pris l'initiative en annonçant les processeurs Intel Pentium D et Intel Extreme Edition à peu près au même moment. Certes, l'annonce d'une gamme similaire de processeurs Athlon64 X2 produits par AMD n'a eu lieu que quelques jours en retard.

Processeurs Intel double cœur

Les premiers processeurs Intel Pentium D 8xx double cœur étaient basés sur le cœur Smithfield, qui n'est rien de plus que deux cœurs Prescott combinés sur une seule puce semi-conductrice. Il y a également un arbitre qui surveille l'état du bus système et aide à en diviser l'accès entre les cœurs, chacun possédant son propre cache de deuxième niveau de 1 Mo. La taille d'un tel cristal, fabriqué à l'aide d'un procédé technologique de 90 nm, atteignait 206 mètres carrés. mm, et le nombre de transistors approche les 230 millions.

Pour les utilisateurs avancés et les passionnés, Intel propose des processeurs Pentium Extreme Edition, qui diffèrent du Pentium D en prenant en charge la technologie HyperThreading (et un multiplicateur déverrouillé), grâce à quoi ils sont détectés par le système d'exploitation comme quatre processeurs logiques. Toutes les autres fonctions et technologies des deux processeurs sont complètement identiques. Parmi eux figurent la prise en charge du jeu d'instructions EM64T 64 bits (x86-64), les technologies d'économie d'énergie EIST (Enhanced Intel SpeedStep), C1E (Enhanced Halt State) et TM2 (Thermal Monitor 2), ainsi que les informations sur les bits NX. fonction de protection. Ainsi, la différence de prix considérable entre les processeurs Pentium D et Pentium EE est largement artificielle.

En ce qui concerne la compatibilité, les processeurs basés sur le cœur Smithfield peuvent potentiellement être installés sur n'importe quelle carte mère LGA775, à condition qu'ils répondent aux exigences d'Intel concernant le module d'alimentation de la carte.

Mais la première crêpe, comme d'habitude, a été un désastre - dans de nombreuses applications (dont la plupart ne sont pas optimisées pour le multi-threading), non seulement les processeurs Pentium D double cœur n'ont pas surpassé les processeurs Prescott monocœur fonctionnant à la même fréquence d'horloge. , mais parfois même perdu contre eux. Évidemment, le problème réside dans l'interaction des cœurs via le bus processeur Quad Pumped Bus (lors du développement du cœur Prescott, aucune disposition n'a été prise pour faire évoluer ses performances en augmentant le nombre de cœurs).

Pour éliminer les défauts de la première génération de processeurs Intel dual-core, des processeurs basés sur le cœur Presler 65 nm (deux cœurs Cedar Mill distincts situés sur le même substrat), apparus au tout début de cette année, ont été sollicités. . Un procédé technique plus « fin » a permis de réduire la surface des cœurs et leur consommation électrique, ainsi que d'augmenter les fréquences d'horloge. Les processeurs dual-core basés sur le cœur Presler étaient appelés Pentium D avec les index 9xx. Si l'on compare les processeurs des séries Pentium D 800 et 900, en plus d'une réduction notable de la consommation électrique, les nouveaux processeurs ont doublé le cache de deuxième niveau (2 Mo par cœur au lieu de 1 Mo) et la prise en charge de la technologie de virtualisation prometteuse de Vanderpool ( Technologie de virtualisation Intel). De plus, le processeur Pentium Extreme Edition 955 a été lancé avec la technologie HyperThreading activée et fonctionnant à une fréquence de bus système de 1 066 MHz.

Officiellement, les processeurs basés sur le cœur Presler avec une fréquence de bus de 1066 MHz ne sont compatibles qu'avec les cartes mères basées sur les chipsets des séries i965 et i975X, tandis que le Pentium D à 800 MHz fonctionnera dans la plupart des cas sur toutes les cartes mères prenant en charge ce bus. Mais, encore une fois, la question se pose de l'alimentation électrique de ces processeurs : le package thermique des Pentium EE et Pentium D, à l'exception du modèle plus jeune, est de 130 W, soit près d'un tiers de plus que celui du Pentium 4. Selon Intel lui-même, un fonctionnement stable d'un système dual-core n'est possible qu'en utilisant des alimentations d'une puissance d'au moins 400 W.

Les processeurs dual-core de bureau modernes les plus efficaces d'Intel sont, sans aucun doute, Intel Core 2 Duo et Core 2 eXtreme (conroe core). Leur architecture développe les principes de base de l'architecture de la famille P6, cependant, le nombre d'innovations fondamentales est si important qu'il est temps de parler de la nouvelle 8ème génération d'architecture de processeur (P8) d'Intel. Malgré la fréquence d'horloge inférieure, ils surpassent sensiblement la famille de processeurs P7 (NetBurst) en termes de performances dans la grande majorité des applications - principalement en raison d'une augmentation du nombre d'opérations effectuées à chaque cycle d'horloge, ainsi qu'en réduisant les pertes dues à la grande longueur du pipeline P7.

Les processeurs de bureau de la gamme Core 2 Duo sont disponibles en plusieurs versions :

- Série E4xxx - FSB 800 MHz, 2 Mo de cache L2 commun aux deux cœurs ;

- Série E6xxx - FSB 1066 MHz, taille de cache 2 ou 4 Mo ;

- Série X6xxx (eXtreme Edition) - FSB 1066 MHz, taille du cache 4 Mo.

La lettre code "E" indique la plage de consommation électrique de 55 à 75 watts, "X" - supérieure à 75 watts. Le Core 2 eXtreme ne diffère du Core 2 Duo que par sa fréquence d'horloge accrue.

Tous les processeurs Conroe utilisent un bus Quad Pumped bien développé et un socket LGA775. Ce qui ne signifie toutefois pas une compatibilité avec les anciennes cartes mères. En plus de prendre en charge des vitesses d'horloge de 1 067 MHz, les cartes mères des nouveaux processeurs doivent inclure un nouveau module de régulation de tension (VRM 11). Ces exigences sont principalement satisfaites par les versions mises à jour des cartes mères basées sur les chipsets Intel des séries 975 et 965, ainsi que par NVIDIA nForce 5xx Intel Edition et ATI Xpress 3200 Intel Edition.

Au cours des deux prochaines années, les processeurs Intel de toutes classes (mobiles, ordinateurs de bureau et serveurs) seront basés sur l'architecture Intel Core, et le développement principal ira dans le sens d'augmenter le nombre de cœurs sur une puce et d'améliorer leurs interfaces externes. . En particulier, pour le marché des ordinateurs de bureau, ce processeur sera Kentsfield, le premier processeur quadricœur d'Intel destiné au segment des PC de bureau hautes performances.

Processeurs AMD double cœur

La gamme de processeurs double cœur AMD Athlon 64 X2 utilise deux cœurs (Toledo et Manchester) à l'intérieur d'une seule puce, fabriqués à l'aide d'une technologie de processus 90 nm utilisant la technologie SOI. Chacun des cœurs Athlon 64 X2 possède son propre ensemble d'actionneurs et un cache dédié de deuxième niveau ; ils partagent un contrôleur de mémoire et un contrôleur de bus HyperTransport. Les différences entre les cœurs résident dans la taille du cache de deuxième niveau : Toledo dispose d'un cache L2 de 1 Mo par cœur, tandis que Manchester a la moitié de ce chiffre (512 Ko chacun). Tous les processeurs disposent d'un cache L1 de 128 Ko et leur dissipation thermique maximale ne dépasse pas 110 W. Le noyau de Toledo se compose d'environ 233,2 millions de transistors et a une superficie d'environ 199 mètres carrés. mm. La zone centrale de Manchester est nettement plus petite : 147 mètres carrés. mm., le nombre de transistors est de 157 millions.

Processeurs Athlon64 X2 double cœur hérités de la prise en charge d'Athlon64 pour la technologie d'économie d'énergie Cool`n`Quiet, un ensemble d'extensions AMD64 64 bits, SSE - SSE3 et la fonction de protection des informations NX-bit.

Contrairement aux processeurs Intel dual-core qui fonctionnent uniquement avec la mémoire DDR2, l'Athlon64 X2 est capable de fonctionner à la fois avec la mémoire DDR400 (Socket 939), qui offre une bande passante maximale de 6,4 Go/s, et la DDR2-800 (Socket AM2), dont le débit maximal est de 12,8 Go/s.

Sur toutes les cartes mères assez modernes, les processeurs Athlon64 X2 fonctionnent sans aucun problème - contrairement à l'Intel Pentium D, ils n'imposent aucune exigence particulière sur la conception du module d'alimentation de la carte mère.

Jusqu'à tout récemment, l'AMD Athlon64 X2 était considéré comme le plus productif parmi les processeurs de bureau, mais avec la sortie d'Intel Core 2 Duo, la situation a radicalement changé - ces derniers sont devenus les leaders incontestés, notamment dans les applications de jeux et multimédia. De plus, les nouveaux processeurs Intel ont une consommation d'énergie inférieure et des mécanismes de gestion de l'énergie beaucoup plus efficaces.

AMD n'était pas satisfait de cet état de fait et en réponse, il a annoncé la sortie mi-2007 d'un nouveau processeur à 4 cœurs avec une microarchitecture améliorée, connu sous le nom de K8L. Tous ses cœurs auront des caches L2 séparés de 512 Ko chacun et un cache commun de niveau 3 de 2 Mo (dans les versions ultérieures du processeur, le cache L3 peut être augmenté). L'architecture prometteuse AMD K8L sera abordée plus en détail dans l'un des prochains numéros de notre magazine.

Un noyau ou deux ?

Même un rapide coup d'œil sur l'état actuel du marché des processeurs de bureau indique que l'ère des processeurs monocœurs appartient progressivement au passé - les deux principaux fabricants mondiaux se sont tournés vers la production de processeurs principalement multicœurs. Cependant, le logiciel, comme cela s'est produit à plusieurs reprises auparavant, est toujours en retard par rapport au niveau de développement du matériel. En effet, afin d'utiliser pleinement les capacités de plusieurs cœurs de processeur, le logiciel doit être capable de se « diviser » en plusieurs threads parallèles traités simultanément. Ce n'est qu'avec cette approche qu'il devient possible de répartir la charge sur tous les cœurs de calcul disponibles, réduisant ainsi le temps de calcul plus qu'on ne pourrait le faire en augmentant la fréquence d'horloge. Alors que la grande majorité des programmes modernes ne sont pas capables d'utiliser toutes les capacités offertes par les processeurs dual-core ou, surtout, multi-core.

Quels types d'applications utilisateur peuvent être parallélisés le plus efficacement, c'est-à-dire sans traitement spécial du code du programme, ils vous permettent de sélectionner plusieurs tâches (threads de programme) qui peuvent être exécutées en parallèle et, ainsi, de charger plusieurs cœurs de processeur avec du travail à une fois? Après tout, seules ces applications offrent une augmentation notable des performances grâce à l'introduction de processeurs multicœurs.

Les plus grands avantages du multitraitement proviennent d'applications qui permettent initialement une parallélisation naturelle des calculs avec partage de données, par exemple des progiciels de rendu informatique réalistes - 3DMax, etc. Vous pouvez également vous attendre à de bons gains de performances grâce au multitraitement dans les applications qui encodent des fichiers multimédias (audio et vidéo) d'un format à un autre. De plus, les tâches d'édition d'images 2D dans les éditeurs graphiques comme le populaire Photoshop se prêtent bien à la parallélisation.

Ce n'est pas pour rien que les applications de toutes les catégories listées ci-dessus sont largement utilisées dans les tests lorsqu'elles veulent montrer les avantages du multitraitement virtuel Hyper-Threading. Et il n'y a rien à dire sur le véritable multitraitement.

Mais dans les applications de jeux 3D modernes, il ne faut pas s'attendre à une augmentation significative de la vitesse de la part de plusieurs processeurs. Pourquoi? Parce qu’un jeu informatique typique ne peut pas être facilement parallélisé en deux ou plusieurs processus. Par conséquent, le deuxième processeur logique n'effectuera, au mieux, que des tâches auxiliaires, ce qui n'apportera pratiquement aucun gain de performances. Et développer une version multithread d'un jeu dès le début est assez complexe et nécessite un travail considérable - parfois bien plus que la création d'une version monothread. Ces coûts de main-d'œuvre ne sont d'ailleurs peut-être pas encore rentables d'un point de vue économique. Après tout, les fabricants de jeux informatiques se concentrent traditionnellement sur la partie la plus répandue des utilisateurs et ne commencent à utiliser les nouvelles capacités du matériel informatique que si elles sont répandues. Cela se voit clairement dans l'utilisation des capacités des cartes vidéo par les développeurs de jeux. Par exemple, après l'apparition de nouvelles puces vidéo prenant en charge les technologies de shader, les développeurs de jeux les ont longtemps ignorés, se concentrant sur les capacités de solutions de masse simplifiées. Ainsi, même les joueurs avancés qui ont acheté les cartes vidéo les plus « sophistiquées » de ces années n’ont jamais reçu de jeux normaux utilisant toutes leurs capacités. Une situation à peu près similaire avec les processeurs dual-core est observée aujourd'hui. Aujourd'hui, peu de jeux utilisent réellement la technologie HyperThreading, malgré le fait que les processeurs de masse qui la supportent sont en pleine production depuis plusieurs années maintenant.

Dans les applications bureautiques, la situation n'est pas aussi claire. Tout d'abord, les programmes de cette classe fonctionnent rarement seuls - une situation beaucoup plus courante est celle où plusieurs applications bureautiques exécutées en parallèle s'exécutent sur l'ordinateur. Par exemple, un utilisateur travaille avec un éditeur de texte, et en même temps un site Web se charge dans le navigateur, et une recherche de virus est effectuée en arrière-plan. De toute évidence, avoir plusieurs applications en cours d’exécution vous permet d’utiliser facilement plusieurs processeurs et d’obtenir une amélioration des performances. De plus, toutes les versions de Windows XP, y compris Home Edition (qui s'est initialement vu refuser la prise en charge des processeurs multicœurs), sont déjà capables de tirer parti des processeurs double cœur en répartissant les threads de programme entre eux. Assurant ainsi une grande efficacité dans l’exécution de nombreux programmes d’arrière-plan.

Ainsi, on peut s'attendre à un certain effet même des applications bureautiques non optimisées si elles sont exécutées en parallèle, mais il est difficile de comprendre si une telle augmentation des performances vaut l'augmentation significative du coût d'un processeur dual-core. De plus, un certain inconvénient des processeurs dual-core (en particulier les processeurs Intel Pentium D) est que les applications dont les performances sont limitées non pas par la puissance de traitement du processeur lui-même, mais par la vitesse d'accès à la mémoire, peuvent ne pas bénéficier autant de ayant plusieurs cœurs.

Conclusion

Il ne fait aucun doute que l'avenir appartient définitivement aux processeurs multicœurs, mais aujourd'hui, alors que la plupart des logiciels existants ne sont pas optimisés pour les nouveaux processeurs, leurs avantages ne sont pas aussi évidents que les fabricants tentent de le montrer dans leurs supports promotionnels. Oui, un peu plus tard, lorsqu'il y aura une forte augmentation du nombre d'applications prenant en charge les processeurs multicœurs (cela concerne principalement les jeux 3D, dans lesquels les CPU de nouvelle génération contribueront à soulager considérablement le système graphique), leur achat sera conseillé, mais maintenant... On sait depuis longtemps qu'acheter des processeurs « pour la croissance » est loin d'être l'investissement le plus efficace.

D’un autre côté, les progrès sont rapides et, pour une personne normale, changer d’ordinateur chaque année est peut-être excessif. Ainsi, tous les propriétaires de systèmes assez modernes basés sur des processeurs monocœur ne devraient pas trop s'inquiéter dans un avenir proche - vos systèmes seront encore « au pair » pendant un certain temps, tandis que pour ceux qui envisagent d'acheter un nouvel ordinateur, nous recommanderait toujours son attention aux modèles bas de gamme relativement peu coûteux de processeurs dual-core.

|

Lorsque vous achetez un nouvel ordinateur portable ou construisez un ordinateur, le processeur est la décision la plus importante. Mais il existe beaucoup de jargon, notamment concernant les noyaux. Quel processeur choisir : dual-core, quad-core, six-core ou huit-core. Lisez l'article pour comprendre ce que cela signifie réellement.

Dual core ou quad core, le plus simple possible

Restons simple. Voici tout ce que vous devez savoir :

- Il n'y a qu'une seule puce processeur. Cette puce peut avoir un, deux, quatre, six ou huit cœurs.

- Actuellement, un processeur à 18 cœurs est le meilleur que vous puissiez obtenir sur les PC grand public.

- Chaque « cœur » est la partie de la puce qui effectue le traitement. Essentiellement, chaque cœur est une unité centrale de traitement (CPU).

Vitesse

Désormais, une logique simple veut que plus de cœurs rendent votre processeur globalement plus rapide. Mais ce n'est pas toujours le cas. C'est un peu plus compliqué.

Plus de cœurs ne donnent plus de vitesse que si un programme peut diviser ses tâches entre les cœurs. Tous les programmes ne sont pas conçus pour répartir les tâches entre les cœurs. Nous en reparlerons plus tard.

La vitesse d'horloge de chaque cœur est également un facteur de vitesse décisif, tout comme l'architecture. Un processeur double cœur plus récent avec une vitesse d'horloge plus élevée surpassera souvent un ancien processeur quadricœur avec une vitesse d'horloge inférieure.

Consommation d'énergie

Un plus grand nombre de cœurs entraîne également une consommation d'énergie du processeur plus élevée. Lorsque le processeur est allumé, il alimente tous les cœurs, pas seulement ceux impliqués.

Les fabricants de puces tentent de réduire la consommation d’énergie et de rendre les processeurs plus économes en énergie. Mais la règle générale est qu'un processeur quadricœur consommera plus d'énergie de votre ordinateur portable qu'un processeur double cœur (et videra donc la batterie plus rapidement).

Dégagement de chaleur

Chaque cœur affecte la chaleur générée par le processeur. Encore une fois, en règle générale, un plus grand nombre de noyaux entraîne des températures plus élevées.

En raison de cette chaleur supplémentaire, les fabricants doivent ajouter de meilleurs radiateurs ou d'autres solutions de refroidissement.

Prix

Plus de cœurs ne signifient pas toujours un prix plus élevé. Comme nous l'avons dit plus tôt, la vitesse d'horloge, les versions architecturales et d'autres considérations entrent en jeu.

Mais si tous les autres facteurs sont égaux, un plus grand nombre de cœurs atteindra un prix plus élevé.

Tout sur le logiciel

Voici un petit secret que les fabricants de processeurs ne veulent pas que vous sachiez. Il ne s'agit pas du nombre de cœurs que vous utilisez, mais du logiciel que vous exécutez dessus.

Les programmes doivent être spécifiquement conçus pour tirer parti de plusieurs processeurs. Ce type de « logiciel multithreading » n’est pas aussi courant qu’on pourrait le penser.

Il est important de noter que même s’il s’agit d’un programme multithread, la raison pour laquelle il est utilisé est également importante. Par exemple, le navigateur Web Google Chrome prend en charge plusieurs processus, ainsi que le logiciel de montage vidéo Adobe Premier Pro.

Adobe Premier Pro propose différents moteurs pour travailler sur différents aspects de votre édition. Compte tenu des nombreuses couches impliquées dans le montage vidéo, cela est logique puisque chaque noyau peut travailler sur une tâche différente.

De même, Google Chrome propose différents noyaux à exécuter sur différents onglets. Mais c’est là que réside le problème. Une fois que vous ouvrez une page Web dans un onglet, elle est généralement statique par la suite. Aucun traitement supplémentaire n'est nécessaire ; le reste du travail consiste à stocker la page dans la RAM. Cela signifie que même si le noyau peut être utilisé pour créer l'arrière-plan, ce n'est pas nécessaire.

Cet exemple de Google Chrome illustre à quel point même un logiciel multithread peut ne pas vous apporter une réelle amélioration des performances.

Deux cœurs ne doublent pas la vitesse

Supposons donc que vous disposiez du bon logiciel et que tous vos autres matériels soient identiques. Un processeur quad core sera-t-il deux fois plus rapide qu'un processeur dual core ? Non.

L'augmentation du nombre de cœurs ne résout pas le problème de mise à l'échelle du logiciel. La mise à l'échelle des cœurs est la capacité théorique de tout logiciel à attribuer les bonnes tâches aux bons cœurs, de sorte que chaque cœur calcule à sa vitesse optimale. Ce n’est pas ce qui se passe réellement.

En réalité, les tâches sont réparties de manière séquentielle (comme le font la plupart des programmes multithread) ou de manière aléatoire. Par exemple, disons que vous devez effectuer trois tâches pour réaliser une activité et que vous disposez de cinq activités de ce type. Le logiciel demande au noyau 1 de résoudre le problème 1, tandis que le noyau 2 résout le deuxième et que le noyau 3 résout le troisième ; Pendant ce temps, le noyau 4 est inactif.

Si la troisième tâche est la plus difficile et la plus longue, il serait alors logique que le logiciel divise la troisième tâche entre les cœurs 3 et 4. Mais ce n'est pas ce qu'il fait. Au lieu de cela, même si les cœurs 1 et 2 termineront la tâche plus rapidement, l'action devra attendre que le cœur 3 soit terminé, puis calculer les résultats des cœurs 1, 2 et 3 ensemble.

C'est une manière détournée de dire que le logiciel, tout comme aujourd'hui, n'est pas optimisé pour tirer pleinement parti des plusieurs cœurs. Et doubler les cœurs n’équivaut pas à doubler la vitesse.

Où davantage de cœurs seront-ils vraiment utiles ?

Maintenant que vous savez à quoi servent les cœurs et leurs limites de performances, vous devriez vous demander : « Ai-je besoin de plus de cœurs ? Eh bien, cela dépend de ce que vous comptez en faire.

Si vous jouez souvent à des jeux informatiques, davantage de cœurs sur votre PC vous seront sans aucun doute utiles. La grande majorité des nouveaux jeux populaires des grands studios prennent en charge une architecture multithread. Le jeu vidéo dépend encore largement du type de carte graphique dont vous disposez, mais un processeur multicœur est également utile.

Tout professionnel travaillant avec des programmes vidéo ou audio bénéficiera de davantage de cœurs. Les outils d'édition audio et vidéo les plus populaires utilisent un traitement multithread.

Photoshop et conception

Si vous êtes un concepteur, des vitesses d'horloge plus élevées et davantage de cache CPU augmenteront mieux la vitesse que davantage de cœurs. Même le logiciel de conception le plus populaire, Adobe Photoshop, prend largement en charge les processus monothread ou légèrement threadés. Un grand nombre de cœurs ne constitueront pas une incitation significative à cela.

Navigation Web plus rapide

Comme nous l'avons déjà dit, avoir plus de cœurs ne signifie pas une navigation Web plus rapide. Bien que tous les navigateurs modernes prennent en charge l'architecture multi-processus, les noyaux ne seront utiles que si vos onglets en arrière-plan sont des sites nécessitant beaucoup de puissance de traitement.

Tâches de bureau

Toutes les applications Office principales sont monothread, donc un processeur quadricœur n'ajoutera pas de vitesse.

Avez-vous besoin de plus de cœurs ?

En général, un processeur quadricœur fonctionnera plus rapidement qu'un processeur double cœur pour l'informatique générale. Chaque programme que vous ouvrez fonctionnera sur son propre noyau, donc si les tâches sont séparées, les vitesses seront meilleures. Si vous utilisez plusieurs programmes en même temps, basculez souvent entre eux et leur attribuez leurs propres tâches, choisissez un processeur avec un grand nombre de cœurs.

Sachez simplement ceci : Les performances globales du système sont un domaine dans lequel il existe trop de facteurs. Ne vous attendez pas à une amélioration magique des performances en remplaçant un seul composant, même le processeur.

Téléchargez la version russe de Google Chrome (Google Chrome)

Téléchargez la version russe de Google Chrome (Google Chrome) Comment synchroniser les contacts Android avec Google : instructions étape par étape

Comment synchroniser les contacts Android avec Google : instructions étape par étape Comment activer le mode sans échec sur 10

Comment activer le mode sans échec sur 10 Pilote pour adaptateur réseau - instructions d'installation détaillées

Pilote pour adaptateur réseau - instructions d'installation détaillées Recherche de téléphone gratuite par IMEI via satellite

Recherche de téléphone gratuite par IMEI via satellite Comment accéder au menu de démarrage du BIOS sur un ordinateur portable Lenovo

Comment accéder au menu de démarrage du BIOS sur un ordinateur portable Lenovo Comment réaffecter les touches cassées de votre clavier

Comment réaffecter les touches cassées de votre clavier