Trois lettres joyeuses: ce que vous devez savoir sur HDR. Tout ce que vous avez besoin de savoir sur HDR dans les moniteurs d'ordinateur Quels jeux sont pris en charge par HDR sur PC

Après CES et Compuex 2017, il est devenu clair: d'ici la fin de cette année, les premiers moniteurs du PC soutenant la norme apparaîtront sur le marché. Tous les grands fabricants, tels que Asus, LG, Acer, Samsung et Dell, l'ont annoncé. Alors, étudions une petite théorie des moniteurs avec HDR.

HDR en format PC

HDR ou une plage dynamique élevée est une norme permettant d'élargir la reproduction des couleurs et le contraste vidéo au-delà des fonctionnalités matérielles standard. Il est simplement expliqué, l'autorisation 4K est importante pour la qualité de l'image, la contraste, la luminosité et la saturation des couleurs et HDR améliore ces trois paramètres, atteignant ainsi une amélioration des détails de l'image.

HDR nécessite que le moniteur ait une couleur de 10 ou 12 bits. Toutefois, les moniteurs PC standard sont actuellement capables de transmettre une couleur de 6 ou 8 bits à l'aide de la gamme de couleurs SRGB qui ne couvre qu'un tiers du spectre visuel HDR.

Bien sûr, il y a des moniteurs qui répondent aux exigences de la couleur. Ce sont des modèles avec le soutien de la couleur dite large de la gamme. Cependant, leurs capacités ne sont compatibles qu'avec des programmes professionnels. Les jeux et autres logiciels ignorent simplement des couleurs supplémentaires et semblent souvent "floues".

La norme HDR vous permet d'éviter cette confusion, y compris des métadonnées dans la diffusion vidéo qui distribuent correctement l'espace de couleur. Il aide à visualiser correctement l'image et entraîne tout le logiciel d'utiliser les meilleures fonctionnalités d'affichage.

Normes

Actuellement, il existe quatre normes, mais deux sont les plus souvent utilisés dans l'électronique grand public: breveté avec des métadonnées de couleur 12 bits et de métadonnées dynamiques et d'une norme ouverte qui prend en charge la couleur de 10 bits et fournissant des métadonnées statiques pour démarrer la diffusion vidéo. Les deux autres normes sont Hlg. ou, développé par BBC et utilisé sur YouTube et HDR avancé., Créé par Technicolor et utilisé en Europe.

Mais retour à la question de l'utilisation de HDR dans les moniteurs PC. En raison de tous les frais de licence et d'équipements supplémentaires, Dolby Vision est plus chère des deux normes. En fournissant une meilleure profondeur de couleur et des paramètres dynamiques des paramètres de jeu de jeux de jeu sont axés sur le HDR moins cher, mais assez acceptable HDR 10. Ceci est juste non seulement pour les fabricants basés sur PC, mais également pour les consoles: Microsoft C, Sony avec PS4 ,.

Mise à jour récente Dolby Vision a simplifié l'intégration du logiciel dans cartes vidéo de jeu Utiliser des mises à jour du pilote. Depuis mars, Nvidia est l'un des principaux partisans de Dolby Vision dans des jeux tels que l'effet de masse: Andromeda.

Photo de Nvidia Rack sur Compuex 2017, montrant un moniteur SDR standard (à gauche) et HDR (à droite) avec effet de masse: Andromeda. Photo: Techowerup.

Photo de Nvidia Rack sur Compuex 2017, montrant un moniteur SDR standard (à gauche) et HDR (à droite) avec effet de masse: Andromeda. Photo: Techowerup. Problème avec HDR pour les joueurs de PC

Si vous avez assez d'argent, il n'y a aucun problème à l'achat d'un moniteur HDR. Mais il y a une question sur le contenu que vous pouvez utiliser dans HDR. Et voici une mauvaise nouvelle pour les joueurs. Oui, de nouveaux jeux vont au marché avec un soutien à HDR, mais plus âgés n'ont pas de possibilités de contraste plus élevé.

Seuls quelques jeux soutiennent HDR: Ombre Warrior 2, Deus Ex: L'humanité dévidée, Hitman, Resident Evil 7, Obdduction, Paragon Et ce qui précède Effet masse: Andromeda. Apparaîtra bientôt Besoin de vitesse: Payback et Star Wars: Battlefront 2.

Pour voir tous les délices des images standard HDR10, qui peuvent produire Xbox One S, PlayStation 4 et PlayStation 4 Pro, vous aurez besoin d'une télévision avec prise en charge de ce format. Mais alors tout devient plus facile - vous pouvez prendre une photo de l'écran et ressentir la différence.

À la présentation spéciale de Sony, dans le cadre du spectacle de gibier de Tokyo, un carré de 4 et une horizon sont démontrés: zéro Dawn à la fois avec l'inclus et éteint HDR. Il n'est resté que pour faire une photo - qui a été faite par les correspondants de la montre japonaise de publication.

Dans le cas de l'horizon: zéro Dawn La différence est évidente: la première photo montre le HDR inclus, la seconde est désactivée. Uncharted 4 Tout est plus compliqué: sur les deux photos, vous pouvez voir la ligne oblique passant à travers l'image. Une partie de l'image à gauche de la ligne montre le HDR éteint, à droite - l'inclus.

La même présentation a montré des versions de Final Fantasy XV, infâme première lumière et résident Evil 7: Biohazard pour PlayStatio 4 Pro. À propos de Biohazard et d'une première lumière, il est difficile de dire quelque chose de défini, mais FFXV a clairement l'air plus décent que sur la playstation habituelle 4. Il semble que les fans devraient avoir à fortuer non seulement sur le jeu, mais également sur la nouvelle console.

La plage dynamique est plus importante que 4K.

Signets

Sur l'affichage du SDR pour voir HDR est impossible, donc généralement dans de telles comparaisons, l'image de la gauche aggravait intentionnellement d'être claire l'essence

4K, comme la norme, s'est enfin allée aux masses. Vous pouvez nommer en toute sécurité 2017 par le tournant de l'historique lorsque cette permission est devenue véritablement consommateur. Le prix des panneaux tomba en dessous de 500 dollars, même pour de grandes diagonales, et le contenu lui-même, laisse et avec tension, mais a commencé à répondre aux exigences nécessaires.

Il y avait des consoles pour un soutien inestimable. L'apparition de PS4 PRO et Xbox One X a considérablement accéléré l'introduction d'écrans 4K. Peu à peu (mais pas sans un tas de réservations) dans 4K traduit et de vastes cinéastes hollywoodiens. Déjà presque tous les spectacles Netflix d'origine peuvent être visionnés dans le décent Ultra HD.

La différence entre 4K et Full HD

Mais est-ce nécessaire une autorisation de 4K 4K exactement sur la télévision? Sur le moniteur, qui est le plus souvent dans une paire de dizaines de centimètres des yeux, la photo en Full HD commence à "crue" sur les pixels déjà sur 27 pouces. Pour cette raison, la rétine / 5k et même 1440p deviennent de plus en plus populaires.

Parmi les téléspectateurs de la télévision, l'adaptation est plus lente, puis de trois mètres, au moins une différence ne se rend visible qu'à 43 pouces et, idéalement, une diagonale de plus de 49 pouces sera prise pour justifier l'achat d'une télévision 4K. De toute évidence, un tel luxe est mal disponible pour la plupart des appartements russes, même s'il y a de l'argent - parfois une énorme télévision est tout simplement nulle part à faire.

Vue ultra-hdr

Les mêmes pensées étaient approximativement à l'auteur de l'article avant d'acheter une nouvelle télévision. Prenez un bon FHD, et Dieu avec lui, avec ce 4k? La pensée n'est raisonnable qu'au premier abord, car le HDR est également attaché à la résolution sur des panneaux décents. Et ceci, avec ceci, avec la forme, pas la technologie très promue est vraiment ressentie par le saut actuel comme une image, les lecteurs et le contenu en vertu de ces normes ne sont pas tellement que je voudrais.

Le produit est simple et accessible pour dire ce que HDR est et comment l'utiliser. Sur la manière dont le processus d'achat et d'installation d'une télévision avec 4K et de HDR sur le matériau DTF, tracez-vous en termes de plus en détail.

Qu'est-ce que HDR et pourquoi il a besoin

Différence visuelle

Commençons par le fait que le terme HDR elle-même est comme une blague d'un marketing maladroit. Il crée une confusion inutile juste du seuil. Ce HDR, qui est dans la télévision, ne s'applique pas à la technologie avec un nom similaire dans les smartphones ou les caméras. Si nous parlons de la photo, HDR est une combinaison de plusieurs images avec différentes expositions, où l'objectif est d'atteindre le plus même sur les ombres et la lumière de l'option.

Avec la vidéo, tout n'est pas vrai, nous parlons du nombre total d'informations. Avant l'apparence HDR, la norme de l'image, y compris Blu-ray, était de 8 bits. Il s'agit d'une bonne couverture de couleur, mais des panneaux modernes, en particulier OLED, sont capables d'afficher beaucoup plus de nuances, de gradients et de couleurs que des sources de 8 bits permettent.

Une nouvelle norme 10 bits est appelée à résoudre ce problème, ce qui vous permet de transmettre de manière significative plus d'informations sur la luminosité, la saturation, la profondeur et la couleur du spectacle de scène. Pour lui, un nouveau protocole HDMI 2.0 a été développé.

Mais ne vous pressez pas ensemble avec le téléviseur change tous les fils! Les anciens câbles sont compatibles avec HDMI 2.0A, quel que soit les spécialistes du marketing pendent sur vos oreilles. L'essentiel est qu'ils ont une marque "grande vitesse avec Ethernet". Seule la bande passante est inquiète - les connecteurs eux-mêmes n'ont pas changé.

Au moment de la rédaction de cet article, le HDR sur le téléviseur est affûté avec précision 10 bits, bien que la norme de tournage numérique soit crue de 14 bits (même au-dessus du film), de sorte que même les panneaux modernes sont encore loin de tout le monde. Affichage des informations avec quels directeurs et installations de nombreuses peintures de travail.

Ok, mais qu'est-ce que cela donne dans la pratique?

Exemple HDR vs SDR basé sur Uncharted 4Le soleil commence à briller dans les coulisses sensiblement plus lumineuses, une compréhension du fait que dans une image, il peut y avoir plusieurs luminosité et saturation différentes de sources de lumière. Le problème disparaît avec la pixélisation de la demi-teinte dans les scènes sombres et les gradients et les mélanges complexes des peintures acquièrent du volume. Le ciel n'est plus ennuyé et ne fusionne pas de la terre à la ligne d'horizon. En bref, vous voyez une photo plus près de votre propre œil qu'un oculaire limité de la caméra.

Pour le moment, les jeux vidéo sont bénéfiques que la technologie, où une variété d'éclairage en temps réel est enfin affichée plus ou moins correctement. Beaucoup dépend de la qualité du traitement de la source pour HDR et de nombreux Hack Hacktur, mais maintenant, les références apparaissent pour le format du type de "gardes de la galaxie 2" ou "John Whitch 2".

Fabricants de télévision - vos ennemis

Jusqu'à présent, HDR, comme toute technologie de pointe, est le "Wild West". L'étiquette "Prêt pour HDR" est suspendue à tous les nouveaux téléviseurs - que ce soit en mesure d'afficher de manière adéquate 10 bits ou non. Il y a une grande différence entre le véritable téléviseur HDR et le panneau, qui affiche simplement la teneur en HDR, l'abaissant jusqu'à 8 bits et simplement souffler les couleurs et le contraste.

Il est parfois difficile de lancer des fabricants. Il convient de visualiser si le panneau est déclaré 10 bits et qu'il est responsable de la norme Open HDR10. Le signe correct du panneau HDR réel est le support pour une large gamme de couleurs (large gamme de couleurs). Sans sa HDR perd une signification pratique.

Une partie notable des téléviseurs LCD utilise des panneaux actifs 8 bits, qui "imaginent" des couleurs avec des algorithmes spéciaux. L'image HDR sur de tels panneaux est un peu pire que, mais elles sont sensiblement moins chères.

Retour de "bit" guerres

À tout tour de l'évolution de la photo, les normes de guerre peuvent survenir. Mais si dans le cas de la bataille Blu-ray et HD-DVD, tout s'est terminé à déplorable pour la seconde, y compris pour ceux qui ont acheté des consommateurs «fer», la bataille de HDR10 contre Dolby Vision HDR finira probablement le dessin imperméable.

La norme HDR10 transmet des couleurs plus petites et ne prend en charge que 10 bits, mais entièrement ouverte. La norme Dolby conserve des nuances et élargit jusqu'à 12 bits, mais il est plus difficile de suivre et de la mettre en œuvre. En tout état de cause, la question de l'appui de cette technologie ou de cette technologie est résolue par une copie logicielle simple et les mêmes jeux travaillent déjà avec HDR10, car il s'agissait qu'ils ont été choisis pour leurs consoles à la fois à Sony et à Microsoft.

Les téléviseurs eux-mêmes vous permettent souvent d'utiliser plusieurs normes à la fois, de sorte que cela n'en vaut plus la tête.

Que regarder?

Si nous parlons de l'écran, il vaut mieux prendre OLED et ses analogues. Vous obtiendrez un support noir profond et complet pour tous les charmes HDR. Si le portefeuille ne permet pas à l'ordre d'environ 80 mille à la télévision supérieure, vous ne devriez pas désespérer. Le modèle LCD de 2017 a finalement fait face à des plaies pour enfants et vous remarquez immédiatement la différence entre HDR et SDR, laisser et perdre dans les gradations de noir et de luminosité. L'auteur de cet article est juste un panneau LCD avec support HDR et, je peux vous assurer que la différence avec le contenu des couleurs standard est vue à partir des premières secondes.

Si nous parlons de la source, toutes les consoles de jeu modernes produisent de toute façon (à l'exception du commutateur et de la Tolstoy Xbox One). PS4 le donne juste un HDR (n ° 4K) et la Xbox One S / X vous permet de jouer les lecteurs UHD et de lutter contre le Native 4K HDR directement au téléviseur. Des services en ligne, la norme est déjà prise en charge par Netflix et Amazon et Netflix contient en soi une bibliothèque pour HDR10 et le contenu de Dolby Vision.

Et que regarder?

Toute la teneur originale Netflix depuis 2016, plus tous les films de 4k qui produisent des studios de cinéma sur des disques et dans le "chiffre". Très bientôt, la collection de films de Christopher Nolan Film apparaîtra, dont le processus de numérisation contrôlait lui-même le Directeur. Comme il était avec le "chevalier noir" sur Blu-ray, il est certainement de nombreuses années à définir les normes pour les maîtres UHD et pour HDR.

À quoi jouer?

Un nombre notable de jeux prend en charge HDR, même sur des consoles «de base». Particulièrement lumineux (désolé pour le jeu de mots) Les fonctionnalités de la technologie montrent de tels jeux comme Horizon Zero Dawn, Uncharted 4 et Gran Turismo Sport.

Ce dernier a été créé sous HDR à partir de zéro et souligne donc tous les avantages d'une gamme étendue de luminosité et de couleurs. Surtout pour GT Sport chez Polyphony Digital développé des caméras HDR pour capturer une image réelle et une étalonnage ultérieure dans le jeu informatique. Et le nombre de couleurs affichées dépasse toujours les possibilités des panneaux les plus chers. Ce qu'on appelle, référence "pour la croissance".

Cependant, tous les jeux ne sont pas adaptés à HDR également bien, de même lire les commentaires sur Internet et consultez les critiques de fonderie numérique. S'inquiéter, cependant, il n'est pas nécessaire de s'inquiéter, car les développeurs sont meilleurs et mieux comprendre les possibilités de la gamme élargie, mais, par conséquent, la qualité du contenu de la console ne poussera que.

Au PC pour le moment, tout n'est pas aussi lisse. Les jeux avec HDR un peu et la conclusion de l'image elle-même est associée aux problèmes de reproduction des couleurs au niveau du système (pilotes de courbes, bizarreries de fenêtres, etc.). L'expérience de l'auteur avec un ligament HDR / Windows 10 était contradictoire. En plus de HDR, les joueurs populaires travaillent mal, alors vous devez attendre. Comme la vitesse d'adaptation 3D montre le PC, la mise en œuvre HDR imputée sur les ordinateurs vaut la peine d'attendre environ six mois. Oui, et la bibliothèque se rattrapera.

Donc, tout va bien, mais quels minus?

Typiquement, les tables d'étalonnage dans les jeux ont l'air plus facile

Les minus de HDR sur le virage actuel sont suffisamment suffisants, mais je vais jeter un couple de critique.

- Votre équipement n'est probablement pas prêt pour HDMI 2.0A et HDCP 2.2, ainsi avec un téléviseur, vous devez presque certainement changer le récepteur. J'ai rencontré cela (PS VR de la première révision), je l'ai couru et Vadim (récepteur avec HDMI 1.4).

- S'il vous semble que le HDR gâcher la photo ou échoue, l'écran doit être calibré. Certains jeux offrent des outils d'étalonnage pratiques (COD WWII, GT Sport), mais la plupart d'entre eux doivent compter sur cette question sur leur propre talent. Mon conseil: courez le jeu dans certains complexepar couleurs et scène brillante, ou inversement, sélectionnez le niveau de nuit au crépuscule. Cela vous permettra de configurer rapidement votre nouvelle télévision cool et vous évitera du désordre principal et de la frustration.

Le temps est venu

10 bits ne sont pas la limite, mais après deux semaines avec une télévision HDR à des jeux ordinaires ou des films, vous revenez sans enthousiasme. Plus cette année, la HDR a cessé d'être le lot de châssis et de tolstostums et s'est finalement allé au peuple. La technologie deviendra mieux et plus claire, cependant, si vous avez attendu "le moment même" de changer votre téléviseur - alors ici, c'est un bon moment pour enfin voir les mondes virtuels de toutes les couleurs.

ÉcrivezQuand au début de 2017 est passé exposition CESIl est devenu évident que bientôt les compteurs de magasins d'ordinateurs commenceront à déposer des moniteurs informatiques prenant en charge la norme HDR. Tous les principaux fabricants vendent déjà de tels modèles - chacun avec des paramètres impressionnants. Bientôt, nous vous dirons en détail de l'un d'entre eux et nous allons maintenant nous concentrer sur la théorie qui aidera à décider combien de temps l'achat d'un moniteur avec support pour HDR est justifié.

HDR en format PC

L'explication standard décrit le HDR (ou la plage dynamique élevée) en tant qu'ensemble de normes destinées à élargir la reproduction de la couleur et la contraste de la vidéo et des images au-delà des fonctionnalités matérielles standard "durs". Parler plus facile, HDR améliore le contraste, la luminosité et la saturation des couleurs, fournissant plusieurs fois plus détaillées d'une image. HDR contre le SDR

D'un point de vue pratique, pour la plupart des utilisateurs, cela signifie un remplacement complet des périphériques disponibles afin d'obtenir une différence évidente en tant qu'image. Pourquoi un remplacement complet est-il? Étant donné que les périphériques standard, en particulier les moniteurs, ne respectent pas les exigences de certification HDR.

Commençons par les exigences de luminosité. Pour être considéré comme "HDR prêt", l'affichage doit avoir un minimum de 1000 kD / m2 (filetage de luminosité). Les moniteurs haute classe offrent une luminosité comprise entre 300 et 400 nits, c'est-à-dire. Ils ne correspondent même pas étroitement à ce qui est nécessaire. Bons ordinateurs portables avoir environ 100 fils. Même avec des écrans pour smartphones conçus pour offrir une bonne visibilité à la lumière du soleil brillant, cet indicateur dépasse rarement 800 NIT (Galaxy Note8 est l'une des exceptions avec une luminosité de 1200 NIT). En d'autres termes - actuellement 99% des affichages ne prennent pas en charge HDR.

Nous passons maintenant à la lecture de la couleur. La technologie HDR nécessite le moniteur de maintenir une profondeur de couleur de 10 ou 12 bits. Cependant, des moniteurs standard sont capables de transmettre uniquement une couleur de 6 ou 8 bits à l'aide de la gamme de couleurs SRGB, qui ne couvre qu'un tiers du spectre visuel HDR.

Les modèles de moniteurs avec une technologie de couleur large de gamut (WGC) répondent aux exigences de la couleur, mais leurs capacités étendues ne sont compatibles qu'avec des programmes professionnels ( éditeur graphique, par exemple). Les jeux et le reste du logiciel ignorent simplement des couleurs supplémentaires et semblent souvent "floues" si l'équipement ne peut pas imiter un espace de couleur réduit.

HDR vous permet d'éviter cette confusion en raison de métadonnées qui distribuent correctement l'espace de couleur. C'est ceci qui aide à visualiser correctement l'image et amène tout le logiciel à utiliser de manière optimale les capacités d'affichage.

Ici, cependant, vous devez insérer un grand "mais" pour ceux d'entre vous qui travaillent dans le domaine de la photographie, de la conception graphique et du traitement vidéo. Les couleurs plus brillantes et riches, fournies par les moniteurs HDR, sont peu susceptibles de venir à votre douche. Pas parce que vous ne vous aimerez pas, ils ne satisferont tout simplement pas vos besoins professionnels, car leur "vivacité" est obtenue en raison du réalisme de la reproduction des couleurs. Les modèles avec WGC continuent de rester le choix parfait pour vous. Donc, si vous lisez ce texte pour savoir quels avantages cette technologie donne votre sphère d'emploi, vous ne les trouverez pas.  Deux designer moniteur Dell.. Écran gauche - WGC avec reproduction de couleur réaliste. ADRISION DU HDR. Facile à remarquer une saturation de couleur élevée.

Deux designer moniteur Dell.. Écran gauche - WGC avec reproduction de couleur réaliste. ADRISION DU HDR. Facile à remarquer une saturation de couleur élevée.

Bouillie de normes

Ensuite, nous parlerons de l'expérience du point de vue de l'utilisateur habituel et du jeu de PC, mais laissez-moi d'abord démêler l'énorme enchevêtrement omnipré de normes HDR pour vous. Actuellement, il y a quatre standards, mais seulement deux d'entre eux sont généralisés dans l'électronique grand public: une vision de Dolby brevetée avec ses 12 bits de couleur et de métadonnées dynamiques; Et la norme Open HDR10, qui prend en charge la couleur de 10 bits et fournit uniquement une transmission de métadonnées statiques. Deux autres normes - HLG développées par BBC et utilisées sur YouTube; Et HDR avancé, créé par Technicolor et utilisé principalement en Europe.  La différence entre SDR, HDR avec des métadonnées statiques (HDR10) et HDR avec des métadonnées dynamiques (Dolby Vision).

La différence entre SDR, HDR avec des métadonnées statiques (HDR10) et HDR avec des métadonnées dynamiques (Dolby Vision).

Mais retour à la question de l'utilisation de HDR dans des moniteurs informatiques, en ajoutant la gravité des jeux. Nécessite les frais de licence et la disponibilité d'équipements supplémentaires, Dolby Vision est plus coûteux des deux normes et son coût élevé est le principal facteur de réception lente. Malgré le fait que Dolby Vision fournit la meilleure profondeur de couleur et la possibilité de reconfiguration dynamique du cadre dans les coulisses, les développeurs de jeux choisissent le HDR10 moins cher, mais optimal HDR10. Dans ce cas, il ne s'agit pas seulement des fabricants de PC, mais également des consoles: Microsoft (Xbox One S et Xbox One X) et Sony (PS4 et PS4 Pro). Les principaux partisans de HDR10, tels que Samsung et Amazon, se battent même activement contre l'argument que Dolby Vision fournit plus haute qualité Images. Cette lutte a conduit à l'apparition d'une mise à jour particulière appelée HDR10 +, qui améliore certaines faiblesses de HDR10.

Tout cela suggère que le HDR10 sera une norme HDR répandue pour les moniteurs et les jeux informatiques, non? Non pas du tout. Récemment, Dolby Vision Developers a simplifié l'intégration de leur technologie aux jeux et aux processeurs graphiques via des correctifs, du micrologiciel ou des mises à jour des pilotes. Au printemps de cette année, Nvidia Company a rejoint le nombre de partisans clés de Dolby Vision.  NVIDIA Stand à Computex 2017. À gauche - Moniteur SDR standard, à droite - le moniteur HRD. Photo: Techowerup.

NVIDIA Stand à Computex 2017. À gauche - Moniteur SDR standard, à droite - le moniteur HRD. Photo: Techowerup.

(PC) Geyming dans HDR

Consolateurs ont eu de la chance plus dans la question HDR. Ils ont gagné de l'inclusion de la norme dans des téléviseurs à haute classes et des fabricants de consoles de jeux (spécifiquement pour les consoles) ont rapidement vu l'avantage visuel des écrans HDR à des téléviseurs standard. D'un point de vue purement pratique, le consommateur est plus facile de justifier de grands investissements dans l'écran, qui sert de centre de divertissement de sa maison que dans celui qui se trouve sur le bureau.

Néanmoins, les joueurs de PC peuvent être reconnaissants à leurs camarades de la console. Popularisation de HDR dans des téléviseurs, telles que la série LG C6 et C7, qui peut être utilisée comme moniteurs géants pour PC, autorisés "PCCHNIS" de profiter de la première vague de contenu HDR créé spécifiquement pour PC.

Mais toujours, quels modèles de moniteurs doivent faire attention? Trois des annonces les plus prometteuses des moniteurs de HDR ont rapidement déçu que, en fait, ils ne répondent pas à toutes les exigences de HDR10. Et, par conséquent, le vrai HDR ne supporte pas. Deux d'entre eux, Dell S2718D et LG 32UD99 peuvent recevoir un signal HDR, mais ne disposent pas de la plage de couleurs nécessaire ni de la luminosité pour utiliser la teneur en HDR. Le dernier, BenQ SW320, répond aux exigences de couleur, mais pas de luminosité. Ainsi, les modèles suivants sont restés dans la liste: Acer Prédateur X27, Acer Prador X35 Asus Rog Swift PG27UQ, Asus Rog Swift PG35VQ, Samsung Chg70 et Samsung Chg90.  Asus Rog Swift PG35VQ est l'un des modèles HDR les plus prometteurs pour le moment

Asus Rog Swift PG35VQ est l'un des modèles HDR les plus prometteurs pour le moment

La prochaine question logique: Quelle est la situation avec le processeur graphique? À cet égard, les ordinateurs ont longtemps été préparés en raison de la guerre entre NVIDIA et AMD, ainsi que leurs cartes vidéo moyennes et hautes.

Nvidia a débuté avec une intégration HDR dans ses processeurs graphiques de génération Maxwell (série 900 précédente) et sa certification continue avec une nouvelle série 1000, qui utilise l'architecture Pascal. Les premières cartes vidéo certifiées d'AMD sont devenues des modèles de familles de 390x et de Polaris. Mettez simplement, si votre carte vidéo a été libérée au cours des 4 dernières années, vous ne devriez pas avoir de problèmes. Toutefois, si vous souhaitez utiliser tout ce qui peut offrir un nouvel écran HDR, vous devrez acheter l'un des modèles de carte vidéo les plus récents.

Véritable problème avec HDR pour les joueurs de PC

Si avec de l'argent complet, achetez un moniteur avec prise en charge HDR et que le fer à repasser correspondant ne sera pas un problème. Mais avant de courir dans le magasin, la situation doit être examinée avec la présence de contenu approprié. Malheureusement, à cet égard, donc la situation. Oui, il y a de nouveaux jeux dans lesquels le soutien de HDR posé à l'origine, mais de vieux jeux ne savent pas comment s'adapter aux caractéristiques de cette technologie. Au moins, pas sans patchs spéciaux.

L'intégration HDR ne nécessite pas de changements de logiciels à grande échelle, mais cela n'annule pas le fait qu'à l'heure actuelle, la quantité de contenu HDR disponible sur les joueurs de PC n'est pas si grande. En fait, seulement quelques jeux de soutien Standard: Shadow Warrior 2, Deus Ex: L'humanité dévidée, Hitman, Resident Evil 7, Obdduction, Paragon, Paragon, Version d'effet Mass: Andromeda, Besoin de vitesse: Payback et Star Wars: Battlefront 2. Jeux de plate-forme croisée Gears of War, Battlefield et Forza Horizon 3 Support HDR dans les versions de console, mais cette fonction est manquante sur le PC. Il y a quelque temps, Nvidia a activement travaillé sur le patch HDR pour la montée de la tombe de la tombe de la tombe, mais il n'y avait pas de nouvelles de la société depuis longtemps sur la façon dont ce travail bouge.

Les développeurs de jeux prennent l'idée de HDR, mais les jeux de console seront les premiers avec un tel support. Les joueurs de PC restent (encore) en arrière-plan. Il faudra plusieurs années avant que HDR ne devienne une caractéristique vraiment importante des moniteurs informatiques. Pour le moment, cette norme n'est pas parmi les paramètres requis auxquels moniteur de jeuMériter l'attention. Comme dans le cas de 4k, HDR est un investissement à l'avenir.

Un conseil que je peux vous donner en conclusion: achetez aujourd'hui un moniteur qui répond à vos besoins actuels. Si vous êtes important pour HDR, cette agréable bonus vous coûtera quelques centaines de dollars supplémentaires, mais ce sera une garantie (bien que votre nouveau moniteur restera pertinent pendant une longue période.

Mots clés:,| Paramètre | Valeur |

|---|---|

| Nom de code puce. | GP104. |

| Technologie de production | 16 NM Finfet. |

| Nombre de transistors | 7,2 milliards |

| Noyau carré | 314 mm² |

| Architecture | |

| Support matériel DirectX | |

| Bus de mémoire. | |

| 1607 (1733) MHz | |

| Blocs informatiques | 20 multiprocesseurs en streaming comprenant 2560 alus scalaires pour des semi-jeux flottants dans le cadre de la norme IEEE 754-2008; |

| Blocs de texturation | 160 blocs d'adressage et de filtrage de la texture avec le support de composant FP16 et FP32 dans les textures et la prise en charge du filtrage trilinéar et anisotrope pour tous les formats de texture |

| Support de surveillance |

| Spécifications de la carte vidéo de référence Geforce gtx. 1080 | |

|---|---|

| Paramètre | Valeur |

| FRÉQUENCE DE NUCLEUS | 1607 (1733) MHz |

| 2560 | |

| Nombre de blocs de texture | 160 |

| Nombre de blocs de gaffe | 64 |

| Fréquence de mémoire efficace | 10 000 (4 × 2500) MHz |

| Type de mémoire | Gddr5x. |

| Bus de mémoire. | 256 bits |

| Taille mémoire | 8 Go |

| 320 gb / s | |

| environ 9 teraflops | |

| 103 gigapixels / avec | |

| 257 gîtes / avec | |

| Pneu | PCI Express 3.0 |

| Connecteurs | |

| Consommation d'énergie | jusqu'à 180 W. |

| Nourriture supplémentaire | Un connecteur de 8 broches |

| 2 | |

| Prix \u200b\u200brecommandé | 599-699 $ (USA), 54990 roubles (Russie) |

Le nouveau modèle de carte vidéo GeForce GTX 1080 est logique pour la première solution de la nouvelle série GeForce - elle diffère de son prédécesseur direct uniquement une génération modifiée. La nouveauté ne remplace pas simplement les meilleures solutions de la ligne actuelle de la société, mais elle est devenue le produit phare de la nouvelle série jusqu'à ce que le Titan X soit libéré sur le GPU encore plus grand pouvoir. Le modèle GeForce GTX 1070 déjà annoncé est également situé ci-dessous dans la hiérarchie, basé sur la version tranchée de la puce GP104, que nous considérerons ci-dessous.

Les prix recommandés pour une nouvelle vidéo de vacances Nvidia sont 599 $ et 699 $ pour les versions conventionnelles et les éditions spéciales des fondateurs Edition (voir ci-dessous), respectivement, ce qui est une assez bonne phrase, en tenant compte du fait que GTX 1080 est en avance sur non seulement GTX 980 TI, mais aussi Titan X. Aujourd'hui, la nouveauté est la meilleure des performances de la solution sur le marché des cartes vidéo à puce à puce sans aucune question, tout en coûtant moins cher que les cartes vidéo les plus productives de la génération précédente. Bien qu'un concurrent de la DMLI de GeForce GTX 1080 est donc en conséquence, Nvidia a donc pu établir un tel prix qui leur convient.

La carte vidéo à l'étude est basée sur la puce GP104, qui comporte un bus de mémoire de 256 bits, mais un nouveau type de mémoire GDDR5X fonctionne sur une fréquence très efficace de 10 GHz, qui donne une largeur de bande de pointe à 320 gb / c - Ce qui est presque au niveau GTX 980 TI du bus de 384 pieds. La quantité de mémoire montée sur une carte vidéo avec un tel bus pourrait être de 4 ou 8 Go, mais mettre un volume plus petit pour une solution aussi puissante dans conditions modernes Ce serait stupide, donc GTX 1080 totalement reçu logiquement 8 Go de mémoire, et ce volume suffit pour démarrer toutes les applications 3D avec des paramètres de qualité pendant plusieurs années à venir.

La carte de circuit imprimé GeForce GTX 1080 pour des raisons évidentes est décemment différente de celle du PCB précédent de la société. La valeur de l'innovation typique de la nouveauté est de 180 W - il est légèrement supérieur à celui de GTX 980, mais sensiblement inférieur à celui de Titan X et GTX 980 TI moins productif. La carte de référence a un ensemble familier de connecteurs pour la fixation d'un périphérique de sortie d'image: un DVI double-lien, un HDMI et trois displayPort.

Références Design Founders Edition

Annonce de la GeForce GTX 1080 Au début de mai, une édition spéciale de la carte vidéo appelée Founders Edition a été annoncée, qui a un prix plus élevé par rapport aux cartes vidéo conventionnelles des partenaires de la société. En substance, cette publication est une carte de conception de référence et un système de refroidissement, et elle est faite par NVIDIA. Vous pouvez relier différemment à de telles variantes de cartes vidéo, mais développées par les ingénieurs de la conception de référence de la société et la conception produite à l'aide de composants de haute qualité possède ses propres fans.

Mais s'ils donneront quelques milliers de roubles plus pour la carte vidéo de Nvidia elle-même - c'est une question, la réponse à laquelle seule la pratique peut donner. En tout cas, il est d'abord de vendre que les cartes vidéo de référence de Nvidia à un prix accru seront apparaissées, et elle n'est pas particulièrement différente de tout - cela se produit avec chaque annonce, mais la référence GeForce GTX 1080 est caractérisée en ce qu'elle est prévu d'être vendu tout au long de sa durée de vie, jusqu'à la libération des solutions de nouvelle génération.

Nvidia estime que cette publication présente ses avantages, même avant les meilleures œuvres de partenaires. Par exemple, une conception à deux feuilles d'un refroidisseur vous permet de collecter facilement sur la base de cette puissante carte vidéo en tant que PC de jeu d'un facteur de forme relativement petit, ainsi que des systèmes vidéo multiméphie (même malgré l'opération sans travail. en mode trois et quatre heures). Les fondateurs GeForce GTX 1080 L'édition présente quelques avantages sous la forme d'un refroidisseur efficace utilisant une chambre à évaporation et un ventilateur émettant de l'air chauffé à partir du cas - il s'agit de la première solution de cette nouvelle NVIDIA qui consomme moins de 250 W.

Par rapport aux conceptions de référence précédentes des produits de la société, le circuit d'alimentation a été mis à niveau avec une quatre phases à cinq phases. Nvidia parle également de composants améliorés sur lesquels la nouveauté est basée sur la nouveauté, les interférences électriques ont également été réduites pour améliorer la stabilité du potentiel de tension et d'overclocking. À la suite de toutes les améliorations, l'efficacité énergétique des frais de référence a augmenté de 6% par rapport à GeForce GTX 980.

Et afin de différer des modèles «ordinaires» de GeForce GTX 1080 et de l'extérieur, pour les fondateurs Edition a développé une conception de cas «hachée hachée» inhabituelle. Cela, cependant, a probablement conduit à la complication de la forme de la chambre d'évaporation et du radiateur (voir photo), ce qui est possible et servi comme l'une des raisons de la surtaxe à 100 $ pour une telle édition spéciale. Nous répéterons qu'au début des ventes d'un choix spécial pour les acheteurs ne sera pas, mais à l'avenir, vous pouvez choisir une solution à votre propre conception de l'un des partenaires de la société et effectué par NVIDIA même.

Nouvelle génération d'architecture graphique Pascal

La carte vidéo GeForce GTX 1080 est devenue la première solution à la puce GP104 en fonction de la nouvelle génération de l'architecture graphique NVIDIA - Pascal. Bien que la nouvelle architecture reposait sur la décision, elle a recours à Maxwell, il présente d'importantes différences fonctionnelles que nous écrirons. Le changement principal du point de vue mondial a été le nouveau processus technologiqueoù un nouveau processeur graphique a été effectué.

L'utilisation du processus technique de 16 NM FINFET dans la production de processeurs graphiques GP104 dans les usines TSMC TSMC a permis d'augmenter de manière significative la complexité de la puce tout en maintenant la zone relativement basse et le coût. Comparez le nombre de transistors et de la zone de chips GP104 et GM204 - ils sont à proximité dans la région (le cristal des nouveautés est même légèrement moins physiquement physique), mais la puce d'architecture Pascal a un plus grand nombre de transistors et, en conséquence, des blocs exécutifs, y compris fournir de nouvelles fonctionnalités.

D'un point de vue architectural, le premier joueur Pascal est très similaire à des solutions similaires de l'architecture Maxwell, bien qu'il y ait des différences. Comme Maxwell, les processeurs d'architecture Pascal disposent d'une configuration de cluster de calcul de graphique différente (GPC), de multiprocesseurs en streaming multiprocesseur multiprocesseur (SM) et de contrôleurs de mémoire. Le SM MultiProcesseur est un multiprocesseur de haut-parallèle qui planifie et exécute Warp (Warp, groupes de 32 flux de commandes) sur Cuda-Nuclei et d'autres blocs de direction dans un multiprocesseur. Données détaillées sur le périphérique de tous ces blocs que vous pouvez trouver dans nos examens des solutions précédentes NVIDIA.

Chacun des multiprocesseurs SM est pulvérisé avec un moteur de moteur polymorphe, qui traite des échantillons de texture, de la tessellation, de la transformation, de l'installation d'attributs de sommet et d'une correction de perspective. Contrairement aux solutions précédentes de la société, le moteur Polymorph dans la puce GP104 contient également une nouvelle unité multiprofessante multi-projections simultanée que nous allons toujours parler. La combinaison SM MultiProcesseur avec un moteur de moteur Polymorphe est traditionnelle pour Nvidia appelée CLUSTER TPC - Texture Processor.

L'ensemble de la puce GP104 dans la GeForce GTX 1080 contient quatre grappes de GPC et des multirocesseurs de 20 SM, ainsi que huit contrôleurs de mémoire, combinés à des blocs de rops dans la quantité de 64 pièces. Chaque cluster GPC a un moteur de routage dédié et comprend cinq multirocesseurs SM. Chaque multiprocesseur, à son tour, se compose de 128 CUDA-CORELS, 256 KB du fichier de registre, 96 cb de mémoire partagée, 48 Ko du cache du premier niveau et huit blocs de texture TMU. Au total, au total GP104 contient 2560 cœurs CUDA et 160 blocs TMU.

En outre, le processeur graphique, basé sur la carte vidéo GeForce GTX 1080, contient huit 32 bits (contrairement aux contrôleurs de mémoire utilisés de 64 bits précédemment utilisés, ce qui nous donne un bus de mémoire de 256 bits. Chacun des contrôleurs de mémoire est lié à huit rop et à 256 kb du cache de deuxième niveau. C'est-à-dire que toute la puce GP104 contient 64 blocs de rop et 2048 kb de cache de deuxième niveau.

Grâce aux optimisations architecturales et à un nouveau processus technique, le premier jeu Pascal est devenu le processeur graphique le plus économe en énergie pour tous les temps. De plus, la contribution à celle-ci est à la fois de l'un des processus technologiques les plus avancés de 16 NM Finfet et des optimisations de l'architecture à Pascal, par rapport à Maxwell. Nvidia a pu augmenter la fréquence d'horloge encore plus que ce qu'ils ont été calculés lors de la passation d'un nouveau processus technique. GP104 fonctionne à une fréquence plus élevée que le GM204 hypothétique serait fonctionné, libéré à l'aide d'un processus de 17 nm. Pour cela, NVIDIA Ingénieurs devait vérifier et optimiser complètement tous les goulots d'étranglement des solutions précédentes, ne permettant pas d'accélérer au-dessus d'un certain seuil. En conséquence, le nouveau modèle GeForce GTX 1080 fonctionne de plus de 40% de fréquence accrue, par rapport à GeForce GTX 980. Mais ce n'est pas tous les changements associés à la fréquence de fonctionnement du GPU.

Technologie GPU Boost 3.0

Comme nous le savons bien selon les cartes vidéo Nvidia, dans leurs processeurs graphiques, ils utilisent la technologie de matériel de boost GPU, destiné à augmenter la fréquence d'horloge de travail GPU dans les modes lorsqu'il n'a pas encore atteint les limites de la consommation d'énergie et de la génération de chaleur. Au cours des dernières années, cet algorithme a subi de nombreux changements et la troisième génération de cette technologie est déjà utilisée dans la puce vidéo de Pascal Architecture - GPU Boost 3.0, dont l'innovation principale est devenue une installation plus subtile de turbo-fréquences, en fonction de sur la tension.

Si vous rappelez le principe de fonctionnement des versions précédentes de la technologie, la différence entre la fréquence de base (la valeur de fréquence minimale garantie est inférieure à laquelle le GPU ne tombe pas au moins dans les jeux) et la fréquence turbo a été corrigée. C'est-à-dire que la fréquence turbo a toujours été sur un certain nombre de Megahertz au-dessus de la base. GPU Boost 3.0 a la possibilité d'installer des déplacements de fréquence turbo pour chaque tension séparément. Le moyen le plus simple de comprendre est illustré par:

À gauche se trouve le boost GPU de la deuxième version, à droite - le troisième, qui est apparu à Pascal. La différence fixe entre les fréquences de base et les turbo ne permettait pas de divulguer complètement les capacités du GPU complètement, dans certains cas, les processeurs graphiques des générations précédentes pourraient fonctionner plus rapidement sur la tension installée, mais l'excès fixe de la fréquence turbo n'a pas permis cette . Dans GPU Boost 3.0, cette fonctionnalité est apparue et la fréquence turbo peut être installée pour chacune des valeurs de tension individuelles, comprimé complètement tous les jus de la GPU.

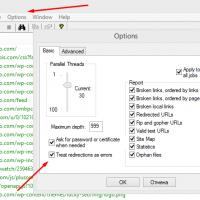

Afin de contrôler l'accélération et d'établir une courbe de turbo-fréquence, des utilitaires pratiques sont nécessaires. Nvidia elle-même ne fait pas cela, mais aide ses partenaires à créer des utilitaires similaires pour le soulagement de l'overclocking (dans des limites raisonnables, bien sûr). Par exemple, la nouvelle fonctionnalité de GPU Boost 3.0 est déjà décrite dans EVGA Precision XOC, qui comprend un scanner d'accélération spécial, de trouver et d'installer automatiquement une différence non linéaire entre la fréquence de base et la fréquence turbo pour valeurs différentes Tensitions utilisant le lancement du test de performance intégré et de la stabilité. En conséquence, l'utilisateur éteint une courbe de fréquence turbo, correspondant parfaitement aux capacités d'une puce particulière. Ce qui, outre, vous pouvez en quelque sorte modifier en mode manuel.

Comme vous pouvez le constater sur la capture d'écran de l'utilitaire, en plus des informations sur le GPU et le système, il existe également des paramètres pour l'overclocking: la cible de puissance (définit la consommation d'énergie typique lors de l'accélération, en pourcentage de la norme), cible TEMP GPU (Température maximale admissible du noyau), décalage d'horloge GPU (dépassant la fréquence de base de toutes les valeurs de tension), décalage de la mémoire (fréquence de mémoire vidéo dépassant la valeur par défaut), surtension (puissance supplémentaire pour augmenter la tension).

L'utilitaire de précision XOC comprend trois modes d'accélération: le manuel principal de base et linéaire linéaire et manuel. En mode principal, vous pouvez définir une seule valeur de dépassement de fréquence (fréquence turbo fixe) au-dessus de la base, telle qu'elle était pour les GPU précédents. Le mode linéaire vous permet de définir une modification linéaire de la fréquence du minimum sur les valeurs de tension maximales pour le GPU. Eh bien, en mode manuel, vous pouvez définir des valeurs de fréquence GPU uniques pour chaque point de tension sur le graphique.

Dans le cadre de l'utilitaire, il existe également un scanner spécial pour l'overclocking automatique. Vous pouvez installer vos propres niveaux de fréquence ou permettre à l'utilitaire de précision XOC de numériser GPU sur toutes les contraintes et de trouver les fréquences les plus stables de chaque point de la courbe de tension et de la fréquence sont entièrement automatiquement automatiquement automatiquement. Dans le processus de numérisation, la précision XOC ajoute progressivement la fréquence du GPU et vérifie ses travaux sur la stabilité ou l'apparence d'artefacts, construisant la courbe parfaite des fréquences et des contraintes, qui sera unique pour chaque puce spécifique.

Ce scanner peut être configuré dans vos propres besoins, définissant le segment d'heure du test de chaque valeur de tension, vérifiée de fréquence minimale et maximale, et son pas. Il est clair que pour atteindre des résultats stables, il sera préférable de définir une petite étape et une durée décente des tests. Dans le processus de test, un dispositif vidéo et un système instables peuvent survenir, mais si le scanner ne dépend pas, il restaurera le travail et continuera de trouver les fréquences optimales.

Nouveau type de mémoire vidéo GDDR5X et compression améliorée

Ainsi, la puissance du processeur graphique a sensiblement augmenté et le bus de mémoire n'est resté que 256 bits - il n'y aura pas de bande passante de mémoire pour limiter les performances globales et ce qui peut être fait avec elle? Il semble que la mémoire HBM prometteuse de la deuxième génération soit encore trop en production, alors je devais chercher d'autres options. Dès le moment de l'avènement de la mémoire GDDR5 en 2009, NVIDIA Ingénieurs a enquêté sur les possibilités d'utiliser de nouveaux types de mémoire. En conséquence, le développement est venu à l'introduction d'une nouvelle norme de mémoire GDDR5X - la norme la plus complexe et la plus avancée, qui donne le taux de transfert de 10 Gbps.

Nvidia apporte un exemple intéressant de la rapidité avec laquelle c'est vite. Il n'y a que 100 picosecondes entre les morceaux transmis - pendant une telle époque, le faisceau lumineux passera la distance à un pouce (environ 2,5 cm). Et lors de l'utilisation de la mémoire GDDR5X, la chaîne de réception de la transmission de données doit être inférieure à la moitié de cette période, sélectionnez la valeur du bit transmis, avant que la suivante soit envoyée, vous comprenez que vous comprenez quelles technologies modernes ont atteint.

Pour atteindre cette vitesse de travail, il était nécessaire de développer une nouvelle architecture du système d'E / S de données nécessitant plusieurs années de développement commun avec des fabricants de puces mémoire. Outre l'augmentation du taux de transmission de données, l'efficacité énergétique a augmenté - les puces de mémoire standard GDDR5X utilisent une tension réduite en 1,35 V et produites selon les nouvelles technologies, ce qui donne la même consommation d'énergie à 43% de fréquence de plus.

Les ingénieurs de la société ont dû recycler les lignes de transmission de données entre le noyau GPU et les copeaux de mémoire, rapportent plus d'attention pour éviter la perte et la dégradation du signal tout au long de la mémoire de la mémoire à GPU et à l'arrière. Ainsi, l'illustration ci-dessus montre un signal capturé sous la forme d'un grand "œil" symétrique, qui indique une bonne optimisation de la chaîne entière et la facilité relative de capture de données du signal. De plus, les modifications décrites ci-dessus ont conduit non seulement à la possibilité d'utiliser GDDR5X de 10 GHz, mais également d'aider à obtenir une PSP élevée sur les futurs produits en utilisant une mémoire GDDR5 plus familière.

Eh bien, plus de 40% de l'augmentation de la PSP de l'application de la nouvelle mémoire que nous avons reçue. Mais n'est-ce pas assez? Pour augmenter davantage l'efficacité de l'utilisation de la bande passante de la mémoire dans NVIDIA, a continué d'améliorer les données avancées enfermées dans les architectures précédentes. Le sous-système de mémoire dans la GeForce GTX 1080 utilise des utilisations améliorées et plusieurs nouvelles techniques de compression des données sans perte, conçues pour réduire les exigences de la PSP - la quatrième génération de compression intracepicale.

Les algorithmes de compression des données dans la mémoire apportent immédiatement plusieurs moments positifs. La compression réduit le nombre de données enregistrées dans la mémoire, il en va de même pour les données envoyées à partir de la mémoire vidéo à la mémoire cache de second niveau, ce qui améliore l'efficacité de l'utilisation du cache L2, car la tuile comprimée (bloc de plusieurs pixels de cadre) a une taille plus petite que non compressée. Diminue également la quantité de données envoyée entre différents points, telles que le module de texture TMU et la tramebuffer.

Le convoyeur de compression de données dans le GPU utilise plusieurs algorithmes, qui sont déterminés en fonction de la "compressibilité" des données - pour eux, le meilleur des algorithmes disponibles est sélectionné. L'un des plus importants est l'algorithme de codage delta des données de couleur pixel (compression de couleur delta). Cette méthode de compression code des données sous la forme d'une différence entre les valeurs séquentielles au lieu des données elles-mêmes. Le GPU calcule la différence entre les valeurs de couleur entre les pixels du bloc (carreau) et enregistre le bloc sous la forme d'une certaine couleur moyennée pour l'ensemble du bloc plus des données sur la différence de valeurs pour chaque pixel. Pour les données graphiques, cette méthode est généralement bien adaptée, car la couleur dans de petits carreaux pour tous les pixels n'est souvent pas différente.

Le processeur graphique GP104 dans le cadre de la GeForce GTX 1080 prend en charge plus d'algorithmes de compression par rapport aux chips précédents d'architecte Maxwell. Ainsi, l'algorithme de compression 2: 1 est devenu plus efficace et, en outre, deux nouveaux algorithmes sont apparus: Mode de compression 4: 1, adapté aux cas, lorsque la différence de couleur du pixel de bloc est très faible et le mode de 8: 1, combinant la compression d'algorithme constante avec un rapport de 4: 1 blocs de 2 x 2 pixels avec une compression double d'un delta entre les blocs. Lorsque la compression n'est pas complètement impossible, elle n'est pas utilisée.

Cependant, en réalité, ce dernier est très peu fréquent. Cela peut être vu par des exemples de captures d'écran du jeu de voitures de projet, qui ont conduit NVIDIA pour illustrer le rapport de compression accru à Pascal. Sur les illustrations de violets, ces carreaux de tampon de personnel sont peints, qui pourrait presser un processeur graphique et une compression non sans perte restée avec la couleur d'origine (d'en haut - Maxwell, ci-dessous - Pascal).

Comme vous pouvez le constater, de nouveaux algorithmes de compression dans le GP104 fonctionnent vraiment beaucoup mieux que dans Maxwell. Bien que l'ancienne architecture puisse également comprimer la plupart des carreaux dans la scène, un grand nombre d'herbes et d'arbres sur les bords, ainsi que les parties de la voiture ne sont pas exposées à des algorithmes de compression obsolètes. Mais lorsque vous activez de nouvelles techniques à Pascal, un très petit nombre d'images de l'image reste non compressé - une efficacité améliorée est évidente.

À la suite d'une compression de données améliorée, GeForce GTX 1080 est capable de réduire considérablement le nombre de données envoyées dans chaque image. Si nous parlons de chiffres, la compression améliorée permet d'économiser environ 20% de la largeur de bande de mémoire effective. En plus de plus de 40% de l'augmentation de la PSP dans la GeForce GTX 1080 relative au GTX 980 de l'utilisation de la mémoire GDDR5X, tout cela donne environ 70% de l'augmentation de la PSP efficace, par rapport au modèle de la génération passée. .

Async calculer le support informatique asynchrone

Les jeux les plus modernes utilisent des calculs complexes en plus du graphique. Par exemple, les calculs dans le calcul du comportement des corps physiques ne peuvent pas être effectués avant ou après des calculs graphiques, mais simultanément avec eux, car ils ne sont pas connectés les uns aux autres et ne dépendent pas l'un de l'autre dans une seule image. En outre, un exemple peut être post-traitement du personnel déjà rendu et de traiter des données audio, qui peuvent également être exécutées en parallèle avec le rendu.

Un autre exemple éclatant d'utilisation de fonctionnalités est une distorsion de temps asynchrone utilisée dans des systèmes de réalité virtuelle afin de modifier la trame de sortie conformément au mouvement de la tête du joueur directement avant sa sortie, interrompant le rendu de la suivante. Une telle chargement asynchrone de capacités GPU permet d'augmenter l'efficacité de l'utilisation de ses blocs de direction.

Ces charges créent deux nouveaux scénarios d'utilisation GPU. Le premier de ceux-ci comprend des téléchargements superposés, car de nombreux types de tâches n'utilisent pas complètement les capacités des processeurs graphiques, et une partie des ressources est inactive. Dans de tels cas, vous pouvez simplement exécuter deux sur un GPU différentes tâchesSéparant ses blocs de direction pour obtenir une utilisation plus efficace - par exemple, les effets Physx fonctionnant avec un rendu de cadre 3D.

Pour améliorer le travail de ce scénario, l'équilibrage de la charge dynamique est apparu dans l'architecture Pascal (équilibrage de la charge dynamique). Dans la précédente architecture Maxwell, des charges superposées ont été effectuées comme une distribution statique des ressources GPU sur graphique et computationnelle. Cette approche est efficace, à condition que l'équilibre entre deux charges correspond approximativement à la séparation des ressources et que les tâches soient effectuées de manière égale à temps. Si des calculs analphaphapiques sont effectués plus longtemps que graphique, et les deux attentes d'achèvement travail communLa partie du GPU reste le temps de se lever, ce qui entraînera une baisse de la performance globale et réduira tous les avantages. L'équilibrage de la charge dynamique matérielle vous permet également d'utiliser les ressources GPU libérées immédiatement au fur et à mesure de leur disponibilité - pour comprendre l'illustration.

Il existe également des tâches critiques par temps d'exécution, ce qui est le deuxième scénario de l'informatique asynchrone. Par exemple, l'exécution d'un algorithme de distorsion de temps asynchrone dans VR doit remplir avant que la numérisation (analyse) ou le cadre soit jeté. Dans ce cas, le GPU doit supporter une interruption très rapide de la tâche et passer à une autre pour supprimer la tâche moins critique de l'exécution sur le GPU, libérant ses ressources pour des tâches critiques - cela s'appelle la préparation.

Une équipe de rendu du moteur de jeu peut contenir des centaines d'appels à des fonctions de dessin, chaque appel d'appel de dessin, à son tour, contient des centaines de triangles traités, chacun contenant des centaines de pixels à calculer et à nier. Dans l'approche traditionnelle, le GPU utilise l'interruption des tâches à un niveau élevé et le convoyeur graphique est obligé d'attendre l'achèvement de tout ce travail avant de changer la tâche, ce qui entraîne des retards très importants.

Pour le réparer, l'architecture Pascal a d'abord introduit la capacité d'interrompre la tâche sur la préemption du niveau de pixel de niveau de pixel. Les blocs exécutifs du processeur graphique Pascal peuvent constamment surveiller l'évolution des tâches de rendu d'exécution et, lorsque l'interruption est demandée, elles peuvent arrêter l'exécution en enregistrant le contexte pour une finition ultérieure, rapidement passés à une autre tâche.

L'interruption et la commutation au niveau de débit pour les opérations d'informatique sont similaires à l'interruption du niveau de pixel pour les calculs graphiques. Les charges de calcul consistent en plusieurs grilles, chacune contenant de nombreux threads. Lorsque la demande d'interruption a été reçue, les flux effectués sur le multiprocesseur terminent l'exécution. D'autres blocs conservent leur propre état pour continuer à partir du même moment à l'avenir, et le GPU passe à une autre tâche. L'ensemble du processus de commutation des tâches prend moins de 100 microsecondes une fois les flux terminés.

Pour les charges de jeu, une combinaison d'interruptions sur un niveau de pixel pour graphique et des interruptions au niveau de la diffusion de tâches de calcul fournit des processeurs graphiques de l'architecture Pascal avec la possibilité de basculer rapidement entre les tâches avec une perte de temps minimale. Et pour les tâches informatiques sur Cuda, il est également possible d'interrompre avec une granularité minimale - au niveau d'instruction. Dans ce mode, tous les flux arrêtent d'exécution immédiatement, passant immédiatement à une autre tâche. Cette approche nécessite le maintien de plus d'informations sur l'état de tous les registres de chaque flux, mais dans certains cas de calculs non-chagrins, il est pleinement justifié.

L'utilisation des tâches d'interruption et de commutation rapides des tâches graphiques et informatiques a été ajoutée à l'architecture Pascal afin que les tâches graphiques et analphabètes soient interrompues au niveau des instructions individuelles et non des flux entiers, comme il se trouvait à Maxwell et Kepler. Ces technologies sont en mesure d'améliorer l'exécution asynchrone de diverses charges sur le processeur graphique et d'améliorer la réactivité tout en effectuant simultanément plusieurs tâches. L'événement NVIDIA a montré une démonstration du travail des calculs asynchrones sur l'exemple de calcul des effets physiques. Si, sans calculs asynchrones, la performance était de 77 à 79 fps, puis avec l'inclusion de ces capacités, la fréquence de trame a atteint 93-94 fps.

Nous avons déjà donné un exemple d'une des possibilités d'utilisation de cette fonctionnalité dans des jeux sous la forme de distorsion de temps asynchrone dans VR. L'illustration montre le travail de cette technologie avec une interruption traditionnelle (préparation) et avec un rapide. Dans le premier cas, le processus de distorsion de temps asynchrone tente de fonctionner aussi tard que possible, mais avant de mettre à jour l'image à l'écran. Mais le travail de l'algorithme doit être effectué à l'exécution de plusieurs millisecondes dans le GPU plus tôt, car sans une interruption rapide, il n'est pas possible d'effectuer un travail avec précision au bon moment, et le GPU est inactif pendant un certain temps.

Dans le cas d'une interruption précise au niveau des pixels et des flux (sur l'illustration à droite), une telle opportunité donne une plus grande précision pour déterminer le moment de l'interruption, et la distorsion de la durée asynchrone peut être lancée de manière significative plus tard avec la confiance à l'arrêt avant l'arrêt. Mise à jour des informations sur l'écran. Et le GPU debout pendant un certain temps dans le premier cas peut être téléchargé de travail graphique supplémentaire.

Technologie multiprocessionnaire Multi-projection simultanée

Le support est apparu dans le nouveau processeur graphique GP104 nouvelle technologie Multi-projection (multi-projections simultanée - SMP), permettant à GPU de dessiner des données sur les systèmes de sortie d'image modernes plus efficacement. SMP permet à l'instruction vidéo d'afficher simultanément des données dans plusieurs prévisions, pour lesquelles il était nécessaire d'entrer un nouveau bloc matériel dans le GPU dans le moteur polymorphe à l'extrémité du convoyeur géométrique devant l'unité de rastrisation. Cette unité est chargée de travailler avec plusieurs projections pour un seul flux de géométrie.

Le moteur multipaturs traite des données géométriques en même temps pour 16 projections préfigurées combinant le point de projection (caméras), ces saillies peuvent être pivotées indépendamment ou inclinées. Étant donné que chaque primitive géométrique peut apparaître simultanément dans plusieurs projections, le moteur SMP fournit une telle fonctionnalité, permettant à l'application de donner les instructions de l'instruction vidéo pour reproduire la géométrie à 32 fois (16 projections dans deux centres de projection) sans traitement supplémentaire.

L'ensemble du processus de traitement est rapidement accéléré et, étant donné que le multiprocage fonctionne après un moteur géométrique, il n'a pas besoin de répéter plusieurs fois toutes les étapes de la géométrie de traitement. Les ressources sauvegardées sont importantes dans des conditions de limitation de la vitesse de rendu avec la performance du traitement de la géométrie, telles que la tessellation, lorsque le même travail géométrique est effectué plusieurs fois pour chaque projection. En conséquence, dans le cas de crête, le multipattant peut réduire le besoin de traitement de la géométrie jusqu'à 32 fois.

Mais pourquoi est-ce tout nécessaire? Il existe plusieurs bons exemples dans lesquels la technologie de multipérapage peut être utile. Par exemple, un système multi-domucceur de trois affichages monté à un angle l'un à l'autre proche de l'utilisateur (configuration surround). Dans une situation typique, la scène est tirée dans une seule projection, ce qui entraîne des distorsions géométriques et des joffonniers incorrects de géométrie. La bonne voie est de trois projections différentes pour chacun des moniteurs, conformément à l'angle sous lequel ils se trouvent.

Avec l'aide d'une carte vidéo sur une architecture Pascal, cela peut être fait en une seule passe de géométrie, indiquant trois projections différentes, chacune pour son moniteur. Et l'utilisateur sera donc en mesure de changer l'angle sous lequel les moniteurs se trouvent les uns aux autres non seulement physiquement, mais également de transformer les projections des moniteurs latéraux pour obtenir la perspective correcte dans la scène 3D avec un angle de vision merveilleusement plus large (FOV) . True, il existe une restriction - pour un tel support, l'application doit pouvoir dessiner une scène avec une large fover et utiliser des appels spéciaux SMP SMP pour l'installation. C'est-à-dire que dans chaque jeu, vous ne le ferez pas, vous avez besoin d'un soutien spécial.

En tout état de cause, les temps d'une seule projection sur le seul moniteur plat passé, maintenant de nombreuses configurations multi-composants et affichages incurvés, qui peuvent également être utilisés cette technologie. Sans parler des systèmes de réalité virtuelle qui utilisent des lentilles spéciales entre les écrans et les yeux de l'utilisateur, qui nécessitent de nouvelles techniques pour la projection d'images 3D dans une image 2D. Beaucoup de ces technologies et techniques sont toujours au début du développement, l'essentiel est que les anciens GPU ne puissent pas utiliser efficacement plus d'une projection plate. Celles-ci nécessitent plusieurs passes de rendu, traitement répété de la même géométrie, etc.

Les puces d'architecte Maxwell avaient un soutien multi-résolutions limité qui contribue à accroître l'efficacité, mais SMP à Pascal peut être beaucoup plus. Maxwell pourrait transformer la saillie de 90 degrés pour les cartes cubes (mappage de cubes) ou divers permis pour la projection, mais il n'était utile que dans un cercle limité d'applications, comme VXGI.

D'autres applications SMP, nous notons le dessin avec une résolution différente et une stéréorateur unique. Par exemple, le dessin avec une résolution différente (ombrage multi-résens) peut être utilisé dans les jeux d'optimisation des performances. Lorsqu'il est utilisé, une résolution plus élevée est utilisée au centre du cadre et sur la périphérie, il diminue pour obtenir un taux de rendu plus élevé.

La stéréadronisation à une seule passe est utilisée en VR, elle a déjà été ajoutée au package VRWorks et utilise la possibilité de multiproycation afin de réduire la quantité de travaux géométriques requis par le rendu VR. Dans le cas de cette fonctionnalité, le processeur graphique GeForce GTX 1080 traite la géométrie de la scène une seule fois, générant deux projections à la fois pour chaque œil, qui a doublé la charge géométrique sur le GPU et réduit également la perte du conducteur et du système d'exploitation. .

Une méthode encore plus avancée d'amélioration de l'efficacité du rendu VR est l'ombrage correspondant à la lentille, lorsque des distorsions géométriques requises avec le rendu VR sont simulées à l'aide de plusieurs projections. Cette méthode utilise multiproduit pour le rendu de la scène 3D à la surface, qui est approximativement similaire à la lentille ajustée lors du dessin à la sortie sur un casque VR, ce qui permet de ne pas tirer beaucoup de pixels inutiles sur la périphérie qui sera jetée. Il est plus facile de comprendre l'essence de la méthode sur l'illustration - devant chaque œil, quatre projections légèrement déployées sont utilisées (Pascal peut également être utilisé pour 16 projections pour chaque œil - pour une imitation plus précise de la lentille incurvée) au lieu de une:

Une telle approche est capable d'économiser de manière décente dans la performance. Donc, une image typique de Oculus Rift pour chaque œil est de 1,1 mégapixel. Mais en raison de la différence de projections, de le rendre, l'image d'origine est utilisée dans 2,1 mégapixels - 86% plus nécessaire! L'utilisation du multitraitement intégré dans l'architecture Pascal permet de réduire la résolution de l'image dessinée à 1,4 mégapixels, ayant reçu une économie d'une manière et une voie à suivre au taux de traitement de pixels et permet également de sauvegarder une bande passante de mémoire.

Et ensemble avec une double économie de la vitesse de traitement de la géométrie due à la stéréadrancement à une seule passe, le processeur graphique GeForce GTX 1080 est capable de fournir une augmentation significative de la performance du rendu VR, très exigeante et à la vitesse de la géométrie de traitement, et même plus donc - au traitement des pixels.

Améliorations des blocs de sortie vidéo et de traitement

Outre les performances et les nouvelles fonctionnalités associées au rendu 3D, il est nécessaire de maintenir un bon niveau et la possibilité de délivrer l'image, ainsi que du décodage et du codage de données vidéo. Et le premier processeur graphique de l'architecture Pascal n'a pas déçu: il prend en charge toutes les normes modernes en ce sens, y compris le décodage du matériel HEVC requis pour visualiser les vidéos 4K sur le PC. En outre, les futurs propriétaires de cartes vidéo GeForce GTX 1080 pourront profiter rapidement de la lecture de la vidéo 4K en streaming de Netflix et d'autres fournisseurs de leurs systèmes.

Du point de vue d'une sortie d'image sur les affichages, GeForce GTX 1080 prend en charge HDMI 2.0B avec HDCP 2.2, ainsi que DisplayPort. Jusqu'à présent, la version de DP 1.2 est certifiée, mais le GPU est prêt pour la certification pour les nouvelles normes: DP 1.3 Prêt et DP 1.4 prêt. Ce dernier vous permet d'afficher une image sur des écrans 4K à une fréquence de renouvellement de 120 Hz et à des écrans 5K et 8K - à 60 Hz lors de l'utilisation de la paire de câbles DisplayPort 1.3. Si pour GTX 980, la résolution maximale prise en charge était de 5120 × 3200 à 60 Hz, puis pour le nouveau modèle GTX 1080, il a augmenté de 7680 × 4320 avec le même 60 Hz. Référence GeForce GTX 1080 dispose de trois sorties DisplayPort, d'une HDMI 2.0B et d'un DVI à double liaison numérique.

Le nouveau modèle de carte vidéo NVIDIA a également reçu une unité de décodage vidéo améliorée et un codage de données vidéo. Ainsi, la puce GP104 est conforme à des normes élevées de PlayReady 3.0 (SL3000) pour lire la vidéo en continu, vous permettant de confirmer que jouer de contenu de haute qualité à partir de fournisseurs bien connus, comme Netflix, sera aussi haute qualité et économe en énergie. Détails sur la prise en charge de divers formats vidéo Lors de l'encodage et du décodage figurent dans le tableau, la nouveauté est clairement différente des solutions précédentes pour le mieux:

Mais une nouveauté encore plus intéressante peut être appelée prise en charge des affichages de plage dynamique élevés (gamme dynamique élevée - HDR), qui sont sur le point de se généraliser sur le marché. Les téléviseurs sont vendus déjà en 2016 (et en un an, il est prévu de vendre quatre millions de TV) et les moniteurs sont les suivants. HDR est la plus grande avancée dans les technologies d'affichage depuis de nombreuses années, ce format a doublé les nuances de couleur (75% du spectre visible, contrairement à 33% pour RVB), d'affichages plus brillants (1000 NIT) avec un contraste plus élevé (10 000: 1) et Couleurs saturées.

L'apparition de la reproduction du contenu avec une plus grande différence de luminosité et de couleurs riches et riches apportera l'image sur l'écran en réalité, la couleur noire deviendra plus profonde, la lumière brillante sera aveugle, comme dans le monde réel. En conséquence, les utilisateurs verront plus de détails dans des images lumineuses et sombres d'images, par rapport aux moniteurs standard et aux téléviseurs.

Pour prendre en charge des affichages HDR, GeForce GTX 1080 a tout ce dont vous avez besoin - la possibilité de produire une couleur 12 bits, une prise en charge des normes BT.2020 et SMPTE 2084, ainsi que de la sortie d'image conformément à HDMI 2.0B 10/12 bits pour HDR dans la résolution 4K, qui était et Maxwell. En outre, Pascal a appuyé un décodage au format Hevc de 4K-Résolution avec une couleur de 60 Hz et 10 ou 12 bits, qui est utilisé pour la vidéo HDR, ainsi que le codage du même format avec les mêmes paramètres, mais seulement dans 10 bits pour enregistrer la vidéo HDR ou le streaming. En outre, une nouveauté est prête à standardiser DisplayPort 1.4 pour transmettre des données HDR pour ce connecteur.

À propos, le codage de la vidéo HDR peut être nécessaire à l'avenir afin de transmettre de telles données d'un PC à la maison à la console de jeu de bouclier, qui peut jouer un HEVC 10 bits. Autrement dit, l'utilisateur sera en mesure de diffuser le jeu avec un PC au format HDR. Arrêtez-vous, et où prendre des jeux avec un tel soutien? Nvidia collabore constamment avec les développeurs de jeux pour mettre en œuvre un tel support, en passant tout ce dont vous avez besoin (prise en charge du pilote, des exemples de code, etc.) Pour un rendu correct d'une image HDR compatible avec les affichages existants.

Au moment de la sortie de la carte vidéo, GeForce GTX 1080, le support de la production HDR présente de tels jeux tels que l'obéduction, le témoin, la législation, la montée de la tombe Raider, Paragon, le principe de Talos et guerrier ombres 2. Mais à proximité avenir, il devrait reconstituer cette liste..

Changements dans le rendu multiple SLI

Il y a eu également des changements associés à la technologie d'entreprise de multiples SLI de rendu, bien que personne n'attendait. SLI est utilisé par les passionnés de jeux PC afin d'accroître la performance ou des valeurs extrêmes, en définissant les cartes vidéo à puce les plus puissantes dans le tandem, ou pour obtenir un taux de trame très élevé, limitant un couple de niveau moyen Les solutions, qui coûtent parfois moins cher qu'un sommet (la décision est controversée, mais faites-la). S'il y a 4k moniteurs, les joueurs n'ont presque aucune autre option, à l'exception de l'installation d'une paire de vidéocamp, car même les meilleurs modèles ne peuvent souvent pas fournir à un jeu confortable à des réglages maximaux dans de telles conditions.

L'un des composants importants de Nvidia SLI est des ponts reliant des cartes vidéo dans une cure vidéo commune et des employés de l'organisation canal numérique En transférant des données entre eux. Sur les cartes vidéo de GeForce, les connecteurs Dual SLI ont été installés traditionnellement, qui servaient à se connecter entre deux ou quatre cartes vidéo dans les configurations SLI 3ème et 4 voies. Chacune des cartes vidéo aurait dû être connectées à chacune, car tous les GPU ont été envoyés avec eux des images dans le processeur graphique principal. Par conséquent, deux interfaces étaient nécessaires sur chacune des planches.

À partir du modèle GeForce GTX 1080, pour toutes les cartes vidéo NVIDIA basées sur l'architecture Pascal, deux interfaces SLI sont connectées ensemble pour augmenter les performances de transmission de données entre cartes vidéo et un nouveau mode SLI à deux canaux vous permet d'améliorer la productivité et Confort Lors de l'affichage des informations visuelles sur des écrans de très haute résolution ou des systèmes multi-composants.

Pour un tel mode, de nouveaux ponts appelés SLI HB étaient nécessaires. Ils combinent une paire de cartes vidéo GeForce GTX 1080 à la fois sur deux canaux SLI, bien que de nouvelles cartes vidéo soient également compatibles avec de vieux ponts. Pour la résolution de 1920 × 1080 et 2560 × 1440 pixels, à une fréquence de mise à jour 60 Hz, vous pouvez utiliser des ponts standard, mais dans des modes plus exigeants (systèmes 4K, 5k et multimonitéels), les meilleurs résultats sur le changement de cadre en douceur fourniront uniquement Nouveaux ponts, bien que l'ancienne fonctionne, mais s'aggrave un peu.

De plus, lorsque vous utilisez des ponts SLI HB, l'interface de transmission de données GeForce GTX 1080 fonctionne à 650 MHz, contre 400 MHz dans des ponts de SLI classiques sur Old GPU. De plus, pour certains des vieux ponts rigides, une fréquence plus élevée de la transmission de données avec des copeaux vidéo de l'architecture Pascal est également disponible. Avec une vitesse croissante de transmission de données entre le GPU sur une double interface SLI avec une fréquence de travail accrue, une sortie de cadre plus fluide est fournie à l'écran, par rapport aux solutions précédentes:

Il convient également de noter que le soutien du rendu multiple de DirectX 12 est quelque peu différent de ce qui était familier plus tôt. Dans la dernière version de l'API graphique, microsoft. Faire de nombreux changements associés au travail de tels systèmes vidéo. Pour les développeurs de logiciels de DX12, deux options d'utilisation de plusieurs GPU sont disponibles: Modes d'affichage multi-affichage (MDA) et adaptateur d'affichage lié (LDA).

De plus, le mode LDA a deux formes: LDA implicite (que NVIDIA utilise pour SLI) et LDA explicite (lorsque le développeur de jeu suppose les tâches de gestion des tâches de gestion de rendu. MDA et modes LDA explicites ont été mis en œuvre dans DirectX 12 afin de donner Les développeurs de jeux sont une plus grande liberté et des opportunités lors de l'utilisation de systèmes vidéo multimédia. La différence entre les modes est clairement visible pour le tableau suivant:

En mode LDA, chaque mémoire GPU peut être associée à la mémoire d'une autre et affichée sous la forme d'un volume total important, naturellement, avec toutes les contraintes de performance lorsque les données vont de la mémoire de quelqu'un d'autre. En mode MDA, chaque mémoire GPU fonctionne séparément et différents GPU ne permettent pas d'accéder directement aux données de la mémoire d'un autre processeur graphique. Le mode LDA est conçu pour les systèmes multi-puretés de performances similaires et le mode MDA comporte moins de restrictions, et des GPU discrètes et intégrés ou des solutions discrètes avec des puces de différents fabricants peuvent travailler ensemble. Mais ce mode nécessite également les développeurs plus d'attention et de travail lors de la programmation de la collaboration pour que le GPU échange des informations les uns avec les autres.

Par défaut, le système SLI basé sur GeForce GTX 1080 Boards prend en charge uniquement deux GPU et des configurations de trois et quatre dimensions ne sont pas officiellement recommandées pour une utilisation, comme dans les jeux modernes, il devient de plus en plus difficile d'assurer des gains de productivité à partir de l'ajout de le troisième et quatrième processeur graphique. Par exemple, de nombreux jeux reposent dans des opportunités processeur central Systèmes Lorsque vous travaillez avec des systèmes vidéo multi-types, des techniques temporelles (temporaires) utilisant des données de cadres précédents sont de plus en plus utilisés dans de nouveaux jeux, dans lesquels le fonctionnement effectif de plusieurs GPU est tout simplement impossible.

Toutefois, le fonctionnement des systèmes dans d'autres systèmes de multithèse (non SLI) reste possible, en tant que modes Explicites MDA ou LDA dans le système SLI DirectX 12 ou à deux types avec un troisième GPU dédié pour des effets physiques de PhysX. Mais qu'en est-il des archives dans les repères, vraiment à Nvidia les refusez-les du tout? Non, bien sûr, mais depuis que de tels systèmes sont en demande dans le monde, presque des unités d'utilisateurs, alors pour de tels ultrantunes, ils ont proposé la clé spéciale de la clé d'enthousiasme, qui peut être téléchargée sur le site Web de NVIDIA et déverrouillez cette opportunité. Pour ce faire, vous devez d'abord obtenir un identifiant GPU unique en exécutant une application spéciale, puis demandez une clé d'enthousiasme sur le site Web et en le téléchargeant, définissez la clé du système, déverrouillant la configuration SLI 3ème et 4 voies.

Technologie de synchronisation de synchronisation rapide

Certaines modifications ont eu lieu dans les technologies de synchronisation lors de l'affichage des informations sur l'écran. Note en avant, rien de nouveau n'est apparu dans la synchronisation G, car la technologie de synchronisation adaptative de synchronisation adaptative n'est pas prise en charge. Mais à Nvidia a décidé d'améliorer la douceur de la sortie et de la synchronisation des jeux qui montrent de très hautes performances lorsque le taux de trame dépasse de manière significative le taux de mise à jour du moniteur. Ceci est particulièrement important pour les jeux nécessitant des retards minimaux et une réponse rapide et sur quelles batailles et la concurrence multijoueur sont organisées.