Limitación del ancho de banda con QoS. Cómo utilizar QoS para garantizar la calidad del acceso a Internet ¿Dónde está el programador de paquetes qos?

En la primera parte de esta serie, cubrí qué hace QoS y para qué se utiliza. En esta parte continuaré la conversación explicando cómo funciona QoS. Al leer este artículo, tenga en cuenta que la información que se presenta aquí se basa en la aplicación QoS de Windows Server 2003, que es diferente de la aplicación QoS en Windows 2000 Server.

API de gestión de tráfico

Uno de los principales problemas de priorizar el tráfico de red es que no se puede priorizar el tráfico en función de la computadora que lo genera. Es común que una sola computadora use múltiples aplicaciones y cree un flujo de tráfico separado para cada aplicación (y sistema operativo). Cuando esto sucede, cada flujo de tráfico debe priorizarse individualmente. Después de todo, una aplicación puede necesitar ancho de banda adicional, mientras que la mejor entrega es ideal para otra aplicación.

Aquí es donde entra en juego la API de control de tráfico (Interfaz de programación de control de tráfico). La API de Traffic Control es una interfaz de programación de aplicaciones que le permite aplicar parámetros de QoS a paquetes individuales. La API Traffic Control funciona definiendo flujos de tráfico individuales y aplicando diferentes métodos de control de QoS a esos flujos.

Lo primero que hace la API de Traffic Control es crear lo que se conoce como filterpec. Filterspec es esencialmente un filtro que define lo que significa que un paquete pertenezca a una secuencia en particular. Algunos de los atributos utilizados por la especificación de filtro incluyen la dirección IP de origen y destino del paquete y el número de puerto.

Una vez que se ha definido la especificación de filtro, la API le permite crear especificación de flujo. Flowspec define los parámetros de QoS que se aplicarán a la secuencia de paquetes. Algunos de los parámetros definidos por la especificación de flujo incluyen la tasa de transferencia (tasa de transferencia aceptable) y el tipo de servicio.

El tercer concepto definido por la API Traffic Control es el concepto de flujo. Un flujo es una secuencia simple de paquetes que están sujetos a la misma especificación de flujo. En términos simples, la especificación de filtro define qué paquetes se incluirán en la especificación de flujo. Flowspec determina si los paquetes se procesarán con prioridades más altas, y el flujo es la transferencia real de paquetes que son procesados por Flowspec. Todos los paquetes del flujo se procesan por igual.

Cabe mencionar que una de las ventajas de la API de control de tráfico sobre la API de QoS genérica utilizada en Windows 2000 es la capacidad de utilizar la agregación (agregación). Si un nodo tiene varias aplicaciones que transmiten múltiples flujos de datos a un destino común, estos paquetes se pueden combinar en un flujo común. Esto es cierto incluso si las aplicaciones utilizan números de puerto diferentes, siempre que las direcciones IP de origen y destino sean las mismas.

Clasificador de paquetes genérico

En la sección anterior, hablé de la relación entre flowpec, filterpec y flow. Sin embargo, es importante recordar que la API de Traffic Control es simplemente una interfaz de programación de aplicaciones. Como tal, su trabajo es definir y priorizar los flujos de tráfico, no crear esos flujos.

El clasificador de paquetes genérico es responsable de crear flujos. Como recordará de la sección anterior, uno de los atributos que se definió en la especificación de flujo fue el tipo de servicio. El tipo de servicio determina esencialmente la prioridad del hilo. El Clasificador Genérico de Paquetes es responsable de determinar el tipo de servicio que se le ha asignado a la especificación de flujo, luego de lo cual pone en cola los paquetes asociados según el tipo de servicio. Cada hilo se coloca en una cola separada.

agendador de paquetes de QoS

El tercer componente de QoS que debe conocer es el programador de paquetes de QoS. En pocas palabras, el trabajo principal de un programador de paquetes de QoS es la configuración del tráfico. Para hacer esto, el programador de paquetes recibe paquetes de varias colas y luego marca estos paquetes con prioridades y velocidad de flujo.

Como mencioné en la primera parte de esta serie de artículos, para que QoS funcione correctamente, los diversos componentes ubicados entre el origen de los paquetes y su destino deben admitir (es decir, tener en cuenta) QoS. Si bien estos dispositivos necesitan saber cómo lidiar con QoS, también necesitan saber cómo manejar el tráfico normal sin prioridades. Para que esto sea posible, QoS utiliza una tecnología llamada etiquetado.

De hecho, aquí hay dos tipos de marcas. El Programador de paquetes de QoS utiliza el etiquetado Diffserv, que es reconocido por los dispositivos de Capa 3, y el etiquetado 802.1p, que es reconocido por los dispositivos de Capa 2.

Configuración del programador de paquetes de QoS

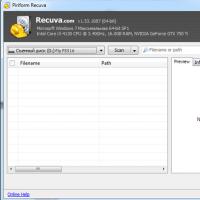

Antes de mostrarle cómo funciona el etiquetado, debe tener en cuenta que deberá configurar el programador de paquetes QoS para que esto funcione. En Windows Server 2003, QoS Packet Scheduler es un componente de red opcional, al igual que el Cliente para redes Microsoft o el protocolo TCP / IP. Para habilitar QoS Packet Scheduler, abra la página de propiedades de la conexión de red de su servidor y marque la casilla junto a QoS Packet Scheduler, como se muestra en la Figura A. Si el QoS Packet Scheduler no aparece en la lista, haga clic en el botón Instalar y siga las instrucciones.

Figura A: El programador de paquetes de QoS debe estar habilitado antes de poder usar QoS

Otra cosa que debe saber sobre el Programador de paquetes de QoS es que su adaptador de red debe admitir el etiquetado 802.1p para que funcione correctamente. Para probar su adaptador, haga clic en el botón Configurar, Figura A, y Windows mostrará las propiedades de su adaptador de red. Si observa la pestaña Avanzado en la página de propiedades, verá las diversas propiedades que admite su adaptador de red.

Si observa la Figura B, puede ver que el etiquetado VLAN 802.1Q / 1P es una de las propiedades enumeradas. También puede ver que esta propiedad está deshabilitada de forma predeterminada. Para habilitar el etiquetado 802.1p, simplemente habilite esta propiedad y haga clic en Aceptar.

Figura B: Debe habilitar el etiquetado VLAN 802.1Q / 1P

Es posible que haya notado en la Figura B que la función que habilitó es el etiquetado de VLAN, no el etiquetado de paquetes. Esto se debe a que los marcadores de prioridad se incluyen en las etiquetas de VLAN. El estándar 802.1Q define VLAN y etiquetas VLAN. Este estándar en realidad reserva tres bits en el paquete VLAN, que se utilizan para escribir el código de prioridad. Desafortunadamente, el estándar 802.1Q nunca especifica cuáles deberían ser estos códigos de prioridad.

El estándar 802.1P se creó para complementar 802.1Q. 802.1P define el etiquetado de prioridad que se puede incluir en una etiqueta VLAN. Les diré cómo funcionan estos dos estándares en la tercera parte.

Conclusión

En este artículo, hemos analizado algunos de los conceptos básicos de la arquitectura QoS de Windows Server 2003. En la Parte 3, entraré en más detalles sobre cómo el Programador de paquetes de QoS marca los paquetes. También discutiré cómo funciona QoS en un entorno de red de ancho de banda bajo.

En este artículo, veremos cómo configurar el ancho de banda reservado en Windows 10. De forma predeterminada, Windows reserva el 20% del ancho de banda total de Internet.

Sí, sí, el sistema operativo Windows 10 reserva un cierto porcentaje del ancho de banda de su conexión a Internet para la calidad de servicio (QoS).

Según Microsoft:

QoS puede incluir operaciones críticas del sistema, como actualizar el sistema Windows, administrar el estado de la licencia, etc. El concepto de ancho de banda reservado se aplica a todos los programas que se ejecutan en el sistema. Normalmente, el programador de paquetes limitará el sistema al 80% del ancho de banda de conectividad. Esto significa que Windows reserva el 20% de su ancho de banda de Internet exclusivamente para QoS.

En caso de que desee reservar ese porcentaje de ancho de banda, este artículo es para usted. A continuación, se muestran dos formas de configurar el ancho de banda reservado en el sistema operativo Windows 10.

NOTA: Si apaga todo el ancho de banda reservado para su sistema, es decir, lo establece en 0%, esto afectará las acciones del sistema operativo, especialmente las actualizaciones automáticas.

Negación de responsabilidad: los pasos adicionales incluirán la edición del registro. Los errores al editar el registro pueden afectar negativamente a su sistema. Por lo tanto, tenga cuidado al editar las entradas del registro y cree primero un punto de restauración del sistema.

Paso 1: Abrir el editor del registro(si no está familiarizado con el Editor del Registro, haga clic en).

Paso 2: En el panel izquierdo de la ventana del Editor del registro, navegue hasta la siguiente sección:

HKEY_LOCAL_MACHINE \ SOFTWARE \ Políticas \ Microsoft \ Windows \ Psched

Nota: Si la sección y el parámetro " NonBestEffortLimit"No existas, solo créalos.

Paso 3: Ahora en el panel derecho de la clave de registro "Psched" busque el parámetro DWORD (32 bits) llamado NonBestEffortLimit... Haga doble clic en él para cambiar sus valores:

De forma predeterminada, el parámetro se establece en 50 en hexadecimal o 80 en notación decimal.

Etapa 4: Seleccione el sistema decimal y establezca el valor igual al porcentaje del ancho de banda reservado requerido.

Por ejemplo si establece el valor en 0 , el ancho de banda reservado para su sistema operativo Windows estará completamente deshabilitado, es decir, igual al 0%. Clic en el botón "OK" y cierre el Editor del Registro.

Paso 5: Reinicie su PC para que los cambios surtan efecto.

Si desea configurar o limitar el ancho de banda reservado en varios equipos de su organización / lugar de trabajo, puede implementar la configuración adecuada en el GPO.

Paso 1: Abra el Editor de políticas de grupo local

Paso 2: Ir a la sección: Configuración del equipo → Plantillas administrativas → Red → Programador de paquetes Qos

Paso 3: En la ventana de la derecha, haga doble clic en la política.

De forma predeterminada, esta política no está establecida y el sistema se reserva 20% ancho de banda de la conexión a Internet. Necesitas habilitarlo, configurar el parámetro "Limita el ancho de banda reservado" significado "Incluido".

No hay una sola persona que no haya leído las preguntas frecuentes sobre Windows XP al menos una vez. Y si es así, entonces todo el mundo sabe que existe una Calidad de Servicio tan dañina, para abreviar, QoS. Al configurar el sistema, es muy recomendable desactivarlo, porque limita el ancho de banda de la red al 20% de forma predeterminada, y como si este problema también existiera en Windows 2000.

Estas son las líneas:

P: ¿Cómo deshabilitar completamente el servicio QoS (Quality of Service)? ¿Cómo lo configuro? ¿Es cierto que limita la velocidad de la red?

R: De hecho, de forma predeterminada, Quality of Service reserva el 20% del ancho de banda del canal para sus necesidades (cualquiera, incluso un módem para 14400, incluso un gigabit Ethernet). Además, incluso si elimina el servicio QoS Packet Scheduler de la conexión de Propiedades, este canal no se libera. Puede liberar el canal o simplemente configurar QoS aquí. Inicie el subprograma de directiva de grupo (gpedit.msc). En Política de grupo, busque Política de equipo local y haga clic en Plantillas administrativas. Seleccione el elemento Red - Programador de paquetes de QoS. Active Limitar ancho de banda reservable. Ahora reducimos el límite de ancho de banda del 20% al 0% o simplemente lo desactivamos. Si lo desea, también puede configurar otros parámetros de QoS aquí. Para activar los cambios realizados, solo queda reiniciar.

El 20% es, por supuesto, mucho. Verdaderamente Microsoft es Mazdai. Las declaraciones de este tipo van de FAQ a FAQ, de foro a foro, de medios a medios, se utilizan en todo tipo de "ajustes": programas para "ajustar" Windows XP (por cierto, abra "Políticas de grupo" y "Local Políticas de seguridad ", y ningún" ajuste "puede igualarlas en la gran cantidad de opciones de personalización). Es necesario tener cuidado de exponer acusaciones infundadas de este tipo, lo que haremos ahora con un enfoque sistemático. Es decir, estudiaremos a fondo el tema problemático, apoyándonos en fuentes primarias oficiales.

¿Qué es una red de servicios de calidad?

Adoptemos la siguiente definición simplificada de un sistema en red. Las aplicaciones se ejecutan y se ejecutan en hosts y se comunican entre sí. Las aplicaciones envían datos al sistema operativo para su transmisión a través de la red. Una vez que los datos se transfieren al sistema operativo, se convierten en tráfico de red.

La calidad de servicio de la red se basa en la capacidad de la red para procesar este tráfico para garantizar que se cumplan las solicitudes de algunas aplicaciones. Esto requiere un mecanismo fundamental para manejar el tráfico de la red que sea capaz de identificar el tráfico que es elegible y controlar el manejo específico.

La funcionalidad QoS está diseñada para satisfacer a dos actores de la red: aplicaciones de red y administradores de red. A menudo tienen desacuerdos. El administrador de red limita los recursos utilizados por una aplicación específica, mientras que la aplicación intenta captar tantos recursos de red como sea posible. Sus intereses pueden conciliarse, teniendo en cuenta que el administrador de la red juega un papel de liderazgo en relación con todas las aplicaciones y usuarios.

Parámetros básicos de QoS

Las diferentes aplicaciones tienen diferentes requisitos para manejar su tráfico de red. Las aplicaciones son más o menos tolerantes a la latencia y la pérdida de tráfico. Estos requisitos han encontrado aplicación en los siguientes parámetros relacionados con la calidad del servicio:

- Ancho de banda: la velocidad a la que el tráfico generado por la aplicación debe enviarse a través de la red.

- Latencia (latencia): la demora que la aplicación puede tolerar en la entrega del paquete de datos;

- Jitter: cambia el tiempo de retardo;

- Pérdida: el porcentaje de datos perdidos.

Si estuvieran disponibles recursos de red infinitos, entonces todo el tráfico de la aplicación podría transmitirse a la velocidad requerida, con latencia cero, variación de latencia cero y pérdida cero. Sin embargo, los recursos de la red no son ilimitados.

El mecanismo de QoS controla la asignación de recursos de red para que el tráfico de aplicaciones cumpla con sus requisitos de transmisión.

Recursos fundamentales de QoS y mecanismos de control del tráfico

Las redes que conectan hosts utilizan una variedad de dispositivos de red, incluidos adaptadores de red de host, enrutadores, conmutadores y concentradores. Cada uno de ellos tiene interfaces de red. Cada interfaz de red puede recibir y transmitir tráfico a una velocidad finita. Si la velocidad a la que se dirige el tráfico a una interfaz es mayor que la velocidad a la que la interfaz reenvía tráfico, se produce una congestión.

Los dispositivos de red pueden manejar la condición de congestión poniendo el tráfico en cola en la memoria del dispositivo (en un búfer) hasta que la congestión termine. En otros casos, el equipo de red puede reducir el tráfico para aliviar la congestión. Como resultado, las aplicaciones se enfrentan a un cambio en la latencia (ya que el tráfico se almacena en colas en las interfaces) o con una pérdida de tráfico.

La capacidad de las interfaces de red para reenviar el tráfico y la disponibilidad de memoria para almacenar el tráfico en los dispositivos de la red (hasta que se pueda enviar más tráfico) constituyen los recursos fundamentales necesarios para proporcionar QoS para los flujos de tráfico de las aplicaciones.

Asignación de recursos de QoS a dispositivos de red

Los dispositivos que admiten QoS utilizan los recursos de red de forma inteligente para transportar tráfico. Es decir, el tráfico de las aplicaciones que son más tolerantes a las latencias se pone en cola (almacenado en un búfer en la memoria) y el tráfico de las aplicaciones que son críticas para la latencia se reenvía.

Para realizar esta tarea, un dispositivo de red debe identificar el tráfico clasificando paquetes y debe tener colas y mecanismos para atenderlos.

Motor de procesamiento de tráfico

El mecanismo de procesamiento de tráfico incluye:

- 802.1p;

- Comportamientos diferenciados por salto (diffserv PHB);

- Servicios integrados (intserv);

- Cajero automático, etc.

La mayoría de las redes de área local se basan en la tecnología IEEE 802, incluida Ethernet, token-ring, etc. 802.1p es un mecanismo de procesamiento de tráfico para admitir QoS en dichas redes.

802.1p define un campo (capa 2 en el modelo de red OSI) en un encabezado de paquete 802 que puede transportar uno de ocho valores de prioridad. Normalmente, los hosts o enrutadores, cuando envían tráfico a la red local, marcan cada paquete enviado, asignándole un cierto valor de prioridad. Se espera que los dispositivos de red, como conmutadores, puentes y concentradores, manejen los paquetes de manera adecuada utilizando mecanismos de cola. 802.1p está limitado a una red de área local (LAN). Tan pronto como el paquete atraviesa la LAN (a través de OSI Layer 3), se elimina la prioridad 802.1p.

Diffserv es un mecanismo de Capa 3. Define un campo en la Capa 3 del encabezado de los paquetes IP llamado punto de código diffserv (DSCP).

Intserv es toda una gama de servicios que definen un servicio garantizado y un servicio que gestiona las descargas. El servicio garantizado promete transportar cierta cantidad de tráfico con una latencia limitada y medible. El servicio que gestiona la carga acepta transportar cierta cantidad de tráfico con una "ligera congestión de la red". Estos son servicios medibles en el sentido de que están definidos para proporcionar QoS medible a una cantidad específica de tráfico.

Debido a que la tecnología ATM fragmenta los paquetes en celdas relativamente pequeñas, puede ofrecer una latencia muy baja. Si necesita enviar un paquete con urgencia, la interfaz ATM siempre puede estar libre para la transmisión durante el tiempo que se tarda en transmitir una celda.

QoS tiene muchos mecanismos más complejos que hacen que esta tecnología funcione. Observemos solo un punto importante: para que QoS funcione, es necesario admitir esta tecnología y una configuración adecuada durante toda la transmisión desde el punto de inicio hasta el punto final.

Una de las áreas más populares en las redes de hoy es la combinación de voz y video en redes de datos tradicionales. Uno de los problemas de este tipo de información es que para que funcione correctamente, los paquetes de datos de vídeo y audio deben transmitirse al destinatario de forma rápida y fiable, sin interrupciones ni retrasos excesivos. Sin embargo, al mismo tiempo, este tipo de tráfico no debería impedir la transmisión de paquetes de datos más tradicionales.

Una posible solución a este problema es QoS. QoS, o calidad de servicio, es una tecnología para priorizar paquetes de datos. QoS le permite transmitir paquetes sensibles al tiempo con una prioridad más alta que otros paquetes.

QoS es un estándar de la industria, no un estándar de Microsoft. Sin embargo, Microsoft introdujo por primera vez este estándar de QoS en Windows 2000. La versión de QoS de Microsoft ha evolucionado bastante desde entonces, pero aún cumple con los estándares de la industria.

En Windows XP Professional, QoS actúa principalmente como un mecanismo de reserva de ancho de banda. Cuando QoS está habilitado, la aplicación puede reservar hasta el 20% del ancho de banda total de la red proporcionado por la NIC de cada máquina. Sin embargo, la cantidad de ancho de banda de red que reserva la aplicación es configurable. Le mostraré cómo cambiar la cantidad de ancho de banda reservado en la Parte 3.

Para ver cómo se utiliza el ancho de banda de repuesto, suponga que tiene una aplicación de videoconferencia que requiere un ancho de banda priorizado para funcionar correctamente. Suponiendo que QoS esté habilitado para esta aplicación, podemos decir que reserva el 20% del ancho de banda total de la máquina, dejando el 80% del ancho de banda para el resto del tráfico de la red.

Todas las aplicaciones, excepto las de videoconferencia, utilizan una tecnología llamada entrega de mejor esfuerzo. Esto significa que los paquetes se envían con la misma prioridad de primero entregado, primero servido. Por otro lado, el tráfico de la aplicación de videoconferencia siempre tendrá prioridad sobre el resto del tráfico, pero nunca se permitirá que la aplicación consuma más del 20% de todo el ancho de banda.

Sin embargo, el hecho de que Windows XP reserve parte del ancho de banda para el tráfico prioritario no significa que las aplicaciones con prioridad normal no puedan utilizar el ancho de banda libre. Aunque las aplicaciones de videoconferencia aprovechan el ancho de banda reservado de mayor prioridad, las posibilidades de que dichas aplicaciones se utilicen constantemente son muy pequeñas. En este caso, Windows permite que otras aplicaciones utilicen el ancho de banda libre y no libre para la mejor entrega posible, siempre que no se utilicen las aplicaciones para las que se reserva parte del ancho de banda de la red.

Tan pronto como se inicia la aplicación de videoconferencia, Windows comienza a hacer cumplir la reserva. Aun así, la reserva no es absoluta. Suponga que Windows ha reservado el 20% del ancho de banda de la red para una aplicación de videoconferencia, pero esta aplicación no necesita todo el 20%. En estos casos, Windows permite que otras aplicaciones usen el ancho de banda restante, pero monitoreará continuamente las necesidades de la aplicación de mayor prioridad. En caso de que la aplicación necesite más ancho de banda, el ancho de banda se le asignará hasta un valor máximo del 20%.

Como dije, QoS es un estándar de la industria, no una tecnología de Microsoft. Como tal, Windows utiliza QoS, pero Windows no puede hacer el trabajo por sí solo. Para que QoS funcione, todos los equipos entre el remitente y el receptor deben admitir QoS. Esto significa que los adaptadores de red, conmutadores, enrutadores y todos los demás dispositivos en uso deben conocer la calidad del servicio, así como los sistemas operativos del destinatario y el remitente.

Si tiene curiosidad, no necesita instalar una infraestructura de red exótica y loca para usar QoS. El modo de transferencia asincrónica (ATM) es una excelente tecnología de red para usar QoS ya que es una tecnología orientada a la conexión, sin embargo, puede usar QoS con otras tecnologías como Frame Relay, Ethernet e incluso Wi-FI (802.11 x).

La razón por la que ATM es una opción tan ideal para QoS es porque es capaz de implementar la reserva de ancho de banda y la asignación de recursos a nivel de hardware. Este tipo de distribución va más allá de las capacidades de Ethernet y tecnologías de redes similares. Esto no significa que no se pueda utilizar QoS. Simplemente significa que QoS debe aplicarse de manera diferente que en un entorno ATM.

En un entorno de cajero automático, los recursos se asignan inmediatamente, a nivel de dispositivo físico. Dado que Ethernet y otras tecnologías similares no pueden asignar recursos de esta manera, las tecnologías de este tipo se basan en la priorización más que en la asignación real de recursos. Esto significa que las reservas de ancho de banda se producen en la capa superior del modelo OSI. Una vez que se ha reservado el ancho de banda, se envían primero los paquetes de mayor prioridad.

Un punto a considerar si va a aplicar QoS a través de Ethernet, Wi-Fi u otras tecnologías similares es que dichas tecnologías no están conectadas. Esto significa que no hay forma de que el remitente verifique el estado del receptor o el estado de la red entre el remitente y el receptor. Esto, a su vez, significa que el remitente puede garantizar que los paquetes con prioridades más altas se enviarán primero, pero no puede garantizar que estos paquetes se entreguen dentro de un cierto período de tiempo. Por otro lado, QoS es capaz de proporcionar este tipo de garantía en las redes ATM, ya que ATM es una tecnología orientada a la conexión.

Windows 2000 vs. Windows Server 2003

Anteriormente hablé sobre cómo Microsoft introdujo QoS por primera vez en Windows 2000 y que esta aplicación de QoS ha evolucionado significativamente desde entonces. Por lo tanto, quiero hablar un poco sobre las diferencias entre QoS en Windows 2000 y en Windows XP y Windows Server 2003 (en los que este estándar se usa aproximadamente de la misma manera).

En Windows 2000, QoS se basaba en la arquitectura Intserv, que no es compatible con Windows XP o Windows Server 2003. La razón por la que Microsoft decidió no usar dicha arquitectura fue que la API subyacente era difícil de usar y la arquitectura tenía problemas. escala.

Algunas organizaciones todavía usan Windows 2000, así que decidí brindarles información sobre cómo funciona la arquitectura QoS de Windows 2000. Windows 2000 usa un protocolo llamado RSVP para reservar recursos de ancho de banda. Cuando se solicita ancho de banda, Windows necesita determinar cuándo se pueden enviar los paquetes. Para hacer esto, Windows 2000 usa un protocolo de señalización llamado SBM (Administrador de ancho de banda de Sunbelt) para decirle al remitente que está listo para recibir paquetes. El Servicio de control de admisión (ACS) verifica que el ancho de banda efectivo esté disponible y luego concede o rechaza la solicitud de ancho de banda.

API de gestión de tráfico

Uno de los principales problemas de priorizar el tráfico de red es que no se puede priorizar el tráfico en función de la computadora que lo genera. Es común que una sola computadora use múltiples aplicaciones y cree un flujo de tráfico separado para cada aplicación (y sistema operativo). Cuando esto sucede, cada flujo de tráfico debe priorizarse individualmente. Después de todo, una aplicación puede necesitar ancho de banda adicional, mientras que la mejor entrega es ideal para otra aplicación.

Aquí es donde entra en juego la API de control de tráfico (Interfaz de programación de control de tráfico). La API de Traffic Control es una interfaz de programación de aplicaciones que le permite aplicar parámetros de QoS a paquetes individuales. La API Traffic Control funciona definiendo flujos de tráfico individuales y aplicando diferentes métodos de control de QoS a esos flujos.

Lo primero que hace la API de Traffic Control es crear lo que se conoce como filterpec. Filterspec es esencialmente un filtro que define lo que significa que un paquete pertenezca a una secuencia en particular. Algunos de los atributos utilizados por la especificación de filtro incluyen la dirección IP de origen y destino del paquete y el número de puerto.

Una vez que se ha definido la especificación de filtro, la API le permite crear especificación de flujo. Flowspec define los parámetros de QoS que se aplicarán a la secuencia de paquetes. Algunos de los parámetros definidos por la especificación de flujo incluyen la tasa de transferencia (tasa de transferencia aceptable) y el tipo de servicio.

El tercer concepto definido por la API Traffic Control es el concepto de flujo. Un flujo es una secuencia simple de paquetes que están sujetos a la misma especificación de flujo. En términos simples, la especificación de filtro define qué paquetes se incluirán en la especificación de flujo. Flowspec determina si los paquetes se procesarán con prioridades más altas, y el flujo es la transferencia real de paquetes que son procesados por Flowspec. Todos los paquetes del flujo se procesan por igual.

Cabe mencionar que una de las ventajas de la API de control de tráfico sobre la API de QoS genérica utilizada en Windows 2000 es la capacidad de utilizar la agregación (agregación). Si un nodo tiene varias aplicaciones que transmiten múltiples flujos de datos a un destino común, estos paquetes se pueden combinar en un flujo común. Esto es cierto incluso si las aplicaciones utilizan números de puerto diferentes, siempre que las direcciones IP de origen y destino sean las mismas.

Clasificador de paquetes genérico

En la sección anterior, hablé de la relación entre flowpec, filterpec y flow. Sin embargo, es importante recordar que la API de Traffic Control es simplemente una interfaz de programación de aplicaciones. Como tal, su trabajo es definir y priorizar los flujos de tráfico, no crear esos flujos.

El clasificador de paquetes genérico es responsable de crear flujos. Como recordará de la sección anterior, uno de los atributos que se definió en la especificación de flujo fue el tipo de servicio. El tipo de servicio determina esencialmente la prioridad del hilo. El Clasificador Genérico de Paquetes es responsable de determinar el tipo de servicio que se le ha asignado a la especificación de flujo, luego de lo cual pone en cola los paquetes asociados según el tipo de servicio. Cada hilo se coloca en una cola separada.

agendador de paquetes de QoS

El tercer componente de QoS que debe conocer es el programador de paquetes de QoS. En pocas palabras, el trabajo principal de un programador de paquetes de QoS es la configuración del tráfico. Para hacer esto, el programador de paquetes recibe paquetes de varias colas y luego marca estos paquetes con prioridades y velocidad de flujo.

Como mencioné en la primera parte de esta serie de artículos, para que QoS funcione correctamente, los diversos componentes ubicados entre el origen de los paquetes y su destino deben admitir (es decir, tener en cuenta) QoS. Si bien estos dispositivos necesitan saber cómo lidiar con QoS, también necesitan saber cómo manejar el tráfico normal sin prioridades. Para que esto sea posible, QoS utiliza una tecnología llamada etiquetado.

De hecho, aquí hay dos tipos de marcas. El Programador de paquetes de QoS utiliza el etiquetado Diffserv, que es reconocido por los dispositivos de Capa 3, y el etiquetado 802.1p, que es reconocido por los dispositivos de Capa 2.

Configuración del programador de paquetes de QoS

Antes de mostrarle cómo funciona el etiquetado, debe tener en cuenta que deberá configurar el programador de paquetes QoS para que esto funcione. En Windows Server 2003, QoS Packet Scheduler es un componente de red opcional, al igual que el Cliente para redes Microsoft o el protocolo TCP / IP. Para habilitar QoS Packet Scheduler, abra la página de propiedades de la conexión de red de su servidor y marque la casilla junto a QoS Packet Scheduler, como se muestra en la Figura A. Si el QoS Packet Scheduler no aparece en la lista, haga clic en el botón Instalar y siga las instrucciones.

Figura A: El programador de paquetes de QoS debe estar habilitado antes de poder usar QoS

Otra cosa que debe saber sobre el Programador de paquetes de QoS es que su adaptador de red debe admitir el etiquetado 802.1p para que funcione correctamente. Para probar su adaptador, haga clic en el botón Configurar, Figura A, y Windows mostrará las propiedades de su adaptador de red. Si observa la pestaña Avanzado en la página de propiedades, verá las diversas propiedades que admite su adaptador de red.

Si observa la Figura B, puede ver que el etiquetado VLAN 802.1Q / 1P es una de las propiedades enumeradas. También puede ver que esta propiedad está deshabilitada de forma predeterminada. Para habilitar el etiquetado 802.1p, simplemente habilite esta propiedad y haga clic en Aceptar.

Figura B: Debe habilitar el etiquetado VLAN 802.1Q / 1P

Es posible que haya notado en la Figura B que la función que habilitó es el etiquetado de VLAN, no el etiquetado de paquetes. Esto se debe a que los marcadores de prioridad se incluyen en las etiquetas de VLAN. El estándar 802.1Q define VLAN y etiquetas VLAN. Este estándar en realidad reserva tres bits en el paquete VLAN, que se utilizan para escribir el código de prioridad. Desafortunadamente, el estándar 802.1Q nunca especifica cuáles deberían ser estos códigos de prioridad.

El estándar 802.1P se creó para complementar 802.1Q. 802.1P define el etiquetado de prioridad que se puede incluir en una etiqueta VLAN.

Señal 802.1P

Como dije en la parte anterior, la señalización 802.1p se realiza en la segunda capa del modelo OSI. Esta capa es utilizada por dispositivos físicos como conmutadores. Los dispositivos de capa 2 que admiten 802.1p pueden ver las marcas de prioridad que se asignan a los paquetes y luego agrupar esos paquetes en clases de tráfico separadas.

En las redes Ethernet, el marcado de prioridad se incluye en las etiquetas VLAN. Las VLAN y las etiquetas de VLAN están definidas por el estándar 802.1Q, que define un campo de prioridad de tres bits, pero no define realmente cómo se debe utilizar este campo de prioridad. Aquí es donde entra en juego el estándar 802.1P.

802.1P define varias clases de prioridad que se pueden utilizar junto con el estándar 802.1Q. En última instancia, 802.1Q deja que el administrador elija el marcado de prioridad, por lo que técnicamente no tiene que seguir las pautas de 802.1P, pero 802.1P parece ser el que todos eligen.

Si bien la idea de utilizar los estándares 802.1P para proporcionar el marcado de Capa 2 probablemente suene a pura teoría, en realidad se puede definir mediante la configuración de la directiva de grupo. El estándar 802.1P proporciona ocho clases de prioridad diferentes (que van de 0 a 7). Los paquetes de mayor prioridad son procesados por QoS con mayor prioridad de entrega.

De forma predeterminada, Microsoft asigna las siguientes marcas de prioridad:

Pero como mencioné anteriormente, puede cambiar estas prioridades modificando varias configuraciones de directiva de grupo. Para hacer esto, abra el editor de políticas de grupo y navegue en el árbol de la consola hasta Configuración del equipo \ Plantillas de administración \ Redes \ Programador de paquetes de QoS \ Valor de prioridad de segundo nivel. Como puede ver en la Figura A, hay configuraciones de directiva de grupo correspondientes a cada una de las etiquetas de prioridad que enumeré anteriormente. Puede asignar sus propios niveles de marcado de prioridad a cualquiera de estos tipos de servicios. Sin embargo, tenga en cuenta que esta configuración de directiva de grupo solo se aplica a los hosts que ejecutan Windows XP, 2003 o Vista.

Figura A: Puede usar el Editor de políticas de grupo para personalizar el marcado de prioridad de segundo nivel.

Servicios diferenciados

Como expliqué en el artículo anterior, QoS realiza el marcado de prioridad en la segunda y tercera capas del modelo OSI. Esto asegura que las prioridades se tengan en cuenta durante todo el proceso de entrega de paquetes. Por ejemplo, los conmutadores operan en la segunda capa del modelo OSI, pero los enrutadores normalmente operan en la tercera capa. Por lo tanto, si los paquetes solo usaran el marcado de prioridad 802.1p, el conmutador daría prioridad a estos paquetes, pero los enrutadores de red ignorarían estas prioridades. Para contrarrestar esto, QoS utiliza el protocolo de servicios diferenciados (Diffserv) para priorizar el tráfico en la tercera capa del modelo OSI. El marcado Diffserv se incluye en los encabezados IP de los paquetes que utilizan TCP / IP.

La arquitectura utilizada por Diffserv fue definida originalmente por RFC 2475. Sin embargo, muchas de las especificaciones de arquitectura se han reescrito en RFC 2474. RFC 2474 define la arquitectura Diffserv para IPv4 e IPv6.

Un punto interesante sobre IPv4 en RFC 2474 es que, aunque Diffserv se ha redefinido por completo, sigue siendo compatible con la especificación RFC 2475 original. Esto significa que los enrutadores más antiguos que no admiten las nuevas especificaciones pueden reconocer las prioridades asignadas.

La aplicación Diffserv actual utiliza los octetos de tipo de paquete Tipo de servicio (TOS) para almacenar el valor Diffserv (llamado valor DSCP). Dentro de este octeto, los primeros seis bits contienen el valor DSCP y los dos últimos bits no se utilizan. La razón por la que estas marcas son retrocompatibles con la especificación RFC 2475 es porque RFC 2475 requería que los primeros tres bits del mismo octeto se usaran en la información de secuencia IP. Aunque los valores de DSCP tienen una longitud de seis bits, los primeros tres bits aún reflejan la secuencia de IP.

Al igual que con el etiquetado 802.1p que demostré anteriormente, puede configurar las prioridades de Diffserv a través de varias configuraciones de directiva de grupo. Antes de mostrarle cómo, presentaré las prioridades estándar de Diffserv utilizadas en Windows:

Es posible que haya notado que las marcas de prioridad de Diffserv utilizan un rango completamente diferente al de 802.1P. En lugar de admitir un rango de 0 a 7, Diffserv admite un rango de marcado de prioridad de 0 a 63, y los números más grandes tienen prioridades más altas.

Como dije anteriormente, Windows le permite definir el marcado de prioridad de Diffserv utilizando la configuración de la Política de grupo. Sin embargo, tenga en cuenta que algunos enrutadores más avanzados asignarán sus propios valores Diffserv a los paquetes, independientemente de lo que asigne Windows.

Con esto en mente, puede configurar el Marcado de prioridad de Diffserv abriendo el Editor de políticas de grupo y navegando a Configuración del equipo \ Plantillas administrativas \ Red \ Programador de paquetes de QoS en el árbol de la consola.

Si observa la Figura B, notará que hay dos pestañas relacionadas con DSCP en la pestaña Programador de paquetes de QoS. Una de estas pestañas le permite asignar el marcado de prioridad DSCP para los paquetes que coinciden con la especificación de flujo, y la otra le permite establecer el marcado de prioridad DSCP para los paquetes que no cumplen. Los parámetros reales en sí mismos son similares para ambas pestañas, como se muestra en la Figura C.

Figura B: Windows administra las marcas de prioridad DSCP por separado para los paquetes que coinciden con la especificación de flujo y los que no.

Figura C: Puede asignar manualmente el marcado de prioridad DSCP para diferentes tipos de servicios.

Configuración de directiva de grupo miscelánea

Si observa la Figura B, notará que hay tres configuraciones de directiva de grupo que no mencioné. Quería mencionar brevemente cuáles son estos parámetros y qué hacen, para aquellos de ustedes que podrían estar interesados.

El parámetro Limitar paquetes pendientes es esencialmente un valor de umbral de servicio. Si el número de paquetes superados alcanza un cierto valor, QoS denegará cualquier asignación de ancho de banda adicional para el adaptador de red hasta que el valor caiga por debajo del umbral máximo permitido.

El parámetro Limitar ancho de banda reservable controla el porcentaje del ancho de banda total que las aplicaciones habilitadas para QoS pueden reservar. De forma predeterminada, las aplicaciones habilitadas para QoS pueden reservar hasta el 80 por ciento del ancho de banda de la red. Por supuesto, cualquier parte del ancho de banda que esté reservado y que no esté siendo utilizado actualmente por las aplicaciones de QoS puede ser utilizado por otras aplicaciones.

El parámetro Establecer resolución del temporizador controla las unidades de tiempo mínimas (en microsegundos) que el programador de paquetes de QoS utilizará para programar paquetes. Básicamente, esta configuración controla la velocidad máxima a la que los paquetes se pueden poner en cola para su entrega.

QoS y módems

En esta era de disponibilidad casi universal de tecnologías de banda ancha, parece extraño hablar de módems. Sin embargo, todavía hay muchas pequeñas empresas y usuarios domésticos que utilizan módems como mecanismo para conectarse a Internet. Recientemente, incluso vi a una gran corporación que usaba módems para comunicarse con oficinas satélites ubicadas en lugares remotos donde la tecnología de banda ancha no está disponible.

Por supuesto, el mayor problema con el uso de módems es el ancho de banda limitado que tienen. Un tema menos obvio pero igualmente importante es que los usuarios generalmente no cambian su comportamiento en línea cuando utilizan conexiones de acceso telefónico. Por supuesto, los usuarios pueden no tener muchas ganas de descargar archivos grandes cuando están conectados a Internet a través de un módem, pero el resto del comportamiento del usuario sigue siendo el mismo que si estuvieran conectados a través de una conexión de banda ancha.

Por lo general, los usuarios no se preocupan demasiado por mantener Microsoft Outlook abierto todo el tiempo o navegar mientras los archivos se descargan en segundo plano. Algunos usuarios también mantienen abierto su sistema de mensajería instantánea en todo momento. El problema con este tipo de comportamiento es que cada una de estas aplicaciones o tareas consume una cierta cantidad de ancho de banda en tu conexión a Internet.

Para ver cómo la calidad del servicio puede ayudar, echemos un vistazo a lo que sucede en circunstancias normales cuando no se utiliza la calidad del servicio. Por lo general, la primera aplicación que intenta acceder a Internet tiene más derechos para usar la conexión. Esto no significa que otras aplicaciones no puedan usar la conexión, sino que Windows piensa que otras aplicaciones no usarán la conexión.

Una vez que se establece la conexión, Windows comienza a ajustar dinámicamente el tamaño de la ventana de recepción de TCP. El tamaño de la ventana de recepción de TCP es la cantidad de datos que se pueden enviar antes de esperar un reconocimiento de que se han recibido los datos. Cuanto mayor sea la ventana de recepción de TCP, mayores serán los paquetes que el remitente puede transmitir antes de esperar una confirmación de entrega exitosa.

El tamaño de la ventana de recepción de TCP debe ajustarse con cuidado. Si la ventana de recepción de TCP es demasiado pequeña, la eficiencia se verá afectada, ya que TCP requiere reconocimientos muy frecuentes. Sin embargo, si la ventana de recepción de TCP es demasiado grande, es posible que la máquina transmita demasiados datos antes de saber que hubo un problema durante la transferencia. Como resultado, se requiere retransmitir una gran cantidad de datos, lo que también afecta la eficiencia.

Cuando una aplicación comienza a utilizar una conexión de acceso telefónico a Internet, Windows ajusta dinámicamente el tamaño de la ventana de recepción de TCP a medida que envía paquetes. El objetivo de Windows aquí es lograr un estado estable en el que el tamaño de la ventana de recepción de TCP esté optimizado.

Ahora, suponga que el usuario abre una segunda aplicación que también requiere una conexión a Internet. Después de hacerlo, Windows inicia el algoritmo de inicio lento de TCP, que es el algoritmo responsable de ajustar el tamaño de la ventana de recepción de TCP al valor óptimo. El problema es que TCP ya está siendo utilizado por una aplicación que se inició anteriormente. Esto afecta a la segunda aplicación de dos formas. Primero, la segunda aplicación tarda mucho más en lograr el tamaño óptimo de la ventana de recepción de TCP. En segundo lugar, la velocidad en baudios de la segunda aplicación siempre será más lenta que la velocidad en baudios de la aplicación de ejecución directa.

La buena noticia es que puede evitar estos problemas en Windows XP y Windows Server 2003 simplemente ejecutando QOS Package Scheduler. Después de eso, QOS Packet Scheduler utilizará automáticamente una tecnología llamada Deficit Round Robin siempre que Windows detecte una velocidad de conexión lenta.

Deficit Round Robin funciona creando dinámicamente colas separadas para cada aplicación que requiere acceso a Internet. Windows sirve estas colas de forma rotatoria que mejora drásticamente la eficiencia de todas las aplicaciones que necesitan acceder a Internet. Si tiene curiosidad, Deficit Round Robin también está disponible en Windows 2000 Server, pero no se enciende automáticamente.

Compartir conexión a Internet

En Windows XP y Windows Server 2003, QoS también facilita el uso compartido de la conexión a Internet. Como probablemente sepa, compartir la conexión a Internet es una forma simplificada de crear un enrutador basado en NAT. La computadora a la que está conectada físicamente la conexión a Internet actúa como un enrutador y un servidor DHCP para otras computadoras en la red, proporcionándoles así acceso a Internet a través de este host. El uso compartido de la conexión a Internet generalmente solo se usa en redes pequeñas de igual a igual que carecen de infraestructura de dominio. Las grandes redes suelen utilizar enrutadores físicos o servicios de enrutamiento y acceso remoto.

En la sección anterior, ya he explicado cómo Windows ajusta dinámicamente el tamaño de la ventana de recepción de TCP. Sin embargo, esta configuración dinámica puede causar problemas al compartir una conexión a Internet. La razón de esto es que las conexiones entre computadoras en una red local suelen ser relativamente rápidas. Normalmente, dicha conexión consta de 100 Mb Ethernet o una conexión inalámbrica 802.11G. Si bien estos tipos de conexiones están lejos de ser las más rápidas, son mucho más rápidas que la mayoría de las conexiones a Internet disponibles en los Estados Unidos. Aquí es donde radica el problema.

La computadora cliente necesita comunicarse a través de Internet, pero no puede hacerlo directamente. En su lugar, utiliza el host para compartir la conexión a Internet como módulo de acceso. Cuando Windows calcula el tamaño óptimo de la ventana de recepción de TCP, lo hace basándose en la velocidad de la conexión entre la máquina local y la máquina de Conexión compartida a Internet. La diferencia entre la cantidad de datos que la máquina local puede recibir de Internet y la cantidad que cree que puede recibir, según la velocidad del host de Conexión compartida a Internet, puede causar problemas. Más específicamente, la diferencia en la velocidad de conexión puede causar situaciones en las que los datos se guarden en una cola conectada a una conexión lenta.

Aquí es donde entra en juego QoS. Si instala QOS Packet Scheduler en un sitio de Conexión compartida a Internet, el host de Conexión compartida a Internet invalidará el tamaño de la ventana de recepción de TCP. Esto significa que el host de Conexión compartida a Internet establecerá el tamaño de la ventana de recepción de TCP para los hosts locales en el mismo tamaño que tendrían si estuvieran conectados directamente a Internet. Esto soluciona problemas causados por velocidades de conexión de red no coincidentes.

Conclusión

En esta serie de artículos, he cubierto QoS y cómo se puede utilizar para dar forma al flujo de tráfico a través de varios tipos de conexiones de red. Como puede ver, QoS puede hacer que la red funcione de manera mucho más eficiente al configurar el tráfico de tal manera que pueda aprovechar la congestión más leve de la red y garantizar una entrega de tráfico más rápida con mayor prioridad.

Brien Posey

El mito de QoS

No hay una sola persona que no haya leído las preguntas frecuentes sobre Windows XP al menos una vez. Y si es así, entonces todo el mundo sabe que existe una Calidad de Servicio tan dañina, para abreviar, QoS. Al configurar el sistema, es muy recomendable desactivarlo, porque limita el ancho de banda de la red al 20% de forma predeterminada, y como si este problema también existiera en Windows 2000.

Estas son las líneas:

"P: ¿Cómo deshabilitar por completo el servicio QoS (Quality of Service)? ¿Cómo configurarlo? ¿Es cierto que limita la velocidad de la red?"

R: De hecho, de forma predeterminada, Quality of Service reserva el 20% del ancho de banda del canal para sus necesidades (cualquiera, incluso un módem para 14400, incluso un gigabit Ethernet). Además, incluso si elimina el servicio QoS Packet Scheduler de la conexión de Propiedades, este canal no se libera. Puede liberar el canal o simplemente configurar QoS aquí. Inicie el subprograma de directiva de grupo (gpedit.msc). En Política de grupo, busque Política de equipo local y haga clic en Plantillas administrativas. Seleccione el elemento Red - Programador de paquetes de QoS. Active Limitar ancho de banda reservable. Ahora reducimos el límite de ancho de banda del 20% al 0% o simplemente lo desactivamos. Si lo desea, también puede configurar otros parámetros de QoS aquí. Para activar los cambios, solo necesita reiniciar ".

El 20% es, por supuesto, mucho. Verdaderamente Microsoft es Mazdai. Las declaraciones de este tipo van de FAQ a FAQ, de foro a foro, de medios a medios, se utilizan en todo tipo de "ajustes": programas para "ajustar" Windows XP (por cierto, abra "Políticas de grupo" y "Local Políticas de seguridad ", y ningún" ajuste "puede igualarlas en la gran cantidad de opciones de personalización). Es necesario tener cuidado de exponer acusaciones infundadas de este tipo, lo que haremos ahora con un enfoque sistemático. Es decir, estudiaremos a fondo el tema problemático, apoyándonos en fuentes primarias oficiales.

¿Qué es una red de servicios de calidad?

Adoptemos la siguiente definición simplificada de un sistema en red. Las aplicaciones se ejecutan y se ejecutan en hosts y se comunican entre sí. Las aplicaciones envían datos al sistema operativo para su transmisión a través de la red. Una vez que los datos se transfieren al sistema operativo, se convierten en tráfico de red.

La calidad de servicio de la red se basa en la capacidad de la red para procesar este tráfico para garantizar que se cumplan las solicitudes de algunas aplicaciones. Esto requiere un mecanismo fundamental para manejar el tráfico de la red que sea capaz de identificar el tráfico que es elegible y controlar el manejo específico.

La funcionalidad QoS está diseñada para satisfacer a dos actores de la red: aplicaciones de red y administradores de red. A menudo tienen desacuerdos. El administrador de red limita los recursos utilizados por una aplicación específica, mientras que la aplicación intenta captar tantos recursos de red como sea posible. Sus intereses pueden conciliarse, teniendo en cuenta que el administrador de la red juega un papel de liderazgo en relación con todas las aplicaciones y usuarios.

Parámetros básicos de QoS

Las diferentes aplicaciones tienen diferentes requisitos para manejar su tráfico de red. Las aplicaciones son más o menos tolerantes a la latencia y la pérdida de tráfico. Estos requisitos han encontrado aplicación en los siguientes parámetros relacionados con la calidad del servicio:

Ancho de banda: la velocidad a la que el tráfico generado por la aplicación debe enviarse a través de la red.

Latencia: la latencia que una aplicación puede tolerar al entregar un paquete de datos.

Jitter: cambia el tiempo de retardo.

Pérdida: el porcentaje de datos perdidos.

Si estuvieran disponibles recursos de red infinitos, entonces todo el tráfico de la aplicación podría transmitirse a la velocidad requerida, con latencia cero, variación de latencia cero y pérdida cero. Sin embargo, los recursos de la red no son ilimitados.

El mecanismo de QoS controla la asignación de recursos de red para que el tráfico de aplicaciones cumpla con sus requisitos de transmisión.

Recursos fundamentales de QoS y mecanismos de control del tráfico

Las redes que conectan hosts utilizan una variedad de dispositivos de red, incluidos adaptadores de red de host, enrutadores, conmutadores y concentradores. Cada uno de ellos tiene interfaces de red. Cada interfaz de red puede recibir y transmitir tráfico a una velocidad finita. Si la velocidad a la que se dirige el tráfico a una interfaz es mayor que la velocidad a la que la interfaz reenvía tráfico, se produce una congestión.

Los dispositivos de red pueden manejar la condición de congestión poniendo el tráfico en cola en la memoria del dispositivo (en un búfer) hasta que la congestión termine. En otros casos, el equipo de red puede reducir el tráfico para aliviar la congestión. Como resultado, las aplicaciones se enfrentan a un cambio en la latencia (ya que el tráfico se almacena en colas en las interfaces) o con una pérdida de tráfico.

La capacidad de las interfaces de red para reenviar el tráfico y la disponibilidad de memoria para almacenar el tráfico en los dispositivos de la red (hasta que se pueda enviar más tráfico) constituyen los recursos fundamentales necesarios para proporcionar QoS para los flujos de tráfico de las aplicaciones.

Asignación de recursos de QoS a dispositivos de red

Los dispositivos que admiten QoS utilizan los recursos de red de forma inteligente para transportar tráfico. Es decir, el tráfico de las aplicaciones que son más tolerantes a las latencias se pone en cola (almacenado en un búfer en la memoria) y el tráfico de las aplicaciones que son críticas para la latencia se reenvía.

Para realizar esta tarea, un dispositivo de red debe identificar el tráfico clasificando paquetes y debe tener colas y mecanismos para atenderlos.

Motor de procesamiento de tráfico

El mecanismo de procesamiento de tráfico incluye:

802.1p

Comportamientos diferenciados por salto (diffserv PHB).

Servicios integrados (intserv).

Cajero automático, etc.

La mayoría de las redes de área local se basan en la tecnología IEEE 802, incluida Ethernet, token-ring, etc. 802.1p es un mecanismo de procesamiento de tráfico para admitir QoS en dichas redes.

802.1p define un campo (capa 2 en el modelo de red OSI) en un encabezado de paquete 802 que puede transportar uno de ocho valores de prioridad. Normalmente, los hosts o enrutadores, cuando envían tráfico a la red local, marcan cada paquete enviado, asignándole un cierto valor de prioridad. Se espera que los dispositivos de red, como conmutadores, puentes y concentradores, manejen los paquetes de manera adecuada utilizando mecanismos de cola. 802.1p está limitado a una red de área local (LAN). Tan pronto como el paquete atraviesa la LAN (a través de OSI Layer 3), se elimina la prioridad 802.1p.

Diffserv es un mecanismo de Capa 3. Define un campo en la Capa 3 del encabezado de los paquetes IP llamado punto de código diffserv (DSCP).

Intserv es toda una gama de servicios que definen un servicio garantizado y un servicio que gestiona las descargas. El servicio garantizado promete transportar cierta cantidad de tráfico con una latencia limitada y medible. El servicio que gestiona la carga acepta transportar cierta cantidad de tráfico con una "ligera congestión de la red". Estos son servicios medibles en el sentido de que están definidos para proporcionar QoS medible a una cantidad específica de tráfico.

Debido a que la tecnología ATM fragmenta los paquetes en celdas relativamente pequeñas, puede ofrecer una latencia muy baja. Si necesita enviar un paquete con urgencia, la interfaz ATM siempre puede estar libre para la transmisión durante el tiempo que se tarda en transmitir una celda.

QoS tiene muchos mecanismos más complejos que hacen que esta tecnología funcione. Observemos solo un punto importante: para que QoS funcione, es necesario admitir esta tecnología y una configuración adecuada durante toda la transmisión desde el punto de inicio hasta el punto final.

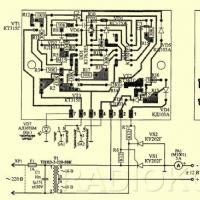

Para mayor claridad, considere la Fig. una.

Aceptamos lo siguiente:

Todos los enrutadores participan en la transmisión de los protocolos requeridos.

Se proporciona una sesión de QoS, que requiere 64 Kbps, entre el Host A y el Host B.

Se inicializa otra sesión, que requiere 64 Kbps, entre el Host A y el Host D.

Para simplificar el diagrama, asumimos que los enrutadores están configurados para que puedan reservar todos los recursos de la red.

En nuestro caso, una solicitud de reserva de 64 Kbps llegaría a tres enrutadores en la ruta de datos entre el Host A y el Host B. Otra solicitud de 64 Kbps llegaría a tres enrutadores entre el Host A y el Host D. Los enrutadores cumplirían estas solicitudes de reserva de recursos porque lo hacen no exceda el máximo. En cambio, si ambos hosts B y C iniciaran simultáneamente una sesión de QoS de 64 Kbps con el host A, entonces el enrutador que atiende a estos hosts (B y C) negaría una de las conexiones.

Ahora suponga que el administrador de la red desactiva el procesamiento de QoS en los tres enrutadores inferiores que sirven a los hosts B, C, D, E. En este caso, las solicitudes de recursos de hasta 128 Kbps se cumplirían independientemente de la ubicación del host participante. Sin embargo, la garantía de calidad sería baja porque el tráfico de un host comprometería el tráfico de otro. QoS podría mantenerse si el enrutador superior limitara todas las solicitudes a 64 Kbps, pero esto daría como resultado un uso ineficiente de los recursos de la red.

Por otro lado, el ancho de banda de todas las conexiones de red podría aumentarse a 128 Kbps. Pero el ancho de banda aumentado solo se utilizará cuando los hosts B y C (o D y E) soliciten recursos simultáneamente. Si este no es el caso, los recursos de la red se utilizarán nuevamente de manera ineficiente.

Componentes de Microsoft QoS

Windows 98 contiene solo componentes de QoS a nivel de usuario, que incluyen:

Componentes de la aplicación.

API de GQoS (parte de Winsock 2).

Proveedor de servicios de QoS.

El sistema operativo Windows 2000 / XP / 2003 contiene todo lo anterior y los siguientes componentes:

Proveedor de servicios de protocolo de reserva de recursos (Rsvpsp.dll) y servicios RSVP (Rsvp.exe) y QoS ACS. No se utiliza en Windows XP, 2003.

Control de tráfico (Traffic.dll).

Clasificador de paquetes genérico (Msgpc.sys). El clasificador de paquetes identifica la clase de servicio a la que pertenece el paquete. En este caso, el paquete se entregará en la cola correspondiente. Las colas son administradas por QoS Packet Scheduler.

Programador de paquetes de QoS (Psched.sys). Define los parámetros de QoS para un flujo de datos específico. El tráfico está etiquetado con un valor de prioridad específico. El Programador de paquetes de QoS determina la programación de la cola para cada paquete y maneja las solicitudes en competencia entre los paquetes en cola que necesitan acceso concurrente a la red.

El diagrama de la Figura 2 ilustra la pila de protocolos, los componentes de Windows y cómo interactúan en un host. Los elementos utilizados en Windows 2000 pero no utilizados en Windows XP / 2003 no se muestran en el diagrama.

Las aplicaciones están en la parte superior de la pila. Es posible que conozcan o no la calidad del servicio. Para aprovechar todo el poder de QoS, Microsoft recomienda utilizar llamadas API de QoS genéricas en las aplicaciones. Esto es especialmente importante para aplicaciones que requieren garantías de servicio de alta calidad. Se pueden utilizar varias utilidades para invocar QoS en nombre de aplicaciones que no son conscientes de QoS. Funcionan a través de la API de gestión del tráfico. Por ejemplo, NetMeeting usa la API de GQoS. Pero para tales aplicaciones, la calidad no está garantizada.

El ultimo clavo

Los puntos teóricos anteriores no dan una respuesta inequívoca a la pregunta de adónde va el notorio 20% (que, observo, nadie ha medido exactamente todavía). Con base en lo anterior, este no debería ser el caso. Pero los oponentes presentan un nuevo argumento: el sistema QoS es bueno, pero la implementación es torcida. En consecuencia, después de todo, el 20% está "harto". Aparentemente, el problema también ha desgastado al gigante del software, ya que ya ha negado por separado tales fabricaciones durante bastante tiempo.

Sin embargo, cedamos la palabra a los desarrolladores y presentemos momentos seleccionados del artículo "316666 - Mejoras y comportamiento de la calidad de servicio (QoS) de Windows XP" en ruso literario:

"El cien por ciento del ancho de banda de la red está disponible para compartir entre todos los programas, a menos que un programa solicite explícitamente el ancho de banda priorizado. Este ancho de banda" reservado "está disponible para otros programas si el programa que lo solicitó no envía datos.

De forma predeterminada, los programas pueden reservar hasta un 20% de la velocidad de conexión principal en cada interfaz de computadora. Si el programa que reservó el ancho de banda no envía suficientes datos para usarlo, la parte no utilizada del ancho de banda reservado está disponible para otros flujos de datos.

Ha habido declaraciones en varios artículos técnicos y grupos de noticias que Windows XP siempre reserva el 20% del ancho de banda disponible para QoS. Estas declaraciones son incorrectas ".

Si ahora alguien todavía está consumiendo el 20% del ancho de banda, bueno, puedo aconsejarle que continúe utilizando más todo tipo de "ajustes" y controladores de red asimétricos. Y no tanto será "engordado".

¡Todos, el mito de QoS, mueran!

Yuri Trofimov,

X360ce: conecte cualquier joystick (instrucciones para la versión anterior) Instale el joystick en la PC desde Xbox 360

X360ce: conecte cualquier joystick (instrucciones para la versión anterior) Instale el joystick en la PC desde Xbox 360 Recuperar contactos en Android

Recuperar contactos en Android Código promocional pizza empire octubre

Código promocional pizza empire octubre Por qué el volante no se conecta a la computadora

Por qué el volante no se conecta a la computadora Cómo conectar una rueda de juego a una computadora

Cómo conectar una rueda de juego a una computadora Cómo llevar un diario personal y para qué sirve

Cómo llevar un diario personal y para qué sirve Cargador "Cedar": descripción, instrucciones

Cargador "Cedar": descripción, instrucciones