Cum se editează fișierul robots txt. Cum să editați un fișier txt robot Creați un fișier txt robot

Acest articol conține un exemplu de cod optim, după părerea mea, pentru fișierul robots.txt pentru WordPress, pe care îl puteți folosi în site-urile dvs.

Pentru început, să ne amintim de ce ai nevoie de robots.txt- fișierul robots.txt este necesar exclusiv pentru roboții de căutare pentru a le „spune” ce secțiuni/pagini ale site-ului să le viziteze și pe care nu ar trebui să le viziteze. Paginile care sunt închise de la vizitare nu vor fi incluse în indexul motorului de căutare (Yandex, Google etc.).

Opțiunea 1: Cod robots.txt optim pentru WordPress

User-agent: * Disallow: /cgi-bin # classic... Disallow: /? # toți parametrii de interogare de pe pagina principală Disallow: /wp- # toate fișierele WP: /wp-json/, /wp-includes, /wp-content/plugins Disallow: *?s= # search Disallow: *&s= # search Nu permiteți: /căutare # Căutare Nu permiteți: /autor/ # arhiva autor Nu permiteți: */embed # toate înglobările Nu permiteți: */page/ # toate tipurile de paginare Permite: */încărcări # încărcări deschise Permite: /*/*.js # în interiorul /wp - (/*/ - pentru prioritate) Permite: /*/*.css # în interiorul /wp- (/*/ - pentru prioritate) Permite: /wp-*.png # imagini în pluginuri, folderul cache etc. . Permite: /wp-*.jpg # imagini în pluginuri, folderul cache etc. Permite: /wp-*.jpeg # imagini în pluginuri, folderul cache etc. Permite: /wp-*.gif # imagini în pluginuri, folderul cache etc. Permite: /wp-*.svg # imagini în pluginuri, folderul cache etc. Permite: /wp-*.pdf # fișiere în pluginuri, folderul cache etc. Permite: /wp-admin/admin-ajax.php #Disallow: /wp/ # când WP este instalat în subdirectorul wp Sitemap: http://example.com/sitemap.xml Sitemap: http://example.com/ sitemap2.xml # alt fișier #Sitemap: http://example.com/sitemap.xml.gz # versiune comprimată (.gz) # Versiune cod: 1.1 # Nu uitați să schimbați `site.ru` pe site-ul dvs.Analiza codului:

- Disallow: /cgi-bin - închide directorul de scripturi de pe server

- Disallow: /feed - închide fluxul RSS al blogului

- Disallow: /trackback - închide notificările

- Disallow: ?s= sau Disallow: *?s= - închide paginile de căutare

- Disallow: */page/ - închide toate tipurile de paginare

Regula Sitemap: http://example.com/sitemap.xml indică robotul către un fișier cu un sitemap în format XML. Dacă aveți un astfel de fișier pe site-ul dvs., atunci scrieți calea completă către el. Pot exista mai multe astfel de fișiere, apoi indicăm calea către fiecare separat.

În linia Gazdă: site.ru indicăm oglinda principală a site-ului. Dacă un site are oglinzi (copii ale site-ului pe alte domenii), atunci pentru ca Yandex să le indexeze pe toate în mod egal, trebuie să specificați oglinda principală. Directiva gazdă: numai Yandex înțelege, Google nu înțelege! Dacă site-ul funcționează sub protocolul https, atunci trebuie specificat în Gazdă: Gazdă: http://example.com

Din documentația Yandex: „Gazda este o directivă independentă și funcționează oriunde în fișier (intersecțional).” Prin urmare, îl punem în partea de sus sau chiar la sfârșitul fișierului, printr-o linie goală.

În linia User-agent: * indicăm că toate regulile de mai jos vor funcționa pentru toți roboții de căutare *. Dacă aveți nevoie de aceste reguli să funcționeze doar pentru un robot specific, atunci în loc de * indicăm numele robotului (User-agent: Yandex, User-agent: Googlebot).

În linia Permite: */încărcări, permitem în mod intenționat indexarea paginilor care conțin /încărcări. Această regulă este obligatorie, deoarece mai sus interzicem indexarea paginilor care încep cu /wp- și /wp- inclus în /wp-content/uploads. Prin urmare, pentru a anula regula Disallow: /wp-, aveți nevoie de linia Allow: */uploads , deoarece pentru link-uri precum /wp-content/uploads/... Este posibil să avem imagini care trebuie indexate și pot exista și unele fișiere descărcate pe care nu este nevoie să le ascundem. Permite: poate fi „înainte” sau „după” Disallow: .

Rândurile rămase interzic roboților să „urmărească” link-uri care încep cu:

Deoarece prezența fluxurilor deschise este necesară, de exemplu, pentru Yandex Zen, atunci când trebuie să conectați un site la un canal (mulțumită comentatorului „Digital”). Poate că sunt necesare fluxuri deschise în altă parte.

În același timp, feedurile au propriul format în anteturile de răspuns, datorită căruia motoarele de căutare înțeleg că aceasta nu este o pagină HTML, ci un feed și, evident, o procesează într-un fel diferit.

Directiva Gazdă nu mai este necesară pentru Yandex

Yandex abandonează complet directiva Gazdă și a înlocuit-o cu o redirecționare 301. Gazda poate fi eliminată în siguranță de pe robots.txt. Cu toate acestea, este important ca toate oglinzile site-ului să aibă o redirecționare 301 către site-ul principal (oglindă principală).

Acest lucru este important: regulile de sortare înainte de procesare

Yandex și Google procesează directivele Allow și Disallow nu în ordinea în care sunt specificate, dar mai întâi le sortează de la regula scurtă la lungă, apoi procesează ultima regulă de potrivire:

Agent utilizator: * Permite: */încărcări Nu permite: /wp-

va fi citit ca:

User-agent: * Disallow: /wp- Allow: */uploads

Pentru a înțelege și aplica rapid funcția de sortare, amintiți-vă această regulă: „cu cât regula este mai lungă în robots.txt, cu atât are prioritate mai mare. Dacă lungimea regulilor este aceeași, atunci se acordă prioritate directivei Allow.”

Opțiunea 2: robots.txt standard pentru WordPress

Nu știu de ce, dar sunt pentru prima opțiune! Pentru că este mai logic - nu este nevoie să duplicați complet secțiunea pentru a indica directiva Gazdă pentru Yandex, care este intersecțională (înțeleasă de robot oriunde în șablon, fără a indica la ce robot se referă). În ceea ce privește directiva non-standard Allow, funcționează pentru Yandex și Google, iar dacă nu deschide folderul de încărcări pentru alți roboți care nu o înțeleg, atunci în 99% din cazuri acest lucru nu va implica nimic periculos. Încă nu am observat că primii roboți nu funcționează așa cum ar trebui.

Codul de mai sus este puțin incorect. Mulțumesc comentatorului „ ” pentru că a subliniat incorectitudinea, deși a trebuit să-mi dau seama despre ce este vorba. Și asta este ceea ce am venit (s-ar putea să greșesc):

- Directiva Yandex Gazdă: trebuie utilizată după Disallow:, deoarece este posibil ca unii roboți (nu Yandex și Google) să nu o înțeleagă și să respingă, în general, robots.txt. Yandex însuși, judecând după documentație, nu-i pasă de unde și cum să folosești Host:, chiar dacă în general creați robots.txt cu o singură linie Host: www.site.ru pentru a lipi toate oglinzile site-ului împreună.

Unii roboți (nu Yandex și Google) nu înțeleg mai mult de 2 directive: User-agent: și Disallow:

3. Sitemap: o directivă intersecțională pentru Yandex și Google și, aparent, pentru mulți alți roboți, așa că o scriem la sfârșit cu o linie goală și va funcționa pentru toți roboții simultan.

Pe baza acestor modificări, codul corect ar trebui să arate astfel:

Agent de utilizator: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-json/ Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */embed Disallow: */page/ Disallow: /cgi-bin Disallow: *?s= Allow: /wp-admin/admin-ajax.php Gazdă: site.ru User-agent: * Disallow: /wp-admin Disallow : /wp-includes Disallow: /wp-content/plugins Disallow: /wp-json/ Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */embed Disallow: */page/ Disallow: / cgi-bin Disallow: *?s= Allow: /wp-admin/admin-ajax.php Sitemap: http://example.com/sitemap.xmlSă-l adăugăm pentru noi înșine

Dacă trebuie să blocați orice alte pagini sau grupuri de pagini, puteți adăuga o regulă (directivă) mai jos Nu permiteți:. De exemplu, trebuie să închidem toate intrările dintr-o categorie de la indexare știri, apoi înainte Harta site-ului: adauga o regula:

Nu permiteți: /știri

Împiedică roboții să urmărească astfel de link-uri:

- http://example.com/news

- http://example.com/news/drugoe-nazvanie/

Dacă trebuie să închideți orice apariție a /news , atunci scrieți:

Nu permiteți: */știri

- http://example.com/news

- http://example.com/my/news/drugoe-nazvanie/

- http://example.com/category/newsletter-nazvanie.html

Puteți studia directivele robots.txt mai detaliat pe pagina de ajutor Yandex (dar rețineți că nu toate regulile descrise acolo funcționează pentru Google).

Verificare și documentare Robots.txt

Puteți verifica dacă regulile prescrise funcționează corect utilizând următoarele link-uri:

- Yandex: http://webmaster.yandex.ru/robots.xml.

- La Google acest lucru se face în Consolă de căutare. Ai nevoie de autorizație și de prezența site-ului în panoul webmaster...

- Serviciu pentru crearea unui fișier robots.txt: http://pr-cy.ru/robots/

- Serviciu pentru crearea și verificarea robots.txt: https://seolib.ru/tools/generate/robots/

L-am întrebat pe Yandex...

Am pus o întrebare în tehnologie. Asistență Yandex cu privire la utilizarea intersecțională a directivelor Gazdă și Sitemap:

Întrebare:

Buna ziua!

Scriu un articol despre robots.txt pe blogul meu. Aș dori să primesc un răspuns la această întrebare (nu am găsit un „da” clar în documentație):Dacă trebuie să lipesc toate oglinzile și pentru asta folosesc directiva Host chiar la începutul fișierului robots.txt:

Gazdă: site.ru Agent utilizator: * Nu permite: /asd

Va funcționa corect Host: site.ru în acest exemplu? Va indica roboților că site.ru este oglinda principală? Acestea. Folosesc această directivă nu într-o secțiune, ci separat (la începutul fișierului) fără a indica la ce User-agent se referă.

De asemenea, am vrut să știu dacă directiva Sitemap trebuie folosită în interiorul unei secțiuni sau poate fi folosită în exterior: de exemplu, printr-o linie goală, după o secțiune?

User-agent: Yandex Disallow: /asd User-agent: * Disallow: /asd Sitemap: http://example.com/sitemap.xml

Va înțelege robotul directiva Sitemap din acest exemplu?

Sper să primesc de la dumneavoastră un răspuns care să-mi pună capăt îndoielilor.

Răspuns:

Buna ziua!

Directivele Gazdă și Sitemap sunt intersecționale, așa că vor fi utilizate de robot indiferent de locul din fișierul robots.txt în care sunt specificate.

--

Cu stimă, Platon Shchukin

Serviciu de asistență Yandex

Concluzie

Este important să rețineți că modificările în robots.txt pe un site deja funcțional vor fi observate numai după câteva luni (2-3 luni).

Există zvonuri că uneori Google poate ignora regulile din robots.txt și poate duce o pagină în index dacă consideră că pagina este foarte unică și utilă și pur și simplu trebuie să fie în index. Cu toate acestea, alte zvonuri infirmă această ipoteză prin faptul că optimizatorii neexperimentați pot specifica incorect regulile în robots.txt și astfel pot închide paginile necesare de la indexare și pot lăsa pe cele inutile. Sunt mai înclinat spre a doua presupunere...

Roboti dinamici.txt

În WordPress, cererea pentru fișierul robots.txt este procesată separat și nu este deloc necesară crearea fizică a unui fișier robots.txt în rădăcina site-ului, mai mult, acest lucru nu este recomandat, deoarece cu această abordare va fi este foarte dificil pentru plugin-uri să schimbe acest fișier, iar acest lucru este uneori necesar.

Citiți despre cum funcționează crearea dinamică a unui fișier robots.txt în descrierea funcției, iar mai jos voi da un exemplu despre cum puteți schimba conținutul acestui fișier din mers, printr-un cârlig.

Pentru a face acest lucru, adăugați următorul cod în fișierul functions.php:

Add_action("do_robotstxt", "my_robotstxt"); funcția my_robotstxt())( $lines = [ "User-agent: *", "Disallow: /wp-admin/", "Disallow: /wp-includes/", "", ]; echo implode ("\r\ n ", $linii); die; // termina munca PHP)

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/

Crawl-delay - timeout pentru roboții nebuni (nu luați în considerare din 2018)

Yandex

După ce am analizat scrisorile din ultimii doi ani către suportul nostru cu privire la problemele de indexare, am aflat că unul dintre principalele motive pentru descărcarea lentă a documentelor este o directivă de întârziere cu crawlere configurată incorect în robots.txt […] Astfel încât proprietarii de site-uri să nu mai fie trebuie să vă faceți griji pentru acest lucru și Pentru a ne asigura că toate paginile site-ului web cu adevărat necesare apar și sunt actualizate rapid în căutare, am decis să renunțăm la directiva Crawl-delay.

Când robotul Yandex scanează site-ul ca un nebun și acest lucru creează încărcare inutilă pe server. Puteți cere robotului să „încetinească”.

Pentru a face acest lucru, trebuie să utilizați directiva Crawl-delay. Indică timpul în secunde în care robotul trebuie să stea inactiv (să aștepte) pentru a scana fiecare pagină ulterioară a site-ului.

Pentru compatibilitatea cu roboții care nu respectă bine standardul robots.txt, întârzierea cu crawlere trebuie specificată în grup (în secțiunea User-Agent) imediat după Disallow și Allow

Yandex Robot înțelege valorile fracționale, de exemplu, 0,5 (jumătate de secundă). Acest lucru nu garantează că robotul de căutare vă va vizita site-ul la fiecare jumătate de secundă, dar vă permite să accelerați accesarea cu crawlere a site-ului.

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Crawl-delay: 1,5 # timeout 1,5 secunde User-agent: * Disallow: /wp-admin Disallow: /wp-includes Allow: /wp-* . gif Întârziere accesare cu crawlere: 2 # timeout 2 secunde

Googlebot nu înțelege directiva Crawl-delay. Timeout-ul pentru roboții săi poate fi specificat în panoul webmaster.

Pe serviciul avi1.ru puteți achiziționa acum promovarea SMM în mai mult de 7 dintre cele mai populare rețele sociale. În același timp, acordați atenție costului destul de scăzut al tuturor serviciilor site-ului.

Navigare rapidă pe această pagină:

Realitatea modernă este că în RuNet, niciun site care se respectă nu se poate descurca fără un fișier numit robots.txt - chiar dacă nu ai nimic de interzis indexarea (deși aproape fiecare site are pagini tehnice și conținut duplicat care necesită închiderea de la indexare). ), apoi Cel puțin, merită cu siguranță să înregistrați o directivă cu www și fără www pentru Yandex - pentru asta sunt regulile pentru scrierea robots.txt, care vor fi discutate mai jos.

Ce este robots.txt?

Un fișier cu acest nume datează din 1994, când consorțiul W3C a decis să introducă un astfel de standard pentru ca site-urile să poată furniza motoarele de căutare instrucțiuni de indexare.

Un fișier cu acest nume trebuie salvat în directorul rădăcină al site-ului; nu este permisă plasarea lui în orice alte foldere.

Fișierul îndeplinește următoarele funcții:

- interzice indexarea oricăror pagini sau grupuri de pagini

- permite indexarea oricăror pagini sau grupuri de pagini

- indică robotului Yandex care oglindă a site-ului este cea principală (cu www sau fără www)

- arată locația fișierului sitemap

Toate cele patru puncte sunt extrem de importante pentru optimizarea motorului de căutare a site-urilor web. Blocarea indexării vă permite să blocați paginile de indexare care conțin conținut duplicat - de exemplu, pagini de etichetare, arhive, rezultate de căutare, pagini cu versiuni imprimabile și așa mai departe. Prezența conținutului duplicat (atunci când același text, chiar și de dimensiunea mai multor propoziții, este prezent pe două sau mai multe pagini) este un minus pentru site în clasamentele motoarelor de căutare, prin urmare ar trebui să existe cât mai puține duplicate posibil.

Directiva allow nu are un sens independent, deoarece implicit toate paginile sunt deja disponibile pentru indexare. Funcționează împreună cu disallow - atunci când, de exemplu, o anumită categorie este complet închisă de motoarele de căutare, dar doriți să deschideți această pagină sau o pagină separată în ea.

Arătarea către oglinda principală a site-ului este, de asemenea, unul dintre cele mai importante elemente în optimizare: motoarele de căutare văd site-urile www.yoursite.ru și yoursite.ru ca două resurse diferite, dacă nu le spui direct altfel. Rezultatul este o dublare a conținutului - apariția duplicatelor, o scădere a puterii legăturilor externe (linkurile externe pot fi plasate atât cu www, cât și fără www) și ca urmare, acest lucru poate duce la o clasare mai scăzută în rezultatele căutării.

Pentru Google, oglinda principală este înregistrată în instrumentele pentru webmasteri (http://www.google.ru/webmasters/), dar pentru Yandex aceste instrucțiuni pot fi înregistrate numai în același robots.tkht.

Indicarea către un fișier xml cu o hartă de site (de exemplu, sitemap.xml) permite motoarelor de căutare să detecteze acest fișier.

Reguli pentru specificarea User-agent

Agentul utilizator în acest caz este motorul de căutare. Când scrieți instrucțiuni, trebuie să indicați dacă acestea se vor aplica tuturor motoarele de căutare (caz în care este indicat un asterisc - *) sau dacă sunt destinate unui anumit motor de căutare - de exemplu, Yandex sau Google.

Pentru a seta un User-agent care indică toți roboții, scrieți următoarea linie în fișierul dvs.:

Agent utilizator: *

Pentru Yandex:

Agent utilizator: Yandex

Pentru Google:

Agent utilizator: GoogleBot

Reguli pentru specificarea interzicerii și permiterii

În primul rând, trebuie remarcat faptul că fișierul robots.txt trebuie să conțină cel puțin o directivă disallow pentru a fi valid. Acum să ne uităm la aplicarea acestor directive folosind exemple specifice.

Folosind acest cod, permiteți indexarea tuturor paginilor site-ului:

User-agent: * Nu permiteți:

Și cu acest cod, dimpotrivă, toate paginile vor fi închise:

Agent utilizator: * Nu permite: /

Pentru a interzice indexarea unui anume director numit folder, specificați:

User-agent: * Disallow: /folder

De asemenea, puteți utiliza asteriscuri pentru a înlocui un nume arbitrar:

Agent utilizator: * Nu permite: *.php

Important: asteriscul înlocuiește întregul nume de fișier, adică nu puteți specifica fișier*.php, doar *.php (dar toate paginile cu extensia .php vor fi interzise; pentru a evita acest lucru, puteți specifica o anumită adresă de pagină) .

Directiva allow, așa cum sa menționat mai sus, este folosită pentru a crea excepții în disallow (altfel nu are sens, deoarece paginile sunt deja deschise implicit).

De exemplu, vom interzice indexarea paginilor din folderul arhivă, dar vom lăsa deschisă pagina index.html din acest director:

Permite: /archive/index.html Disallow: /archive/

Specificați gazda și harta site-ului

Gazda este oglinda principală a site-ului (adică numele domeniului plus www sau numele domeniului fără acest prefix). Gazda este specificată numai pentru robotul Yandex (în acest caz, trebuie să existe cel puțin o comandă de respingere).

Pentru a specifica o gazdă, robots.txt trebuie să conțină următoarea intrare:

Agent utilizator: Yandex Disallow: Gazdă: www.yoursite.ru

În ceea ce privește harta site-ului, în robots.txt harta site-ului este indicată prin simpla scriere a căii complete către fișierul corespunzător, indicând numele domeniului:

Harta site-ului: http://yoursite.ru/sitemap.xml

Este scris despre cum să faci un sitemap pentru WordPress.

Exemplu robots.txt pentru WordPress

Pentru WordPress, instrucțiunile trebuie specificate în așa fel încât să închidă toate directoarele tehnice (wp-admin, wp-includes etc.) pentru indexare, precum și paginile duplicate create de etichete, fișiere RSS, comentarii și căutare.

Ca exemplu de robots.txt pentru wordpress, puteți prelua fișierul de pe site-ul nostru:

Agent de utilizator: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /search Disallow: */trackback Disallow: */feed/ Nu permite: */feed Disallow: */comments/ Disallow: /?feed= Disallow: /?s= Disallow: */page/* Disallow: */comment Disallow: */tag/* Disallow: */ atașament/* Permite: /wp-content/uploads/ Gazdă: www..php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /search Disallow: */trackback Disallow: */feed/ Disallow: * /feed Disallow: */comments/ Disallow: /?feed= Disallow: /?s= Disallow: */page/* Disallow: */comment Disallow: */tag/* Disallow: */attachment/* Permite: /wp -content/uploads/ User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /search Disallow: */trackback Disallow: */feed/ Disallow: */feed Disallow: */comments/ Disallow: /?feed= Disallow: /?s= Disallow: */page/* Disallow: */comment Disallow: */tag/ * Nu permiteți: */attachment/* Permiteți: /wp-content/uploads/ Sitemap: https://www..xml

Puteți descărca fișierul robots.txt de pe site-ul nostru web folosind .

Daca dupa ce ai citit acest articol mai ai intrebari, intreaba in comentarii!

Aproape fiecare proiect care vine la noi pentru audit sau promovare are un fișier robots.txt incorect și adesea lipsește cu totul. Acest lucru se întâmplă pentru că atunci când se creează un fișier, fiecare este ghidat de imaginația sa, și nu de reguli. Să ne dăm seama cum să compunem corect acest fișier, astfel încât roboții de căutare să lucreze cu el în mod eficient.

De ce trebuie să configurați robots.txt?

Robots.txt este un fișier situat în directorul rădăcină al unui site care le spune roboților motoarelor de căutare ce secțiuni și pagini ale site-ului pot accesa și pe care nu.

Configurarea robots.txt este o parte importantă în rezultatele motoarelor de căutare; roboții configurați corespunzător măresc și performanța site-ului. Lipsa Robots.txt nu va împiedica motoarele de căutare să acceseze cu crawlere și să indexeze site-ul dvs., dar dacă nu aveți acest fișier, este posibil să aveți două probleme:

Robotul de căutare va citi întregul site, ceea ce va „submina” bugetul de crawling. Bugetul de accesare cu crawlere este numărul de pagini pe care un robot de căutare este capabil să le acceseze cu crawlere într-o anumită perioadă de timp.

Fără un fișier roboți, motorul de căutare va avea acces la pagini nefinalizate și ascunse, la sute de pagini folosite pentru administrarea CMS-ului. Le va indexa, iar când vine vorba de paginile necesare care oferă conținut direct pentru vizitatori, bugetul de crawling se va „epuiza”.

Indexul poate include pagina de conectare a site-ului și alte resurse de administrator, astfel încât un atacator le poate urmări cu ușurință și poate efectua un atac ddos sau hack site-ul.

Cum văd roboții de căutare un site cu și fără robots.txt:

Sintaxa Robots.txt

Înainte de a începe să înțelegem sintaxa și să setăm robots.txt, să ne uităm la cum ar trebui să arate „fișierul ideal”:

Dar nu ar trebui să-l folosești imediat. Fiecare site necesită cel mai adesea propriile setări, deoarece toți avem o structură diferită a site-ului și un CMS diferit. Să ne uităm la fiecare directivă în ordine.

Agent utilizator

User-agent - definește un robot de căutare care trebuie să urmeze instrucțiunile descrise în fișier. Dacă trebuie să vă adresați tuturor simultan, utilizați pictograma *. De asemenea, puteți contacta un anumit robot de căutare. De exemplu, Yandex și Google:

Folosind această directivă, robotul înțelege ce fișiere și foldere nu pot fi indexate. Dacă doriți ca întregul dvs. site să fie deschis pentru indexare, lăsați necompletat valoarea Disallow. Pentru a ascunde tot conținutul de pe site după Disallow, puneți „/”.

Putem împiedica accesul la un anumit folder, fișier sau extensie de fișier. În exemplul nostru, contactăm toți roboții de căutare și blocăm accesul la bitrix, folderul de căutare și extensia pdf.

Permite

Permiteți ca paginile și secțiunile site-ului să fie indexate. În exemplul de mai sus, contactăm robotul de căutare Google, blocăm accesul la bitrix, folderul de căutare și extensia pdf. Dar în folderul bitrix forțăm deschiderea a 3 foldere pentru indexare: componente, js, instrumente.

Gazdă - oglindă site

Un site oglindă este un duplicat al site-ului principal. Oglinzile sunt folosite pentru o varietate de scopuri: schimbarea adresei, securitate, reducerea sarcinii pe server etc.

Gazda este una dintre cele mai importante reguli. Dacă această regulă este scrisă, robotul va înțelege care dintre oglinzile site-ului ar trebui să fie luate în considerare pentru indexare. Această directivă este necesară pentru roboții Yandex și Mail.ru. Alți roboți vor ignora această regulă. Gazda este înregistrată o singură dată!

Pentru protocoalele „https://” și „http://”, sintaxa din fișierul robots.txt va fi diferită.

Harta site - harta site-ului

Harta site-ului este o formă de navigare pe site care este utilizată pentru a informa motoarele de căutare despre paginile noi. Folosind directiva sitemap, arătăm „forțat” robotului unde se află harta.

Simboluri în robots.txt

Simboluri utilizate în fișier: „/, *, $, #”.

Verificarea funcționalității după configurarea robots.txt

După ce ați plasat Robots.txt pe site-ul dvs. web, trebuie să îl adăugați și să îl verificați în Yandex și Google webmaster.

Verificare Yandex:

- Urmați acest link.

- Selectați: Setări de indexare - Analiză Robots.txt.

Verificare Google:

- Urmați acest link.

- Selectați: Scanare - Instrument de inspecție a fișierelor Robots.txt.

În acest fel, puteți verifica fișierul robots.txt pentru erori și puteți face ajustările necesare, dacă este necesar.

- Conținutul dosarului trebuie scris cu majuscule.

- Trebuie specificat un singur fișier sau director în directiva Disallow.

- Linia „User-agent” nu trebuie să fie goală.

- User-agent ar trebui să vină întotdeauna înainte de Disallow.

- Nu uitați să includeți o bară oblică dacă trebuie să dezactivați indexarea unui director.

- Înainte de a încărca un fișier pe server, asigurați-vă că îl verificați pentru erori de sintaxă și ortografie.

Vă doresc succes!

Revizuire video a 3 metode de creare și personalizare a fișierului Robots.txt

În primul rând, vă voi spune ce este robots.txt.

Robots.txt– un fișier care se află în folderul rădăcină al site-ului, unde sunt scrise instrucțiuni speciale pentru roboții de căutare. Aceste instructiuni sunt necesare pentru ca la intrarea pe site robotul sa nu tina cont de pagina/sectiunea, cu alte cuvinte, inchidem pagina de la indexare.

De ce avem nevoie de robots.txt?

Fișierul robots.txt este considerat o cerință cheie pentru optimizarea SEO pentru absolut orice site web. Absența acestui fișier poate afecta negativ încărcarea de la roboți și indexarea lentă și, mai mult, site-ul nu va fi complet indexat. În consecință, utilizatorii nu vor putea accesa paginile prin Yandex și Google.

Impactul robots.txt asupra motoarele de căutare?

Motoare de căutare(în special Google) va indexa site-ul, dar dacă nu există fișier robots.txt, atunci, așa cum am spus, nu toate paginile. Dacă există un astfel de fișier, atunci roboții sunt ghidați de regulile care sunt specificate în acest fișier. Mai mult, există mai multe tipuri de roboți de căutare; unii pot lua în considerare regula, în timp ce alții o ignoră. În special, robotul GoogleBot nu ține cont de directivele Gazdă și Crawl-Delay, robotul YandexNews a încetat recent să ia în considerare directiva Crawl-Delay, iar roboții YandexDirect și YandexVideoParser ignoră directivele general acceptate în robots.txt (dar luați în considerare cele care sunt scrise special pentru ei).

Site-ul este încărcat cel mai mult de roboții care încarcă conținut de pe site-ul dvs. În consecință, dacă îi spunem robotului ce pagini să indexeze și care să ignore, precum și la ce intervale de timp să încarce conținutul din pagini (acest lucru se aplică mai mult site-urilor mari care au mai mult de 100.000 de pagini în indexul motorului de căutare). Acest lucru va face mult mai ușor pentru robot să indexeze și să descarce conținut de pe site.

Fișierele care nu sunt necesare pentru motoarele de căutare includ fișiere care aparțin CMS, de exemplu, în Wordpress – /wp-admin/. În plus, ajax, scripturi json responsabile pentru formulare pop-up, bannere, ieșire captcha și așa mai departe.

Pentru majoritatea roboților, recomand și blocarea tuturor fișierelor Javascript și CSS de la indexare. Dar pentru GoogleBot și Yandex, este mai bine să indexați astfel de fișiere, deoarece sunt utilizate de motoarele de căutare pentru a analiza confortul site-ului și clasarea acestuia.

Ce este o directivă robots.txt?

Directive– acestea sunt regulile pentru roboții de căutare. Primele standarde pentru scrierea robots.txt și, în consecință, au apărut în 1994, iar standardul extins în 1996. Cu toate acestea, după cum știți deja, nu toți roboții acceptă anumite directive. Prin urmare, mai jos am descris după ce se ghidează roboții principali atunci când indexează paginile site-ului.

Ce înseamnă User-agent?

Aceasta este cea mai importantă directivă care determină ce roboți de căutare vor urma alte reguli.

Pentru toți roboții:

Pentru un anumit bot:

Agent utilizator: Googlebot

Înregistrarea în robots.txt nu este important, puteți scrie atât Googlebot, cât și googlebot

roboți de căutare Google

roboți de căutare Yandex

|

Robotul principal de indexare al lui Yandex |

|

|

Folosit în serviciul Yandex.Images |

|

|

Folosit în serviciul Yandex.Video |

|

|

Date multimedia |

|

|

Căutare pe blog |

|

|

Un robot de căutare care accesează o pagină atunci când o adaugă prin formularul „Adăugați URL”. |

|

|

robot care indexează pictogramele site-ului web (favicons) |

|

|

Yandex.Direct |

|

|

Yandex.Metrica |

|

|

Folosit în serviciul Yandex.Catalog |

|

|

Folosit în serviciul Yandex.News |

|

|

YandexImageResizer |

Robot de căutare a serviciilor mobile |

Roboti de căutare Bing, Yahoo, Mail.ru, Rambler

Directivele Disallow și Allow

Interziceți blocarea secțiunilor și paginilor site-ului dvs. de la indexare. În consecință, Permiteți, dimpotrivă, le deschide.

Există câteva particularități.

În primul rând, operatorii suplimentari sunt *, $ și #. La ce sunt folosite?

“*” – acesta este orice număr de caractere și absența lor. În mod implicit, este deja la sfârșitul liniei, așa că nu are rost să-l puneți din nou.

“$” – indică faptul că personajul dinaintea lui ar trebui să vină ultimul.

“#” – comentează, robotul nu ține cont de tot ce vine după acest simbol.

Exemple de utilizare a Disallow:

Nu permite: *?s=

Nu permiteți: /categorie/

În consecință, robotul de căutare va închide pagini precum:

Dar pagini ca aceasta vor fi deschise pentru indexare:

Acum trebuie să înțelegeți cum sunt executate regulile de imbricare. Ordinea în care sunt scrise directivele este absolut importantă. Moștenirea regulilor este determinată de care directoare sunt specificate, adică dacă vrem să blocăm o pagină/document de la indexare, este suficient să scriem o directivă. Să ne uităm la un exemplu

Acesta este fișierul nostru robots.txt

Nu permiteți: /șablon/

Această directivă poate fi specificată oriunde și pot fi specificate mai multe fișiere sitemap.

Directiva gazdă în robots.txt

Această directivă este necesară pentru a indica oglinda principală a site-ului (deseori cu sau fără www). Vă rugăm să rețineți că directiva gazdă este specificată fără protocolul http://, dar cu protocolul https://. Directiva este luată în considerare doar de roboții de căutare Yandex și Mail.ru, iar alți roboți, inclusiv GoogleBot, nu vor lua în considerare regula. Gazda ar trebui să fie specificată o dată în fișierul robots.txt

Exemplu cu http://

Gazdă: website.ru

Exemplu cu https://

Directiva privind întârzierea cu crawler

Setează intervalul de timp pentru indexarea paginilor site-ului de către un robot de căutare. Valoarea este indicată în secunde și milisecunde.

Exemplu:

Este folosit mai ales pe marile magazine online, site-uri de informare, portaluri, unde traficul pe site este de la 5.000 pe zi. Este necesar ca robotul de căutare să facă o cerere de indexare într-o anumită perioadă de timp. Dacă această directivă nu este specificată, poate crea o sarcină serioasă pe server.

Valoarea optimă a întârzierii accesării cu crawlere este diferită pentru fiecare site. Pentru motoarele de căutare Mail, Bing, Yahoo, valoarea poate fi setată la o valoare minimă de 0,25, 0,3, deoarece acești roboți de motoare de căutare vă pot accesa cu crawlere site-ul o dată pe lună, 2 luni și așa mai departe (foarte rar). Pentru Yandex, este mai bine să setați o valoare mai mare.

Dacă încărcarea pe site-ul dvs. este minimă, atunci nu are rost să specificați această directivă.

Directiva Clean-param

Regula este interesantă deoarece îi spune crawler-ului că paginile cu anumiți parametri nu trebuie să fie indexate. Sunt specificate două argumente: URL-ul paginii și parametrul. Această directivă este susținută de motorul de căutare Yandex.

Exemplu:

Nu permiteți: /admin/

Nu permiteți: /plugins/

Nu permiteți: /căutare/

Nu permiteți: /cart/

Nu permite: *sortare=

Nu permite: *view=

Agent utilizator: GoogleBot

Nu permiteți: /admin/

Nu permiteți: /plugins/

Nu permiteți: /căutare/

Nu permiteți: /cart/

Nu permite: *sortare=

Nu permite: *view=

Permite: /plugins/*.css

Permite: /plugins/*.js

Permite: /plugins/*.png

Permite: /plugins/*.jpg

Permite: /plugins/*.gif

Agent utilizator: Yandex

Nu permiteți: /admin/

Nu permiteți: /plugins/

Nu permiteți: /căutare/

Nu permiteți: /cart/

Nu permite: *sortare=

Nu permite: *view=

Permite: /plugins/*.css

Permite: /plugins/*.js

Permite: /plugins/*.png

Permite: /plugins/*.jpg

Permite: /plugins/*.gif

Clean-Param: utm_source&utm_medium&utm_campaign

În exemplu, am notat regulile pentru 3 roboți diferiți.

Unde să adăugați robots.txt?

Adăugat în folderul rădăcină al site-ului. În plus, pentru a putea urmări linkul:

Cum se verifică robots.txt?

Webmaster Yandex

În fila Instrumente, selectați Robots.txt Analysis și apoi faceți clic pe Verificare

Google Search Console

Pe fila Scanare alege Instrument de inspecție a fișierelor Robots.txt apoi faceți clic pe verificare.

Concluzie:

Fișierul robots.txt trebuie să fie prezent pe fiecare site web promovat și doar configurarea lui corectă vă va permite să obțineți indexarea necesară.

Și, în sfârșit, dacă aveți întrebări, puneți-le în comentariile de sub articol și, de asemenea, mă întreb, cum scrieți robots.txt?

Explicația valorilor:

- User-agent: * - accesați toate motoarele de căutare simultan, Yandex - numai Yandex.

- Disallow: listează folderele și fișierele care sunt interzise pentru indexare

- Gazdă – introduceți numele site-ului dvs. fără www.

- Harta site-ului: link către harta site-ului XML.

Plasați fișierul în directorul rădăcină al site-ului folosind Filezilla sau prin site-ul de găzduire. Postați-l în directorul principal, astfel încât să fie disponibil prin link-ul: your_site.ru/robots.txt

Este potrivit doar pentru cei care au mașini CNC (linkurile sunt scrise în cuvinte, nu în forma p=333). Doar accesați Setări – Permalink-uri, selectați opțiunea de jos și introduceți /%postname% în câmp.

Unii oameni preferă să creeze singuri acest fișier:

Pentru a începe, creați un bloc de note pe computer și numiți-i roboți (nu folosiți majuscule). La sfârșitul setărilor, dimensiunea sa nu trebuie să depășească 500 kb.

Agent utilizator– numele motorului de căutare (Yandex, Googlebot, StackRambler). Dacă vrei să atragi pe toată lumea deodată, pune o stea *

Și apoi specificați paginile sau folderele pe care acest robot nu ar trebui să le indexeze Nu permiteți:

Mai întâi, sunt listate trei directoare și apoi un anumit fișier.

Pentru a permite indexarea tuturor și a tuturor, trebuie să scrieți:

Agent utilizator: *

Nu permiteți:

Configurarea robots.txt pentru Yandex și Google

Pentru Yandex Cu siguranță trebuie să adăugați directiva gazdă pentru a evita paginile duplicat. Acest cuvânt este înțeles numai de botul Yandex, așa că notați instrucțiunile pentru el separat.

Pentru Google nu sunt plusuri. Singurul lucru pe care trebuie să-l știi este cum să-l accesezi. În secțiunea User-agent trebuie să scrieți:

- Googlebot;

- Googlebot-Image – dacă limitați indexarea imaginilor;

- Googlebot-Mobile - pentru versiunea mobilă a site-ului.

Cum se verifică funcționalitatea fișierului robots.txt

Acest lucru se poate face în secțiunea „Instrumente pentru webmasteri” din motorul de căutare Google sau pe site-ul web Yandex.Webmaster în secțiunea Verificați robots.txt.

Dacă există erori, corectați-le și verificați din nou. Obțineți un rezultat bun, apoi nu uitați să copiați codul corect în robots.txt și să îl încărcați pe site.

Acum aveți o idee despre cum să creați robots.txt pentru toate motoarele de căutare. Pentru începători, recomand să folosești un fișier gata făcut, înlocuind numele site-ului tău.

Este posibil și cum pot repara singur un telefon mobil cu ecran tactil dacă cade în apă și nu funcționează?

Este posibil și cum pot repara singur un telefon mobil cu ecran tactil dacă cade în apă și nu funcționează? Lista neagră MTS - Blocarea numerelor inutile

Lista neagră MTS - Blocarea numerelor inutile Cum să uscați un telefon cu ecran tactil dacă cade în apă

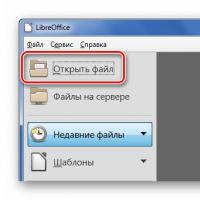

Cum să uscați un telefon cu ecran tactil dacă cade în apă Cum se deschide un fișier .AI? Fișierele cu extensia AI: cum și cum să le deschideți Descărcați fișierul ai

Cum se deschide un fișier .AI? Fișierele cu extensia AI: cum și cum să le deschideți Descărcați fișierul ai Modalități de a converti CR2 în JPG Cr2 sunt deschise online

Modalități de a converti CR2 în JPG Cr2 sunt deschise online Cum să blocați VKontakte pe un computer

Cum să blocați VKontakte pe un computer Cum se deschide un fișier .PUB? Extensia PUB - cum se deschide? Extensie pub decât să deschidă

Cum se deschide un fișier .PUB? Extensia PUB - cum se deschide? Extensie pub decât să deschidă